Bild vom Autor

ComfyUI hat die Artwork und Weise verändert, wie Schöpfer und Entwickler an die KI-gestützte Bildgenerierung herangehen. Im Gegensatz zu herkömmlichen Schnittstellen bietet Ihnen die knotenbasierte Architektur von ComfyUI eine beispiellose Kontrolle über Ihre kreativen Arbeitsabläufe. Dieser Crashkurs führt Sie vom kompletten Anfänger zum selbstbewussten Benutzer und führt Sie durch alle wesentlichen Konzepte, Funktionen und praktischen Beispiele, die Sie benötigen, um dieses leistungsstarke Instrument zu beherrschen.

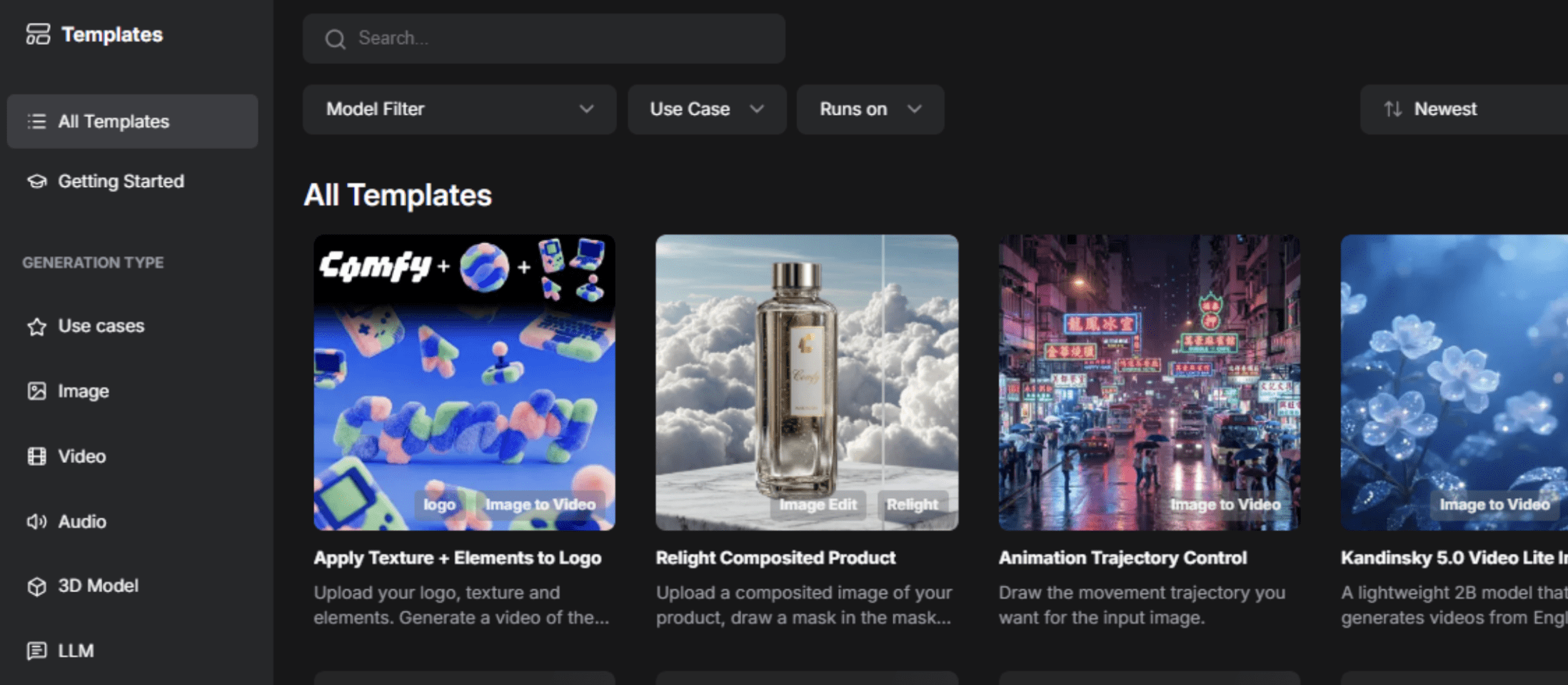

Bild vom Autor

ComfyUI ist eine kostenlose, knotenbasierte Open-Supply-Schnittstelle und das Backend dafür Stabile Verbreitung und andere generative Modelle. Betrachten Sie es als eine visuelle Programmierumgebung, in der Sie Bausteine (sogenannte „Knoten“) verbinden, um komplexe Arbeitsabläufe zum Generieren von Bildern, Movies, 3D-Modellen und Audio zu erstellen.

Wesentliche Vorteile gegenüber herkömmlichen Schnittstellen:

- Sie haben die volle Kontrolle über die visuelle Erstellung von Workflows, ohne Code schreiben zu müssen, mit vollständiger Kontrolle über jeden Parameter.

- Sie können ganze Arbeitsabläufe mit in die generierten Dateien eingebetteten Metadaten speichern, teilen und wiederverwenden.

- Es gibt keine versteckten Kosten oder Abonnements; Es ist vollständig anpassbar mit benutzerdefinierten Knoten, kostenlos und Open Supply.

- Es wird lokal auf Ihrem Laptop ausgeführt, um die Iteration zu beschleunigen und die Betriebskosten zu senken.

- Es verfügt über eine nahezu unbegrenzte erweiterte Funktionalität mit benutzerdefinierten Knoten, die Ihre spezifischen Anforderungen erfüllen können.

# Wählen Sie zwischen lokaler und cloudbasierter Set up

Bevor Sie ComfyUI genauer erkunden, müssen Sie entscheiden, ob Sie es lokal ausführen oder eine cloudbasierte Model verwenden möchten.

| Lokale Set up | Cloudbasierte Set up |

|---|---|

| Funktioniert nach der Set up offline | Erfordert eine ständige Internetverbindung |

| Keine Abonnementgebühren | Es können Abonnementkosten anfallen |

| Vollständiger Datenschutz und Kontrolle | Weniger Kontrolle über Ihre Daten |

| Erfordert leistungsstarke {Hardware} (insbesondere eine gute). NVIDIA GPU) | Keine leistungsstarke {Hardware} erforderlich |

| Manuelle Set up und Updates erforderlich | Automatische Updates |

| Begrenzt durch die Rechenleistung Ihres Computer systems | Mögliche Geschwindigkeitsbeschränkungen während der Spitzenlast |

Wenn Sie gerade erst anfangen, empfiehlt es sich, mit einer cloudbasierten Lösung zu beginnen, um sich mit der Benutzeroberfläche und den Konzepten vertraut zu machen. Wenn Sie Ihre Fähigkeiten weiterentwickeln, sollten Sie den Übergang zu einer lokalen Set up in Betracht ziehen, um mehr Kontrolle zu haben und die langfristigen Kosten zu senken.

# Die Kernarchitektur verstehen

Bevor Sie mit Knoten arbeiten, ist es wichtig, die theoretischen Grundlagen der Funktionsweise von ComfyUI zu verstehen. Stellen Sie es sich als ein Multiversum zwischen zwei Universen vor: dem Rot-Grün-Blau-Universum (RGB) (was wir sehen) und dem latenten Weltraumuniversum (wo Berechnungen stattfinden).

// Die zwei Universen

Das RGB-Universum ist unsere beobachtbare Welt. Es enthält regelmäßige Bilder und Daten, die wir mit unseren Augen sehen und verstehen können. Der latente Raum (KI-Universum) ist der Ort, an dem die „Magie“ geschieht. Es handelt sich um eine mathematische Darstellung, die Modelle verstehen und manipulieren können. Es ist chaotisch, voller Rauschen und enthält die abstrakte mathematische Struktur, die die Bilderzeugung antreibt.

// Verwendung des Variational Autoencoders

Der Variational Autoencoder (VAE) fungiert als Portal zwischen diesen Universen.

- Bei der Kodierung (RGB – Latent) wird ein sichtbares Bild in eine abstrakte latente Darstellung umgewandelt.

- Bei der Dekodierung (Latent – RGB) wird die abstrakte latente Darstellung zurück in ein Bild umgewandelt, das wir sehen können.

Dieses Konzept ist wichtig, da viele Knoten in einem einzigen Universum operieren. Wenn Sie es verstehen, können Sie die richtigen Knoten miteinander verbinden.

// Knoten definieren

Knoten sind die Grundbausteine von ComfyUI. Jeder Knoten ist eine eigenständige Funktion, die eine bestimmte Aufgabe ausführt. Knoten haben:

- Eingaben (linke Seite): Wo Daten einfließen

- Ausgänge (rechte Seite): Wo verarbeitete Daten ausgegeben werden

- Parameter: Einstellungen, die Sie anpassen, um das Verhalten des Knotens zu steuern

// Identifizieren farbcodierter Datentypen

ComfyUI verwendet ein Farbsystem, um anzuzeigen, welche Artwork von Daten zwischen Knoten fließen:

| Farbe | Datentyp | Beispiel |

|---|---|---|

| Blau | RGB-Bilder | Regelmäßig sichtbare Bilder |

| Rosa | Latente Bilder | Bilder in latenter Darstellung |

| Gelb | CLIP | Textual content in Maschinensprache umgewandelt |

| Rot | VAE | Modell, das zwischen Universen konvertiert |

| Orange | Konditionierung | Eingabeaufforderungen und Kontrollanweisungen |

| Grün | Textual content | Einfache Textzeichenfolgen (Eingabeaufforderungen, Dateipfade) |

| Lila | Modelle | Prüfpunkte und Modellgewichte |

| Blaugrün/Türkis | Kontrollnetze | Steuerdaten zur Leitgenerierung |

Es ist sehr wichtig, diese Farben zu verstehen. Sie sagen Ihnen sofort, ob Knoten miteinander verbunden werden können.

// Erkundung wichtiger Knotentypen

Ladeknoten importieren Modelle und Daten in Ihren Workflow:

CheckPointLoader: Lädt ein Modell (enthält normalerweise die Modellgewichte, das Contrastive Language-Picture Pre-Coaching (CLIP) und VAE in einer Datei).Load Diffusion Mannequin: Lädt Modellkomponenten separat (für neuere Modelle wie Fluss die keine Komponenten bündeln).VAE Loader: Lädt den VAE-Decoder separat.CLIP Loader: Lädt den Textual content-Encoder separat.

Verarbeitungsknoten transformieren Daten:

CLIP Textual content Encodewandelt Textaufforderungen in Maschinensprache um (Konditionierung).KSamplerist die zentrale Bildgenerierungs-Engine.VAE DecodeKonvertiert latente Bilder zurück in RGB.

Versorgungsknoten unterstützen das Workflow-Administration:

- Primitiver Knoten: Ermöglicht die manuelle Eingabe von Werten.

- Knoten umleiten: Bereinigt die Workflow-Visualisierung durch Umleiten von Verbindungen.

- Bild laden: Importiert Bilder in Ihren Workflow.

- Bild speichern: Exportiert generierte Bilder.

# Den KSampler-Knoten verstehen

Der KSampler ist wohl der wichtigste Knoten in ComfyUI. Es ist der „Roboter-Builder“, der Ihre Bilder tatsächlich generiert. Das Verständnis seiner Parameter ist für die Erstellung hochwertiger Bilder von entscheidender Bedeutung.

// Überprüfen der KSampler-Parameter

Seed (Normal: 0)

Der Startwert ist der anfängliche Zufallszustand, der bestimmt, welche Zufallspixel zu Beginn der Generierung platziert werden. Betrachten Sie es als Ihren Ausgangspunkt für die Randomisierung.

- Fester Seed: Wenn Sie denselben Seed mit denselben Einstellungen verwenden, wird immer das gleiche Bild erzeugt.

- Zufälliger Startwert: Jede Technology erhält einen neuen zufälligen Startwert, der unterschiedliche Bilder erzeugt.

- Wertebereich: 0 bis 18.446.744.073.709.551.615.

Schritte (Normal: 20)

Schritte definieren die Anzahl der durchgeführten Entrauschungsiterationen. Jeder Schritt verfeinert das Bild schrittweise vom reinen Rauschen hin zur gewünschten Ausgabe.

- Niedrige Schritte (10–15): Schnellere Generierung, weniger raffinierte Ergebnisse.

- Mittlere Schritte (20–30): Gute Stability zwischen Qualität und Geschwindigkeit.

- Hohe Schritte (50+): Bessere Qualität, aber deutlich langsamer.

CFG-Skala (Normal: 8,0, Bereich: 0,0–100,0)

Die Classifier-Free Steerage (CFG)-Skala steuert, wie strikt die KI Ihrer Aufforderung folgt.

Analogie – Stellen Sie sich vor, Sie geben einem Bauunternehmer einen Bauplan:

- Niedriger CFG (3-5): Der Bauunternehmer wirft einen Blick auf den Bauplan und macht dann sein eigenes Ding – kreativ, ignoriert aber möglicherweise Anweisungen.

- Hoher CFG (12+): Der Bauunternehmer folgt wie besessen jedem Element des Bauplans – genau, sieht aber möglicherweise steif oder überbearbeitet aus.

- Ausgewogener CFG (7-8 für stabile Diffusion, 1-2 für Flussmittel): Der Builder folgt größtenteils dem Bauplan und fügt natürliche Variationen hinzu.

Identify des Samplers

Der Sampler ist der Algorithmus, der für den Entrauschungsprozess verwendet wird. Zu den gängigen Probenehmern gehören: Euler, DPM++ 2MUnd UniPC.

Planer

Steuert, wie Rauschen über die Rauschunterdrückungsschritte hinweg geplant wird. Planer legen die Lärmminderungskurve fest.

- Regular: Normal-Lärmplanung.

- Karras: Bietet oft bessere Ergebnisse bei geringerer Schrittzahl.

Denoise (Normal: 1,0, Bereich: 0,0-1,0)

Dies ist eines Ihrer wichtigsten Steuerelemente für Bild-zu-Bild-Workflows. Denoise bestimmt, wie viel Prozent des Eingabebildes durch neuen Inhalt ersetzt werden soll:

- 0.0: Nichts ändern – die Ausgabe ist mit der Eingabe identisch

- 0,5: 50 % des Originalbildes beibehalten, 50 % wie neu generieren

- 1.0: Vollständig neu generieren – das Eingabebild ignorieren und mit reinem Rauschen beginnen

# Beispiel: Erstellen eines Charakterporträts

Eingabeaufforderung: „Ein Cyberpunk-Androide mit neonblauen Augen, detaillierten mechanischen Teilen und dramatischer Beleuchtung.“

Einstellungen:

- Modell: Flussmittel

- Schritte: 20

- CFG: 2,0

- Sampler: Normal

- Auflösung: 1024×1024

- Samen: Randomisieren

Adverse Aufforderung: „Geringe Qualität, verschwommen, übersättigt, unrealistisch.“

// Erkunden von Bild-zu-Bild-Workflows

Bild-zu-Bild-Workflows bauen auf der Textual content-zu-Bild-Grundlage auf und fügen ein Eingabebild hinzu, um den Generierungsprozess zu steuern.

Szenario: Sie haben ein Landschaftsfoto und möchten es im Stil eines Ölgemäldes gestalten.

- Laden Sie Ihr Landschaftsbild

- Optimistic Aufforderung: „Ölgemälde, impressionistischer Stil, lebendige Farben, Pinselstriche“

- Denoise: 0,7

// Durchführung der Posengesteuerten Charaktergenerierung

Szenario: Sie haben einen Charakter erstellt, den Sie lieben, möchten aber eine andere Pose.

- Laden Sie Ihr Authentic-Charakterbild

- Optimistic Aufforderung: „Gleiche Charakterbeschreibung, stehende Pose, Arme seitlich“

- Rauschunterdrückung: 0,3

# ComfyUI installieren und einrichten

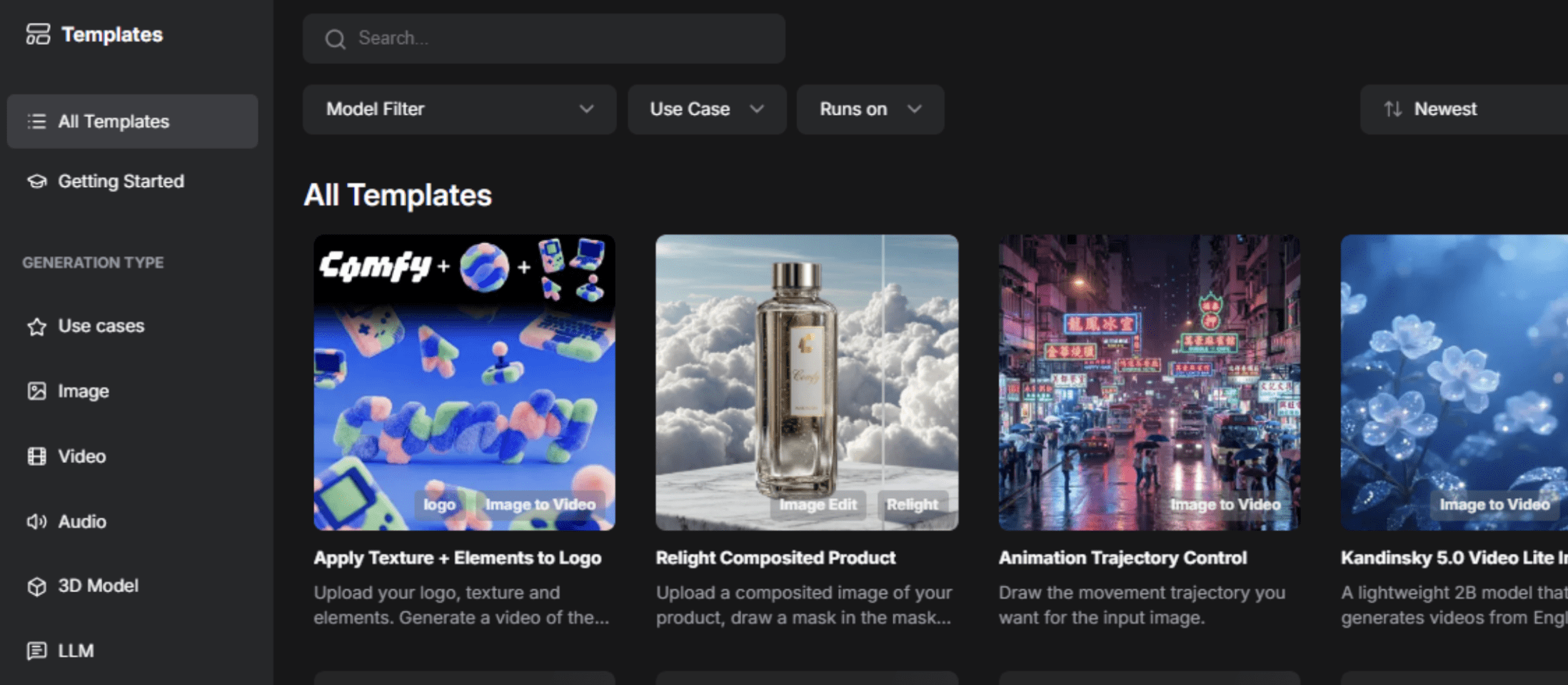

Cloudbasiert (am einfachsten für Anfänger)

Besuchen RunComfy.com und klicken Sie oben rechts auf Comfortable Cloud starten. Alternativ können Sie auch einfach Melden Sie sich an in Ihrem Browser.

Bild vom Autor

Bild vom Autor

// Verwenden von Home windows Moveable

- Vor dem Herunterladen müssen Sie über ein {Hardware}-Setup einschließlich einer NVIDIA-GPU mit CUDA-Unterstützung oder macOS (Apple Silicon) verfügen.

- Laden Sie den portablen Home windows-Construct von der ComfyUI-GitHub-Versionsseite herunter.

- Extrahieren Sie es an den gewünschten Ort.

- Laufen

run_nvidia_gpu.bat(wenn Sie eine NVIDIA-GPU haben) oderrun_cpu.bat. - Öffnen Sie Ihren Browser zu http://localhost:8188.

// Durchführen einer manuellen Set up

- Installieren Python: Laden Sie Model 3.12 oder 3.13 herunter.

- Klon-Repository:

git clone https://github.com/comfyanonymous/ComfyUI.git - Installieren PyTorch: Befolgen Sie die plattformspezifischen Anweisungen für Ihre GPU.

- Abhängigkeiten installieren:

pip set up -r necessities.txt - Modelle hinzufügen: Platzieren Sie Modellprüfpunkte

fashions/checkpoints. - Laufen:

python fundamental.py

# Arbeiten mit verschiedenen KI-Modellen

ComfyUI unterstützt zahlreiche hochmoderne Modelle. Hier die aktuellen Topmodelle:

| Flux (empfohlen für Realismus) | Stabile Diffusion 3.5 | Ältere Modelle (SD 1.5, SDXL) |

|---|---|---|

| Hervorragend geeignet für fotorealistische Bilder | Ausgewogene Qualität und Geschwindigkeit | Umfangreich von der Group optimiert |

| Schnelle Technology | Unterstützt verschiedene Stile | Massives Low-Rank-Adaption-Ökosystem (LoRA). |

| CFG: Bereich 1–3 | CFG: Bereich 4–7 | Immer noch hervorragend für bestimmte Arbeitsabläufe geeignet |

# Fortschrittliche Arbeitsabläufe mit Low-Rank-Anpassungen

Low-Rank-Anpassungen (LoRAs) sind kleine Adapterdateien, die Modelle für bestimmte Stile, Themen oder Ästhetiken verfeinern, ohne das Basismodell zu ändern. Zu den häufigen Verwendungszwecken gehören Charakterkonsistenz, Kunststile und benutzerdefinierte Konzepte. Um einen zu verwenden, fügen Sie einen „LoRA laden“-Knoten hinzu, wählen Sie Ihre Datei aus und verbinden Sie sie mit Ihrem Workflow.

// Anleitung zur Bilderzeugung mit ControlNets

ControlNets bieten räumliche Kontrolle über die Generierung und zwingen das Modell, Pose, Kantenkarten oder Tiefe zu berücksichtigen:

- Erzwingen Sie bestimmte Posen anhand von Referenzbildern

- Behalten Sie die Objektstruktur bei, während Sie den Stil ändern

- Leitfadenkomposition basierend auf Kantenkarten

- Respektieren Sie Tiefeninformationen

// Selektive Bildbearbeitung mit Inpainting durchführen

Mit Inpainting können Sie nur bestimmte Bereiche eines Bildes regenerieren, während der Relaxation intakt bleibt.

Arbeitsablauf: Bild laden – Maskenmalerei – Inpainting KSampler – Ergebnis

// Höhere Auflösung durch Upscaling

Verwenden Sie Upscale-Knoten nach der Generierung, um die Auflösung zu erhöhen, ohne das gesamte Bild neu zu generieren. Zu den beliebten Upscalern gehören RealESRGAN Und SwinIR.

# Abschluss

ComfyUI stellt einen sehr wichtigen Wandel in der Inhaltserstellung dar. Seine knotenbasierte Architektur bietet Ihnen Leistung, die bisher Softwareentwicklern vorbehalten conflict, bleibt aber auch für Anfänger zugänglich. Die Lernkurve ist actual, aber jedes Konzept, das Sie lernen, eröffnet neue kreative Möglichkeiten.

Erstellen Sie zunächst einen einfachen Textual content-zu-Bild-Workflow, generieren Sie einige Bilder und passen Sie Parameter an. Innerhalb weniger Wochen erstellen Sie ausgefeilte Arbeitsabläufe. Innerhalb weniger Monate werden Sie die Grenzen dessen erweitern, was im generativen Bereich möglich ist.

Shittu Olumide ist ein Software program-Ingenieur und technischer Autor, der sich leidenschaftlich dafür einsetzt, modernste Technologien zu nutzen, um fesselnde Erzählungen zu erschaffen, mit einem scharfen Blick fürs Element und einem Gespür für die Vereinfachung komplexer Konzepte. Sie können Shittu auch auf finden Twitter.