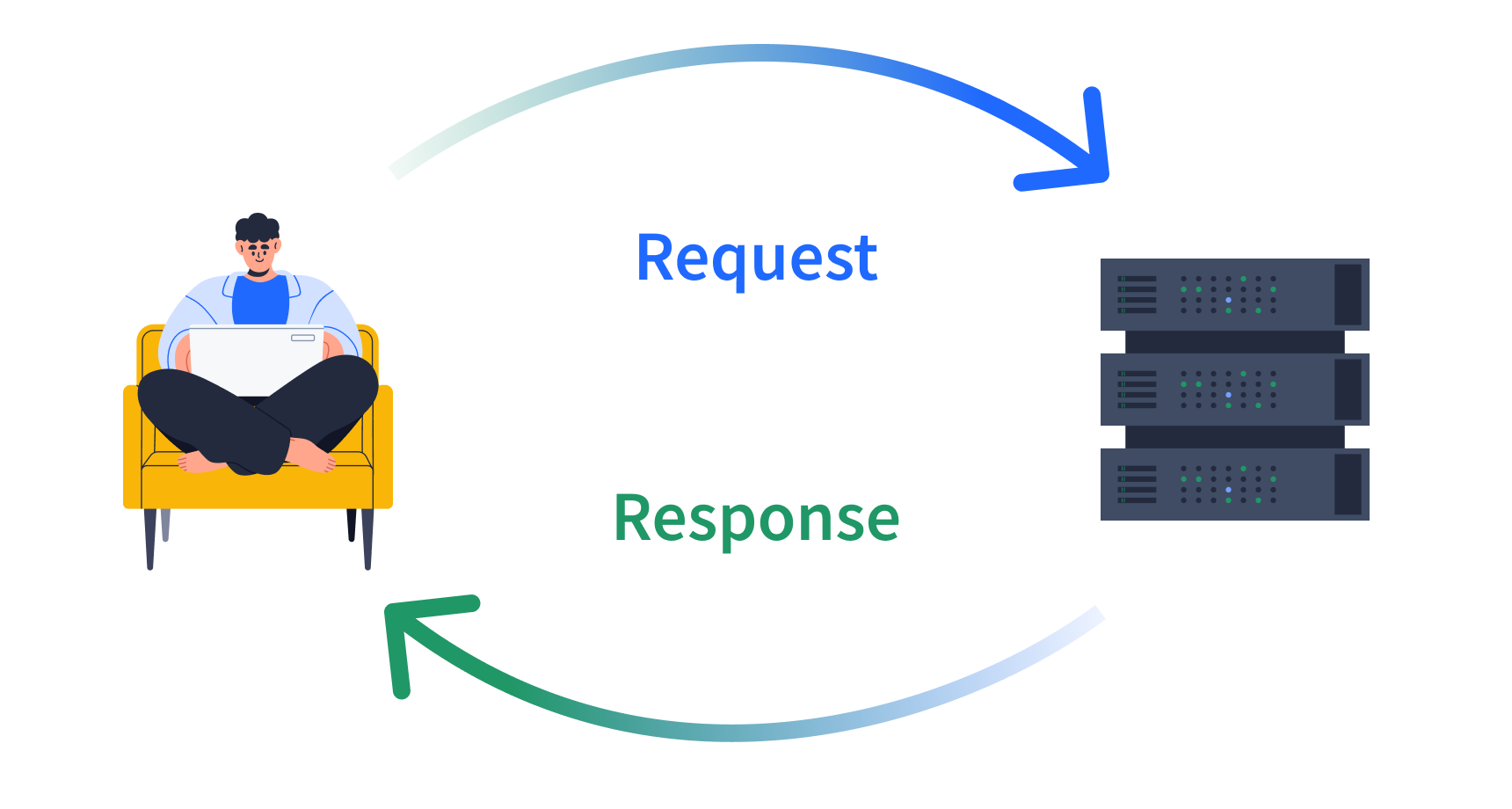

Anwendungsprogrammierschnittstellen (APIs) und Net Scraping sind leistungsstarke Instruments zum Sammeln von Daten in Python und können Ihre datenwissenschaftlichen Fähigkeiten erheblich erweitern. Als ich diese Techniken zum ersten Mal erlernte, struggle ich erstaunt darüber, wie sie es mir ermöglichten, Daten zu sammeln, die über statische Datensätze hinausgingen. Jeder Datenwissenschaftler sollte mit der Interaktion mit APIs, dem Umgang mit JSON-Daten und dem Extrahieren von Informationen aus Webseiten vertraut sein. Mit diesen Fähigkeiten können Sie Daten aus einer Vielzahl von On-line-Quellen sammeln und analysieren und so neue Möglichkeiten für Ihre Projekte eröffnen.

Die Nützlichkeit von APIs wurde mir zum ersten Mal während eines maschinellen Lernprojekts bewusst, bei dem es um die Vorhersage von Wetterereignissen ging. Anstatt Daten von meteorologischen Web sites manuell zu kopieren und einzufügen, habe ich über APIs mit nur wenigen Codezeilen auf riesige Mengen strukturierter Wetterdaten zugegriffen. Sie haben meine Datenerfassungszeit drastisch verkürzt und mir geholfen, meine Datensätze zu standardisieren.

Aber APIs sind nur ein Teil des Puzzles. Net Scraping bietet Zugriff auf Datenquellen, die keine offiziellen APIs haben. Plötzlich konnte ich Daten sammeln von vielen verschiedenen Web sites, um benutzerdefinierte Datensätze zu erstellen, wenn die benötigten Informationen nicht ohne weiteres über eine formale API verfügbar waren.

Als ich mich eingehender mit diesen Techniken beschäftigte, wurde mir schnell klar, wie wichtig es ist, die API-Dokumentation zu verstehen. Durch die sichere Navigation in der Dokumentation konnte ich genau die Daten abrufen, die ich brauchte, was Zeit und Rechenressourcen sparte.

Eine wichtige Lektion, die ich während meines Wetterprojekts gelernt habe, struggle, wie wichtig es ist, die Aktualität der Daten mit API-Ratenbegrenzungen in Einklang zu bringen. Effektive Datenabrufstrategien sind entscheidend, um die aktuellsten Informationen zu erhalten, ohne die von API-Anbietern festgelegten Grenzen zu überschreiten.

Die wahre Magie geschah, als ich begann, Daten von APIs und Net-Scraping für mein Wettervorhersageprojekt zu kombinieren. Durch die Integration von Echtzeit-Wetterdaten von einer API mit historischen Wettermustern, die von verschiedenen Klimaforschungs-Web sites stammen, habe ich umfangreichere, vielfältigere Datensätze erstellt, die die Genauigkeit meiner Vorhersagen verbesserten.

Der Umgang mit JSON-Daten ist eine weitere wichtige Fähigkeit bei der Arbeit mit APIs. Pythons json Die Bibliothek wurde von unschätzbarem Wert, da sie es mir ermöglichte, komplexe JSON-Antworten einfach zu analysieren und zu bearbeiten.

Wenn Sie bereit sind, diese leistungsstarken Techniken zu erlernen, sind unsere APIs und Net Scraping in Python für Knowledge Science Der Kurs kann Sie durch den Prozess führen. Sie lernen:

- Verwenden Sie die Anforderungsbibliothek von Python, um mit APIs zu interagieren

- Verarbeiten und manipulieren Sie JSON-Datenstrukturen

- Implementieren Sie die API-Authentifizierung und verwalten Sie Ratenbeschränkungen

- Nutzen Sie optionale Abfrageparameter zur Verfeinerung Datenabruf

- Wenden Sie Net-Scraping-Techniken an, um Daten aus HTML zu extrahieren

- Integrieren Sie API- und Net-Scraping-Daten zur Analyse in Pandas

Am Ende des Kurses sind Sie intestine gerüstet, um Daten aus verschiedenen On-line-Quellen zu sammeln und zu analysieren, was Ihnen neue Möglichkeiten für Ihre Knowledge-Science-Projekte eröffnet.

Überlegen Sie beim Erkunden von APIs und Net Scraping, wie diese Techniken Ihre aktuelle Arbeit verbessern könnten. Gibt es öffentliche APIs, die wertvolle Daten für Ihre Projekte liefern könnten? Welche Web sites enthalten Informationen, die Ihre vorhandenen Datensätze ergänzen könnten? Mit diesen Fähigkeiten in Ihrem Toolkit sind Sie bereit, die Fülle der on-line verfügbaren Informationen zu erkunden und optimum zu nutzen.

Wir laden Sie auch ein, sich unserem anzuschließen Dataquest-Group um mit anderen Lernenden in Kontakt zu treten und Ihre Erfahrungen auszutauschen. Es ist ein großartiger Ort, um Unterstützung zu finden, Ideen auszutauschen und weiter zu wachsen Datenwissenschaftler.