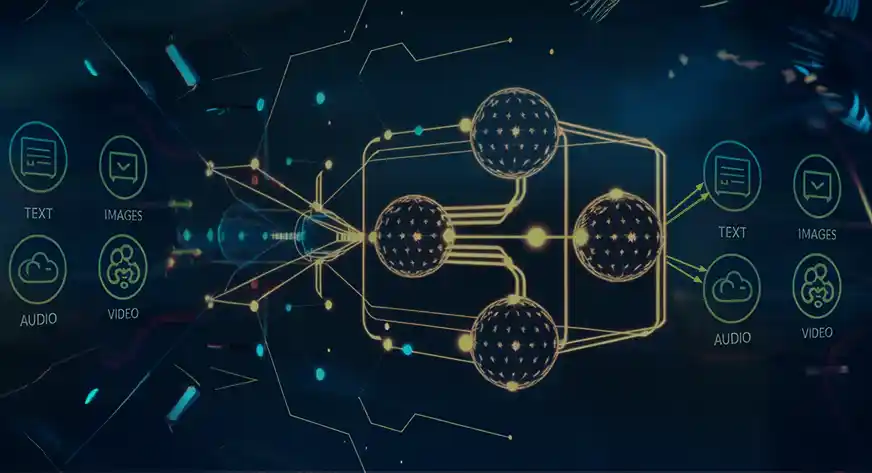

Der rasante Fortschritt der künstlichen Intelligenz (KI) hat zu einer neuen Ära von Modellen geführt, die darauf ausgelegt sind, Daten über mehrere Modalitäten hinweg zu verarbeiten und zu generieren. Dazu gehören Textual content, Bilder, Audio und Video. Diese multimodalen Modelle werden zunehmend in verschiedenen Anwendungen eingesetzt, von der Inhaltserstellung bis hin zu erweiterten Analysen. Dieser Artikel führt Sie in das Konzept multimodaler Modelle ein und vergleicht sieben der beliebtesten derzeit verfügbaren multimodalen Modelle (sowohl Open-Supply- als auch proprietäre Modelle). Es zeigt Ihnen, wann und wo Sie jedes Modell basierend auf seinen Funktionen, Anwendungsfällen, Zugänglichkeit und Kosten verwenden sollten.

Was sind multimodale Modelle?

Multimodale Modelle sind spezialisierte KI-Architekturen, die darauf ausgelegt sind, Daten aus verschiedenen Modalitäten zu verarbeiten und zu integrieren. Sie können Aufgaben wie das Generieren von Textual content aus Bildern, das Klassifizieren von Bildern anhand von beschreibendem Textual content und das Beantworten von Fragen ausführen, die sowohl visuelle als auch textliche Informationen beinhalten. Diese Modelle werden in der Regel an großen Datensätzen mit unterschiedlichen Datentypen trainiert, wodurch sie komplexe Beziehungen zwischen verschiedenen Modalitäten erlernen können.

Multimodale Modelle sind für Aufgaben, die ein kontextuelles Verständnis über verschiedene Formate hinweg erfordern, unverzichtbar geworden. Sie können beispielsweise Suchmaschinen verbessern, den Kundenservice durch Chatbots verbessern, die Generierung erweiterter Inhalte ermöglichen und bei Bildungstools helfen.

Erfahren Sie mehr: Erkundung der fortschrittlichen multimodalen generativen KI

Liste der 7 beliebtesten multimodalen Modelle

Die folgende Tabelle vergleicht die Modalitäten, Stärken, Kosten und andere Particulars der 7 beliebtesten derzeit verfügbaren multimodalen Modelle.

| # | Modell | Modalitätsunterstützung | Open Supply / Proprietär | Zugang | Kosten* | Am besten für | Veröffentlichungsdatum |

| 1 | Lama 3,2 90B | Textual content, Bild | Open Supply | Gemeinsam KI | Kostenlose Credit im Wert von 5 $ | Anweisungen befolgen | September 2024 |

| 2 | Gemini 1.5 Flash | Textual content, Bild, Video, Audio | Proprietär | Google KI Dienstleistungen | Beginnt um 0,00002 $ / Bild | Ganzheitliches Verständnis | September 2024 |

| 3 | Florenz | Textual content, Bild | Open Supply | Umarmendes Gesicht | Frei | Stärke des Computersehens | Juni 2024 |

| 4 | GPT-4o | Textual content, Bild | Proprietär | OpenAI Abonnement | Beginnt um 2,5 $ professional 1 Mio. Eingabe-Token | Optimierte Leistung | Mai 2024 |

| 5 | Claude 3 | Textual content, Bild | Proprietär | Claude AI | Sonett: FreeOpus: 20 $/MonatHaiku: 20 $/Monat | Ethischer KI-Fokus | März 2024 |

| 6 | LLaVA V1.5 7B | Textual content, Bild, Audio | Open Supply | Groq Cloud | Frei | Interaktion in Echtzeit | Januar 2024 |

| 7 | DALL·E 3 | Textual content, Bild | Proprietär | OpenAI Plattform | Beginnt um 0,040 $/Bild | Inpainting, hochwertige Technology | Oktober 2023 |

*Die genannten Preise sind auf dem Stand vom 21. Oktober 2024

Lassen Sie uns nun ihre Funktionen und Anwendungsfälle genauer untersuchen.

1. Lama 3,2 90B

Meta-KIs Lama 3.2 90B ist derzeit eines der fortschrittlichsten und beliebtesten multimodalen Modelle, die verwendet werden. Diese neueste Variante der Llama-Serie kombiniert Funktionen zum Befolgen von Anweisungen mit fortschrittlicher Bildinterpretation und deckt so ein breites Spektrum an Benutzeranforderungen ab. Das Modell wurde entwickelt, um Aufgaben zu erleichtern, die sowohl das Verständnis als auch die Generierung von Antworten auf der Grundlage multimodaler Eingaben erfordern.

Merkmale:

- Anweisungen folgen: Entwickelt für die Handhabung komplexer Benutzeranweisungen, die sowohl Textual content als auch Bilder umfassen.

- Hohe Effizienz: Kann große Datenmengen schnell verarbeiten und verbessert so seinen Nutzen in dynamischen Umgebungen.

- Robuste multimodale Interaktion: Integriert Textual content- und Bilddaten, um umfassende Antworten bereitzustellen.

Anwendungsfälle:

- Interaktive Lernplattformen: Hilft bei der Bereitstellung von Anweisungen und Erklärungen für komplexe visuelle Inhalte und macht das Lernen ansprechender.

- Technische Help-Anwendungen: Nützlich, um Benutzer mit einer Kombination aus Bildern und Schritt-für-Schritt-Anleitungen durch Fehlerbehebungsprozesse zu führen.

2. Gemini 1.5 Flash

Gemini 1.5 Flash ist Googles neuestes leichtes multimodales Modell, das Textual content, Bilder, Movies und Audio mit großer Geschwindigkeit und Effizienz verarbeiten kann. Aufgrund seiner Fähigkeit, umfassende Einblicke in verschiedene Datenformate zu liefern, eignet es sich für Anwendungen, die ein tieferes Verständnis des Kontexts erfordern.

Merkmale:

- Multimedia-Verarbeitung: Verarbeitet mehrere Datentypen gleichzeitig und ermöglicht so erweiterte Interaktionen.

- Konversationsintelligenz: Besonders effektiv bei Dialogen mit mehreren Runden, bei denen der Kontext früherer Interaktionen von entscheidender Bedeutung ist.

- Dynamische Antwortgenerierung: Erzeugt Antworten, die das Verständnis verschiedener Medieneingaben widerspiegeln.

Anwendungsfälle:

- Virtuelle Assistenten: Verbessert die Funktionalität intelligenter Assistenten, indem es ihnen ermöglicht, auf Anfragen zu reagieren, die sowohl Textual content als auch Bilder umfassen.

- Instruments zur Inhaltserstellung: Nützlich bei der Erstellung von Multimedia-Inhalten für soziale Medien oder Web sites, indem Textual content und Bildmaterial nahtlos kombiniert werden.

3. Florenz 2

Florenz 2 ist ein leichtes Modell von Microsoft, das hauptsächlich für Laptop-Imaginative and prescient-Aufgaben entwickelt wurde und gleichzeitig Texteingaben integriert. Seine Fähigkeiten ermöglichen die Durchführung komplexer Analysen visueller Inhalte. Dies macht es zu einem unschätzbar wertvollen Modell für Imaginative and prescient-Language-Anwendungen wie OCR, Untertitel, Objekterkennung, Instanzsegmentierung usw.

Merkmale:

- Starke visuelle Erkennung: Hervorragend darin, visuelle Inhalte zu identifizieren und zu kategorisieren und detaillierte Erkenntnisse zu liefern.

- Komplexe Abfrageverarbeitung: Verarbeitet Benutzeranfragen, die Textual content und Bilder effektiv kombinieren.

Anwendungsfälle:

- Automatisiertes Content material-Tagging: Optimiert die Verwaltung visueller Inhalte durch automatisches Taggen von Bildern basierend auf ihren Attributen.

- Visuelle Frage-Antwort-Systeme: Ermöglicht Benutzern, Fragen zu Bildern zu stellen und so informative und relevante Antworten zu generieren.

4. GPT-4o

GPT-4o ist eine optimierte Model von GPT-4, die auf Effizienz und Leistung bei der Verarbeitung von Textual content und Bildern ausgelegt ist. Seine Architektur ermöglicht schnelle Reaktionen und qualitativ hochwertige Ausgaben, was ihn zur bevorzugten Wahl für verschiedene Anwendungen macht.

Merkmale:

- Optimierte Leistung: Höhere Verarbeitungsgeschwindigkeiten ohne Einbußen bei der Ausgabequalität, geeignet für Echtzeitanwendungen.

- Multimodale Fähigkeiten: Behandelt effektiv eine Vielzahl von Abfragen, die sowohl Textual content- als auch visuelle Daten umfassen.

Anwendungsfälle:

- Kundenbindungsplattformen: Verbessert die Interaktion durch die Bereitstellung sofortiger und relevanter Antworten basierend auf Benutzereingaben.

- Assistenten für kreatives Schreiben: Unterstützt Autoren durch die Generierung von Ideen und Erzählungen, die mit den bereitgestellten Bildern übereinstimmen.

5. Claude 3.5

Claude 3.5 ist ein von Anthropic entwickeltes multimodales Modell, das sich auf ethische KI und sichere Interaktionen konzentriert. Dieses Modell kombiniert Textual content- und Bildverarbeitung und stellt dabei die Sicherheit und Zufriedenheit der Benutzer in den Vordergrund. Es ist in drei Größen erhältlich: Haiku, Sonnet und Opus.

Merkmale:

- Sicherheitsprotokolle: Entwickelt, um schädliche Ergebnisse zu minimieren und sicherzustellen, dass die Interaktionen konstruktiv bleiben.

- Menschenähnliche Interaktionsqualität: Der Schwerpunkt liegt auf der Schaffung natürlicher, ansprechender Antworten, sodass es für ein breites Publikum geeignet ist.

- Multimodales Verständnis: Integriert Textual content und Bilder effektiv, um umfassende Antworten zu geben.

Anwendungsfälle:

- Bildungsplattformen: Bietet Suggestions zur visuellen Arbeit, hilft den Lernenden, sich zu verbessern und sorgt gleichzeitig für eine sichere Umgebung.

- Inhaltsmoderation: Hilft beim Filtern unangemessener Inhalte, indem es sowohl Textual content- als auch visuelle Eingaben versteht.

6. LLaVA V1.5 7B

LLaVA (Massive Language and Imaginative and prescient Assistant) ist ein fein abgestimmtes Modell. Es nutzt die visuelle Instruktionsoptimierung, um die bildbasierte, natürliche Instruktionsbefolgung und die Fähigkeit zum visuellen Denken zu unterstützen. Aufgrund seiner geringen Größe eignet es sich für interaktive Anwendungen wie Chatbots oder virtuelle Assistentendie eine Interaktion mit den Benutzern in Echtzeit erfordern. Seine Stärken liegen in der gleichzeitigen Verarbeitung von Textual content, Audio und Bildern.

Merkmale:

- Echtzeit-Interaktion: Bietet sofortige Antworten auf Benutzeranfragen und sorgt dafür, dass sich Gespräche natürlicher anfühlen.

- Kontextbewusstsein: Besseres Verständnis von Benutzerabsichten, die verschiedene Datentypen kombinieren.

- Visuelle Beantwortung von Fragen: Identifiziert Textual content in Bildern durch optische Zeichenerkennung (OCR) und beantwortet Fragen basierend auf dem Bildinhalt.

Anwendungsfälle:

- Bildunterschrift: Hilft bei der Erstellung von Textbeschreibungen für Bilder, sodass sehbehinderte Benutzer den Inhalt von Bildern leichter verstehen können.

- Multimodale Dialogsysteme: Hilft Kundendienst-Chatbots, Gespräche mit Kunden zu führen und Textual content- und visuelle Fragen zu Produkten zu beantworten.

7. DALL·E 3

Offene KIs DALL·E 3 ist ein leistungsstarkes Bildgenerierungsmodell, das Textbeschreibungen in lebendige und detaillierte Bilder übersetzt. Dieses Modell ist bekannt für seine Kreativität und seine Fähigkeit, nuancierte Eingabeaufforderungen zu verstehen, sodass Benutzer Bilder erstellen können, die ihrer Vorstellungskraft am nächsten kommen.

Merkmale:

- Textual content-zu-Bild-Generierung: Wandelt detaillierte Eingabeaufforderungen in einzigartige Bilder um und bietet so umfangreiche kreative Möglichkeiten.

- Inpainting-Funktionalität: Benutzer können vorhandene Bilder ändern, indem sie Änderungen im Textual content beschreiben, was Flexibilität bei der Bildbearbeitung bietet.

- Fortgeschrittenes Sprachverständnis: Der Kontext und die Feinheiten der Sprache werden besser verstanden, was zu genaueren visuellen Darstellungen führt.

Anwendungsfälle:

- Marketingkampagnen: Unternehmen können schnell maßgeschneiderte Visuals für Anzeigen erstellen, ohne dass dafür Kenntnisse im Bereich Grafikdesign erforderlich sind.

- Konzeptkunsterstellung: Künstler können das Modell zum Brainstorming von Ideen und zur Visualisierung von Konzepten nutzen und so den kreativen Prozess beschleunigen.

Abschluss

Multimodale Modelle erweitern die Grenzen der KI, indem sie verschiedene Arten von Daten integrieren, um immer komplexere Aufgaben auszuführen. Von der Kombination von Textual content und Bildern bis hin zur Analyse von Echtzeitvideos mit Audio eröffnen diese Modelle neue Möglichkeiten in Branchen wie dem Gesundheitswesen, der Erstellung von Inhalten und der virtuellen Realität.

In diesem Artikel haben wir die Funktionen und Anwendungsfälle von 7 beliebten multimodalen KI-Modellen untersucht. Die Auswahl des richtigen Modells hängt jedoch von der konkreten Aufgabenstellung ab. Ob Sie Bilder generieren, vielfältige Dateneingaben analysieren oder Movies in Echtzeit optimieren, es gibt ein darauf spezialisiertes multimodales Modell. Mit der Weiterentwicklung der KI werden multimodale Modelle mehr Datentypen für komplexere und vielfältigere Anwendungsfälle umfassen.

Erfahren Sie mehr: Welche Zukunft erwartet Sie mit multimodaler KI?

Häufig gestellte Fragen

A. Multimodale Modelle sind KI-Systeme, die Daten über mehrere Modalitäten hinweg verarbeiten und generieren können, wie z. B. Textual content, Bilder, Audio, Video und mehr, und so ein breites Anwendungsspektrum ermöglichen.

A. Multimodale Modelle sind hilfreich bei Anwendungen, die das Verständnis oder die Generierung von Daten in verschiedenen Formaten erfordern, beispielsweise die Kombination von Textual content und Bildern für einen verbesserten Kontext.

A: Herkömmliche Modelle konzentrieren sich typischerweise auf einen einzelnen Datentyp (wie Textual content oder Bilder), während multimodale Modelle mehrere Datentypen gleichzeitig integrieren und verarbeiten können.

A. Die Kosten eines multimodalen Modells können je nach Modell, Nutzung und Zugangsmethode stark variieren. Einige multimodale Modelle sind jedoch kostenlos verfügbar oder bieten Open-Supply-Optionen.

A. Die meisten der in diesem Artikel besprochenen multimodalen Modelle sind über APIs oder Plattformen wie HuggingFace verfügbar.

A. Je nach Modell bieten einige möglicherweise Feinabstimmungsoptionen, während andere in erster Linie vorab trainiert sind und nicht für die Anpassung auf Benutzerebene gedacht sind.

A. Für den Umgang mit unterschiedlichen Datentypen werden verschiedene multimodale Modelle erstellt. Dies kann Textual content, Bild, Video und Audio umfassen.