Ganz oben auf vielen Wunschlisten zur Automatisierung steht eine besonders zeitaufwändige Aufgabe: die Hausarbeit.

Das Ziel vieler Robotiker besteht darin, die richtige Kombination aus Laborious- und Software program zu entwickeln, damit eine Maschine „generalistische“ Richtlinien (die Regeln und Strategien, die das Verhalten von Robotern steuern) erlernen kann, die überall und unter allen Bedingungen funktionieren. Realistisch betrachtet ist es Ihnen jedoch wahrscheinlich egal, ob ein Roboter in Ihrem Zuhause für Ihre Nachbarn arbeitet oder nicht. Forscher des Laptop Science and Synthetic Intelligence Laboratory (CSAIL) des MIT beschlossen daher, eine Lösung zu finden, mit der sich Roboter problemlos robuste Richtlinien für sehr spezifische Umgebungen aneignen lassen.

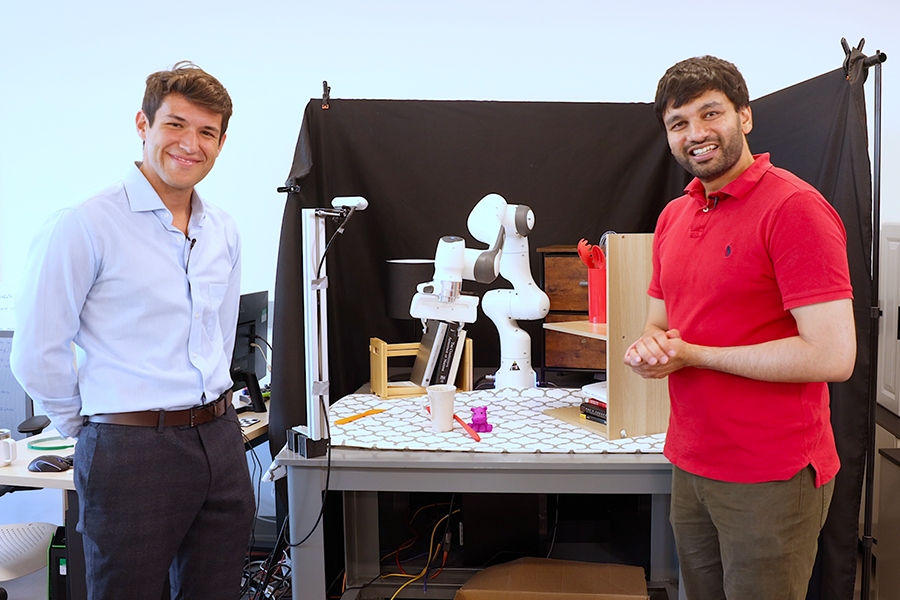

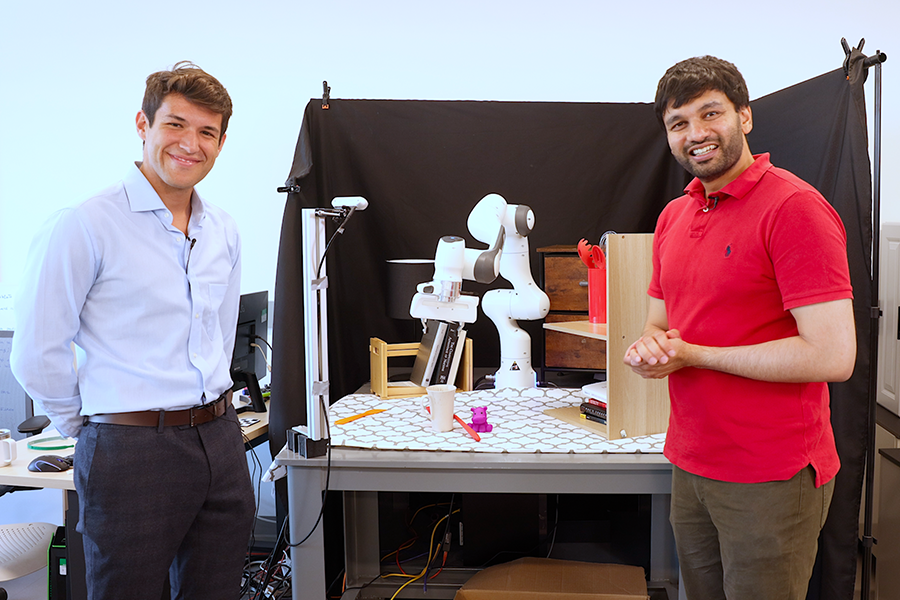

„Unser Ziel ist es, Roboter zu entwickeln, die unter Störungen, Ablenkungen, unterschiedlichen Lichtverhältnissen und Änderungen der Objektpositionen außergewöhnlich intestine funktionieren, und das alles in einer einzigen Umgebung“, sagt Marcel Torne Villasevil, Forschungsassistent am CSAIL des MIT im Unbelievable AI-Labor und Hauptautor einer kürzlich erschienenen Papier über die Arbeit. „Wir schlagen eine Methode vor, um digitale Zwillinge im Handumdrehen zu erstellen, indem wir die neuesten Fortschritte in der Computervision nutzen. Mit nur einem Telefon kann jeder eine digitale Nachbildung der realen Welt erfassen, und die Roboter können dank GPU-Parallelisierung in einer simulierten Umgebung viel schneller trainieren als in der realen Welt. Unser Ansatz macht umfangreiches Reward Engineering überflüssig, indem er einige Demonstrationen in der realen Welt nutzt, um den Trainingsprozess anzukurbeln.“

Nehmen Sie Ihren Roboter mit nach Hause

RialTo ist natürlich etwas komplizierter als nur eine einfache Bewegung mit dem Telefon und (bumm!) der House-Bot steht zu Ihrer Verfügung. Zunächst wird mit Ihrem Gerät die Zielumgebung mithilfe von Instruments wie NeRFStudio, ARCode oder Polycam gescannt. Sobald die Szene rekonstruiert ist, können Benutzer sie auf die RialTo-Schnittstelle hochladen, um detaillierte Anpassungen vorzunehmen, den Robotern die erforderlichen Gelenke hinzuzufügen und vieles mehr.

Die verfeinerte Szene wird exportiert und in den Simulator gebracht. Ziel ist es, eine Strategie auf Grundlage realer Aktionen und Beobachtungen zu entwickeln, wie etwa das Greifen einer Tasse auf einer Theke. Diese realen Demonstrationen werden in der Simulation nachgestellt und liefern wertvolle Daten für das bestärkende Lernen. „Dies hilft bei der Entwicklung einer starken Strategie, die sowohl in der Simulation als auch in der realen Welt intestine funktioniert. Ein verbesserter Algorithmus mit bestärkendem Lernen hilft bei der Steuerung dieses Prozesses, um sicherzustellen, dass die Strategie auch außerhalb des Simulators wirksam ist“, sagt Torne.

Exams zeigten, dass RialTo für eine Vielzahl von Aufgaben starke Richtlinien entwickelte, sei es in kontrollierten Laborumgebungen oder in unvorhersehbareren realen Umgebungen, und dabei eine um 67 Prozent bessere Leistung als Imitationslernen bei gleicher Anzahl von Demonstrationen erzielte. Die Aufgaben umfassten das Öffnen eines Toasters, das Platzieren eines Buches in einem Regal, das Abstellen eines Tellers auf einem Gestell, das Platzieren einer Tasse in einem Regal, das Öffnen einer Schublade und das Öffnen eines Schranks. Für jede Aufgabe testeten die Forscher die Leistung des Techniques in drei zunehmenden Schwierigkeitsstufen: zufällige Objektpositionen, Hinzufügen visueller Ablenkungen und Anwenden physischer Störungen während der Aufgabenausführung. In Verbindung mit realen Daten übertraf das System traditionelle Imitationslernmethoden, insbesondere in Situationen mit vielen visuellen Ablenkungen oder physischen Störungen.

„Diese Experimente zeigen, dass, wenn wir Wert darauf legen, gegenüber einer bestimmten Umgebung sehr sturdy zu sein, die beste Idee darin besteht, digitale Zwillinge zu nutzen, statt zu versuchen, Robustheit durch die groß angelegte Datenerfassung in unterschiedlichen Umgebungen zu erreichen“, sagt Pulkit Agrawal, Leiter des Unbelievable AI Lab, außerordentlicher Professor für Elektrotechnik und Informatik (EECS) am MIT, leitender Forscher am MIT CSAIL und leitender Autor der Arbeit.

Was die Einschränkungen betrifft, so dauert es derzeit drei Tage, bis RialTo vollständig trainiert ist. Um dies zu beschleunigen, erwähnt das Workforce die Verbesserung der zugrunde liegenden Algorithmen und die Verwendung von Basismodellen. Das Coaching in der Simulation hat auch seine Einschränkungen, und derzeit ist es schwierig, mühelos eine Übertragung von der Simulation in die reale Welt durchzuführen und verformbare Objekte oder Flüssigkeiten zu simulieren.

Das nächste Stage

Wie geht es additionally weiter mit RialTo? Aufbauend auf früheren Bemühungen arbeiten die Wissenschaftler daran, die Robustheit gegenüber verschiedenen Störungen zu erhalten und gleichzeitig die Anpassungsfähigkeit des Modells an neue Umgebungen zu verbessern. „Unser nächstes Unterfangen ist dieser Ansatz, vorab trainierte Modelle zu verwenden, den Lernprozess zu beschleunigen, den menschlichen Enter zu minimieren und breitere Generalisierungsmöglichkeiten zu erreichen“, sagt Torne.

„Wir sind unglaublich begeistert von unserem Konzept der ‚on-the-fly‘-Roboterprogrammierung, bei dem Roboter ihre Umgebung autonom scannen und lernen können, wie sie in der Simulation bestimmte Aufgaben lösen. Obwohl unsere aktuelle Methode Einschränkungen hat – wie etwa, dass einige anfängliche Demonstrationen durch einen Menschen erforderlich sind und eine erhebliche Rechenzeit zum Trainieren dieser Richtlinien (bis zu drei Tage) erforderlich ist – sehen wir sie als einen bedeutenden Schritt in Richtung ‚on-the-fly‘-Roboterlernen und -einsatz“, sagt Torne. „Dieser Ansatz bringt uns einer Zukunft näher, in der Roboter keine vordefinierte Richtlinie benötigen, die jedes Szenario abdeckt. Stattdessen können sie schnell neue Aufgaben lernen, ohne umfassend mit der realen Welt zu interagieren. Meiner Ansicht nach könnte dieser Fortschritt die praktische Anwendung der Robotik viel schneller vorantreiben, als wenn man sich ausschließlich auf eine universelle, allumfassende Richtlinie verlässt.“

„Um Roboter in der realen Welt einzusetzen, haben sich Forscher traditionell auf Methoden wie Imitationslernen aus Expertendaten verlassen, was teuer sein kann, oder Verstärkungslernen, was unsicher sein kann“, sagt Zoey Chen, eine Doktorandin der Informatik an der College of Washington, die nicht an der Arbeit beteiligt conflict. „RialTo befasst sich mit seiner neuartigen Actual-to-Sim-to-Actual-Pipeline direkt sowohl mit den Sicherheitsbeschränkungen des realen RL (Roboterlernens) als auch mit effizienten Datenbeschränkungen für datengesteuerte Lernmethoden. Diese neuartige Pipeline gewährleistet nicht nur ein sicheres und robustes Coaching in der Simulation vor dem Einsatz in der realen Welt, sondern verbessert auch die Effizienz der Datenerfassung erheblich. RialTo hat das Potenzial, das Roboterlernen erheblich zu skalieren und ermöglicht es Robotern, sich viel effektiver an komplexe reale Szenarien anzupassen.“

„Die Simulation hat beeindruckende Fähigkeiten bei echten Robotern gezeigt, indem sie kostengünstige, möglicherweise unendliche Daten für das Erlernen von Strategien liefert“, ergänzt Marius Memmel, ein Doktorand der Informatik an der College of Washington, der nicht an der Arbeit beteiligt conflict. „Diese Methoden sind jedoch auf einige wenige spezifische Szenarien beschränkt, und die Erstellung der entsprechenden Simulationen ist teuer und mühsam. RialTo bietet ein benutzerfreundliches Software, mit dem sich reale Umgebungen in Minuten statt in Stunden rekonstruieren lassen. Darüber hinaus nutzt es während des Erlernens von Strategien in großem Umfang gesammelte Demonstrationen, wodurch die Belastung des Bedieners minimiert und die Sim2Real-Lücke verringert wird. RialTo zeigt Robustheit gegenüber Objektpositionen und Störungen und zeigt eine unglaubliche Leistung in der realen Welt, ohne dass eine umfangreiche Simulatorkonstruktion und Datenerfassung erforderlich ist.“

Torne hat dieses Papier zusammen mit den leitenden Autoren Abhishek Gupta, Assistenzprofessor an der College of Washington, und Agrawal verfasst. Vier weitere CSAIL-Mitglieder sind ebenfalls genannt: EECS-Doktorand Anthony Simeonov SM ’22, Forschungsassistent Zechu Li, Studentin April Chan und Tao Chen PhD ’24. Mitglieder des Unbelievable AI Lab und des WEIRD Lab haben ebenfalls wertvolles Suggestions und Unterstützung bei der Entwicklung dieses Projekts geliefert.

Diese Arbeit wurde teilweise vom Sony Analysis Award, der US-Regierung und Hyundai Motor Co. unterstützt, mit Unterstützung des WEIRD (Washington Embodied Intelligence and Robotics Growth) Lab. Die Forscher präsentierten ihre Arbeit Anfang dieses Monats auf der Konferenz Robotics Science and Techniques (RSS).