Salesforce AI Analysis veröffentlicht Coda-1.7bein diffusionsbasiertes Sprachmodell für Code, das von generiert wird Denoising ganzer Sequenzen mit bidirektionalem KontextAktualisierung mehrere Token parallel eher anstatt von der nächsten nach rechts zu rechten Vorhersage. Das Forschungsteam veröffentlichte beide Base Und Anweisen Checkpoints und ein Finish-to-Finish-Trainings-/Bewertungs-/Servierstapel.

Verständnis der Architektur und des Trainings

Coda passt ein 1,7b-Parameter-Rückgrat an Diskrete Verbreitung Für Textual content: Maskierte Sequenzen werden iterativ unter Verwendung der Aufmerksamkeit der Sachhäuser iterativ abgelenkt, wodurch einheimische Infillieren und nicht autoregressive Decodierung ermöglicht werden. Die Modellkarten dokumentiert a dreistufige Pipeline (Vorausbildung mit bidirektionaler Maskierung, beaufsichtigtem Nachtraining und progressiver Denoising bei Inferenz) und reproduzierbare Skripte für TPU-Vorausbildung, GPU-Feinabstimmung und Bewertung.

Die wichtigsten Funktionen sind in der Veröffentlichung aufgetaucht:

- Bidirektionaler Kontext über Diffusions -Denoising (keine feste Erzeugungsreihenfolge).

- Konfidenzgesteuerte Probenahme (Entropiestil-Dekodierung) zur Handelsqualität im Vergleich zu Geschwindigkeit.

- Offene Trainingspipeline mit Bereitstellung von Skripten und CLI.

Wie treten sie mit Benchmarks auf?

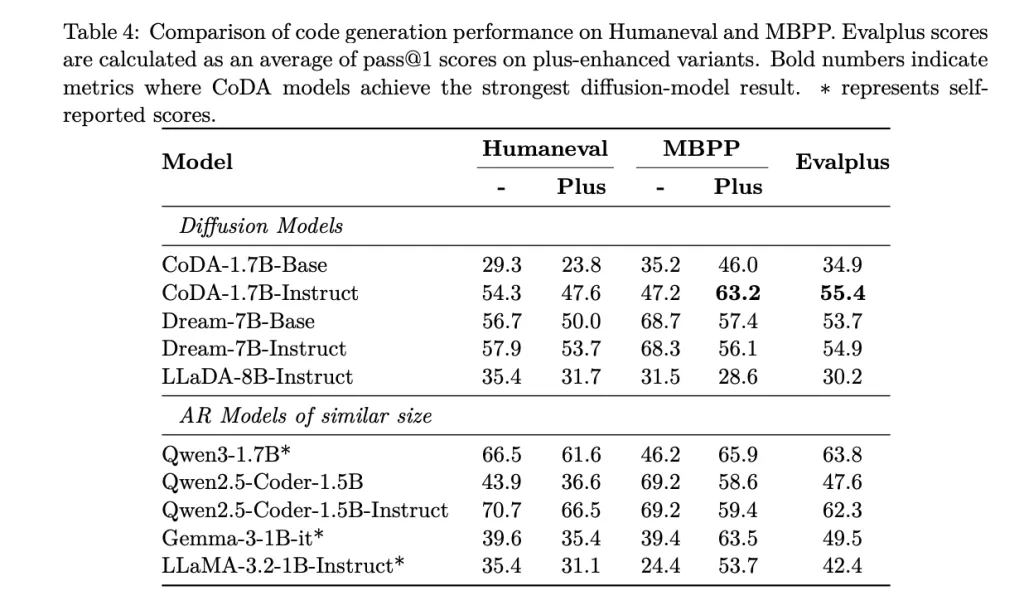

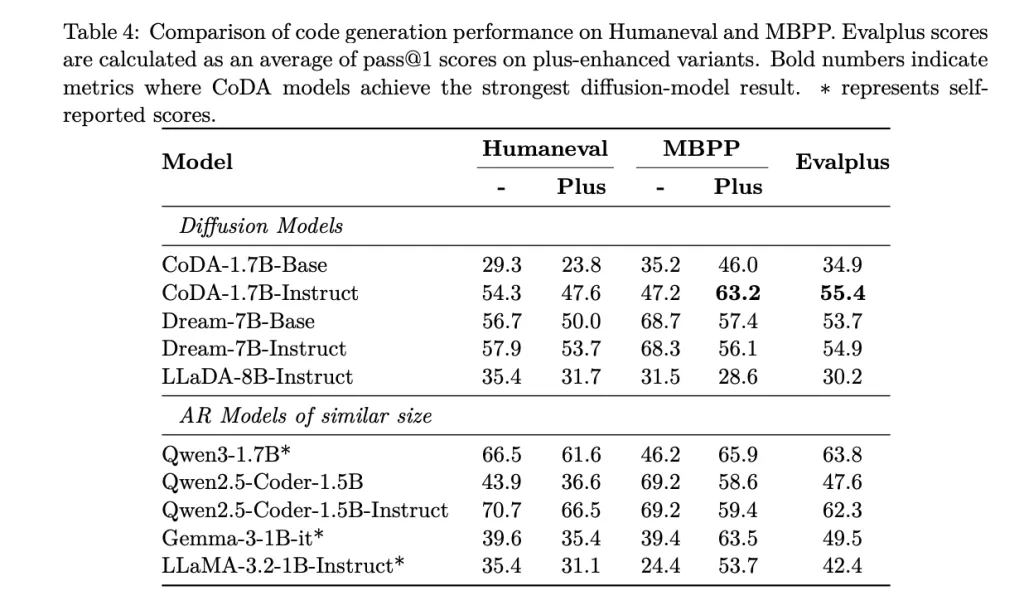

Auf Customary-Code-Gen-Suiten, Coda-1.7b-unstruktur Berichte: Humanerad 54,3%Anwesend Humanerover+ 47,6%Anwesend MBPP 47,2%Anwesend MBPP+ 63,2%Anwesend Evalplus aggregieren 55,4% (Cross@1). Für den Kontext ist die Modellkarte mit Diffusionsbasislinien einschließlich Dream-7b-Instruct (vergleichbar (57,9% Humaner) mit Coda 1.7b Fußabdruck ist mit einigen wettbewerbsfähig 7b Diffusionsmodelle zu mehreren Metriken und unter Verwendung weniger Parameter.

Inferenzverhalten

Die Erzeugungskosten unterliegen den Anzahl der Diffusionsschritte; Coda enthüllt Knöpfe wie z. STEPSAnwesend ALG="entropy"Anwesend ALG_TEMPund blocklänge zum Einstellen Latenz-/Qualitätskompromente. Da Token unter voller Aufmerksamkeit parallel aktualisiert werden, zielt die Coda niedriger ab Wandverkleidungslatenz in kleinem Maßstab im Vergleich zu größeren Diffusionsmodellen bei vergleichbaren Schrittbudgets. (Umarmtes Gesicht)

Bereitstellung und Lizenzierung

Das Repository bietet a Fastapi-Server mit OpenAI-kompatiblen APIs und eine interaktive CLI für lokale Inferenz; Zu den Anweisungen gehören Umgebungsanlagen und a start_server.sh Launcher. Modellkarten und a Umarmende Gesichtskollektion Artefakte zentralisieren. Die Kontrollpunkte werden unter veröffentlicht CC BY-NC 4.0 An Umarmtes Gesicht.

Coda-1.7b steht als saubere Referenz für die Erzeugung diskreter Diffusionscode in kleinem Maßstab: 1,7b-Parameter, bidirektionale Beenosing mit parallelen Token-Updates und eine reproduzierbare Pipeline von der Voraussetzung bis zu SFT und Servieren. Der gemeldete Cross@1-Ergebnisse-Humaneval 54,3, Humaneval+ 47,6, MBPP 47,2, MBPP+ 63,2, Evalplus aggregieren 55,4-platzieren Sie sie wettbewerbsfähig mit etwa 7B-Diffusions-Baselines (z. B. Dream-7b Humaneval 57,9) und verwenden nur wenige Parameter. Die Inferenzlatenz wird ausdrücklich von Schritt und Dekodierungsknöpfen regiert (Knöpfe (Decoding) (STEPSAnleitung im Entropiestil), die operativ zum Abtun von Durchsatz/Qualität nützlich ist. Die Veröffentlichung enthält Gewichte auf dem Umarmungsgesicht und einen Fastapi -Server/CLI für die lokale Bereitstellung.

Schauen Sie sich das an PapierAnwesend Github Repo Und Modell auf dem Umarmungsgesicht. Fühlen Sie sich frei, unsere zu überprüfen Github -Seite für Tutorials, Codes und Notizbücher. Fühlen Sie sich auch frei, uns zu folgen Twitter Und vergessen Sie nicht, sich unserer anzuschließen 100k+ ml Subreddit und abonnieren Unser E-newsletter. Warten! Bist du im Telegramm? Jetzt können Sie sich uns auch im Telegramm anschließen.

Asif Razzaq ist der CEO von Marktechpost Media Inc. Sein jüngstes Bestreben ist die Einführung einer Medienplattform für künstliche Intelligenz, Marktechpost, die sich durch die ausführliche Berichterstattung über maschinelles Lernen und Deep-Studying-Nachrichten auszeichnet, die von einem breiten Publikum technisch intestine und leicht verständlich sind. Die Plattform verfügt über über 2 Millionen monatliche Ansichten und veranschaulicht ihre Beliebtheit des Publikums.