In den heutigen Geschäftsanwendungen verändern APIs (Utility Programming Interfaces) die Artwork und Weise, wie wir KI-Funktionen integrieren und nutzen. Sie fungieren als entscheidende Brücken und ermöglichen die nahtlose Integration von Giant Language Fashions (LLMs) in verschiedene Software program-Ökosysteme. Durch die Erleichterung eines effizienten Datenaustauschs und der gemeinsamen Nutzung von Funktionen ermöglichen APIs sowohl von Open- als auch von Closed-Supply-LLMs, dass Anwendungen die Leistungsfähigkeit von LLMs nutzen können. In diesem Artikel werden verschiedene kostenlose und kostenpflichtige APIs untersucht, die für den Zugriff auf verschiedene LLMs für ihre Anwendungen verwendet werden.

Informationen zu verschiedenen kostenlosen und kostenpflichtigen LLMs-Chat-Schnittstellen für tägliche Aufgaben finden Sie in unserem vorherigen Blogbeitrag mit dem Titel: 12 kostenlose und kostenpflichtige LLMs für Ihre täglichen Aufgaben.

Was ist eine API?

APIs sind digitale Konnektoren, die es verschiedenen Softwareanwendungen ermöglichen, zu kommunizieren und Daten auszutauschen. Sie fungieren als Vermittler und ermöglichen eine nahtlose Interaktion zwischen verschiedenen Programmen und Systemen.

APIs sind überall in unserem täglichen Leben verfügbar – sei es bei der Nutzung von Mitfahr-Apps, beim mobilen Bezahlen oder bei der Fernanpassung von Sensible-Residence-Geräten. Wenn Sie mit diesen Apps interagieren, nutzen sie APIs, um Informationen mit Servern auszutauschen, Anfragen zu verarbeiten und Ergebnisse in einem benutzerfreundlichen Format auf Ihrem Gerät bereitzustellen.

Warum brauchen wir eine LLM-API?

APIs bieten Entwicklern eine standardisierte Schnittstelle, über die sie große Sprachmodelle in ihre Programme integrieren können. Diese Standardisierung vereinfacht nicht nur die Entwicklungsabläufe, sondern garantiert auch den Zugriff auf die neuesten Modellerweiterungen. Es ermöglicht außerdem eine effektive Job-Skalierung und Auswahl geeigneter LLMs für verschiedene Aufgaben. Aufgrund der Flexibilität, die APIs bieten, können die Reaktionen von LLMs außerdem an spezifische Anforderungen angepasst werden, wodurch ihre Anpassungsfähigkeit und Eignung für eine Reihe von Szenarien erhöht wird.

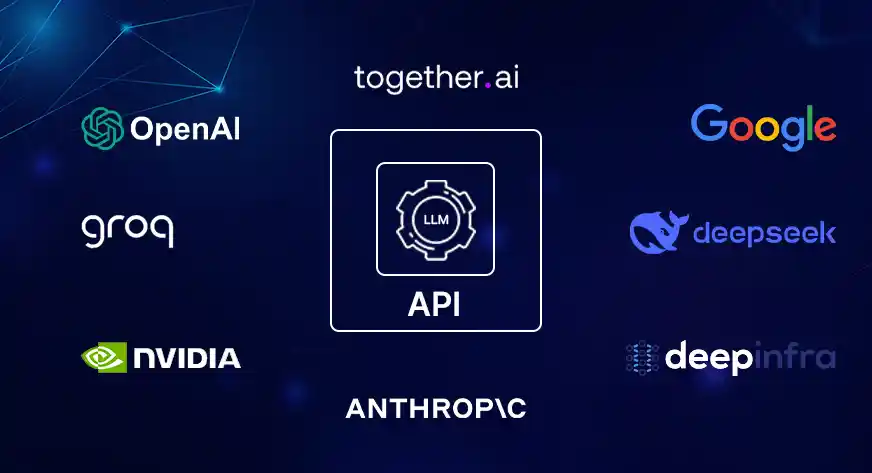

Prime-APIs für große Sprachmodelle

Lassen Sie uns nun einige der besten APIs für LLMs untersuchen und ihre Anbieter, Kosten und die Frage vergleichen, ob das LLM Open Supply ist oder nicht.

*Kostenstand: 10. Okt. 2024

Prominente API-Anbieter

API-Anbieter sind kostengünstige Cloud-Plattformen, die für die effiziente Bereitstellung von Modellen für maschinelles Lernen konzipiert sind. Sie konzentrieren sich auf den infrastrukturfreien Zugang zu fortschrittlicher KI durch benutzerfreundliche APIs, robuste Skalierung und wettbewerbsfähige Preise und machen KI für Unternehmen jeder Größe zugänglich. In diesem Abschnitt werden wir einige der bekanntesten API-Anbieter untersuchen.

1. OpenAI

OpenAI ist ein KI-Forschungs- und Bereitstellungsunternehmen, das erstmals im Jahr 2022 mit chatGPT auf den Markt kam OpenAI Die API-Preisgestaltung richtet sich nach dem verwendeten Modell und der Menge der verarbeiteten Token. Für GPT-4 gibt es je nach Verarbeitungsbedarf unterschiedliche Ebenen (8K- oder 32K-Kontextfenster), während GPT-3.5 und Einbettungen geringere Kosten verursachen. Der Preis richtet sich nach der Nutzung und gewährleistet so Flexibilität für verschiedene Anwendungen.

2. Anthropisch

AnthropischDie API von s bietet Zugriff auf die Claude-Modellfamilie. Es bietet verschiedene Ebenen, die für Geschwindigkeit, Durchsatz und Leistung für Aufgaben wie Codierung, Produktivität und Kundensupport optimiert sind. Die versatile, nutzungsbasierte Preisgestaltung eignet sich für unterschiedliche Arbeitslasten, während Optionen für individuellen Help die Anpassung an den Unternehmenseinsatz ermöglichen.

3. Google

Die API-Bibliothek auf Google Cloud Console stellt Instruments zur Integration von Firebase-Diensten in Apps bereit. Es umfasst Authentifizierung, Datenbanken, maschinelles Lernen und Analysen. Sein modulares API-Setup ermöglicht Entwicklern die Auswahl von Diensten, die zu spezifischen App-Anforderungen passen, und macht es so skalierbar und effizient für die App-Entwicklung.

4. DeepInfra

DeepInfra bietet eine kostengünstige Cloud-Plattform für die Ausführung verschiedener Modelle des maschinellen Lernens, einschließlich einer breiten Palette von LLMs, über eine einfache API. Es kümmert sich um Infrastruktur, Skalierung und Überwachung, sodass sich Benutzer auf ihre Anwendungen konzentrieren können. Mit Pay-as-you-go-Preisen und der Unterstützung mehrerer Schnittstellen bietet DeepInfra eine kostengünstige Various zu anderen API-Anbietern.

5. Deepseek

DeepSeek bietet eine kostengünstige Cloud-Plattform für maschinelles Lernen mit umfassender Unterstützung für LLMs. Es verfügt über eine Kontextbeschränkung von 128 KB, die über eine unkomplizierte API zugänglich ist. Es bietet wettbewerbsfähige Preise von 0,14 US-Greenback professional Million Enter-Tokens und 0,28 US-Greenback professional Million Output-Tokens und legt den Schwerpunkt auf effiziente Skalierung und Überwachung. Mit seiner robusten Architektur ermöglicht DeepSeek Unternehmen die Nutzung leistungsstarker Modelle, einschließlich Codierungs- und Argumentationsfunktionen, ohne die interne Infrastruktur verwalten zu müssen.

6. Groq

Die KI-Inferenztechnologie, einschließlich der Sprachverarbeitungseinheit (LPU), ist für schnelle und energieeffiziente KI-Arbeitslasten konzipiert. Groq bietet gestaffelte Preise für KI-Modelle, einschließlich Hochgeschwindigkeits-Token-Verarbeitung und wettbewerbsfähige Preise für Aufgaben wie Sprachgenerierung und Spracherkennung. Die Optionen reichen von vielseitigen Modellen für allgemeine Anwendungen bis hin zu kundenspezifischen Modellen für Unternehmenskunden und gewährleisten skalierbare Lösungen für unterschiedliche Anforderungen.

7. Gemeinsam KI

Gemeinsam KI bietet eine umfassende Plattform für die Entwicklung, Feinabstimmung und Bereitstellung groß angelegter generativer KI-Modelle. Es bietet kostengünstige GPU-Cluster, benutzerdefinierte Modell-Feinabstimmung und serverlose oder dedizierte Inferenzoptionen. Collectively AI ist für ein schnelles Modelltraining im Produktionsmaßstab mit flexibler Bereitstellung konzipiert, das auf spezifische Geschäftsanforderungen zugeschnitten ist.

8. Nvidia

NVIDIA ist ein führendes Unternehmen im Bereich Accelerated Computing, spezialisiert auf KI, Metaverse-Technologie und Hochleistungsgrafik. Das NVIDIA NIM (NVIDIA AI Microservices) ist eine robuste Suite von Container-Microservices, die für die nahtlose Bereitstellung von KI-Modellen in verschiedenen Umgebungen entwickelt wurden. NIM unterstützt Open-Supply-, NVIDIA- und benutzerdefinierte Modelle und optimiert gleichzeitig die GPU-Leistung und Beobachtbarkeit für jedes Setup.

Abschluss

APIs vereinfachen die Integration anspruchsvoller Funktionen in LLM-Anwendungen und ermöglichen Entwicklern die einfache Nutzung modernster Modellfunktionen. Dadurch können sie Aufgaben standardisieren und effektiv skalieren, unabhängig davon, ob sie proprietäre oder Open-Supply-LLMs verwenden.

Die hier besprochenen APIs bieten eine breite Palette an Limits und Anwendungsfallgenerierung, jede mit ihren eigenen Preis- und Leistungsmerkmalen. Diese Informationen helfen Ihnen, fundierte Entscheidungen bei der Auswahl einer API für Ihr Projekt zu treffen.

Häufig gestellte Fragen

A. APIs sind digitale Konnektoren, die es verschiedenen Softwareanwendungen ermöglichen, zu kommunizieren und Daten auszutauschen.

A. APIs standardisieren den LLM-Zugriff, vereinfachen die Entwicklung, stellen Updates sicher, ermöglichen Skalierung und bieten kostengünstige Lösungen für Unternehmen.

A. Berücksichtigen Sie bei der Auswahl einer LLM-API den Ruf des Anbieters, Kosten, Leistung, Funktionen, Skalierbarkeit und ob Open oder Closed Supply am besten zu Ihrem Projekt passt.

A. Die API-Kosten sind nach Modelltyp, Token-Nutzung und Anbieter strukturiert. Einige der LLM-APIs sind möglicherweise kostenpflichtig, während andere möglicherweise kostenlos verfügbar sind.

A. Zu den bekanntesten LLM-API-Anbietern gehören OpenAI (GPT-3.5, GPT-4), Google, Anthropic (Claude), Nvidia und Deepinfra.