Bild vom Herausgeber | Midjourney & Canva

Robin Sharma sagte: „Jeder Meister warfare einmal ein Anfänger. Jeder Profi warfare einmal ein Newbie.“ Sie haben schon seit einiger Zeit davon gehört, dass große Sprachmodelle (LLMs), KI und Transformer-Modelle (GPT) im KI-Bereich für Aufsehen sorgen, und sind sich nicht sicher, wie Sie damit anfangen sollen. Ich kann Ihnen versichern, dass jeder, den Sie heute komplexe Anwendungen erstellen sehen, einmal dort warfare.

Deshalb vermittelt Ihnen dieser Artikel das Wissen, das Sie benötigen, um mit der Entwicklung von LLM-Apps mit der Programmiersprache Python zu beginnen. Er ist ausschließlich für Anfänger geeignet und Sie können beim Lesen dieses Artikels mitprogrammieren.

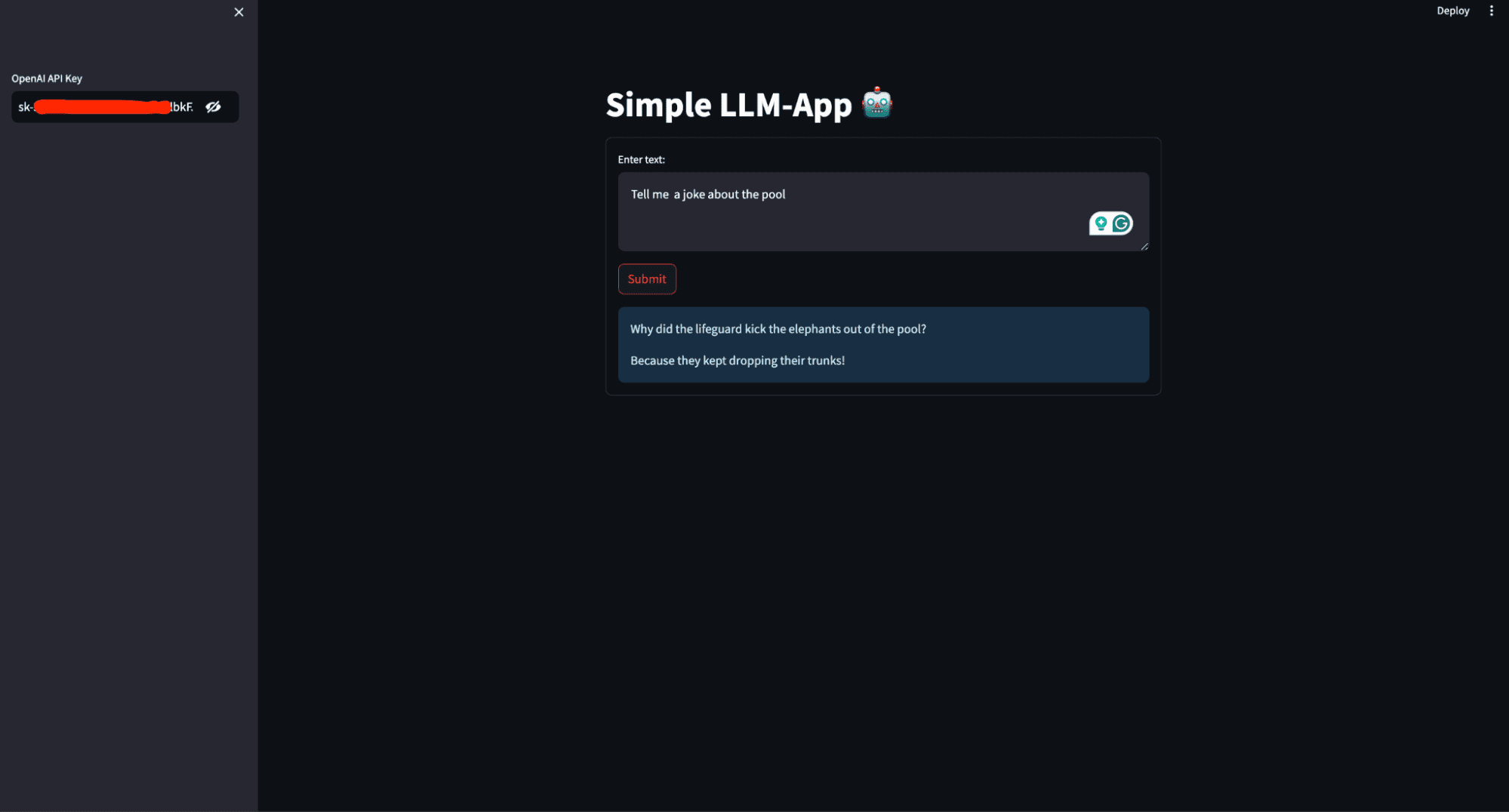

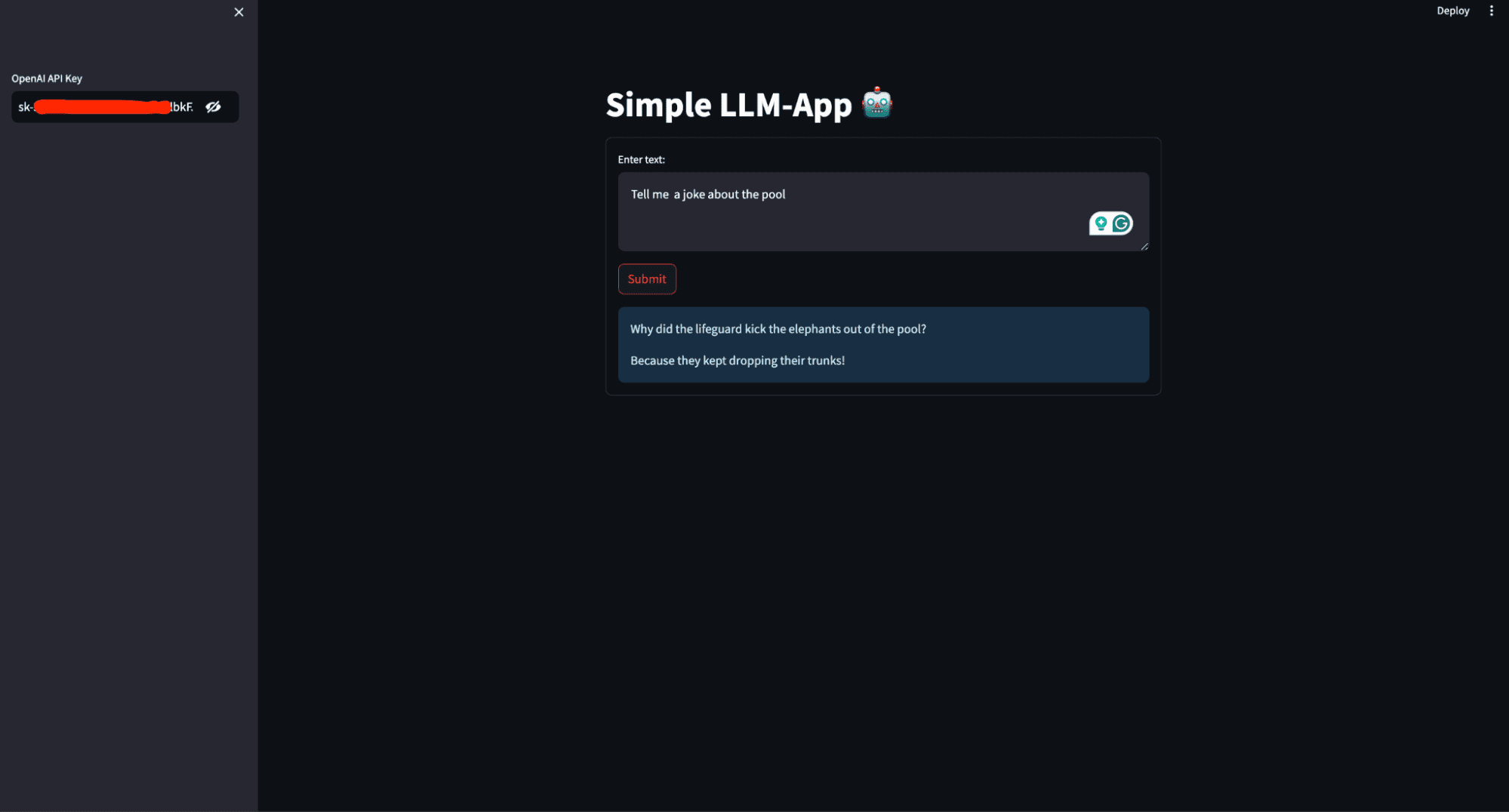

Was werden Sie in diesem Artikel erstellen? Sie werden einen einfachen persönlichen KI-Assistenten erstellen, der basierend auf der Eingabeaufforderung des Benutzers eine Antwort generiert und diese international bereitstellt. Das Bild unten zeigt, wie die fertige Anwendung aussieht.

Dieses Bild zeigt die Benutzeroberfläche des persönlichen KI-Assistenten, der in diesem Artikel erstellt wird

Voraussetzungen

Damit Sie diesen Artikel durchlesen können, müssen Sie einige Dinge im Griff haben. Dazu gehören:

- Python (3.5+) und Hintergrundwissen zum Schreiben von Python-Skripten.

- OpenAI: OpenAI ist eine Forschungsorganisation und ein Technologieunternehmen, das sich zum Ziel gesetzt hat, die künstliche allgemeine Intelligenz (AGI) der gesamten Menschheit zugute kommen zu lassen. Einer seiner wichtigsten Beiträge ist die Entwicklung fortgeschrittener LLMs wie GPT-3 Und GPT-4. Diese Modelle können menschenähnlichen Textual content verstehen und generieren, was sie zu leistungsstarken Instruments für verschiedene Anwendungen wie Chatbots, Content material-Erstellung und mehr macht.

Melden Sie sich an für OpenAI und kopieren Sie Ihre API-Schlüssel aus dem API-Bereich Ihres Kontos, damit Sie auf die Modelle zugreifen können. Installieren Sie OpenAI mit dem folgenden Befehl auf Ihrem Pc:

- LangChain:LangChain ist ein Framework, das die Entwicklung von Anwendungen, die LLMs nutzen, vereinfachen soll. Es bietet Instruments und Dienstprogramme zum Verwalten und Optimieren der verschiedenen Aspekte der Arbeit mit LLMs und erleichtert so die Erstellung komplexer und robuster Anwendungen.

Installieren Sie LangChain mit dem folgenden Befehl auf Ihrem Pc:

- Streamlit: Streamlit ist eine leistungsstarke und benutzerfreundliche Python-Bibliothek zum Erstellen von Webanwendungen. Mit Streamlit können Sie interaktive Webanwendungen nur mit Python erstellen. Sie benötigen keine Fachkenntnisse in der Webentwicklung (HTML, CSS, JavaScript), um funktionale und optisch ansprechende Net-Apps zu erstellen.

Es ist nützlich für die Entwicklung von Apps für maschinelles Lernen und Datenwissenschaft, einschließlich solcher, die LLMs verwenden. Installieren Sie streamlit mit dem folgenden Befehl auf Ihrem Pc:

Code entlang

Wenn alle erforderlichen Pakete und Bibliotheken installiert sind, können Sie mit dem Erstellen der LLM-Anwendung beginnen. Erstellen Sie eine Datei „requirement.txt“ im Stammverzeichnis Ihres Arbeitsverzeichnisses und speichern Sie die Abhängigkeiten.

streamlit

openai

langchainErstellen Sie eine app.py-Datei und fügen Sie den folgenden Code hinzu.

# Importing the required modules from the Streamlit and LangChain packages

import streamlit as st

from langchain.llms import OpenAI- Importiert die Streamlit-Bibliothek, die zum Erstellen interaktiver Webanwendungen verwendet wird.

- from langchain.llms import OpenAI importiert die OpenAI-Klasse aus dem Modul langchain.llms, das zur Interaktion mit den Sprachmodellen von OpenAI verwendet wird.

# Setting the title of the Streamlit utility

st.title('Easy LLM-App 🤖')- st.title(‚Easy LLM-App 🤖‘) legt den Titel der Streamlit-Web site fest.

# Making a sidebar enter widget for the OpenAI API key, enter kind is password for safety

openai_api_key = st.sidebar.text_input('OpenAI API Key', kind="password")- openai_api_key = st.sidebar.text_input(‚OpenAI API Key‘, kind=“password“) erstellt ein Texteingabe-Widget in der Seitenleiste, in das der Benutzer seinen OpenAI API-Schlüssel eingeben kann. Der Eingabetyp ist auf „Passwort“ eingestellt, um den eingegebenen Textual content aus Sicherheitsgründen auszublenden.

# Defining a operate to generate a response utilizing the OpenAI language mannequin

def generate_response(input_text):

# Initializing the OpenAI language mannequin with a specified temperature and API key

llm = OpenAI(temperature=0.7, openai_api_key=openai_api_key)

# Displaying the generated response as an informational message within the Streamlit app

st.information(llm(input_text))- def generate_response(input_text) definiert eine Funktion namens generate_response, die input_text als Argument verwendet.

- llm = OpenAI(temperature=0.7, openai_api_key=openai_api_key) initialisiert die OpenAI-Klasse mit einer Temperatureinstellung von 0,7 und dem bereitgestellten API-Schlüssel.

Temperatur ist ein Parameter, der verwendet wird, um die Zufälligkeit oder Kreativität des von einem Sprachmodell generierten Textes zu steuern. Er bestimmt, wie viel Variabilität das Modell in seine Vorhersagen einbringt.

- Niedrige Temperatur (0,0 – 0,5): Dadurch wird das Modell deterministischer und fokussierter.

- Mittlere Temperatur (0,5 – 1,0): Sorgt für ein Gleichgewicht zwischen Zufälligkeit und Determinismus.

- Hohe Temperatur (1,0 und höher): Erhöht die Zufälligkeit der Ausgabe. Höhere Werte machen das Modell kreativer und vielfältiger in seinen Antworten, dies kann jedoch auch zu weniger Kohärenz und mehr unsinnigen oder themenfremden Ausgaben führen.

- st.information(llm(input_text)) ruft das Sprachmodell mit dem bereitgestellten input_text auf und zeigt die generierte Antwort als Informationsmeldung in der Streamlit-App an.

# Making a kind within the Streamlit app for consumer enter

with st.kind('my_form'):

# Including a textual content space for consumer enter

textual content = st.text_area('Enter textual content:', '')

# Including a submit button for the shape

submitted = st.form_submit_button('Submit')

# Displaying a warning if the entered API key doesn't begin with 'sk-'

if not openai_api_key.startswith('sk-'):

st.warning('Please enter your OpenAI API key!', icon='⚠')

# If the shape is submitted and the API key's legitimate, generate a response

if submitted and openai_api_key.startswith('sk-'):

generate_response(textual content)- mit st.kind(‚my_form‘) wird ein Formularcontainer mit dem Namen my_form erstellt.

- textual content = st.text_area(‚Textual content eingeben:‘, “) fügt dem Formular ein Textbereich-Eingabe-Widget hinzu, in das der Benutzer Textual content eingeben kann.

- submitted = st.form_submit_button(‚Senden‘) fügt dem Formular eine Senden-Schaltfläche hinzu.

- wenn nicht, prüft openai_api_key.startswith(’sk-‚), ob der eingegebene API-Schlüssel nicht mit sk- beginnt.

- st.warning(‚Bitte geben Sie Ihren OpenAI API-Schlüssel ein!‘, icon=’⚠‘) zeigt eine Warnmeldung an, wenn der API-Schlüssel ungültig ist.

- Wenn übermittelt, prüft openai_api_key.startswith(’sk-‚), ob das Formular übermittelt wurde und der API-Schlüssel gültig ist.

- generate_response(textual content) ruft die generate_response-Funktion mit dem eingegebenen Textual content auf, um die Antwort zu generieren und anzuzeigen.

Zusammengefasst erhalten Sie Folgendes:

# Importing the required modules from the Streamlit and LangChain packages

import streamlit as st

from langchain.llms import OpenAI

# Setting the title of the Streamlit utility

st.title('Easy LLM-App 🤖')

# Making a sidebar enter widget for the OpenAI API key, enter kind is password for safety

openai_api_key = st.sidebar.text_input('OpenAI API Key', kind="password")

# Defining a operate to generate a response utilizing the OpenAI mannequin

def generate_response(input_text):

# Initializing the OpenAI mannequin with a specified temperature and API key

llm = OpenAI(temperature=0.7, openai_api_key=openai_api_key)

# Displaying the generated response as an informational message within the Streamlit app

st.information(llm(input_text))

# Making a kind within the Streamlit app for consumer enter

with st.kind('my_form'):

# Including a textual content space for consumer enter with a default immediate

textual content = st.text_area('Enter textual content:', '')

# Including a submit button for the shape

submitted = st.form_submit_button('Submit')

# Displaying a warning if the entered API key doesn't begin with 'sk-'

if not openai_api_key.startswith('sk-'):

st.warning('Please enter your OpenAI API key!', icon='⚠')

# If the shape is submitted and the API key's legitimate, generate a response

if submitted and openai_api_key.startswith('sk-'):

generate_response(textual content)Ausführen der Anwendung

Die Anwendung ist fertig; Sie müssen das Anwendungsskript mit dem entsprechenden Befehl für das von Ihnen verwendete Framework ausführen.

Indem Sie diesen Code mit streamlit run app.py ausführen, erstellen Sie eine interaktive Webanwendung, in der Benutzer Eingabeaufforderungen eingeben und LLM-generierte Textantworten erhalten können.

Wenn Sie streamlit run app.py ausführen, passiert Folgendes:

- Streamlit-Server startet: Streamlit startet einen lokalen Webserver auf Ihrem Pc, der standardmäßig normalerweise unter „http://localhost:8501“ erreichbar ist.

- Codeausführung: Streamlit liest und führt den Code in „app.py“ aus und rendert die App wie im Skript definiert.

- Weboberfläche: Ihr Webbrowser öffnet automatisch (oder Sie können manuell navigieren) zur von Streamlit bereitgestellten URL (normalerweise http://localhost:8501), wo Sie mit Ihrer LLM-App interagieren können.

Bereitstellen Ihrer LLM-Anwendung

Wenn Sie eine LLM-App bereitstellen, müssen Sie sie über das Web zugänglich machen, damit andere sie verwenden und testen können, ohne auf Ihren lokalen Pc zugreifen zu müssen. Dies ist wichtig für die Zusammenarbeit, das Benutzerfeedback und das Testen in der Praxis, um sicherzustellen, dass die App in unterschiedlichen Umgebungen intestine funktioniert.

Um die App in der Streamlit Cloud bereitzustellen, gehen Sie folgendermaßen vor:

- Erstellen Sie ein GitHub-Repository für Ihre App. Stellen Sie sicher, dass Ihr Repository zwei Dateien enthält: app.py und rAnforderungen.txt

- Gehe zu Streamlit Neighborhood Clouddrücke den „Neue App„-Schaltfläche in Ihrem Arbeitsbereich und geben Sie das Repository, den Zweig und den Hauptdateipfad an.

- Drücke den Einsetzen Schaltfläche, und Ihre LLM-Anwendung wird jetzt in der Streamlit Neighborhood Cloud bereitgestellt und kann weltweit aufgerufen werden.

Abschluss

Herzlichen Glückwunsch! Sie haben Ihre ersten Schritte beim Erstellen und Bereitstellen einer LLM-Anwendung mit Python unternommen. Nachdem Sie die Voraussetzungen verstanden, die erforderlichen Bibliotheken installiert und den Kernanwendungscode geschrieben haben, haben Sie nun einen funktionsfähigen persönlichen KI-Assistenten erstellt. Durch die Verwendung von Streamlit haben Sie Ihre App interaktiv und benutzerfreundlich gemacht und durch die Bereitstellung in der Streamlit Neighborhood Cloud Benutzern weltweit zugänglich gemacht.

Mit den Fähigkeiten, die Sie in diesem Handbuch gelernt haben, können Sie tiefer in LLMs und KI eintauchen, erweiterte Funktionen erkunden und noch anspruchsvollere Anwendungen erstellen. Experimentieren Sie weiter, lernen Sie und teilen Sie Ihr Wissen mit der Neighborhood. Die Möglichkeiten mit LLMs sind zahlreich und Ihre Reise hat gerade erst begonnen. Viel Spaß beim Programmieren!

Shittu Olumide ist ein Softwareentwickler und technischer Autor, der mit Leidenschaft modernste Technologien nutzt, um überzeugende Geschichten zu schreiben, mit einem scharfen Auge für Particulars und einem Händchen für die Vereinfachung komplexer Konzepte. Sie finden Shittu auch auf Þjórsárden.