In letzter Zeit habe ich mich auf Knowledge Storytelling und seine Bedeutung für die effektive Kommunikation der Ergebnisse der Datenanalyse zur Wertschöpfung konzentriert. Mein technischer Hintergrund, der der Welt des Datenmanagements und seinen Problemen sehr nahe kommt, brachte mich jedoch dazu, darüber nachzudenken, was Datenmanagement braucht, um sicherzustellen, dass Sie schnell datengesteuerte Geschichten erstellen können. Ich kam zu einer Schlussfolgerung, die oft als selbstverständlich angesehen wird, die man aber immer im Hinterkopf behalten sollte. Sie können sich nicht nur auf Daten verlassen, um datengesteuerte Geschichten zu erstellen. Ein Datenmanagementsystem muss auch mindestens zwei Aspekte berücksichtigen. Möchten Sie wissen, welche? Versuchen wir, es in diesem Artikel herauszufinden.

Was wir in diesem Artikel behandeln werden:

- Einführung in Daten

- Datenmanagementsysteme

- Daten-Storytelling

- Datenmanagement und Knowledge Storytelling

1. Daten einführen

Wir sprechen ständig über Daten, verwenden und generieren sie. Aber haben Sie sich schon einmal gefragt, was Daten sind und welche Arten von Daten es gibt? Versuchen wir, sie zu definieren.

Daten sind Rohdaten, Zahlen oder Symbole, die verarbeitet werden können, um aussagekräftige Informationen zu generieren. Es gibt verschiedene Arten von Daten:

- Strukturierte Daten sind Daten, die in einem festen Schema wie SQL oder CSV organisiert sind. Die Hauptvorteile dieser Artwork von Daten sind, dass sich daraus leicht Erkenntnisse ableiten lassen. Der Hauptnachteil besteht darin, dass die Schemaabhängigkeit die Skalierbarkeit einschränkt. Eine Datenbank ist ein Beispiel für diese Artwork von Daten.

- Halbstrukturierte Daten ist teilweise ohne festes Schema organisiert, wie etwa JSON XML. Der Vorteil liegt darin, dass sie flexibler sind als strukturierte Daten. Der Hauptnachteil besteht darin, dass die Metaebenenstruktur unstrukturierte Daten enthalten kann. Beispiele sind kommentierter Textual content, wie etwa Tweets mit Hashtags.

- Unstrukturierte Datenwie Audio, Video und Textual content, sind nicht kommentiert. Die Hauptvorteile sind, dass sie unstrukturiert sind und sich daher leicht speichern lassen. Außerdem sind sie sehr skalierbar. Allerdings sind sie schwierig zu verwalten. So ist es beispielsweise schwierig, Bedeutungen zu extrahieren. Reiner Textual content und digitale Fotos sind Beispiele für unstrukturierte Daten.

Um Daten zu organisieren, deren Volumen mit der Zeit zunimmt, ist eine ordnungsgemäße Verwaltung unerlässlich.

2. Datenmanagement

Unter Datenmanagement versteht man die Erfassung, Verarbeitung, Sicherung und Speicherung von Unternehmensdaten, die dann für strategische Entscheidungen zur Verbesserung der Geschäftsergebnisse genutzt werden (1). Es gibt drei zentrale Datenmanagementsysteme:

- Knowledge Warehouse

- Datensee

- Daten Lakehouse

2.1 Knowledge Warehouse

Ein Knowledge Warehouse kann nur strukturierte Daten nach Extraktions-, Transformations- und Ladeprozessen (ETL) verarbeiten. Nach der Aufbereitung können die Daten für Berichte, Dashboards oder Mining verwendet werden. Die folgende Abbildung fasst die Struktur eines Knowledge Warehouse zusammen.

Abb. 1: Die Architektur eines Knowledge Warehouse

Die Hauptprobleme mit Knowledge Warehouses sind:

- Skalierbarkeit – sie sind nicht skalierbar

- Unstrukturierte Daten – Sie verwalten keine unstrukturierten Daten

- Echtzeitdaten – sie verwalten keine Echtzeitdaten.

2.2 Datensee

Ein Knowledge Lake kann Rohdaten so aufnehmen, wie sie sind. Im Gegensatz zu einem Knowledge Warehouse verwaltet und bietet ein Knowledge Lake Möglichkeiten zum Konsumieren oder Verarbeiten strukturierter, halbstrukturierter und unstrukturierter Daten. Durch die Aufnahme von Rohdaten kann ein Knowledge Lake historische und Echtzeitdaten in einem Rohdatenspeichersystem aufnehmen.

Der Knowledge Lake fügt eine Metadaten- und Governance-Ebene hinzu, wie in der folgenden Abbildung dargestellt, um die Daten für die oberen Ebenen (Berichte, Dashboards und Knowledge Mining) nutzbar zu machen. Die folgende Abbildung zeigt die Architektur eines Knowledge Lake.

Abb. 2: Die Architektur eines Knowledge Lake

Der Hauptvorteil eines Knowledge Lake besteht darin, dass er jede Artwork von Daten schnell aufnehmen kann, da er keine Vorverarbeitung erfordert. Der Hauptnachteil eines Knowledge Lake besteht darin, dass er, da er Rohdaten aufnimmt, das Semantik- und Transaktionssystem des Knowledge Warehouse nicht unterstützt.

2.3 Daten-Lakehouse

Im Laufe der Zeit hat sich das Konzept eines Knowledge Lakes zum Knowledge Lakehouse entwickelt, einem erweiterten Knowledge Lake, der an seiner Spitze Unterstützung für Transaktionen bietet. In der Praxis ändert ein Knowledge Lakehouse die vorhandenen Daten im Knowledge Lake und befolgt dabei die Knowledge Warehouse-Semantik, wie in der folgenden Abbildung dargestellt.

Abb. 3: Die Architektur eines Knowledge Lakehouse

Das Knowledge Lakehouse nimmt die aus operativen Quellen extrahierten Daten auf, z. B. strukturierte, halbstrukturierte und unstrukturierte Daten. Es stellt sie Analyseanwendungen wie Berichterstellung, Dashboarding, Arbeitsbereichen und Anwendungen zur Verfügung. Ein Knowledge Lakehouse besteht aus den folgenden Hauptkomponenten:

- Knowledge Lake, der Tabellenformat, Dateiformat und Dateispeicher umfasst

- Knowledge Science- und Machine-Studying-Ebene

- Abfrage-Engine

- Metadatenverwaltungsebene

- Datenverwaltungsebene.

2.4 Verallgemeinerung der Datenmanagementsystemarchitektur

Die folgende Abbildung verallgemeinert die Architektur des Datenverwaltungssystems.

Abb. 4. Die allgemeine Architektur eines Datenmanagementsystems

Ein Datenmanagementsystem (Knowledge Warehouse, Knowledge Lake, Knowledge Lakehouse oder was auch immer) erhält Daten als Eingabe und generiert eine Ausgabe (Berichte, Dashboards, Arbeitsbereiche, Anwendungen usw.). Die Eingabe wird von Menschen generiert und die Ausgabe wird wiederum von Menschen genutzt. Wir können additionally sagen, dass wir Menschen in der Eingabe und Menschen in der Ausgabe haben. Ein Datenverwaltungssystem geht von Mensch zu Mensch.

Zu den Personen in der Eingabe zählen Personen, die die Daten generieren, z. B. Personen, die Sensoren tragen, Personen, die an Umfragen teilnehmen, Personen, die eine Rezension über etwas schreiben, Statistiken über Personen usw. Personen in der Ausgabe können zu einer der folgenden drei Kategorien gehören:

- Allgemeine Öffentlichkeitderen Ziel es ist, etwas zu lernen oder unterhalten zu werden

- Berufserfahrenedie technisch versiert sind und Daten verstehen wollen

- Führungskräfte die Entscheidungen treffen.

In diesem Artikel konzentrieren wir uns auf Führungskräfte, da sie Werte schaffen.

Aber was ist Wert? Der Cambridge Dictionary gibt verschiedene Definitionen von Wert (2).

- Der Geldbetrag das kann man für etwas bekommen

- Der Bedeutung oder Wert von etwas für jemanden

- Werte: Die Überzeugungen der Menschen, insbesondere darüber, was richtig und falsch ist und was im Leben am wichtigsten ist, bestimmen ihr Verhalten.

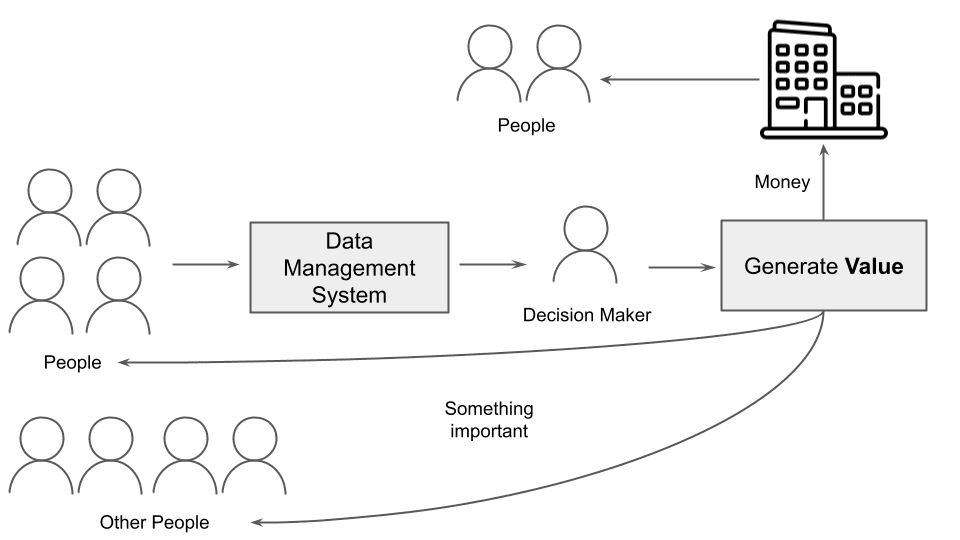

Wenn wir die Definition von Wert als Geldbetrag akzeptieren, könnte ein Entscheidungsträger Wert für das Unternehmen generieren, für das er arbeitet, und indirekt für die Menschen im Unternehmen und die Menschen, die die vom Unternehmen angebotenen Dienste oder Produkte nutzen. Wenn wir die Definition von Wert als die Wichtigkeit von etwas akzeptieren, ist der Wert für die Menschen, die Daten generieren, und andere externe Menschen von wesentlicher Bedeutung, wie in der folgenden Abbildung dargestellt.

Abb. 5: Der Prozess der Wertschöpfung

In diesem Szenario ist die ordnungsgemäße und effektive Übermittlung von Daten an Entscheidungsträger entscheidend für die Wertschöpfung. Aus diesem Grund sollte die gesamte Datenpipeline so konzipiert sein, dass Daten an das Endpublikum (Entscheidungsträger) übermittelt werden, um Wert zu generieren.

3. Daten-Storytelling

Es gibt drei Möglichkeiten, Daten zu kommunizieren:

- Datenberichterstattung enthält eine Datenbeschreibung mit allen Particulars der Datenerkundungs- und -analysephasen.

- Datenpräsentation wählt nur relevante Daten aus und präsentiert sie dem Endpublikum auf organisierte und strukturierte Weise.

- Daten-Storytelling baut eine Geschichte auf Daten auf.

Konzentrieren wir uns auf Knowledge Storytelling. Knowledge Storytelling ist die Vermittlung der Ergebnisse eines Datenanalyseprozesses an ein Publikum durch eine Geschichte. Basierend auf Ihrem Publikum wählen Sie eine geeignete

- Sprache und Ton: Die Wortgruppe (Sprache) und der durch sie vermittelte emotionale Ausdruck (Ton)

- Kontext: Der Detailgrad, den Sie Ihrer Geschichte hinzufügen möchten, basierend auf der kulturellen Sensibilität des Publikums

Beim Knowledge Storytelling müssen die Daten und alle relevanten Informationen, die mit den Daten verbunden sind (Kontext), berücksichtigt werden. Der Datenkontext bezieht sich auf die Hintergrundinformationen und relevanten Particulars, die einen Datensatz umgeben und beschreiben. In Datenpipelines wird dieser Datenkontext als Metadaten gespeichert (3). Metadaten sollte Antworten auf folgende Fragen geben:

- Wer hat die Daten erhoben?

- Worum es in den Daten geht

- Wann die Daten erhoben wurden

- Wo die Daten erhoben wurden

- Warum die Daten erhoben wurden

- Wie die Daten erhoben wurden

3.1 Die Bedeutung von Metadaten

Lassen Sie uns die Datenmanagement-Pipeline aus der Perspektive des Daten-Storytellings betrachten, die Daten und Metadaten (Kontext) umfasst.

Abb. 6: Die Datenmanagement-Pipeline aus der Perspektive des Knowledge Storytelling

Das Datenmanagementsystem besteht aus zwei Elementen: Datenmanagement, bei dem der Dateningenieur der Hauptakteur ist, und Datenanalyse, bei der der Datenwissenschaftler der Hauptakteur ist.

Der Dateningenieur sollte sich nicht nur auf die Daten, sondern auch auf die Metadaten konzentrieren, die dem Datenwissenschaftler dabei helfen, den Kontext um die Daten herum aufzubauen. Es gibt zwei Arten von Metadatenverwaltungssystemen:

- Passives Metadatenmanagement, das Metadaten in einem statischen Datenkatalog aggregiert und speichert (z. B. Apache Hive)

- Aktives Metadatenmanagement, das dynamische und Echtzeit-Metadaten bereitstellt (z. B. Apache Atlas)

Der Datenwissenschaftler sollte die datengesteuerte Story erstellen.

4. Datenmanagement und Knowledge Storytelling

Die Kombination von Datenmanagement und Knowledge Storytelling bedeutet:

- Bedenken Sie, wer letztlich von den Daten profitiert. Ein Datenmanagementsystem wird von Mensch zu Mensch weitergegeben.

- Berücksichtigen Sie Metadaten, die beim Verfassen aussagekräftiger Geschichten hilfreich sind.

Wenn wir die gesamte Datenpipeline aus der Perspektive des gewünschten Ergebnisses betrachten, erkennen wir, wie wichtig die Menschen hinter jedem Schritt sind. Wir können nur dann einen Mehrwert aus Daten generieren, wenn wir die Menschen hinter den Daten betrachten.

Zusammenfassung

Herzlichen Glückwunsch! Sie haben gerade gelernt, wie Sie Datenmanagement aus der Perspektive des Knowledge Storytelling betrachten. Neben den Daten sollten Sie zwei Aspekte berücksichtigen:

- Die Menschen hinter den Daten

- Metadaten, die Ihren Daten einen Kontext verleihen.

Und vergessen Sie vor allem nie die Menschen! Knowledge Storytelling hilft Ihnen, die Geschichten hinter den Daten zu sehen!

Verweise

(1) IBM. Was ist Datenmanagement?

(2) Das Cambridge Wörterbuch. Wert.

(3) Peter Crocker. Leitfaden zur Verbesserung des Datenkontexts: Wer, was, wann, wo, warum und wie

Externe Ressourcen

Mithilfe von Knowledge Storytelling Daten in Werte umwandeln (Vortrag)

Angelica Lo Duca (Mittel) (@alod83) ist Forscherin am Institut für Informatik und Telematik des Nationalen Forschungsrats (IIT-CNR) in Pisa, Italien. Sie ist Professorin für „Datenjournalismus“ im Masterstudiengang Digital Humanities an der Universität Pisa. Ihre Forschungsinteressen umfassen Datenwissenschaft, Datenanalyse, Textanalyse, offene Daten, Webanwendungen, Datentechnik und Datenjournalismus, angewandt auf Gesellschaft, Tourismus und kulturelles Erbe. Sie ist Autorin des Buches Comet for Knowledge Science, herausgegeben von Packt Ltd., des kommenden Buches Knowledge Storytelling in Python Altair and Generative AI, herausgegeben von Manning, und Co-Autorin des kommenden Buches Studying and Working Presto, herausgegeben von O’Reilly Media. Angelica ist außerdem eine begeisterte Technikautorin.