Kimi K2 (von Moonshot AI) und Lama 4 (von Meta) basieren auf dem neuesten Stand der Technik (LLMs) auf der Foundation von offenen Großsprachenmodellen (LLMs) Mischung aus Experten (MOE) Architektur. Jedes Modell ist auf verschiedene Bereiche spezialisiert und richtet sich an fortschrittliche Anwendungsfälle mit unterschiedlichen Stärken und Philosophien. Bis vor einer Woche battle Lama 4 der unbestrittene König der Open-Supply-LLMsAber jetzt sagen viele Leute, dass Kimis neuestes Modell das Beste für sein Geld gibt. In diesem Weblog werden wir diese beiden Modelle für verschiedene Aufgaben testen, um herauszufinden, welches von Kimi K2 gegen Llama 4 das beste Open-Supply-Modell ist. Lassen Sie die Schlacht der Besten beginnen!

Kimi K2 gegen Lama 4: Modellvergleich

Kimi K2 von Moonshot AI ist eine Open-Supply-Mischung aus Experten (MOE) mit 1 Billionen Gesamtparametern mit 32 B aktiven Parametern. Das Modell verfügt über ein 128K -Token -Kontextfenster. Das Modell ist mit dem Myon-Optimierer und Excels bei Aufgaben wie Codierung, Argumentation und Agentenaufgaben wie Device-Integration und mehrstufigen Argumentation ausgebildet.

Lama 4 von Meta AI ist eine Familie von multimodalen Modellen mit Mischung aus Experten, die in drei verschiedenen Varianten veröffentlicht wurden: Scout, Maverick und Gige. Scout verfügt über 17B aktive Parameter & 10 m Token -Fenster. Maverick mit 17 B aktiven Parametern und 1 M Token -Fenster, während das Behemoth (immer noch im Coaching) 288 B aktive Parameter mit insgesamt über 2 Billionen Token anbieten soll! Die Modelle sind mit einer starken Kontextbearbeitung, einer verbesserten Verwaltung sensibler Inhalte und einer geringeren Ablehnungsraten ausgestattet

| Besonderheit | Kimi K2 | Lama 4 Scout | Lama 4 Maverick |

|---|---|---|---|

| Modelltyp | MOE großes LLM, offenes Gewicht | MOE Multimodal, offenes Gewicht | MOE Multimodal, offenes Gewicht |

| Aktive Parameter | 32 b | 17 b | 17 b |

| Gesamtparameter | 1 t | 109 b | 400 b |

| Kontextfenster | 128 Okay Token | 10 Millionen Token | 1 Million Token |

| Schlüsselstärken | Codierung, Argumentation, Agentenaufgaben, geöffnet | Leichter, langer Kontext, effizient | Codierung, Argumentation, Leistung konkurrierende proprietäre Modelle |

| Zugänglichkeit | Laden Sie frei und verwenden Sie frei | Öffentlichkeit mit Lizenzbeschränkungen | Öffentlichkeit mit Lizenzbeschränkungen |

Um mehr über diese Modelle, ihre Benchmarks und Efficiency zu erfahren, lesen Sie unsere vorherigen Artikel:

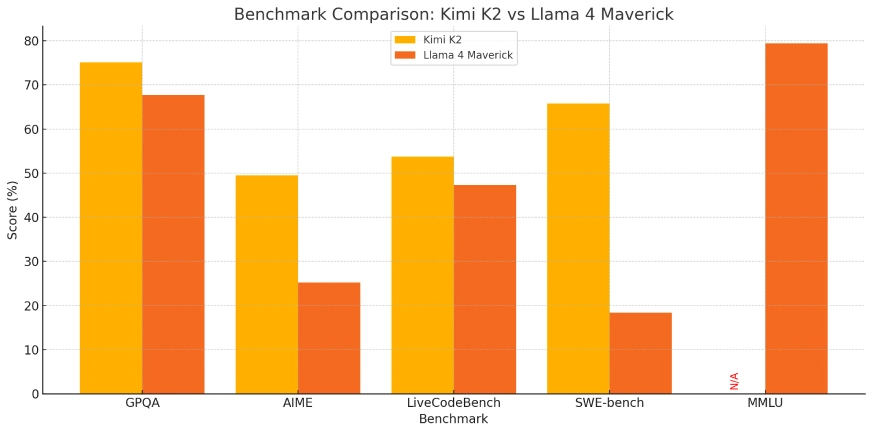

Kimi K2 gegen Lama 4: Benchmark -Vergleich

Kimi K2 und Llama 4 sind beide Tischtopper in ihrer Leistung auf verschiedenen Benchmarks. Hier ist eine kurze Aufschlüsselung ihrer Leistung:

| Benchmark | Was bedeutet das? | Kimi K2 | Lama 4 Maverick |

|---|---|---|---|

| Gpqa diamond | Dies soll LLM -Argumentation in der fortschrittlichen Physik testen | 75,1 % | 67,7 % |

| Aime | Dies soll die LLM auf mathematische Argumentation testen | 49,5 % | 25,2 % |

| LivecodeBench | Dies testet die realen Codierungsfähigkeiten eines Modells. | 53,7 % | 47,3 % |

| Swe -Bench | Dies testet die Fähigkeit eines Modells, produktionsbereitete Code zu schreiben | 65,8 % | 18,4 % |

| Ojbench | Es misst die Fähigkeit zur Problemlösung des Modells. | 27,1 % | – |

| MMLU -Professional | Ein akademischer Benchmark, der allgemeines Wissen und Verständnis testet | – | 79,4 % |

Kimi K2 und Lama 4: Wie kann man zugänglich machen?

Um diese Modelle für verschiedene Aufgaben zu testen, werden wir die Chat -Schnittstelle verwenden.

Wählen Sie das Modell aus dem Dropdown -Modell aus der oberen linken Seite des Bildschirms.

Kimi K2 gegen Lama 4: Leistungsvergleich

Nachdem wir verschiedene Modelle und Benchmark -Vergleiche zwischen Kimi K2 und Lama 4 gesehen haben, werden wir sie nun auf verschiedene Funktionen testen, wie:

- Multimodalität

- Agentenverhalten und Werkzeuggebrauch

- Mehrsprachige Fähigkeiten

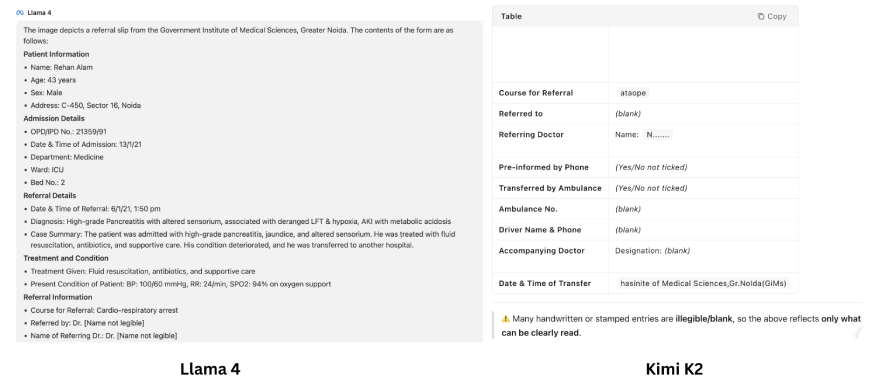

Aufgabe 1: Multimodalität

- Lama 4: Nativ multimodal (kann gemeinsam Bilder und Textual content verarbeiten), daher perfect für Dokumentanalysen, visuelle Erdung und datenreiche Szenarien.

- Kimi K2: Konzentrieren

Immediate: „Inhalt aus diesem Bild extrahieren“

Ausgabe:

Rezension:

Die von den beiden LLMs erzeugten Ausgänge sind stark unterschiedlich. Mit Lama 4 fühlt es sich so an, als würde es den gesamten Textual content des Bildes wie ein Profi durchlesen. Kimi K2 gibt jedoch an, dass die Handschrift unleserlich ist und nicht gelesen werden kann. Aber wenn Sie genau hinschauen, ist der von Lama bereitgestellte Textual content nicht der gleiche wie der Textual content, der im Bild da battle! Das Modell bildete Textual content an mehreren Stellen (Beispiel – Patientenname, sogar Diagnose), was das Spitzenniveau der LLM -Halluzination ist.

Auf dem Gesicht kann es sich so anfühlen, als würden wir eine detaillierte Bildanalyse erhalten, aber die Ausgabe von Lama 4 ist verpflichtet, Sie zu betrogen. Während Kimi K2 – von Anfang an – erwähnt, dass es nicht verstehen kann, was geschrieben ist, ist diese bittere Wahrheit viel besser als eine schöne Lüge.

Wenn es additionally um die Bildanalyse geht, kämpfen sowohl Kimi K2 als auch Lama 4 immer noch und können komplexe Bilder nicht richtig lesen.

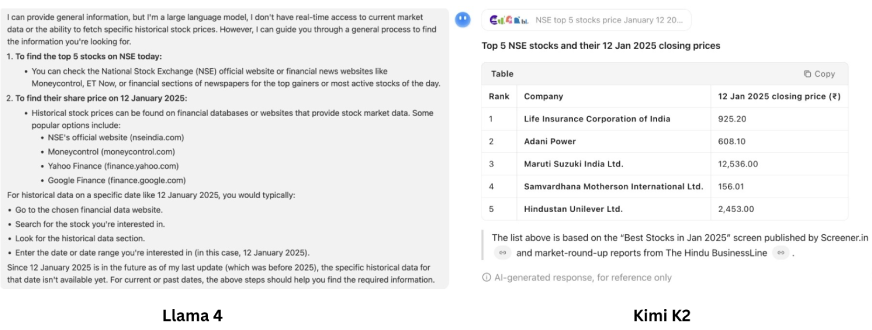

Aufgabe 2: Agentenverhalten und Werkzeuggebrauch

- Kimi K2: Speziell nach agenten-Workflows nachgebildet-kann Absichten ausführen, Shell-Befehle unabhängig ausführen, Apps/Web sites erstellen, APIs aufrufen, Datenwissenschaft automatisieren und mehrstufige Workflows außerhalb der Field durchführen.

- Lama 4: Obwohl es intestine in Logik, Sehvermögen und Analyse ist, ist sein agentisches Verhalten nicht so stark oder offen (meist multimodales Denken).

Immediate: „Finden Sie heute die Prime 5 Aktien von NSE und sagen Sie mir, wie am 12. Januar 2025 ihr Aktienkurs battle?”

Ausgabe:

Rezension:

Lama 4 ist für diese Aufgabe nicht bereit. Es fehlen die agierenden Funktionen, und daher kann es nicht auf das Net -Search -Device zugreifen, um auf die für die Eingabeaufforderung erforderlichen Erkenntnisse zuzugreifen. Jetzt, als er auf den ersten Blick zu Kimi K2 kommt, scheint es, dass Kimi K2 den Job gemacht hat! Hier ist jedoch eine genauere Überprüfung erforderlich. Es ist in der Lage, verschiedene Instruments basierend auf der Aufgabe zu verwenden, die Aufgabe jedoch nicht richtig verstanden hat. Es wurde erwartet, dass es heute nach den Prime -Aktienkünstlern suchen und ihre Preise für den 12. Januar 2025 angibt. Stattdessen gab es nur eine Liste der Prime -Performer vom 12. Januar 2025. Agentic – ja! Aber klug – nicht so sehr – Kimi K2 ist einfach in Ordnung.

Aufgabe 3: Mehrsprachige Fähigkeiten

- Lama 4: Ausgebildet auf Daten für 200 verschiedene Sprachen, einschließlich solider multisprachiger und bringlicher Fähigkeiten.

- Kimi K2: Globale Unterstützung, aber besonders stark in Chinesisch und Englisch (höchste Punktzahlen für chinesische Sprachbenchmarks).

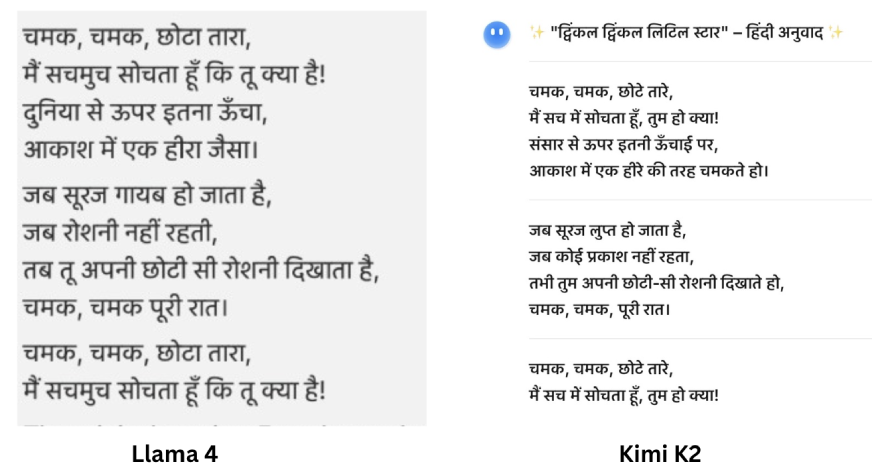

Immediate: „Übersetzen Sie den Inhalt des PDF in Hindi.PDF -Hyperlink“

Notiz: Um LLAMA 4 für diese Eingabeaufforderung zu testen, können Sie auch ein Bild des PDF aufnehmen und teilen, da die meisten kostenlosen LLM -Anbieter nicht zulassen, dass Dokumente in ihrem freien Plan hochgeladen werden.

Ausgabe:

Rezension:

Bei dieser Aufgabe wurden beide Modelle gleich intestine abgebildet. Sowohl Lama 4 als auch Kimi K2 übersetzen Französisch effizient in Hindi. Beide Modelle erkannten auch die Quelle des Gedichts. Die von beiden Modellen erzeugte Antwort battle gleich und korrekt. Wenn es additionally um mehrsprachige Unterstützung geht, ist Kimi K2 so intestine wie Lama 4.

Open-Supply-Natur und Kosten

Kimi K2: Vollständig offene Supply kann lokal eingesetzt werden, Gewichte und API stehen allen zur Verfügung. Die Kosten für Inferenz und API sind erheblich niedriger (0,15 bis 0,60 $/1m Enter-Token, 2,50 USD/1-Mio.-Ausgangs-Token).

Lama 4: Nur im Rahmen einer Group-Lizenz verfügbar (Beschränkungen können nach Area auftreten), etwas höhere Infrastrukturanforderungen aufgrund der Kontextgröße, und für selbst gehostete Produktionsnutzungsfälle manchmal weniger flexibel.

Abschlussfazit:

| Aufgabe | Kimi K2 | Lama 4 |

|---|---|---|

| Multimodalität | ✅ | ❌ |

| Agentenverhalten und Werkzeuggebrauch | ✅ | ❌ |

| Mehrsprachige Fähigkeiten | ❌ | ✅ |

- Verwenden Sie Kimi K2: Wenn Sie eine Excessive-Finish-Codierung, Argumentation und Agentenautomatisierung wünschen, insbesondere wenn Sie die vollständige Verfügbarkeit von Open-Supply, extrem niedrige Kosten und lokale Bereitstellung bewerten. Kimi K2 steht derzeit bei wichtigen Maßnahmen voran, wenn Sie ein Entwickler sind, der Excessive-Finish-Instruments, Workflows oder LLMs mit einem Finances einsetzt.

- Verwenden Sie Lama 4: Wenn Sie ein extrem großes Kontextgedächtnis, ein großes Verständnis der Sprache und die Verfügbarkeit von Open Supply benötigen. Es unterscheidet sich in visuellen Analysen, Dokumentenverarbeitung und Cross-Modal Analysis/Enterprise-Aufgaben.

Abschluss

Zu sagen, Kimi K2 ist besser als Lama 4 könnte nur eine Überbeamte sein. Beide Modelle haben ihre Vor- und Nachteile. Lama 4 ist sehr schnell, während Kimi K2 ziemlich umfassend ist. Lama 4 ist anfälliger, sich die Dinge zu erfinden, während Kimi K2 sich vor dem Versuch scheuen könnte. Beide sind großartige Open-Supply-Modelle und bieten Benutzern eine Reihe von Funktionen, die mit denen von Closed-Supply-Modellen wie GPT 4O, Gemini 2.0 Flash und mehr vergleichbar sind. Eine von den beiden auszuwählen ist etwas schwierig, aber Sie können den Anruf basierend auf Ihrer Aufgabe entgegennehmen.

Oder probieren Sie sie beide und sehen Sie, welche Sie besser mögen?

Melden Sie sich an, um weiter zu lesen und Experten-Kuratinhalte zu genießen.