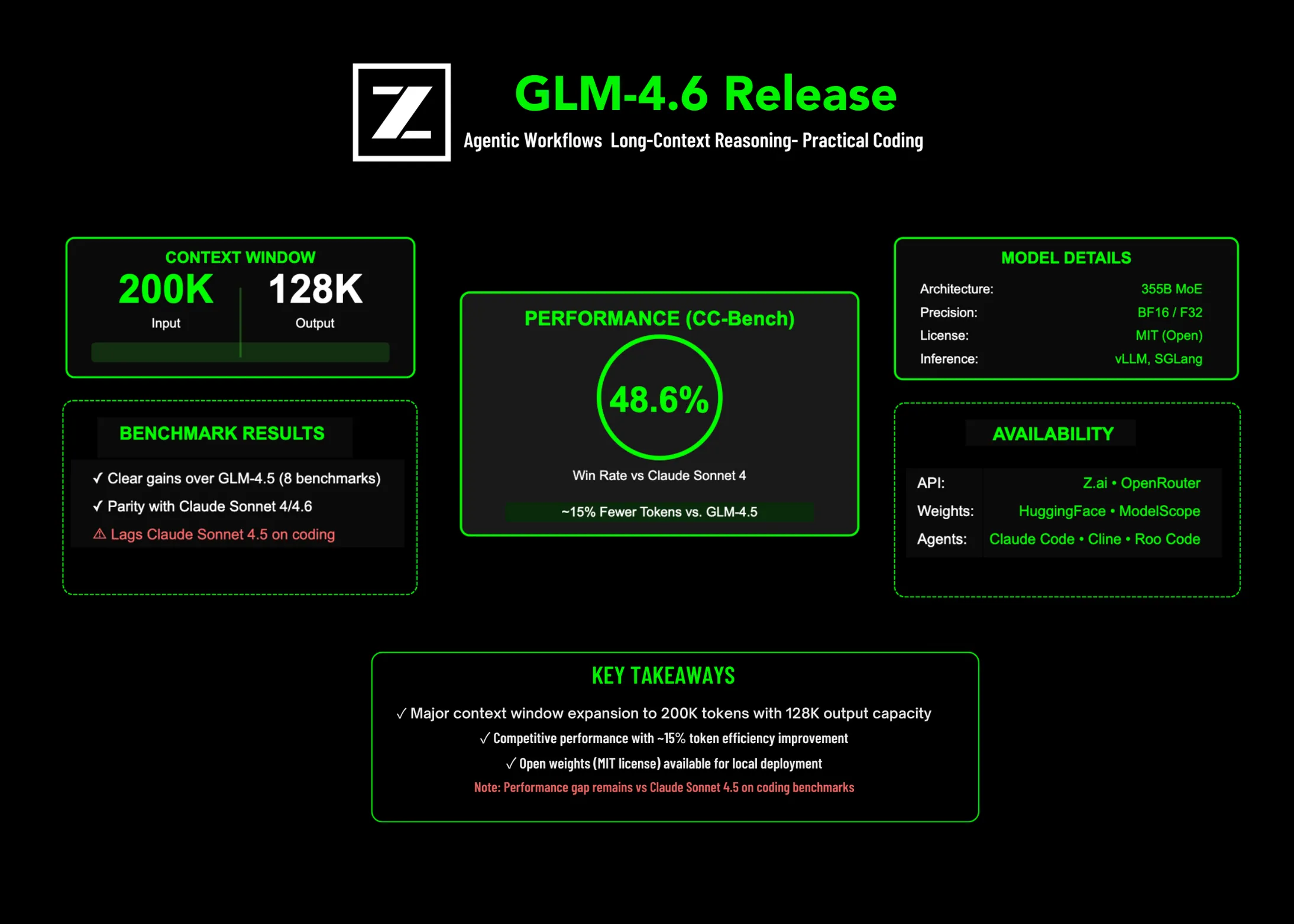

Zhipu AI hat GLM-4,6 veröffentlicht, ein großes Replace für ihre GLM-Serie, die sich auf agierische Workflows, langkontextbezogene Argumentation und praktische Codierungsaufgaben konzentriert. Das Modell erhöht das Eingangsfenster auf 200k Token mit a 128K Max -Ausgangzielt auf einen niedrigeren Tokenverbrauch bei angewandten Aufgaben ab und schiffen mit Offene Gewichte Für lokale Bereitstellung.

Additionally, was genau ist neu?

- Kontext + Ausgangsbegrenzungen: 200k Eingabekontext und 128K Maximale Ausgangs -Token.

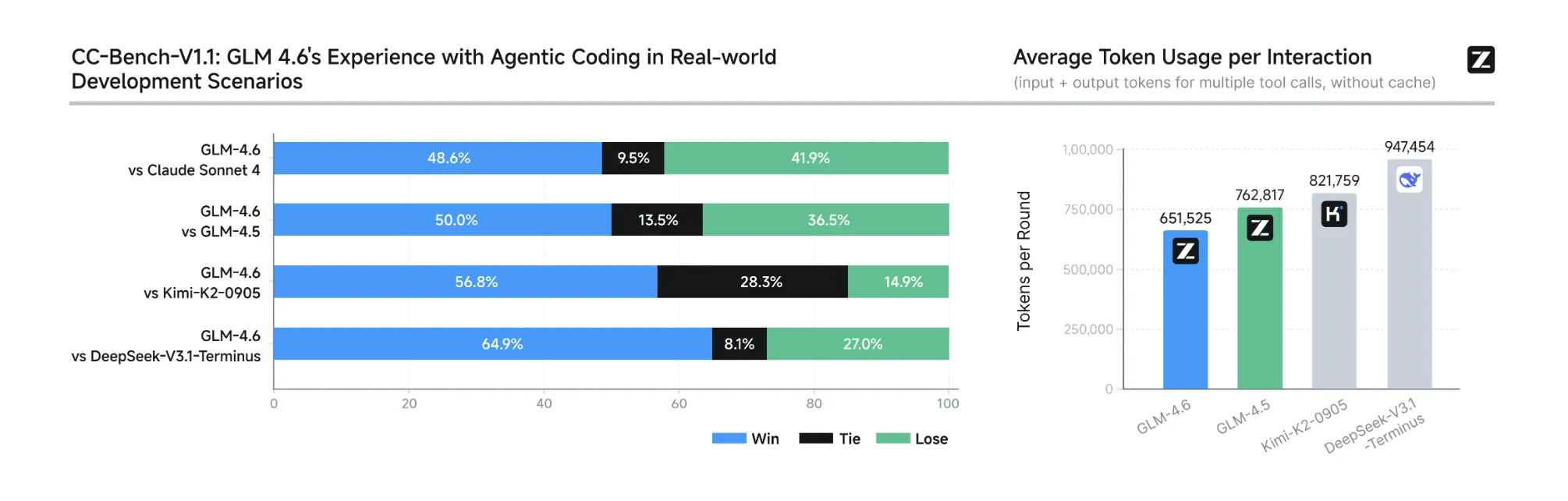

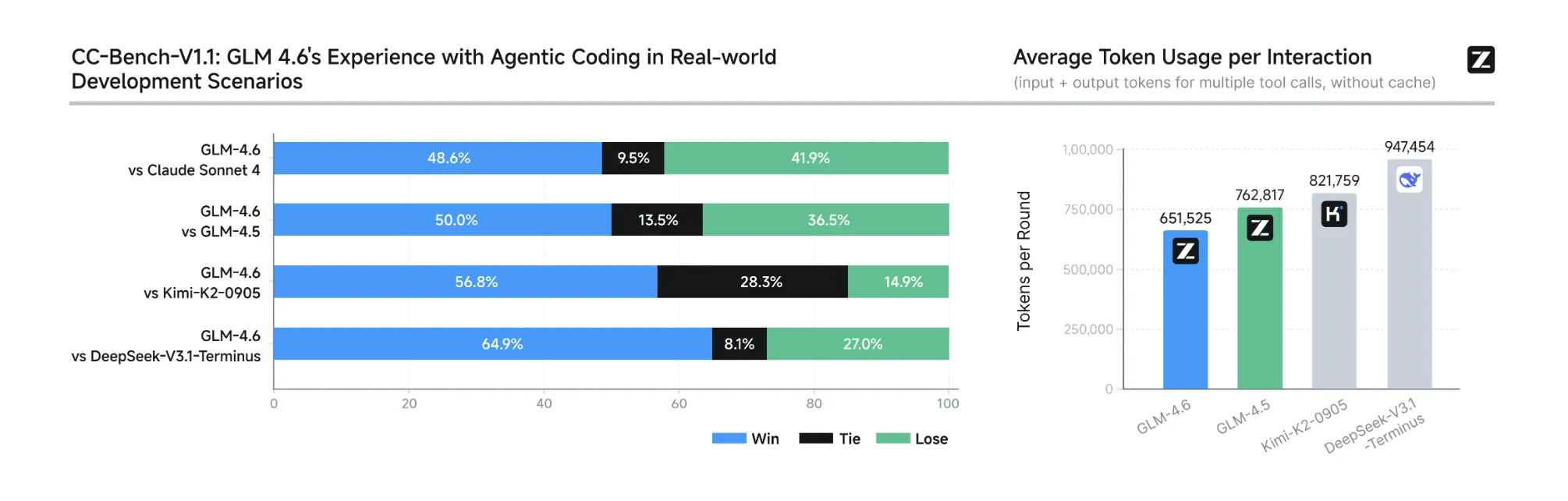

- Codierungsergebnisse der realen Welt: Auf dem erweiterten CC-Financial institution (Multi-Flip-Aufgaben, die von menschlichen Evaluatoren in isolierten Docker-Umgebungen ausgeführt werden, wird berichtet Nahe Parität mit Claude Sonnet 4 (48,6% Gewinnrate) und verwendet ~ 15% weniger Token gegen GLM-4,5 Aufgaben beenden. Aufgabenaufforderungen und Agentenbahnen werden zur Inspektion veröffentlicht.

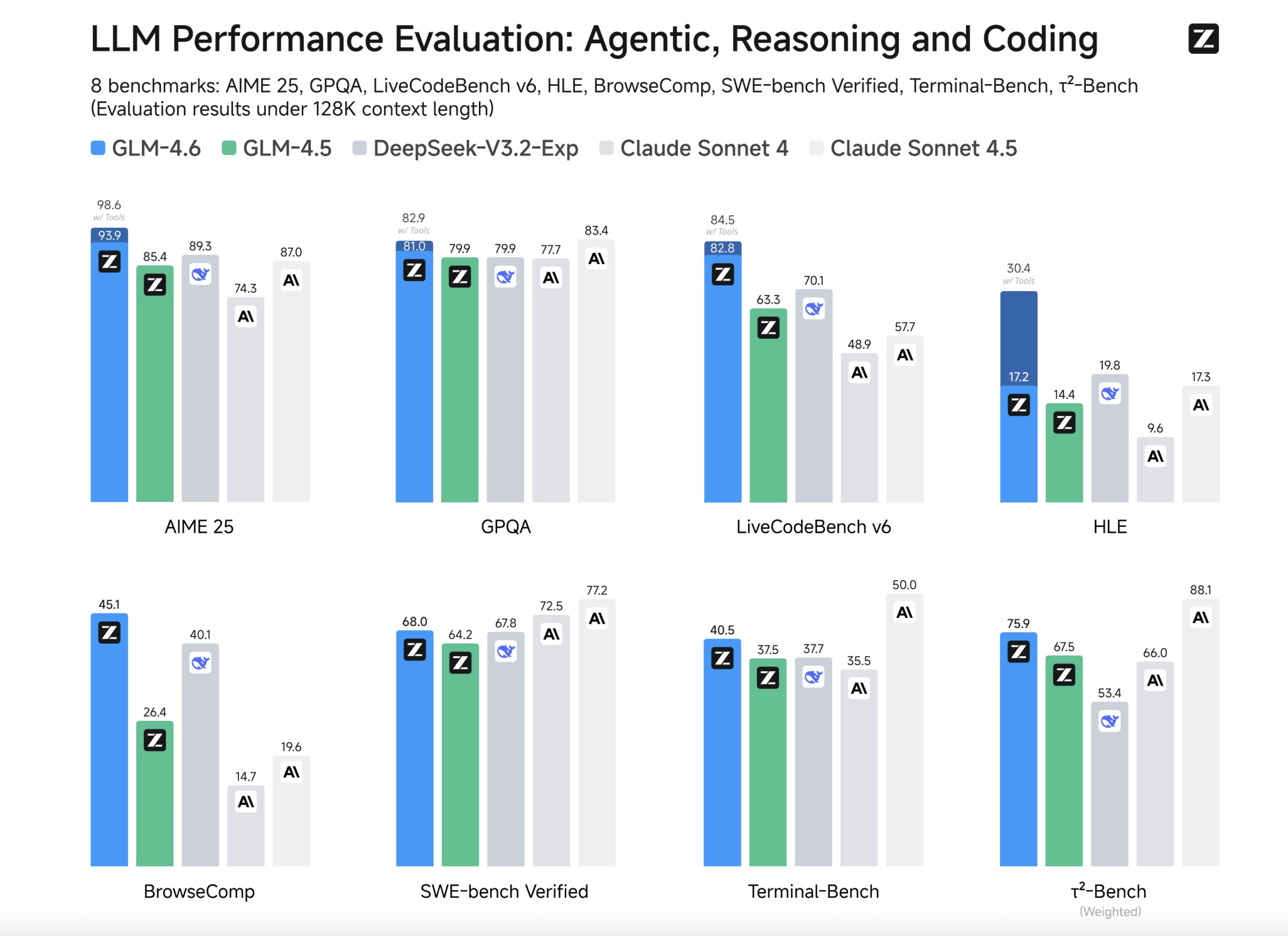

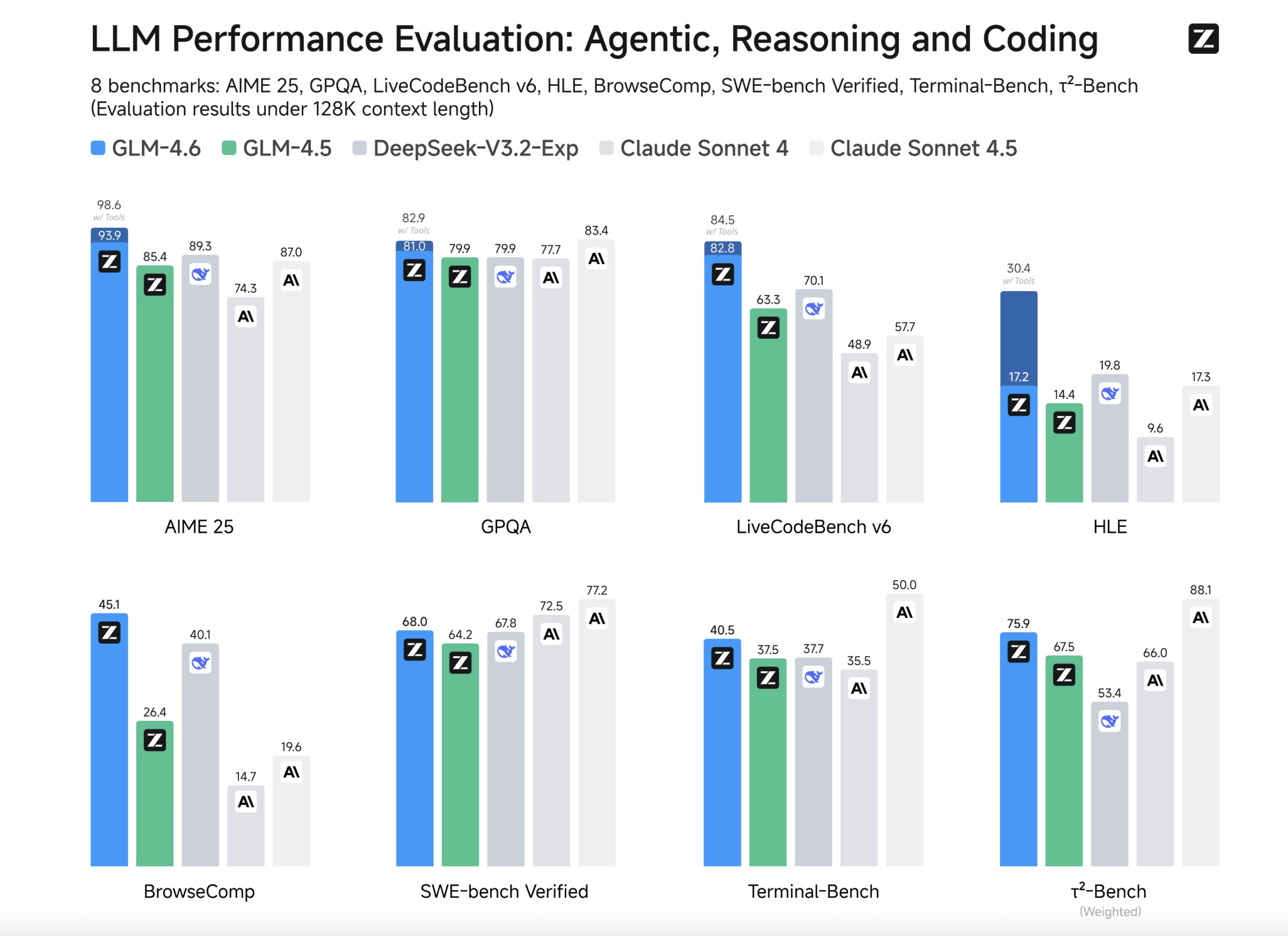

- Benchmark -Positionierung: Zhipu fasst „klare Gewinne“ über GLM-4,5 in acht öffentlichen Benchmarks und Staaten Parität mit Claude Sonnet 4/40 auf mehreren zusammen; Es stellt auch fest GLM-4.6 bleibt immer noch Sonett 4.5 beim Codieren zurück– Eine nützliche Einschränkung für die Modellauswahl.

- Verfügbarkeit von Ökosystemen: GLM-4.6 ist über verfügbar Z.ai API Und OpenRouter; Es wird in beliebte Codierungsagenten (Claude Code, Cline, Roo -Code, Kilo -Code) und vorhandene Codierungsplan -Benutzer integriert, indem sie den Modellnamen auf umschalten

glm-4.6. - Offene Gewichte + Lizenz: Umarmende Gesichtsmodellkartenlisten Lizenz: MIT Und Modellgröße: 355b Params (MOE) mit BF16/F32 -Tensoren. (MOE „Gesamtparameter“ entsprechen den aktiven Parametern professional Token nicht. Für 4,6 auf der Karte wird keine aktive Params angegeben.)

- Lokale Inferenz: vllm Und Sglang werden für die lokale Portion unterstützt; Gewichte sind eingeschaltet Umarmtes Gesicht Und ModelsCope.

Zusammenfassung

GLM-4,6 ist ein inkrementeller, aber materieller Schritt: ein 200k-Kontextfenster, ~ 15% Token-Reduktion auf CC-Bench gegen GLM-4,5, Nahparkitätsaufgabe Win-Fee mit Claude-Sonett 4 und sofortige Verfügbarkeit über Z.AI, OpenRouter und offene Artifakte für lokale Servierungen.

FAQs

1) Was sind die Kontext- und Ausgangs -Token -Grenzen?

GLM-4.6 unterstützt a 200k Eingabekontext und 128K Maximale Ausgangs -Token.

2) Sind offene Gewichte verfügbar und unter welcher Lizenz?

Ja. Die Umarmungsgesichts -Modellkartenlisten Offene Gewichte mit Lizenz: MIT und a 357B-Parameter Moe Konfiguration (BF16/F32 -Tensoren).

3) Wie ist GLM-4,6 mit GLM-4,5 und Claude Sonnet 4 bei angewendeten Aufgaben verglichen?

Auf dem erweiterten CC-Financial institutionGLM-4.6 Berichte ~ 15% weniger Token gegen GLM-4,5 Und Nahe Eltern mit Claude Sonnet 4 (48,6% Win-Fee).

4) Kann ich GLM-4,6 lokal ausführen?

Ja. Zhipu liefert Gewichte auf Umarmung von Gesicht/Fashions und dokumentiert die lokale Schlussfolgerung mit vllm Und Sglang; Neighborhood-Quantisierungen werden für {Hardware} für Workstation-Klasse erscheinen.

Schauen Sie sich das an Github -SeiteAnwesend Umarmung der Gesichtsmodellkarte Und Technische Particulars. Fühlen Sie sich frei, unsere zu überprüfen Github -Seite für Tutorials, Codes und Notizbücher. Fühlen Sie sich auch frei, uns zu folgen Twitter Und vergessen Sie nicht, sich unserer anzuschließen 100k+ ml Subreddit und abonnieren Unser Publication.

Asif Razzaq ist der CEO von Marktechpost Media Inc. Sein jüngstes Bestreben ist die Einführung einer Medienplattform für künstliche Intelligenz, Marktechpost, die sich durch die ausführliche Berichterstattung über maschinelles Lernen und Deep-Studying-Nachrichten auszeichnet, die von einem breiten Publikum technisch intestine und leicht verständlich sind. Die Plattform verfügt über über 2 Millionen monatliche Ansichten und veranschaulicht ihre Beliebtheit des Publikums.