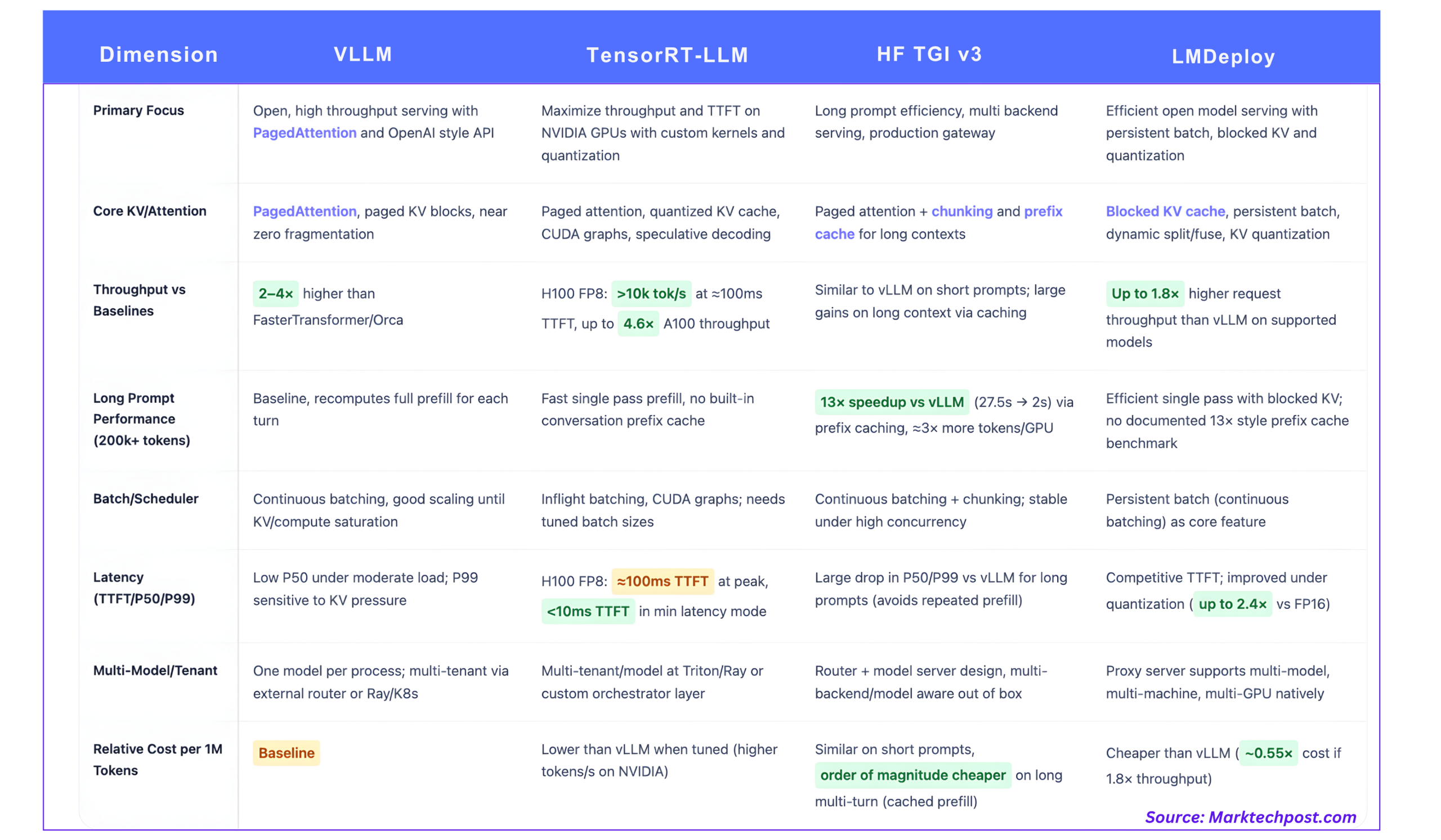

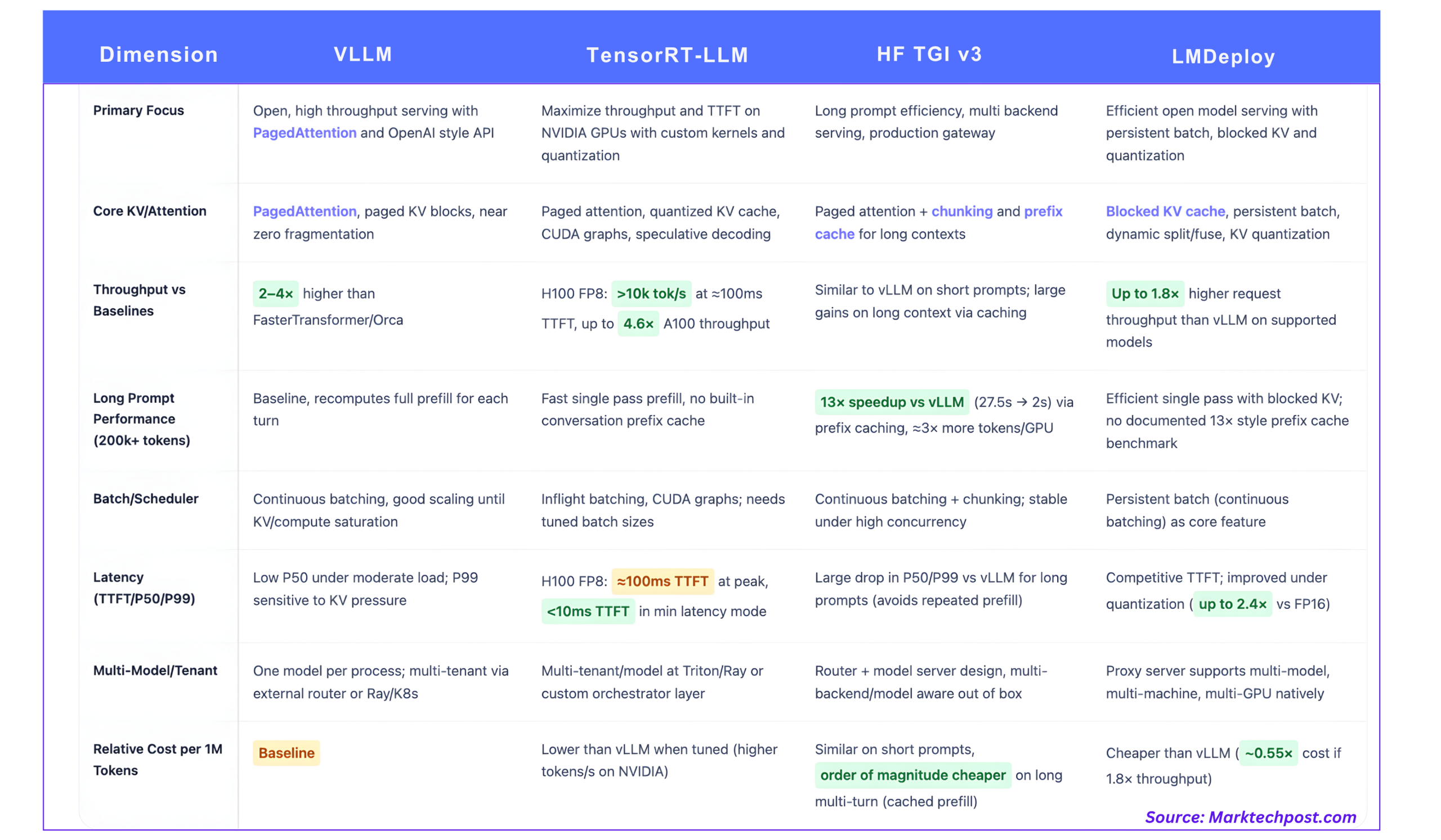

Produktions-LLM-Bereitstellung ist jetzt ein Systemproblem, kein Downside mehr generate() Schleife. Bei realen Workloads ist die Wahl des Inferenzstapels entscheidend Token professional Sekunde, Schwanzlatenzund letztendlich Kosten professional Million Token auf einer bestimmten GPU-Flotte.

Dieser Vergleich konzentriert sich auf 4 weit verbreitete Stacks:

- vLLM

- NVIDIA TensorRT-LLM

- Inferenz zur Generierung von Umarmungsgesichtstexten (TGI v3)

- LMDeploy

1. vLLM, PagedAttention als offene Baseline

Kernidee

vLLM ist darauf aufgebaut PagedAchtungeine Aufmerksamkeitsimplementierung, die den KV-Cache wie ausgelagerten virtuellen Speicher und nicht wie einen einzelnen zusammenhängenden Puffer professional Sequenz behandelt.

Anstatt professional Anfrage eine große KV-Area zuzuweisen, vLLM:

- Unterteilt den KV-Cache in Blöcke fester Größe

- Verwaltet eine Blocktabelle, die logische Token physischen Blöcken zuordnet

- Teilt Blöcke zwischen Sequenzen, wo immer sich Präfixe überschneiden

Dadurch wird die externe Fragmentierung reduziert und der Scheduler kann viel mehr gleichzeitige Sequenzen in denselben VRAM packen.

Durchsatz und Latenz

vLLM verbessert den Durchsatz um 2–4× gegenüber Systemen wie FasterTransformer und Orca bei ähnlicher Latenz, mit größeren Gewinnen für längere Sequenzen.

Wichtige Eigenschaften für Betreiber:

- Kontinuierliche Dosierung (auch Inflight-Batching genannt) führt eingehende Anfragen in bestehende GPU-Batches zusammen, anstatt auf feste Batch-Fenster zu warten.

- Bei typischen Chat-Workloads skaliert der Durchsatz nahezu linear mit der Parallelität, bis der KV-Speicher oder die Rechenleistung ausgelastet ist.

- Die P50-Latenz bleibt bei mäßiger Parallelität niedrig, aber P99 kann sich verschlechtern, wenn die Warteschlangen lang sind oder der KV-Speicher knapp ist, insbesondere bei Abfragen mit hohem Prefill-Gehalt.

vLLM macht eine verfügbar OpenAI-kompatible HTTP-API und lässt sich intestine mit Ray Serve und anderen Orchestratoren integrieren, weshalb es häufig als offene Basislinie verwendet wird.

KV und Multi-Tenant

- PagedAttention gibt Nahezu null KV-Abfall und versatile Präfixfreigabe innerhalb und zwischen Anfragen.

- Jeder vLLM-Prozess dient ein ModellMulti-Tenant- und Multi-Modell-Setups werden normalerweise mit einem externen Router oder API-Gateway erstellt, der auf mehrere vLLM-Instanzen verteilt.

2. TensorRT-LLM, {Hardware}-Most auf NVIDIA-GPUs

Kernidee

TensorRT-LLM ist NVIDIAs optimierte Inferenzbibliothek für ihre GPUs. Die Bibliothek bietet benutzerdefinierte Aufmerksamkeitskerne, Inflight-Batching, ausgelagertes KV-Caching, Quantisierung bis hinunter zu FP4 und INT4 sowie spekulative Dekodierung.

Es ist eng mit NVIDIA-{Hardware} gekoppelt, einschließlich FP8-Tensorkernen auf Hopper und Blackwell.

Gemessene Leistung

Die H100 vs. A100-Bewertung von NVIDIA ist die konkretste öffentliche Referenz:

- Auf H100 mit FP8 erreicht TensorRT-LLM über 10.000 ausgegebene Token/s bei Spitzendurchsatz für 64 gleichzeitige Anfragenmit ~100 ms Zeit bis zum ersten Token.

- H100 FP8 erreicht bis zu 4,6-fach höherer maximaler Durchsatz Und 4,4-mal schnellere Latenz des ersten Tokens als A100 bei den gleichen Modellen.

Für latenzempfindliche Modi:

- TensorRT-LLM auf H100 kann TTFT steuern unter 10 ms in Batch-1-Konfigurationen, auf Kosten eines geringeren Gesamtdurchsatzes.

Diese Zahlen sind modell- und formspezifisch, geben aber einen realistischen Maßstab wieder.

Vorfüllen vs. Dekodieren

TensorRT-LLM optimiert beide Phasen:

- Prefill profitiert von FP8-Aufmerksamkeitskernen mit hohem Durchsatz und Tensorparallelität

- Dekodieren profitiert von CUDA-Graphen, spekulativer Dekodierung, quantisierten Gewichten und KV sowie der Kernel-Fusion

Das Ergebnis sind sehr hohe Tokens/s über einen weiten Bereich von Eingabe- und Ausgabelängen, insbesondere wenn die Engine auf dieses Modell und Batch-Profil abgestimmt ist.

KV und Multi-Tenant

TensorRT-LLM bietet:

- Ausgelagerter KV-Cache mit konfigurierbarem Structure

- Unterstützung für lange Sequenzen, KV-Wiederverwendung und Offloading

- Batch- und prioritätsbewusste Planungsprimitive während des Flugs

NVIDIA kombiniert dies mit Ray-basierten oder Triton-basierten Orchestrierungsmustern für Multi-Tenant-Cluster. Die Unterstützung mehrerer Modelle erfolgt auf Orchestratorebene und nicht innerhalb einer einzelnen TensorRT-LLM-Engine-Instanz.

3. Hugging Face TGI v3, Lengthy-Immediate-Spezialist und Multi-Backend-Gateway

Kernidee

Textgenerierungsinferenz (TGI) ist ein auf Rust und Python basierender Serving-Stack, der Folgendes hinzufügt:

- HTTP- und gRPC-APIs

- Kontinuierlicher Batch-Planer

- Observability- und Autoscaling-Hooks

- Plug-in-Backends, einschließlich Engines im vLLM-Stil, TensorRT-LLM und anderen Laufzeiten

Model 3 konzentriert sich auf die lange Verarbeitung von Eingabeaufforderungen Chunking und Präfix-Caching.

Langer Immediate-Benchmark vs. vLLM

Der TGI v3-Dokumente Geben Sie einen klaren Maßstab:

- Bei langen Eingabeaufforderungen mit mehr als 200.000 Tokeneine Konversationsantwort, die dauert 27,5 s im vLLM kann in ca. serviert werden 2 s in TGI v3.

- Dies wird als a gemeldet 13-fache Beschleunigung auf diese Arbeitsbelastung.

- TGI v3 kann ca. verarbeiten 3× mehr Token im gleichen GPU-Speicher durch Reduzierung des Speicherbedarfs und Nutzung von Chunking und Caching.

Der Mechanismus ist:

- TGI behält den ursprünglichen Konversationskontext bei Präfix-Cachesodass nachfolgende Runden nur für zusätzliche Spielsteine auszahlen

- Der Aufwand für die Cache-Suche liegt in der Größenordnung von Mikrosekundenvernachlässigbar im Vergleich zur Vorfüllberechnung

Hierbei handelt es sich um eine gezielte Optimierung für Workloads, bei denen Eingabeaufforderungen extrem lang sind und über mehrere Runden hinweg wiederverwendet werden, beispielsweise RAG-Pipelines und analytische Zusammenfassungen.

Architektur und Latenzverhalten

Schlüsselkomponenten:

- ChunkingSehr lange Eingabeaufforderungen werden für KV und Planung in überschaubare Segmente aufgeteilt

- Präfix-CachingDatenstruktur, um langen Kontext über Runden hinweg zu teilen

- Kontinuierliche Dosierungeingehende Anfragen verbinden Stapel bereits laufender Sequenzen

- PagedAttention und verschmolzene Kernel in den GPU-Backends

Bei kurzen Workloads im Chat-Stil liegen Durchsatz und Latenz auf dem gleichen Niveau wie bei vLLM. Bei langen, zwischenspeicherbaren Kontexten verbessert sich sowohl die P50- als auch die P99-Latenz um eine Größenordnung, da die Engine wiederholtes Vorfüllen vermeidet.

Multi-Backend und Multi-Modell

TGI ist als konzipiert Router plus Modellserver Architektur. Es kann:

- Leiten Sie Anfragen über viele Modelle und Replikate hinweg weiter

- Zielen Sie auf verschiedene Backends ab, zum Beispiel TensorRT-LLM auf H100 plus CPU oder kleinere GPUs für Datenverkehr mit niedriger Priorität

Dadurch eignet es sich als zentrale Bereitstellungsschicht in Umgebungen mit mehreren Mandanten.

4. LMDeploy, TurboMind mit blockiertem KV und aggressiver Quantisierung

Kernidee

LMDeploy aus dem InternLM-Ökosystem ist ein Toolkit zum Komprimieren und Bereitstellen von LLMs, das sich auf das konzentriert TurboMind Motor. Es konzentriert sich auf:

- Anforderungsbereitstellung mit hohem Durchsatz

- Blockierter KV-Cache

- Persistentes Batching (kontinuierliches Batching)

- Quantisierung von Gewichten und KV-Cache

Relativer Durchsatz im Vergleich zu vLLM

Im Projekt heißt es:

- „LMDeploy bietet einen bis zu 1,8-mal höheren Anforderungsdurchsatz als vLLM.“‚, mit der Unterstützung von persistentem Batch, blockiertem KV, dynamischer Aufteilung und Sicherung, Tensorparallelität und optimierten CUDA-Kerneln.

KV, Quantisierung und Latenz

LMDeploy umfasst:

- Blockierter KV-Cacheähnlich wie bei ausgelagertem KV, das dabei hilft, viele Sequenzen in VRAM zu packen

- Unterstützung für KV-Cache-Quantisierungnormalerweise int8 oder int4, um KV-Speicher und Bandbreite zu reduzieren

- Gewichtet nur Quantisierungspfade wie 4-Bit-AWQ

- Ein Benchmarking-System, das Token-Durchsatz, Anforderungsdurchsatz und erste Token-Latenz meldet

Dies macht LMDeploy attraktiv, wenn Sie größere offene Modelle wie InternLM oder Qwen auf Mittelklasse-GPUs mit aggressiver Komprimierung ausführen und gleichzeitig gute Token/s beibehalten möchten.

Bereitstellung mehrerer Modelle

LMDeploy bietet eine Proxyserver kann damit umgehen:

- Bereitstellung mehrerer Modelle

- Multi-Maschinen- und Multi-GPU-Setups

- Routing-Logik zur Auswahl von Modellen basierend auf Anforderungsmetadaten

Architektonisch ähnelt es additionally eher dem TGI als einem Einzelmotor.

Was wann verwenden??

- Wenn Sie maximalen Durchsatz und sehr niedrige TTFT auf NVIDIA-GPUs wünschen

- TensorRT-LLM ist die erste Wahl

- Es verwendet FP8 und niedrigere Präzision, benutzerdefinierte Kernel und spekulative Dekodierung, um Token/s zu pushen und die TTFT bei hoher Parallelität unter 100 ms und bei niedriger Parallelität unter 10 ms zu halten

- Wenn Sie von langen Eingabeaufforderungen mit Wiederverwendung dominiert werden, z. B. RAG über große Kontexte

- TGI v3 ist ein starker Normal

- Sein Präfix-Cache und Chunking geben nach 3× Token-Kapazität Und 13-fach geringere Latenz als vLLM in veröffentlichten Lengthy-Immediate-Benchmarks, ohne zusätzliche Konfiguration

- Wenn Sie eine offene, einfache Engine mit starker Grundleistung und einer API im OpenAI-Stil wünschen

- vLLM bleibt die Standardbasislinie

- PagedAttention und kontinuierliches Batching machen es möglich 2–4× schneller als ältere Stacks mit ähnlicher Latenz und lässt sich problemlos in Ray und K8s integrieren

- Wenn Sie auf offene Modelle wie InternLM oder Qwen abzielen und Wert auf aggressive Quantisierung mit Multi-Modell-Bereitstellung legen

- LMDeploy passt intestine

- Blockierter KV-Cache, persistentes Batching und int8- oder int4-KV-Quantisierung geben bis zu 1,8-mal höherer Anforderungsdurchsatz als vLLM bei unterstützten Modellen, inklusive Router-Schicht

In der Praxis mischen viele Entwicklerteams diese Systeme und verwenden beispielsweise TensorRT-LLM für proprietäre Chats mit hohem Volumen, TGI v3 für Analysen mit langen Kontexten, vLLM oder LMDeploy für experimentelle und offene Modell-Workloads. Der Schlüssel besteht darin, den Durchsatz, die Latenzausfälle und das KV-Verhalten an die tatsächlichen Token-Verteilungen in Ihrem Datenverkehr anzupassen und dann die Kosten professional Million Token aus den gemessenen Token/s auf Ihrer eigenen {Hardware} zu berechnen.

Referenzen

- vLLM / PagedAttention

- TensorRT-LLM-Leistung und Übersicht

- HF Textual content Era Inference (TGI v3) Verhalten bei langer Eingabeaufforderung

- LMDeploy / TurboMind

Michal Sutter ist ein Knowledge-Science-Experte mit einem Grasp of Science in Knowledge Science von der Universität Padua. Mit einer soliden Grundlage in statistischer Analyse, maschinellem Lernen und Datentechnik ist Michal hervorragend darin, komplexe Datensätze in umsetzbare Erkenntnisse umzuwandeln.