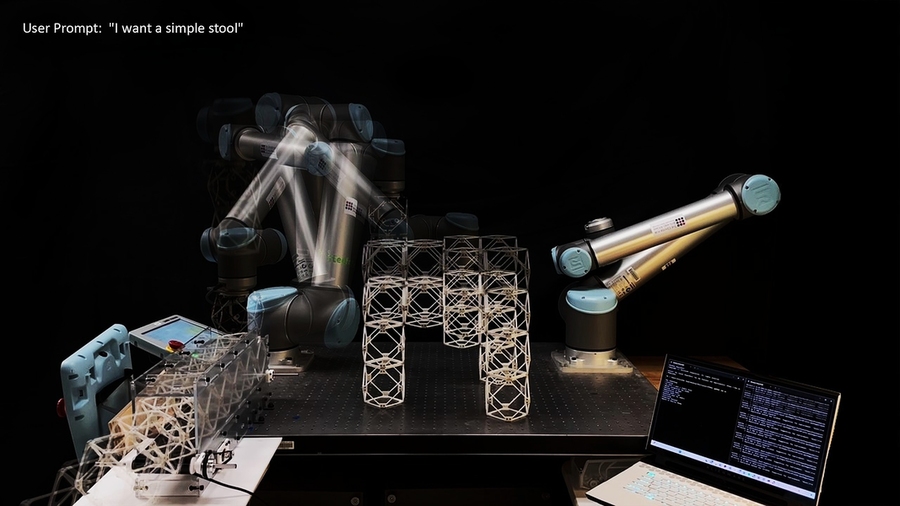

MIT-Forscher haben ein neues Speech-to-Actuality-System entwickelt, das generative 3D-KI mit Robotermontage kombiniert, um Objekte nach Bedarf herzustellen. Das System erstellte Gegenstände wie Möbel in nur fünf Minuten.

Dieser KI-gesteuerte Workflow ermöglicht es Benutzern, einem Roboterarm gesprochene Eingaben zu geben und so „Objekte ins Leben zu rufen“. Die Technologie nutzt natürliche Sprachverarbeitung, generative 3D-KI und Robotermontage, um den Herstellungsprozess zu rationalisieren.

Alexander Htet Kyaw, ein MIT-Absolvent und Stipendiat der Morningside Academy for Design (MAD), erklärte: „Wir verbinden die Verarbeitung natürlicher Sprache, generative 3D-KI und Robotermontage.“ Er fügte hinzu, dass diese schnell voranschreitenden Forschungsbereiche bisher nicht kombiniert wurden, um physische Objekte aus einer einfachen Sprachaufforderung zu erschaffen.

Das System empfängt gesprochene Befehle wie „Ich möchte einen einfachen Hocker“ und konstruiert dann Objekte aus modularen Komponenten. Bisher haben die Forscher mit dem System Hocker, Regale, Stühle, einen kleinen Tisch und dekorative Formen, darunter eine Hundestatue, gebaut.

Das Speech-to-Actuality-System verarbeitet Benutzeranfragen in mehreren Phasen:

- Spracherkennung: Ein großes Sprachmodell verarbeitet die gesprochene Eingabe des Benutzers.

- Generative 3D-KI: Das System erstellt eine digitale Netzdarstellung des gewünschten Objekts.

- Voxelisierungsalgorithmus: Das 3D-Netz wird in spezifische Baugruppenkomponenten zerlegt.

- Geometrische Bearbeitung: Die von der KI generierte Baugruppe wird geändert, um reale Fertigungsbeschränkungen wie Komponentenanzahl, Überhänge und geometrische Konnektivität zu berücksichtigen.

- Montagereihenfolge und Wegeplanung: Das System erstellt eine realisierbare Montagereihenfolge und automatisierte Bahnplanung für den Roboterarm.

Im Gegensatz zum 3D-Druck, der oft Stunden oder Tage dauert, ist die Objektkonstruktion mit diesem System innerhalb von Minuten abgeschlossen. Es macht Design und Fertigung auch für Personen zugänglicher, die über keine Kenntnisse in 3D-Modellierung oder Roboterprogrammierung verfügen.

Kyaw entwickelte das ursprüngliche System während des Kurses „Wie man quick alles herstellt“ von Professor Neil Gershenfeld. Er setzte das Projekt am MIT Heart for Bits and Atoms (CBA) fort und arbeitete mit den Doktoranden Se Hwan Jeon vom Division of Mechanical Engineering und Miana Smith vom CBA zusammen.

Das Crew plant, die Tragfähigkeit von Möbeln durch die Implementierung robusterer Verbindungen zwischen modularen Würfeln zu verbessern, die über die derzeitigen magnetischen Verbindungen hinausgehen. Smith bemerkte: „Wir haben auch Pipelines für die Umwandlung von Voxelstrukturen in realisierbare Montagesequenzen für kleine, verteilte cell Roboter entwickelt, die dazu beitragen könnten, diese Arbeit auf Strukturen jeder Größenskala zu übertragen.“

Durch den Einsatz modularer Komponenten soll der Produktionsabfall reduziert werden, indem die Demontage und der Wiederzusammenbau zu neuen Objekten ermöglicht werden. Kyaw arbeitet außerdem daran, Gestenerkennung und Augmented Actuality in das System zu integrieren und dabei sowohl Sprach- als auch Gestensteuerung für eine verbesserte Interaktion zu kombinieren.

Das Crew präsentierte seinen Artikel „Speech to Actuality: On-Demand Manufacturing utilizing Pure Language, 3D Generative AI, and Discrete Robotic Meeting“ am 21. November auf dem Affiliation for Computing Equipment (ACM) Symposium on Computational Fabrication (SCF ’25) am MIT.