Computergestützte Designsysteme (CAD) sind bewährte Werkzeuge zum Entwerfen vieler physischer Objekte, die wir täglich verwenden. Allerdings erfordert die Beherrschung von CAD-Software program umfangreiches Fachwissen, und viele Instruments verfügen über einen so hohen Detaillierungsgrad, dass sie sich nicht für Brainstorming oder Speedy Prototyping eignen.

Um Design schneller und für Laien zugänglicher zu machen, haben Forscher vom MIT und anderswo ein KI-gesteuertes Roboter-Montagesystem entwickelt, das es Menschen ermöglicht, physische Objekte zu bauen, indem sie sie einfach in Worten beschreiben.

Ihr System verwendet ein generatives KI-Modell, um basierend auf der Eingabeaufforderung des Benutzers eine 3D-Darstellung der Geometrie eines Objekts zu erstellen. Anschließend ermittelt ein zweites generatives KI-Modell das gewünschte Objekt und findet heraus, wo verschiedene Komponenten entsprechend der Funktion und Geometrie des Objekts platziert werden sollten.

Das System kann das Objekt mithilfe der Robotermontage automatisch aus einem Satz vorgefertigter Teile erstellen. Das Design kann auch basierend auf dem Suggestions des Benutzers iteriert werden.

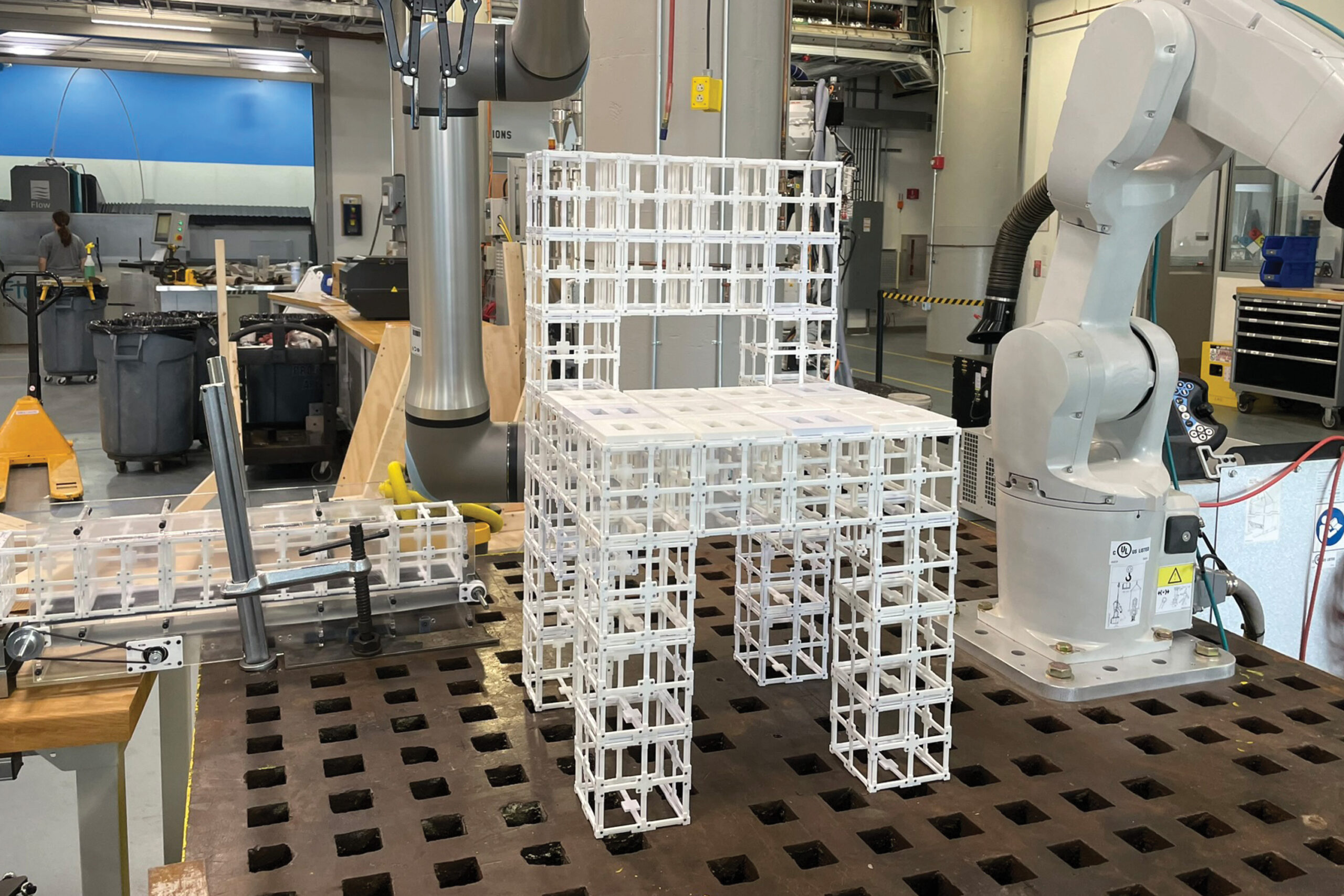

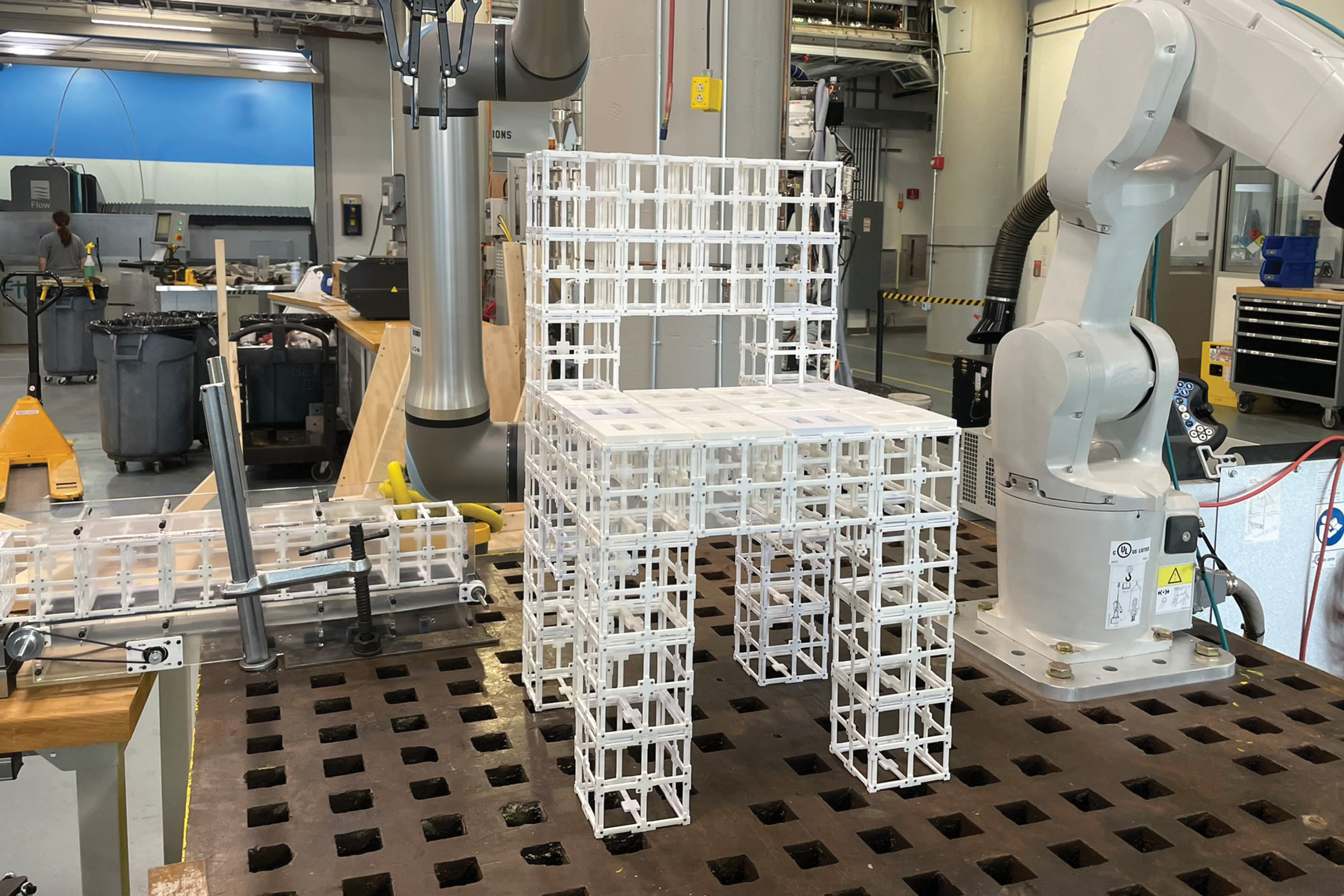

Die Forscher nutzten dieses Finish-to-Finish-System, um Möbel, darunter Stühle und Regale, aus zwei Arten vorgefertigter Komponenten herzustellen. Die Komponenten können nach Belieben zerlegt und wieder zusammengebaut werden, wodurch die Menge an Abfall reduziert wird, die durch den Herstellungsprozess entsteht.

Sie bewerteten diese Designs im Rahmen einer Benutzerstudie und stellten fest, dass mehr als 90 Prozent der Teilnehmer die von ihrem KI-gesteuerten System hergestellten Objekte im Vergleich zu anderen Ansätzen bevorzugten.

Obwohl es sich bei dieser Arbeit um eine erste Demonstration handelt, könnte das Framework besonders für die schnelle Prototypenerstellung komplexer Objekte wie Luft- und Raumfahrtkomponenten und Architekturobjekte nützlich sein. Längerfristig könnte es in Privathaushalten zur Herstellung von Möbeln oder anderen Gegenständen vor Ort eingesetzt werden, ohne dass sperrige Produkte von einer zentralen Einrichtung verschickt werden müssen.

„Früher oder später wollen wir in der Lage sein, mit einem Roboter und einem KI-System auf die gleiche Weise zu kommunizieren und zu reden, wie wir miteinander reden, um gemeinsam Dinge zu erschaffen. Unser System ist ein erster Schritt, um diese Zukunft zu ermöglichen“, sagt Hauptautor Alex Kyaw, ein Doktorand in den MIT-Fakultäten für Elektrotechnik und Informatik (EECS) und Architektur.

Kyaw wird bei dem Artikel von Richa Gupta unterstützt, einer Architekturstudentin am MIT; Faez Ahmed, außerordentlicher Professor für Maschinenbau; Lawrence Sass, Professor und Vorsitzender der Computation Group im Fachbereich Architektur; leitender Autor Randall Davis, EECS-Professor und Mitglied des Pc Science and Synthetic Intelligence Laboratory (CSAIL); sowie andere bei Google Deepmind und Autodesk Analysis. Der Papier wurde kürzlich auf der Konferenz über neuronale Informationsverarbeitungssysteme vorgestellt.

Generieren eines Mehrkomponentendesigns

Während generative KI-Modelle intestine darin sind, aus Texteingaben 3D-Darstellungen, sogenannte Meshes, zu generieren, erzeugen die meisten keine einheitlichen Darstellungen der Geometrie eines Objekts, die über die für die Robotermontage erforderlichen Particulars auf Komponentenebene verfügen.

Die Aufteilung dieser Netze in Komponenten stellt für ein Modell eine Herausforderung dar, da die Zuweisung von Komponenten von der Geometrie und Funktionalität des Objekts und seiner Teile abhängt.

Die Forscher gingen diese Herausforderungen mithilfe eines Imaginative and prescient-Language-Modells (VLM) an, einem leistungsstarken generativen KI-Modell, das vorab darauf trainiert wurde, Bilder und Textual content zu verstehen. Sie beauftragen das VLM damit, herauszufinden, wie zwei Arten vorgefertigter Teile, Strukturbauteile und Plattenbauteile, zu einem Objekt zusammenpassen sollten.

„Es gibt viele Möglichkeiten, Platten auf einem physischen Objekt anzubringen, aber der Roboter muss die Geometrie sehen und über diese Geometrie nachdenken, um eine Entscheidung darüber treffen zu können. Indem das VLM sowohl als Auge als auch als Gehirn des Roboters dient, ermöglicht es dem Roboter, dies zu tun“, sagt Kyaw.

Ein Benutzer fordert das System mit Textual content auf, beispielsweise durch die Eingabe von „Mach mir einen Stuhl“, und gibt ihm zum Starten ein KI-generiertes Bild eines Stuhls.

Dann überlegt das VLM den Stuhl und bestimmt anhand der Funktionalität vieler Beispielobjekte, die es zuvor gesehen hat, wo Plattenkomponenten auf Strukturkomponenten platziert werden. Beispielsweise kann das Modell festlegen, dass der Sitz und die Rückenlehne über Platten verfügen sollen, um eine Sitz- und Anlehnfläche für jemanden zu schaffen, der auf dem Stuhl sitzt.

Es gibt diese Informationen als Textual content aus, beispielsweise „Sitz“ oder „Rückenlehne“. Jede Oberfläche des Stuhls wird dann mit Nummern beschriftet und die Informationen werden an das VLM zurückgemeldet.

Anschließend wählt der VLM die Beschriftungen aus, die den geometrischen Teilen des Stuhls entsprechen, die zur Vervollständigung des Entwurfs mit Panels auf dem 3D-Netz versehen werden sollen.

Co-Design von Mensch und KI

Der Benutzer bleibt während dieses Prozesses auf dem Laufenden und kann das Design verfeinern, indem er dem Modell eine neue Eingabeaufforderung gibt, z. B. „Verwenden Sie nur Paneele an der Rückenlehne, nicht am Sitz.“

„Der Gestaltungsspielraum ist sehr groß, daher schränken wir ihn anhand von Benutzerfeedback ein. Wir glauben, dass dies der beste Weg ist, da Menschen unterschiedliche Vorlieben haben und es unmöglich wäre, ein idealisiertes Modell für alle zu erstellen“, sagt Kyaw.

„Der Human-in-the-Loop-Prozess ermöglicht es den Benutzern, die KI-generierten Designs zu steuern und ein Gefühl der Eigenverantwortung für das Endergebnis zu entwickeln“, fügt Gupta hinzu.

Sobald das 3D-Netz fertiggestellt ist, baut ein Roboter-Montagesystem das Objekt aus vorgefertigten Teilen auf. Diese wiederverwendbaren Teile können zerlegt und in verschiedenen Konfigurationen wieder zusammengebaut werden.

Die Forscher verglichen die Ergebnisse ihrer Methode mit einem Algorithmus, der Paneele auf allen horizontalen Flächen platziert, die nach oben zeigen, und einem Algorithmus, der Paneele zufällig platziert. In einer Benutzerstudie bevorzugten mehr als 90 Prozent der Personen die von ihrem System erstellten Designs.

Sie baten das VLM außerdem, zu erklären, warum es sich für die Anbringung von Panels in diesen Bereichen entschieden habe.

„Wir haben gelernt, dass das Imaginative and prescient-Language-Modell in der Lage ist, die funktionalen Aspekte eines Stuhls, wie Lehnen und Sitzen, bis zu einem gewissen Grad zu verstehen und zu verstehen, warum es Paneele auf dem Sitz und der Rückenlehne anbringt. Es spuckt diese Aufgaben nicht einfach nur wahllos aus“, sagt Kyaw.

Zukünftig wollen die Forscher ihr System so erweitern, dass es auch komplexere und differenziertere Benutzereingaben bewältigen kann, etwa einen Tisch aus Glas und Metall. Darüber hinaus wollen sie weitere vorgefertigte Komponenten wie Zahnräder, Scharniere oder andere bewegliche Teile einbauen, um den Objekten mehr Funktionalität zu verleihen.

„Unsere Hoffnung ist es, die Hürde beim Zugang zu Design-Instruments drastisch zu senken. Wir haben gezeigt, dass wir generative KI und Robotik nutzen können, um Ideen schnell, zugänglich und nachhaltig in physische Objekte umzuwandeln“, sagt Davis.