Erdbeobachtungskonstellationen (EO) erfassen täglich große Mengen hochauflösender Bilder, doch die meisten davon erreichen den Boden nicht rechtzeitig für das Modelltraining. Der Hauptengpass ist die Downlink-Bandbreite. Bilder können tagelang im Orbit bleiben, während Bodenmodelle mit Teil- und Verzögerungsdaten trainieren.

Als einen anderen Ansatz stellten Microsoft-Forscher das „OrbitalBrain“-Framework vor. Anstatt Satelliten nur als Sensoren zu verwenden, die Daten an die Erde weiterleiten, verwandelt es eine Nanosatellitenkonstellation in ein verteiltes Trainingssystem. Modelle werden direkt im Weltraum trainiert, aggregiert und aktualisiert, wobei integrierte Rechenleistung, Intersatellitenverbindungen und vorausschauende Planung von Leistung und Bandbreite genutzt werden.

Der BentPipe-Engpass

Die meisten kommerziellen Konstellationen verwenden das BentPipe-Modell. Satelliten sammeln Bilder, speichern sie lokal und senden sie an Bodenstationen, wann immer sie über ihnen vorbeifliegen.

Das Forschungsteam schätzt eine planetenähnliche Konstellation mit 207 Satelliten und 12 Bodenstationen ein. Bei maximaler Bildrate erfasst das System 363.563 Bilder professional Tag. Bei 300 MB professional Bild und realistischen Downlink-Beschränkungen können in diesem Zeitraum nur 42.384 Bilder übertragen werden, etwa 11,7 % der aufgenommenen Bilder. Selbst wenn die Bilder auf 100 MB komprimiert werden, erreichen innerhalb von 24 Stunden nur 111.737 Bilder, etwa 30,7 %, den Boden.

Der begrenzte Onboard-Speicher stellt eine weitere Einschränkung dar. Alte Bilder müssen gelöscht werden, um Platz für neue zu schaffen, was bedeutet, dass viele potenziell nützliche Proben nie für bodengestütztes Coaching verfügbar sind.

Warum herkömmliches föderiertes Lernen nicht ausreicht

Federated Studying (FL) scheint eine offensichtliche Lösung für Satelliten zu sein. Jeder Satellit könnte lokal trainieren und Modellaktualisierungen zur Aggregation an einen Bodenserver senden. Das Forschungsteam bewertet mehrere an diese State of affairs angepasste FL-Basislinien:

- AsyncFL

- SyncFL

- FedBuff

- FedSpace

Allerdings setzen diese Methoden eine stabilere Kommunikation und eine flexiblere Energieversorgung voraus, als sie Satelliten bieten können. Wenn das Forschungsteam realistische Orbitaldynamiken, intermittierenden Bodenkontakt, begrenzte Leistung und Nicht-IID-Daten über Satelliten hinweg simuliert, zeigen diese Basislinien eine instabile Konvergenz und große Genauigkeitseinbußen im Bereich von 10–40 % im Vergleich zu idealisierten Bedingungen.

Die Zeit-zu-Genauigkeitskurven werden flacher und schwanken, insbesondere wenn Satelliten über längere Zeiträume von Bodenstationen isoliert sind. Viele lokale Updates veralten, bevor sie aggregiert werden können.

OrbitalBrain: Konstellationszentriertes Coaching im Weltraum

OrbitalBrain geht von 3 Beobachtungen aus:

- Konstellationen werden in der Regel von einer einzelnen kommerziellen Einheit betrieben, sodass Rohdaten von mehreren Satelliten gemeinsam genutzt werden können.

- Umlaufbahnen, Sichtbarkeit der Bodenstation und Solarenergie lassen sich anhand von Orbitalelementen und Leistungsmodellen vorhersagen.

- Intersatellitenverbindungen (ISLs) und Bordbeschleuniger sind jetzt auf Nanosatelliten praktisch.

Das Framework stellt drei Aktionen für jeden Satelliten in einem Planungsfenster bereit:

- Lokales Computing (LC): Trainieren Sie das lokale Modell anhand gespeicherter Bilder.

- Modellaggregation (MA): Modellparameter über ISLs austauschen und aggregieren.

- Datenübertragung (DT): Rohbilder zwischen Satelliten austauschen, um Datenversatz zu reduzieren.

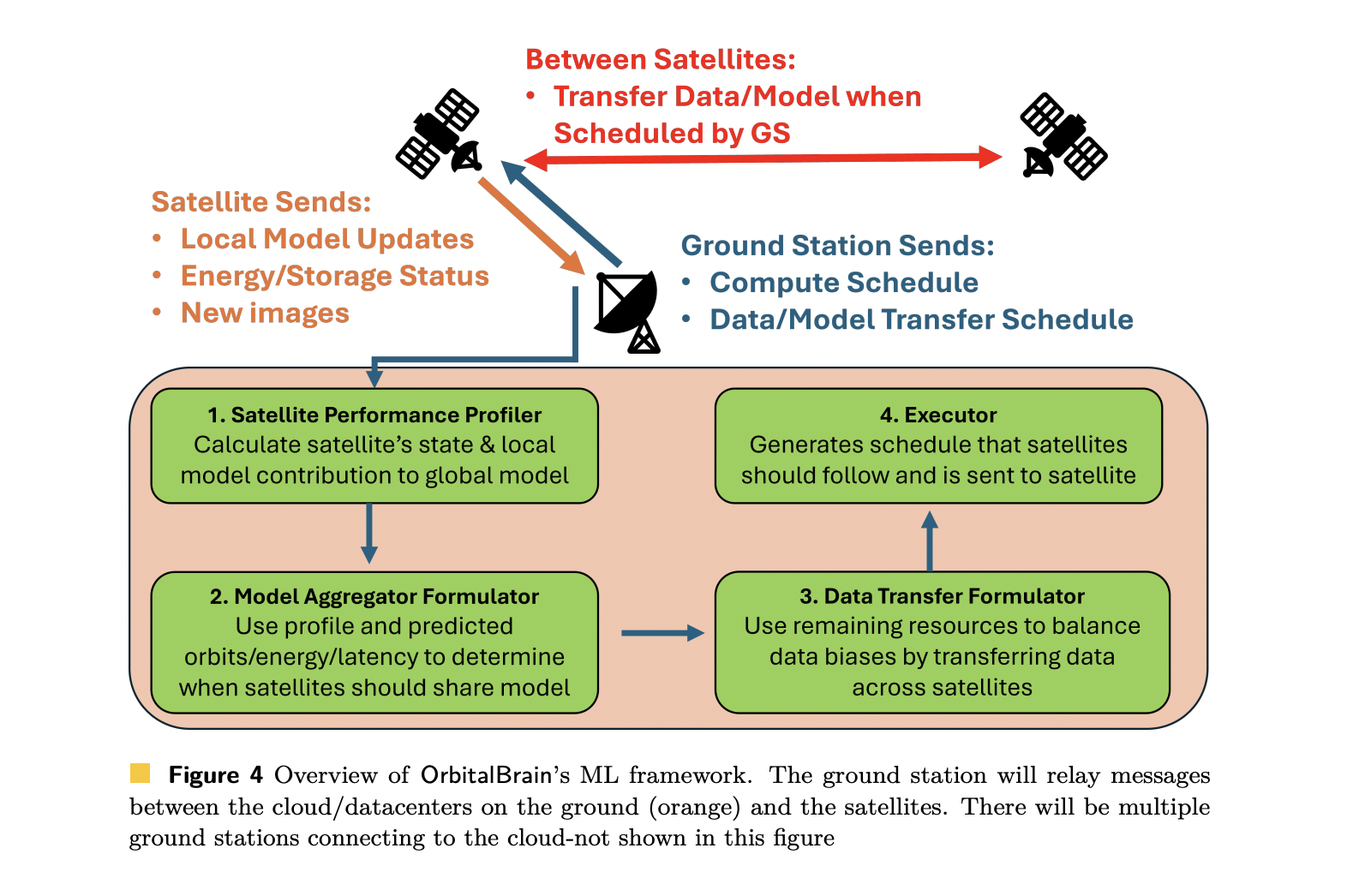

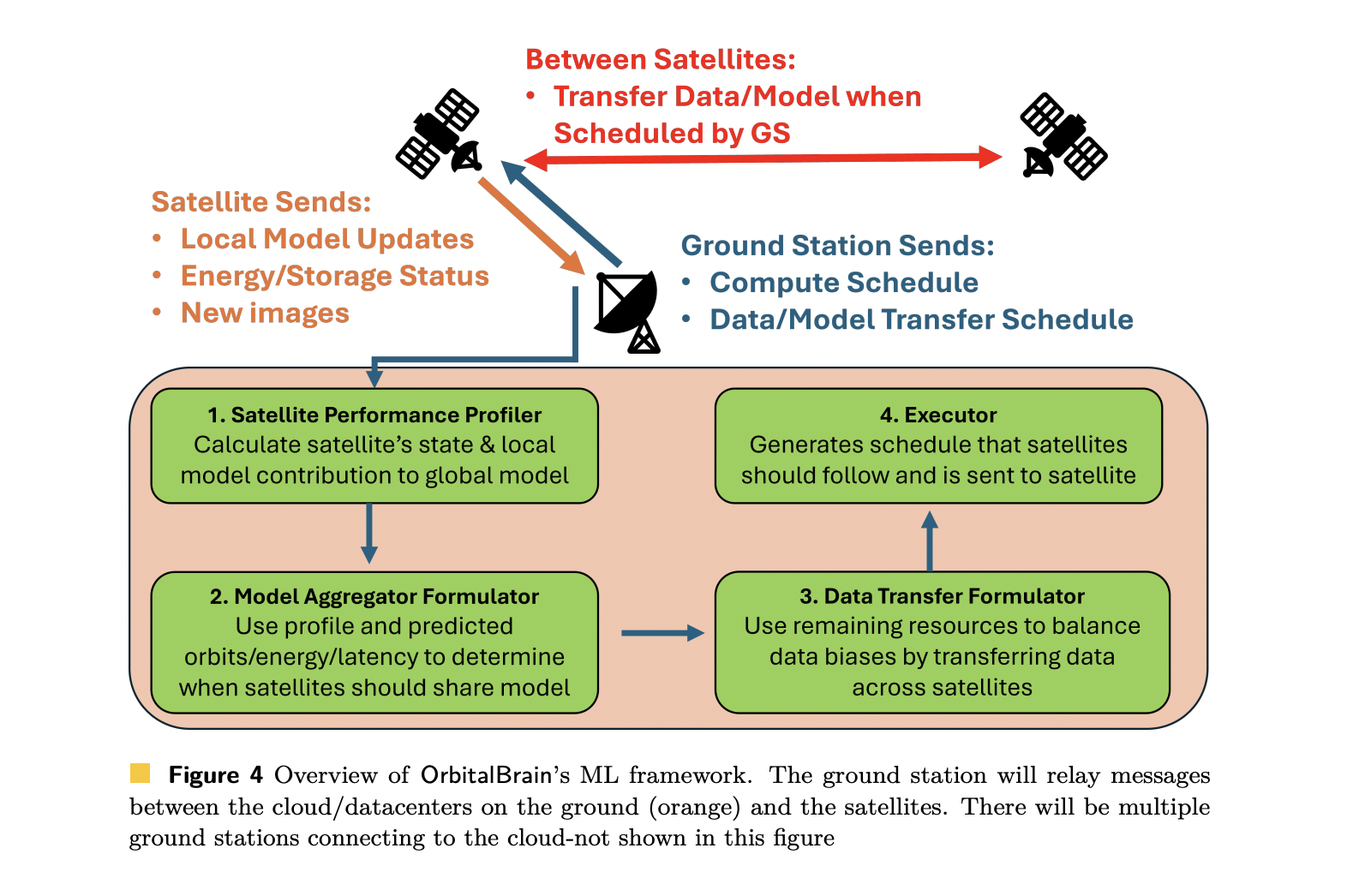

Ein in der Cloud laufender Controller, der über Bodenstationen erreichbar ist, berechnet einen Vorhersageplan für jeden Satelliten. Der Zeitplan entscheidet, welche Aktion in jedem zukünftigen Fenster priorisiert werden soll, basierend auf Prognosen zu Energie, Speicherung, Orbitalsichtbarkeit und Verbindungsmöglichkeiten.

Kernkomponenten: Profiler, MA, DT, Executor

- Geführter Leistungsprofiler

- Modellaggregation über ISLs

- Datenübertrager für Etiketten-Neuausrichtung

- Testamentsvollstrecker

Versuchsaufbau

OrbitalBrain ist in Python auf Foundation des Orbitalsimulators CosmicBeats und des föderierten Lernrahmens FLUTE implementiert. Die integrierte Rechenleistung wird als NVIDIA-Jetson-Orin-Nano-4GB-GPU modelliert, wobei die Leistungs- und Kommunikationsparameter anhand öffentlicher Satelliten- und Funkspezifikationen kalibriert werden.

Das Forschungsteam simuliert 24-Stunden-Spuren für 2 reale Konstellationen:

- Planet: 207 Satelliten mit 12 Bodenstationen.

- Turm: 117 Satelliten.

Sie bewerten 2 EO-Klassifizierungsaufgaben:

- fMoW: ca. 360.000 RGB-Bilder, 62 Klassen, DenseNet-161, wobei die letzten 5 Schichten trainierbar sind.

- So2Sat: rund 400.000 multispektrale Bilder, 17 Klassen, ResNet-50, wobei die letzten 5 Schichten trainierbar sind.

Ergebnisse: schnellere Zeit bis zur Genauigkeit und höhere Genauigkeit

OrbitalBrain wird unter vollständigen physikalischen Einschränkungen mit BentPipe, AsyncFL, SyncFL, FedBuff und FedSpace verglichen.

Für fMoW nach 24 Stunden:

- Planet: OrbitalBrain erreicht eine High-1-Genauigkeit von 52,8 %.

- Spire: OrbitalBrain erreicht eine High-1-Genauigkeit von 59,2 %.

Für So2Sat:

- Planet: 47,9 % High-1-Genauigkeit.

- Spire: 47,1 % High-1-Genauigkeit.

Diese Ergebnisse verbessern sich gegenüber der besten Basislinie um 5,5–49,5 %, je nach Datensatz und Konstellation.

Was die Zeit bis zur Genauigkeit betrifft, OrbitalBrain erreicht eine Beschleunigung um das 1,52- bis 12,4-fache im Vergleich zu hochmodernen bodenbasierten oder föderierten Lernansätzen. Dies ist auf die Nutzung von Satelliten zurückzuführen, die derzeit keine Bodenstation erreichen können, indem sie über ISLs aggregiert werden, und auf die Neuausrichtung der Datenverteilungen über DT.

Ablationsstudien zeigen, dass die Deaktivierung von MA oder DT sowohl die Konvergenzgeschwindigkeit als auch die Endgenauigkeit erheblich beeinträchtigt. Weitere Experimente deuten darauf hin, dass OrbitalBrain strong bleibt, wenn die Wolkendecke einen Teil der Bilder verdeckt, wenn nur eine Teilmenge der Satelliten beteiligt ist und wenn Bildgrößen und Auflösungen variieren.

Auswirkungen auf Satelliten-KI-Arbeitslasten

OrbitalBrain zeigt, dass sich das Modelltraining in den Weltraum bewegen kann und dass Satellitenkonstellationen als verteilte ML-Systeme und nicht nur als Datenquellen fungieren können. Durch die Koordinierung lokaler Schulung, Modellaggregation und Datenübertragung unter strengen Bandbreiten-, Strom- und Speicherbeschränkungen ermöglicht das Framework aktuellere Modelle für Aufgaben wie Waldbranderkennung, Überschwemmungsüberwachung und Klimaanalyse, ohne tagelang darauf warten zu müssen, dass die Daten terrestrische Rechenzentren erreichen.

Wichtige Erkenntnisse

- Der BentPipe-Downlink ist der Hauptengpass: Planetenähnliche EO-Konstellationen können nur etwa 11,7 % der erfassten 300-MB-Bilder professional Tag downlinken, und etwa 30,7 % selbst mit 100-MB-Komprimierung, was das bodengestützte Modelltraining stark einschränkt.

- Standardmäßiges föderiertes Lernen schlägt unter realen Satelliteneinschränkungen fehl: AsyncFL, SyncFL, FedBuff und FedSpace verschlechtern sich um 10–40 % an Genauigkeit, wenn realistische Orbitaldynamik, intermittierende Verbindungen, Leistungsgrenzen und nicht-iid-Daten angewendet werden, was zu instabiler Konvergenz führt.

- OrbitalBrain plant die Berechnung, Aggregation und Datenübertragung im Orbit gemeinsam: Ein Cloud-Controller nutzt Prognosen zu Umlaufbahn, Energie, Speicher und Verbindungsmöglichkeiten, um lokale Berechnung, Modellaggregation über ISLs oder Datenübertragung professional Satellit auszuwählen und so eine Nutzenfunktion professional Aktion zu maximieren.

- Die Neuausrichtung von Etiketten und die Veralterung von Modellen werden explizit behandelt: Ein geführter Profiler verfolgt die Veralterung und den Verlust des Modells, um den Rechennutzen zu definieren, während der Datenübertrager die Jensen-Shannon-Divergenz auf Label-Histogrammen nutzt, um den Austausch von Rohbildern voranzutreiben, die Nicht-IID-Effekte reduzieren.

- OrbitalBrain bietet eine höhere Genauigkeit und eine bis zu 12,4-mal schnellere Zeit bis zur Genauigkeit: In Simulationen von Planeten- und Spire-Konstellationen mit fMoW und So2Sat verbessert OrbitalBrain die endgültige Genauigkeit um 5,5–49,5 % gegenüber BentPipe- und FL-Basislinien und erreicht eine 1,52- bis 12,4-fache Beschleunigung der Zeit bis zur Genauigkeit.

Schauen Sie sich das an Papier. Sie können uns auch gerne weiter folgen Twitter und vergessen Sie nicht, bei uns mitzumachen 100.000+ ML SubReddit und Abonnieren Unser Publication. Warten! Bist du im Telegram? Jetzt können Sie uns auch per Telegram kontaktieren.