Bild vom Autor

# (Wieder)Einführung von Hugging Face

Am Ende dieses Tutorials werden Sie lernen und verstehen, wie wichtig es ist Umarmendes Gesicht Erkunden Sie das Ökosystem des modernen maschinellen Lernens und richten Sie Ihre lokale Entwicklungsumgebung ein, um Ihre praktische Reise zum Erlernen maschinellen Lernens zu beginnen. Außerdem erfahren Sie, warum Hugging Face für alle kostenlos ist, und entdecken die Instruments, die es sowohl für Anfänger als auch für Experten bietet. Aber zuerst wollen wir verstehen, worum es bei Hugging Face geht.

Hugging Face ist eine On-line-Neighborhood für KI, die zum Grundstein für alle geworden ist, die mit KI und maschinellem Lernen arbeiten, und es Forschern, Entwicklern und Organisationen ermöglicht, maschinelles Lernen auf bisher unzugängliche Weise zu nutzen.

Stellen Sie sich Hugging Face als eine Bibliothek voller Bücher vor, die von den besten Autoren aus der ganzen Welt geschrieben wurden. Anstatt Ihre eigenen Bücher zu schreiben, können Sie eines ausleihen, es verstehen und es zur Lösung von Problemen verwenden – sei es beim Zusammenfassen von Artikeln, beim Übersetzen von Texten oder beim Klassifizieren von E-Mails.

In ähnlicher Weise ist Hugging Face mit maschinellen Lern- und KI-Modellen gefüllt, die von Forschern und Entwicklern aus der ganzen Welt geschrieben wurden und die Sie herunterladen und auf Ihrem lokalen Laptop ausführen können. Sie können die Modelle auch direkt über die Hugging Face API nutzen, ohne dass teure {Hardware} erforderlich ist.

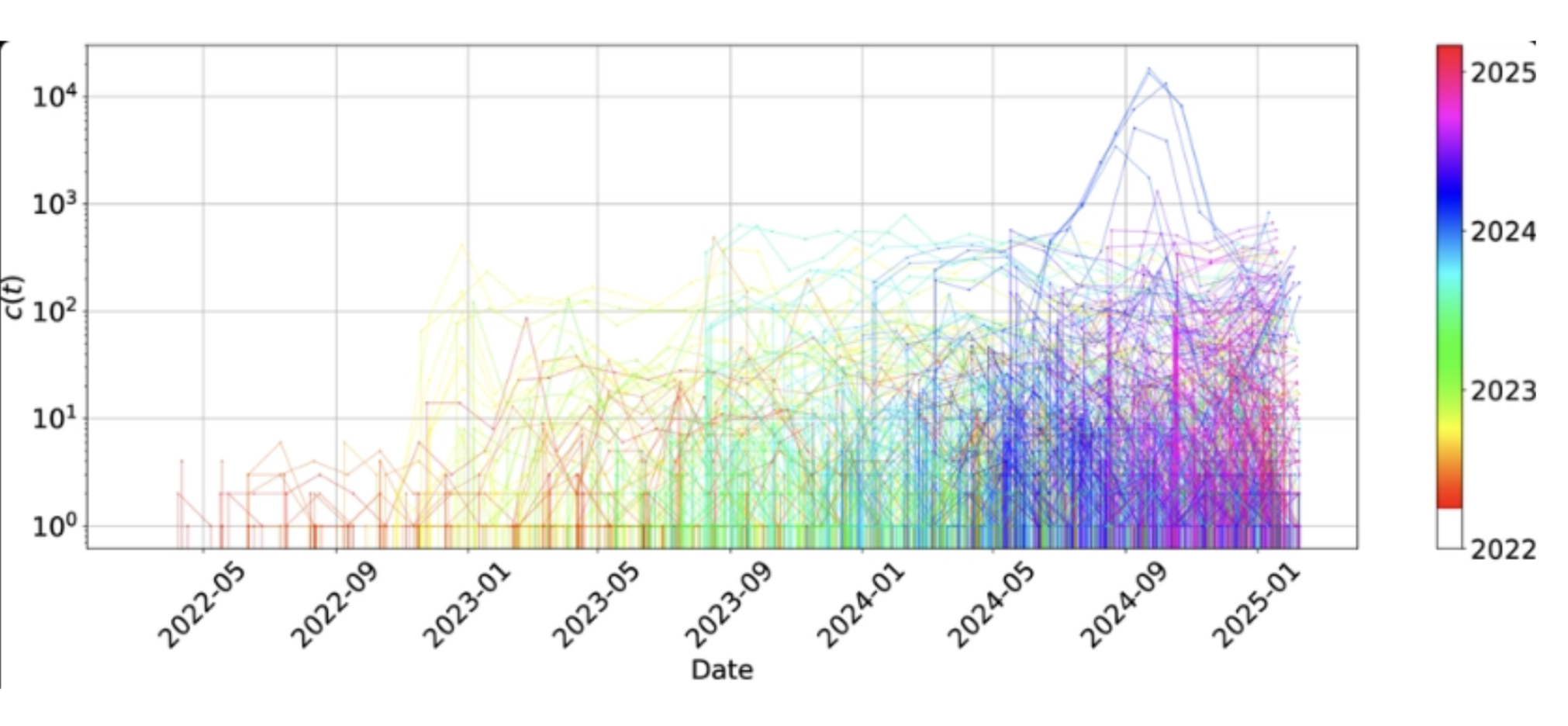

Heute beherbergt der Hugging Face Hub Millionen vorab trainierter Modelle, Hunderttausende Datensätze und große Sammlungen von Demoanwendungen, die alle von einer globalen Neighborhood bereitgestellt werden.

# Den Ursprung des umarmenden Gesichts aufspüren

Hugging Face wurde von den französischen Unternehmern Clement Delangue, Julien Chaumond und Thomas Wolf gegründet, die sich zunächst mit der Entwicklung eines leistungsstarken Chatbots beschäftigten und dabei feststellten, dass Entwickler und Forscher Schwierigkeiten hatten, auf vorab trainierte Modelle zuzugreifen und modernste Algorithmen zu implementieren. Anschließend widmete sich Hugging Face der Entwicklung von Instruments für maschinelle Lernworkflows und Open-Supply-Plattformen für maschinelles Lernen.

Bild vom Autor

# Engagieren Sie sich in der Hugging Face Open-Supply-KI-Neighborhood

Hugging Face steht im Mittelpunkt der Instruments und Ressourcen, die alles bieten, was für einen maschinellen Lernworkflow erforderlich ist. Hugging Face bietet all diese Instruments und Ressourcen für die KI. Hugging Face ist nicht nur ein Unternehmen, sondern eine globale Gemeinschaft, die das KI-Zeitalter vorantreibt.

Hugging Face bietet eine Reihe von Instruments, wie zum Beispiel:

- Transformers-Bibliothek: für den Zugriff auf vorab trainierte Modelle für Aufgaben wie Textklassifizierung und -zusammenfassung usw.

- Datensatzbibliothek: bieten einfachen Zugriff auf kuratierte Datensätze zur Verarbeitung natürlicher Sprache (NLP), zu visuellem Sehen und zu Audiodaten. Dadurch sparen Sie Zeit, da Sie nicht neu beginnen müssen.

- Modell-Hub: Hier tauschen Forscher und Entwickler Exams aus, gewähren Ihnen Zugriff darauf und laden vorab trainierte Modelle für jede Artwork von Projekt herunter, das Sie erstellen.

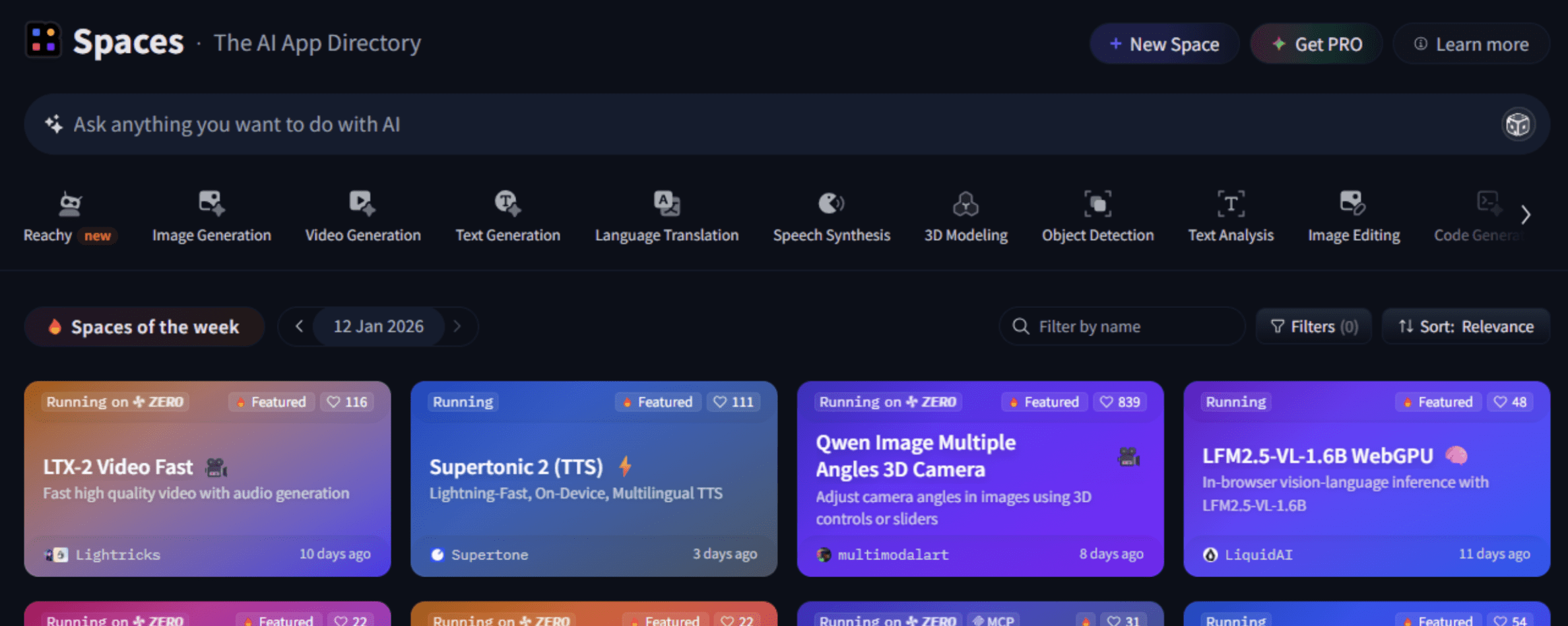

- Räume: Hier können Sie Ihre Demo erstellen und hosten Gradio Und Streamlit.

Was Hugging Face wirklich von anderen KI- und maschinellen Lernplattformen unterscheidet, ist sein Open-Supply-Ansatz, der es Forschern und Entwicklern aus der ganzen Welt ermöglicht, einen Beitrag zur KI-Neighborhood zu leisten, sie weiterzuentwickeln und zu verbessern.

# Bewältigung der wichtigsten Herausforderungen des maschinellen Lernens

Maschinelles Lernen ist transformativ, musste sich im Laufe der Jahre jedoch mehreren Herausforderungen stellen. Dazu gehört das Coaching großer Modelle von Grund auf und erfordert enorme Rechenressourcen, die teuer und für die meisten Menschen nicht zugänglich sind. Die Vorbereitung von Datensätzen, die Umsetzung von Modellarchitekturen und die Bereitstellung von Modellen in der Produktion sind äußerst komplex.

Hugging Face begegnet diesen Herausforderungen durch:

- Reduziert den Rechenaufwand mit vorab trainierten Modellen.

- Vereinfacht maschinelles Lernen mit intuitiven APIs.

- Erleichtern Sie die Zusammenarbeit durch ein zentrales Repository.

Hugging Face reduziert diese Herausforderungen auf verschiedene Weise. Durch das Angebot vorab trainierter Modelle können Entwickler die kostspielige Trainingsphase überspringen und sofort mit der Verwendung modernster Modelle beginnen.

Der Transformers Die Bibliothek bietet benutzerfreundliche APIs, mit denen Sie anspruchsvolle maschinelle Lernaufgaben mit nur wenigen Codezeilen implementieren können. Darüber hinaus fungiert Hugging Face als zentrales Repository und ermöglicht den nahtlosen Austausch, die Zusammenarbeit und die Entdeckung von Modellen und Datensätzen.

Am Ende haben wir die KI demokratisiert, bei der jeder, unabhängig von Rasse oder Ressourcen, Lösungen für maschinelles Lernen entwickeln und einsetzen kann. Aus diesem Grund ist „Hugging Face“ branchenübergreifend akzeptabel Microsoft, Google, Metaund andere, die es in ihre Arbeitsabläufe integrieren.

# Erkundung des Hugging Face-Ökosystems

Das Ökosystem von Hugging Face ist breit gefächert und umfasst viele integrierte Komponenten, die den gesamten Lebenszyklus von KI-Workflows unterstützen:

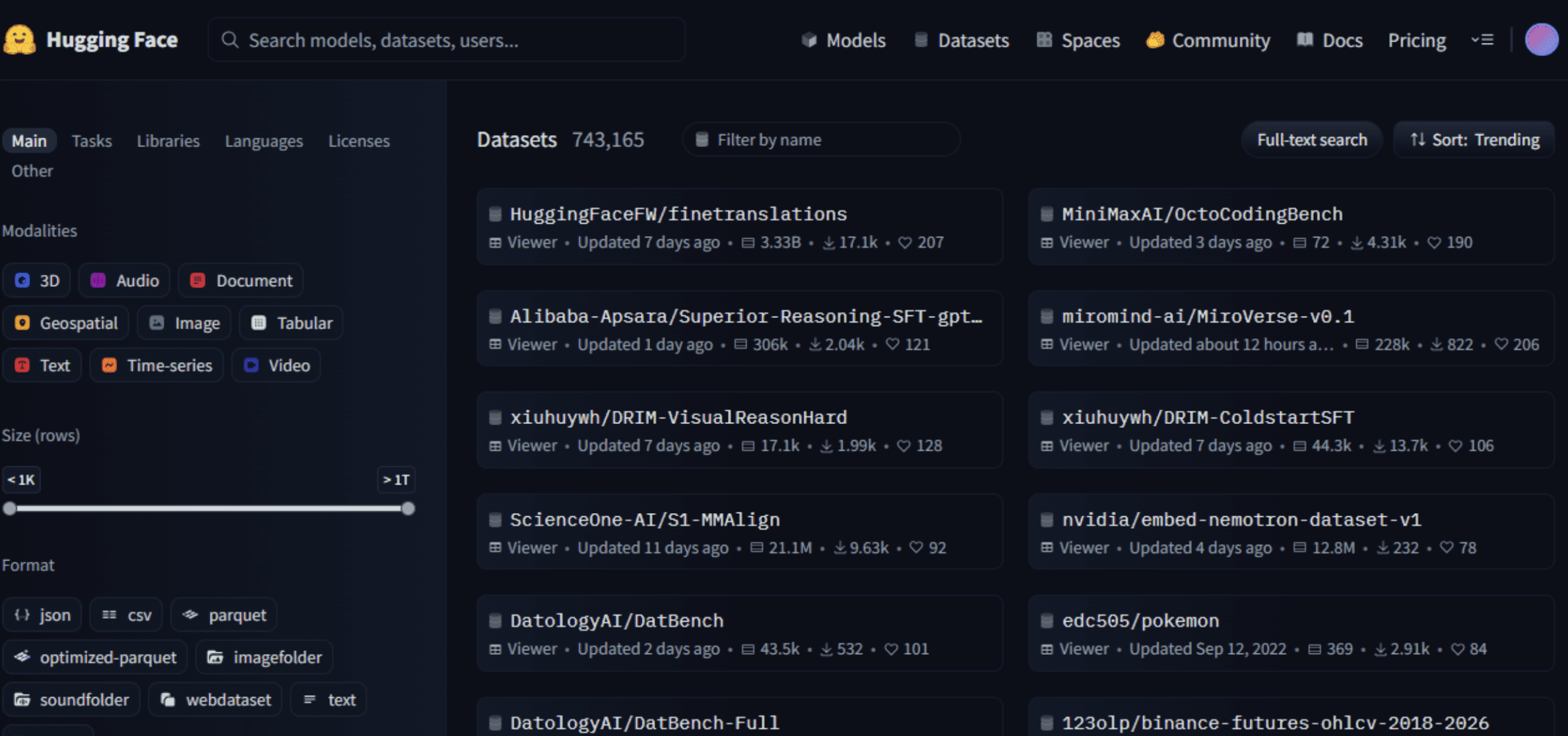

// Navigieren im Hugging Face Hub

- Ein zentrales Repository für KI-Artefakte: Modelle, Datensätze und Anwendungen (Areas).

- Unterstützt öffentliches und privates Internet hosting mit Versionierung, Metadaten und Dokumentation.

- Benutzer können KI-Ressourcen hochladen, herunterladen, durchsuchen und vergleichen.

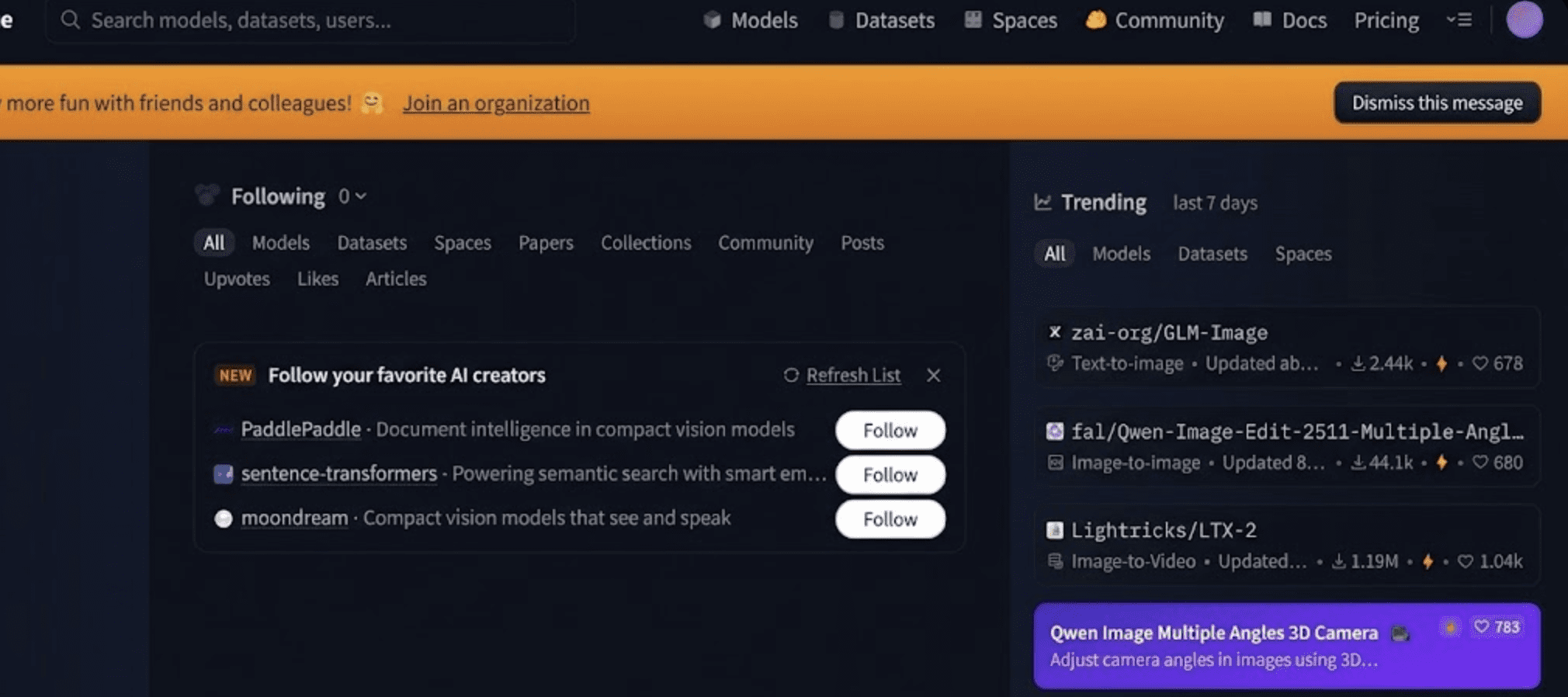

Besuchen Sie zunächst die Hugging Face-Web site in Ihrem Browser. Die Homepage bietet eine übersichtliche Oberfläche mit Optionen zum Erkunden von Modellen, Datensätzen und Räumen.

Bild vom Autor

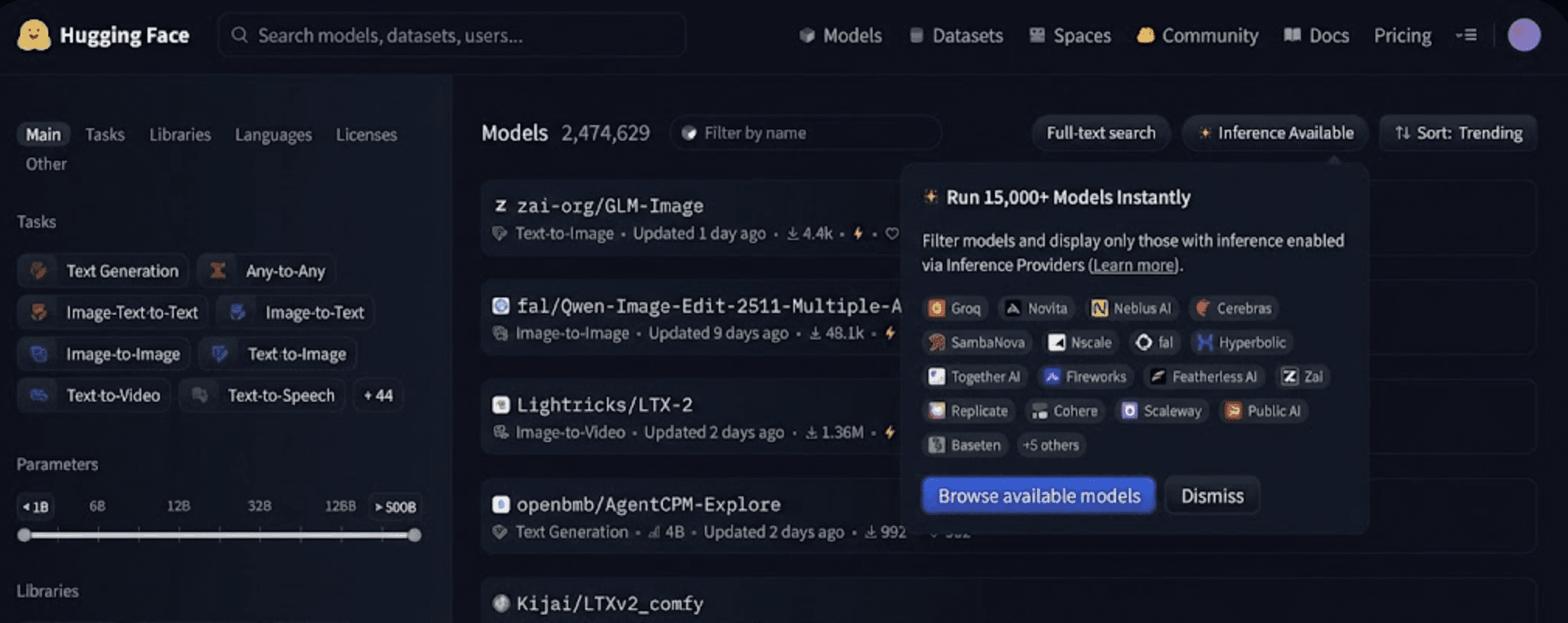

// Arbeiten mit Modellen

Der Modellbereich dient als Zentrum von Hugging Face Hub. Es bietet Tausende vorab trainierter Modelle für verschiedene maschinelle Lernaufgaben, sodass Sie vorab trainierte Modelle für Aufgaben wie Textklassifizierung, Zusammenfassung und Bilderkennung nutzen können, ohne alles von Grund auf neu erstellen zu müssen.

Bild vom Autor

- Datensätze: Gebrauchsfertige Datensätze zum Trainieren und Bewerten Ihrer Modelle.

- Areas: Interaktive Demos und Apps, die mit Instruments wie erstellt wurden Gradio Und Streamlit.

// Nutzung der Transformers-Bibliothek

Der Transformers-Bibliothek ist das Flaggschiff-Open-Supply-SDK, das standardisiert, wie transformatorbasierte Modelle für Inferenz und Coaching für verschiedene Aufgaben verwendet werden, einschließlich NLP, Laptop Imaginative and prescient, Audio und multimodales Lernen. Es:

- Unterstützt über Tausende von Modellarchitekturen (z. B. BERT, GPT, T5, ViT).

- Stellt Pipelines für allgemeine Aufgaben bereit, einschließlich Textgenerierung, Klassifizierung, Beantwortung von Fragen und Imaginative and prescient.

- Integriert sich mit PyTorch, TensorFlowUnd JAX für flexibles Coaching und Inferenz.

// Zugriff auf die Datensatzbibliothek

Der Datensätze Die Bibliothek bietet Instruments für:

- Entdecken, laden und vorverarbeiten Sie Datensätze vom Hub.

- Behandeln Sie große Datensätze mit Streaming-, Filter- und Transformationsfunktionen.

- Verwalten Sie Schulungs-, Bewertungs- und Testsplits effizient.

Diese Bibliothek erleichtert das Experimentieren mit realen Daten in verschiedenen Sprachen und Aufgaben ohne komplexes Knowledge Engineering.

Bild vom Autor

Hugging Face unterhält außerdem mehrere Hilfsbibliotheken, die das Coaching und die Bereitstellung von Modellen ergänzen:

- Diffusoren: Für generative Bild-/Videomodelle unter Verwendung von Diffusionstechniken.

- Tokenisierer: Ultraschnelle Tokenisierungsimplementierungen in Rust

- PEFT: Parametereffiziente Feinabstimmungsmethoden (LoRA, QLoRA)

- Beschleunigen: Vereinfacht verteiltes und leistungsstarkes Coaching

- Transformers.js: Ermöglicht Modellinferenz direkt im Browser oder Node.js

- TRL (Transformers Reinforcement Studying): Instruments zum Trainieren von Sprachmodellen mit Methoden des verstärkenden Lernens

// Bauen mit Räumen

Räume sind leichte interaktive Anwendungen, die Modelle und Demos präsentieren, die normalerweise mit Frameworks wie Gradio oder Streamlit erstellt wurden. Sie ermöglichen Entwicklern:

- Stellen Sie Demos für maschinelles Lernen mit minimaler Infrastruktur bereit.

- Teilen Sie interaktive visuelle Instruments für die Texterstellung, Bildbearbeitung, semantische Suche und mehr.

- Experimentieren Sie visuell, ohne Backend-Dienste zu schreiben.

Bild vom Autor

# Einsatz von Bereitstellungs- und Produktionstools

Zusätzlich zu Open-Supply-Bibliotheken bietet Hugging Face produktionsbereite Dienste wie:

- Inferenz-API: Diese APIs ermöglichen gehostete Modellinferenz über REST-APIs ohne Bereitstellung von Servern und unterstützen auch Skalierungsmodelle (einschließlich großer Sprachmodelle) für Stay-Anwendungen

- Inferenzendpunkte: Dies dient der Verwaltung von GPU/TPU-Endpunkten und ermöglicht es Groups, Modelle im großen Maßstab mit Überwachung und Protokollierung bereitzustellen

- Cloud-Integrationen: Hugging Face lässt sich in große Cloud-Anbieter wie AWS, Azure und Google Cloud integrieren und ermöglicht es Unternehmensteams, Modelle innerhalb ihrer bestehenden Cloud-Infrastruktur bereitzustellen

# Befolgen eines vereinfachten technischen Arbeitsablaufs

Hier ist ein typischer Entwickler-Workflow für Hugging Face:

- Suchen Sie im Hub nach einem vorab trainierten Modell und wählen Sie es aus

- Laden Sie Notebooks lokal oder in der Cloud und optimieren Sie sie mit

Transformers - Laden Sie das fein abgestimmte Modell und den Datensatz mit Versionierung zurück in den Hub

- Bereitstellen mit Inference API oder Inference Endpoints

- Teilen Sie Demos über Areas.

Dieser Workflow beschleunigt die Prototypenerstellung, das Experimentieren und die Produktionsentwicklung erheblich.

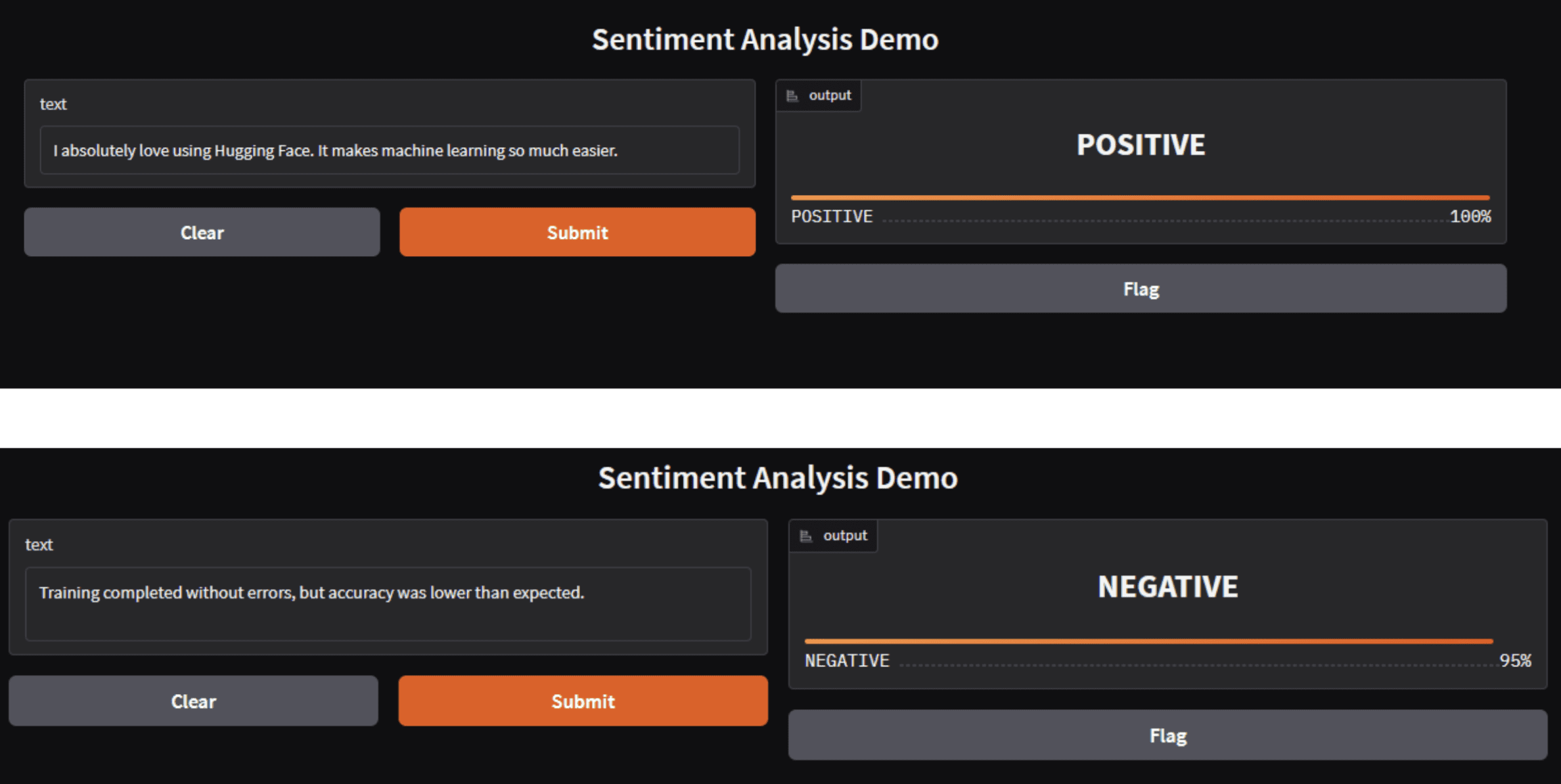

# Erstellen einer interaktiven Demo mit Gradio

import gradio as gr

from transformers import pipeline

classifier = pipeline("sentiment-analysis")

def predict(textual content):

outcome = classifier(textual content)(0) # extract first merchandise

return {outcome("label"): outcome("rating")}

demo = gr.Interface(

fn=predict,

inputs=gr.Textbox(label="Enter textual content"),

outputs=gr.Label(label="Sentiment"),

title="Sentiment Evaluation Demo"

)

demo.launch()Sie können diesen Code ausführen, indem Sie ihn ausführen Python gefolgt vom Dateinamen. In meinem Fall ist es so python demo.py Dadurch kann es heruntergeladen werden, und Sie erhalten unten etwas in der Artwork.

Bild vom Autor

Dieselbe App kann direkt als Hugging Face House bereitgestellt werden.

Beachten Sie das umarmende Gesicht

pipelinesGeben Sie Vorhersagen als Pay attention zurück, auch für einzelne Eingaben. Bei der Integration mit Gradio Etikett Komponente müssen Sie das erste Ergebnis extrahieren und entweder eine Zeichenfolgenbezeichnung oder ein Wörterbuch zurückgeben, das Bezeichnungen den Konfidenzwerten zuordnet. Wenn dies nicht umgesetzt wird, führt dies zu einem Wertfehler aufgrund einer Nichtübereinstimmung der Ausgabetypen.

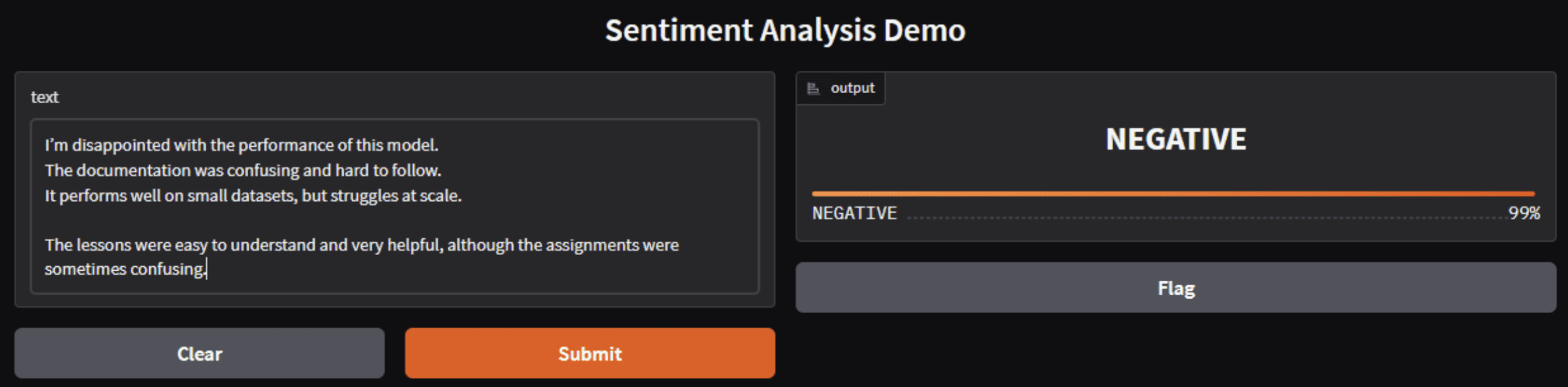

Bild vom Autor

Hugging-Face-Sentiment-Modelle klassifizieren eher den gesamten emotionalen Ton als individuelle Meinungen. Wenn detrimental Signale stärker oder häufiger sind als constructive, sagt das Modell eine detrimental Stimmung selbst dann zuverlässig voraus, wenn positives Suggestions vorhanden ist.

Sie fragen sich vielleicht, warum Entwickler und Organisationen Hugging Face verwenden. Nun, hier sind einige der Gründe:

- Standardisierung: Hugging Face bietet konsistente APIs und Schnittstellen, die die Artwork und Weise verknüpfen, wie Modelle über Sprachen und Aufgaben hinweg geteilt und genutzt werden.

- Neighborhood-Zusammenarbeit: Die offene Governance der Plattform fördert Beiträge von Forschern, Pädagogen und Branchenentwicklern, beschleunigt Innovationen und ermöglicht von der Neighborhood vorangetriebene Verbesserungen an Modellen und Datensätzen.

- Demokratisierung: Durch die Bereitstellung benutzerfreundlicher Instruments und vorgefertigter Modelle wird die KI-Entwicklung für Lernende und Organisationen ohne große Rechenressourcen zugänglicher.

- Unternehmenstaugliche Lösungen: Hugging Face bietet Unternehmensfunktionen wie non-public Modell-Hubs, rollenbasierte Zugriffskontrolle und Plattformunterstützung, die für regulierte Branchen wichtig sind.

# Berücksichtigung von Herausforderungen und Einschränkungen

Während Hugging Face viele Teile des Lebenszyklus des maschinellen Lernens vereinfacht, sollten Entwickler Folgendes beachten:

- Komplexität der Dokumentation: Je größer die Instruments werden, desto unterschiedlicher ist die Dokumentation; Einige erweiterte Funktionen erfordern möglicherweise eine eingehendere Untersuchung, um sie richtig zu verstehen. (Das Neighborhood-Suggestions weist auf eine gemischte Dokumentationsqualität in Teilen des Ökosystems hin.)

- Modellentdeckung: Bei Millionen von Modellen im Hub sind oft sorgfältige Filter- und semantische Suchansätze erforderlich, um das richtige Modell zu finden.

- Ethik und Lizenzierung: Offene Repositories können die Nutzung von Inhalten und die Lizenzierung vor Herausforderungen stellen, insbesondere bei von Benutzern hochgeladenen Datensätzen, die möglicherweise proprietäre oder urheberrechtlich geschützte Inhalte enthalten. Eine wirksame Governance und Sorgfalt bei der Kennzeichnung von Lizenzen und beabsichtigten Anwendungsfällen sind von wesentlicher Bedeutung.

# Abschließende Bemerkungen

Im Jahr 2026 gilt Hugging Face als Eckpfeiler der offenen KI-Entwicklung und bietet ein reichhaltiges Ökosystem, das Forschung und Produktion umfasst. Die Kombination aus Neighborhood-Beiträgen, Open-Supply-Instruments, gehosteten Diensten und kollaborativen Arbeitsabläufen hat die Artwork und Weise, wie Entwickler und Organisationen an maschinelles Lernen herangehen, verändert. Egal, ob Sie modernste Modelle trainieren, KI-Apps bereitstellen oder an einer globalen Forschungsinitiative teilnehmen, Hugging Face bietet die Infrastruktur und Neighborhood, um Innovationen zu beschleunigen.

Shittu Olumid ist ein Software program-Ingenieur und technischer Autor, der sich leidenschaftlich dafür einsetzt, modernste Technologien zu nutzen, um fesselnde Erzählungen zu erschaffen, mit einem scharfen Blick fürs Element und einem Gespür für die Vereinfachung komplexer Konzepte. Sie können Shittu auch auf finden Twitter.