Und mittlere Unternehmen erzielen Erfolg beim Aufbau von Daten und ML -Plattformen. Aufbau von KI -Plattformen ist jetzt zutiefst herausfordernd. In diesem Beitrag werden drei wichtige Gründe erörtert, warum Sie vorsichtig sein sollten, um KI -Plattformen zu erstellen, und schlägt stattdessen meine Gedanken über vielversprechende Richtungen vor.

Haftungsausschluss: Es basiert auf persönlichen Ansichten und gilt nicht für Cloud -Anbieter und Daten/ML -SaaS -Unternehmen. Sie sollten stattdessen die Forschung von AI -Plattformen verdoppeln.

Woher ich komme

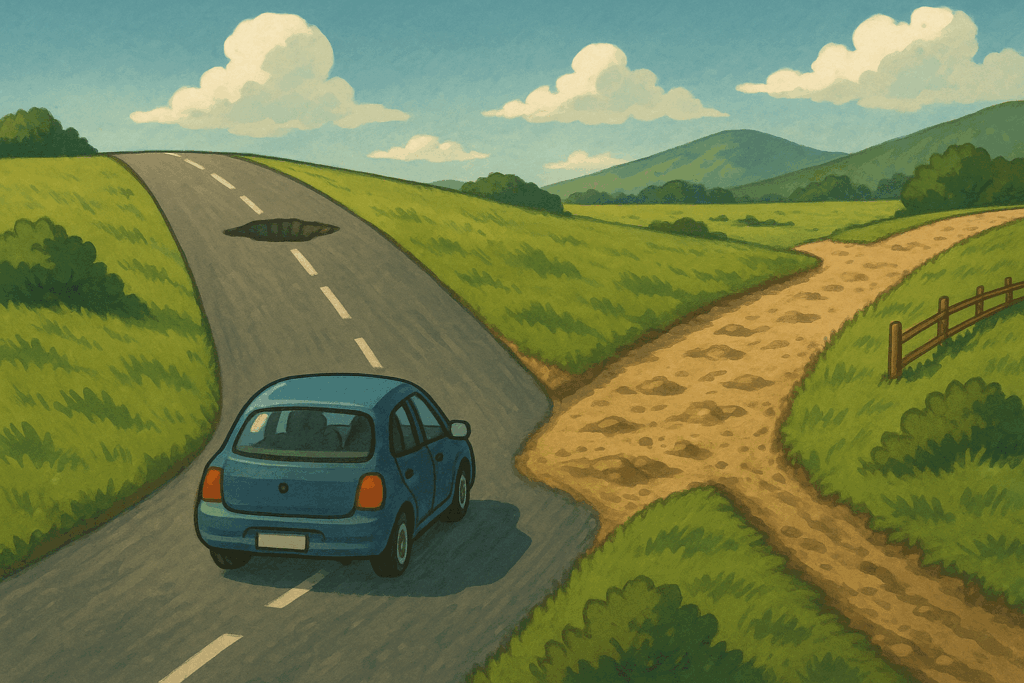

In meinem vorherigen Artikel Von der Datenplattform zur ML -Plattform In Richtung Information Science habe ich geteilt, wie sich eine Datenplattform zu einer ML -Plattform entwickelt. Diese Reise gilt für die meisten kleinen und mittelgroßen Unternehmen. Es gab jedoch keinen klaren Weg für kleine und mittlere Unternehmen, ihre Plattformen weiter auf AI-Plattformen zu entwickeln noch. Auf AI -Plattformen gaben der Pfad in zwei Richtungen ein:

- AI -Infrastruktur: Der „neue Strom“ (KI -Inferenz) ist bei der zentralen Erstellung effizienter. Es ist ein Spiel für große Techniker und große Modellanbieter.

- AI -Anwendungsplattform: Auf ständig wechselnden Boden kann das „Strandhaus“ (AI -Plattform) nicht bauen. Das sich entwickelnde KI -Fähigkeit und das aufkommende neue Entwicklungsparadigma machen die Feststellung einer dauerhaften Standardisierung herausfordernd.

Es gibt jedoch immer noch Anweisungen, die auch bei der Entwicklung von KI -Modellen wahrscheinlich wichtig bleiben. Es ist am Ende dieses Beitrags abgedeckt.

Hohe Barriere der AI -Infrastruktur

Während Databricks vielleicht nur mehrmals besser sind als Ihre eigenen Funkenjobs, könnte Deepseek bei LLM -Abschluss 100x effizienter sein als Sie. Das Coaching und das Servieren eines LLM -Modells erfordern erheblich mehr Investitionen in die Infrastruktur und die Kontrolle über die Struktur des LLM -Modells.

In Diese SerieIch teilte kurz die Infrastruktur für LLM -Schulungen, einschließlich der Einbeziehung Parallele TrainingsstrategienAnwesend Topologie -DesignsUnd Trainingsbeschleunigungen. Auf der Hardwareseite galt neben dem Hochleistungs-GPUs und TPUs ein erheblicher Teil der Kosten für Networking-Setup- und Hochleistungsspeicherdienste. Cluster benötigen ein zusätzliches RDMA-Netzwerk, um nicht blockierende, Punkt-zu-Punkt-Verbindungen für den Datenaustausch zwischen Instanzen zu ermöglichen. Die Orchestrierungsdienste müssen komplexe Stellenplanung, Failover -Strategien, Erkennung von {Hardware} sowie Abstraktion und Bündelung der GPU -Ressourcen unterstützen. Das Trainings -SDK muss asynchrone Prüfungen, Datenverarbeitung und Modellquantisierung erleichtern.

In Bezug auf das Modellieren von Modellbetreiber umfassen Modellanbieter häufig Inferenzeffizienz während der Modellentwicklungsstadien. Modellanbieter haben wahrscheinlich bessere Modellquantifizierungsstrategien, die die gleiche Modellqualität mit einer signifikant kleineren Modellgröße erzeugen würden. Modellanbieter entwickeln wahrscheinlich eine bessere Modell -Parallel -Strategie, da sie über die Modellstruktur übereinstimmen. Es kann die Chargengröße während der LLM -Inferenz erhöhen, was die GPU -Nutzung effektiv erhöht. Darüber hinaus haben große LLM -Spieler logistische Vorteile, mit denen sie günstigere Router, Mainframes und GPU -Chips zugreifen können. Noch wichtiger ist, dass eine stärkere Steuerung der Modellstruktur und bessere Modellanbieter von Modellanbietern mit Parallelfunktionen billigere GPU -Geräte nutzen können. Für Modellverbraucher, die sich auf Open-Supply-Modelle verlassen, könnte die GPU-Abschaltung ein größeres Drawback sein.

Nehmen Sie Deepseek R1 als Beispiel. Nehmen wir an, Sie verwenden p5e.48xLarge AWS -Instanz, die 8 H200 -Chips mit verbundenem NVLink anbieten. Es wird dich kosten 35 $ professional Stunde. Vorausgesetzt, Sie machen es ebenso wie Nvidia und erreichen Sie 151 Token/zweite Leistung. Um 1 Million Output -Token zu generieren, kosten Sie 64 US -Greenback (1 Million / (151 * 3600) * $ 35). Wie viel verkauft Deepseek das Token bei professional Million? Nur 2 $! Deepseek kann das 60 -fache der Effizienz Ihrer Cloud -Bereitstellung erreichen (unter der Annahme von Deepseek).

LLM Inferenzleistung ist additionally in der Tat Elektrizität. Es spiegelt die Vielfalt der Anwendungen wider, die LLMs mit Strom versorgen können. Dies impliziert auch, dass es bei zentraler Erzeugung am effizientesten ist. Trotzdem sollten Sie LLM-Dienste für Privatsphäre immer noch selbsthostere Anwendungsfälle selbst veranstalten, genau wie Krankenhäuser ihre Stromerzeuger für Notfälle haben.

Ständig wechselndem Boden

Die Investition in die AI -Infrastruktur ist ein mutiges Spiel, und das Aufbau von leichten Plattformen für AI -Anwendungen ist mit seinen versteckten Fallstricken ausgestattet. Mit der schnellen Entwicklung der KI -Modellfähigkeiten gibt es kein ausgerichtetes Paradigma für AI -Anwendungen. Daher fehlen eine solide Grundlage für den Bau von AI -Anwendungen.

Die einfache Antwort darauf ist: Sei geduldig.

Wenn wir eine ganzheitliche Sicht auf Daten- und ML -Plattformen haben, treten Entwicklungsparadigmen nur dann auf, wenn die Funktionen von Algorithmen konvergieren.

| Domänen | Algorithmus entsteht | Lösung entstehen | Große Plattformen tauchen auf |

| Datenplattform | 2004 – MapReduce (Google) | 2010–2015 – Funke, Flink, Presto, Kafka | 2020 – jetzt – Datenbank, Schneeflocke |

| ML -Plattform | 2012 – ImageNet (Alexnet, CNN Durchbruch) | 2015–2017 -Tensorflow, Pytorch, Scikit-Study | 2018 – jetzt – Sagemaker, Mlflow, Kubeflow, Databricks ML |

| KI -Plattform | 2017 – Transformatoren (Aufmerksamkeit ist alles, was Sie brauchen) | 2020–2022 – Chatgpt, Claude, Gemini, Deepseek | 2023 – Nun – ?? |

Nach mehreren Jahren heftiger Wettbewerb stehen noch einige große Modelspieler in der Enviornment. Die Entwicklung der KI -Fähigkeit ist jedoch noch nicht konvergiert. Mit der Weiterentwicklung der Fähigkeiten der KI -Modelle wird das bestehende Entwicklungsparadigma schnell veraltet. Große Spieler haben gerade begonnen, ihren Stich auf Agent -Entwicklungsplattformen zu machen, und neue Lösungen tauchen in einem Ofen wie Popcorn auf. Die Gewinner werden irgendwann erscheinen, glaube ich. Derzeit ist die Standardisierung der Bauagenten selbst ein schwieriger Aufruf für kleine und mittelgroße Unternehmen.

Pfadabhängigkeit des alten Erfolgs

Eine weitere Herausforderung beim Aufbau einer KI -Plattform ist ziemlich subtil. Es geht darum, die Denkweise der Plattformbauer widerzuspiegeln, unabhängig davon, ob sie die Pfadabhängigkeit vom vorherigen Erfolg des Erbaus von Daten und ML -Plattformen haben.

Wie wir zuvor geteilt haben, sind die Daten- und ML-Entwicklungsparadigmen seit 2017 intestine ausgerichtet, und die kritischste Aufgabe für die ML-Plattform ist die Standardisierung und Abstraktion. Das Entwicklungsparadigma für AI -Anwendungen ist jedoch noch nicht festgestellt. Wenn das Staff der vorherigen Erfolgsgeschichte des Erstellens einer Daten- und ML -Plattform folgt, werden möglicherweise die Standardisierung zur falschen Zeit priorisieren. Mögliche Anweisungen sind:

- Erstellen Sie ein KI -Modell -Gateway: Geben Sie LLM -Modellen mit zentraler Prüfung und Protokollierung von Anfragen an.

- Erstellen eines AI-Agenten-Frameworks: Entwickeln Sie ein selbstgebaues SDK, um KI-Agenten mit verbesserter Konnektivität zum internen Ökosystem zu erstellen.

- Standardisieren Sie Lag -Praktiken: Erstellen eines Standarddatenindexierungsflusss, um die Balken für Ingenieur -Construct -Information Providers zu senken.

Diese Initiativen können in der Tat signifikant sein. Aber der ROI hängt wirklich von der Skala Ihres Unternehmens ab. Unabhängig davon haben Sie die folgenden Herausforderungen:

- Halten Sie die neuesten KI -Entwicklungen auf dem Laufenden.

- Kundenakaditionsrate, wenn es für Kunden einfach ist, Ihre Abstraktion zu umgehen.

Angenommen, die Bauherren von Daten und ML -Plattformen sind wie „Closet -Organisatoren“, und KI -Bauherren sollten sich jetzt wie „Modedesigner“ verhalten. Es erfordert es, neue Ideen anzunehmen, schnelle Experimente durchzuführen und sogar ein Maß an Unvollkommenheit zu akzeptieren.

Meine Gedanken über vielversprechende Richtungen

Obwohl so viele Herausforderungen vor sich sind, werden Sie bitte daran erinnert, dass es immer noch erfreulich ist, jetzt auf der KI -Plattform zu arbeiten, da Sie einen erheblichen Hebelwirkung haben, der vorher nicht vorhanden struggle:

- Die Transformationsfähigkeit von KI ist erheblicher als die von Daten und maschinellem Lernen.

- Die Motivation, KI zu übernehmen, ist viel wirksamer als je zuvor.

Wenn Sie die richtige Richtung und Strategie auswählen, ist die Transformation, die Sie in Ihr Unternehmen bringen können, erheblich. Hier sind einige meiner Gedanken zu Richtungen, die weniger Störungen aufweisen könnten, wenn das KI -Modell weiter skaliert wird. Ich denke, sie sind mit AI -Plattform gleichermaßen wichtig:

- Hochwertige, reich-semantische Datenprodukte: Datenprodukte mit hoher Genauigkeit und Rechenschaftspflicht, reichhaltigen Beschreibungen und vertrauenswürdigen Metriken werden mit dem Wachstum von AI-Modellen mehr Auswirkungen „ausstrahlen“.

- Multi-Modal-Daten Servieren: OLTP, OLAP, NoSQL und Elasticsearch, ein skalierbarer Wissensdienst hinter dem MCP-Server, benötigen möglicherweise mehrere Arten von Datenbanken, um Hochleistungsdaten zu unterstützen. Es ist schwierig, eine einzige Quelle der Wahrheit und Leistung mit ständigen Reverse ETL -Jobs aufrechtzuerhalten.

- AI DevOps: AI-zentrierte Softwareentwicklung, Wartung und Analyse. Die Genauigkeit der Code-Era wird in den letzten 12 Monaten stark erhöht.

- Experimentieren und Überwachung: Angesichts der erhöhten Unsicherheit der AI -Anwendungen sind die Bewertung und Überwachung dieser Anwendungen noch kritischer.

Dies sind meine Gedanken zum Aufbau von KI -Plattformen. Bitte lassen Sie mich auch Ihre Gedanken darüber wissen. Prost!