AMD hat in dieser Woche bei ihrem fortschreitenden AI 2025-Occasion eine Reihe von Nachrichten veröffentlicht, ein Replace über die Reaktion des Unternehmens auf NVIDIAs 90-prozent-Marktanteilsdominanz in den GPU- und KI-Märkten. Und das Unternehmen bot einen Sneak Peak an, was sie von der nächsten Technology von EPYC -CPUs und Instinkt -GPUs erwarten würde.

Hier ist ein Überblick über die wichtigste Ankündigung von AMD:

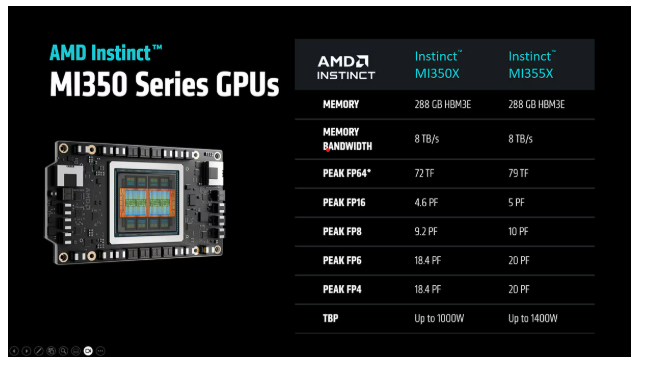

AMD MI350 -Serie GPUs

Die Ankündigung der Schlagzeile: AMD startete die Intuition MI350-Serie, die sie sagten, bis zu 4-fache Generationen-Technology-KI-Berechnungsverbesserungen und bis zu einem 35-fachen-Sprung in der Inferenzleistung.

Sie bieten eine Speicherkapazität von 288 GB HBM3E und Bandbreite von bis zu 8 TB/s zusammen mit luftgekühlten und direkt flüssigen Konfigurationen.

Und sie unterstützen bis zu 64 GPUs in einem luftgekühlten Rack und bis zu 128 GPUs in direkten flüssiggekühlten Racks und liefert bis zu 2,6 Exaflops FP4/FP6-Leistung in einer in Branchenstandards basierenden Infrastruktur.

AMD -CEO Lisa Su

„Mit der MI350 -Serie liefern wir den größten Generationsleistungsprung in der Geschichte des Instinkts und wir sind bereits tief in der Entwicklung von MI400 für 2026.“ Der CEO von AMD, Dr. Lisa Su, sagte. „(Der MI400) ist wirklich von Grund auf als Lösung auf Rackebene ausgestattet.“

In dieser Entrance kündigte AMD seine im nächsten Jahr erhältliche „Helios“ -Skala -Architektur „Helios“ an, die eine Kombination aus der nächsten Technology von AMD -Technologie integrieren wird, einschließlich:

- Der nächste Technology AMD Intuition MI400-Serien-GPUs, der voraussichtlich bis zu 432 GB HBM4-Speicher, 40 Petaflops mit FP4-Leistung und 300 Gigabyte professional Sekunde der Skala-Out-Bandbreite3 anbieten.

- Helios Leistungsskala über 72 GPUs unter Verwendung des offenen Customary-UALINK (Extremely Accelerator Hyperlink), um die GPUs und die NICs aus dem Scale-out zu verbinden. Dies ist so konzipiert, dass jede GPU im Rack als ein einheitliches System kommuniziert.

- Die 6. Gen AMD EPYC „Venice“ CPUs, die die Architektur „Zen 6“ nutzt und voraussichtlich bis zu 256 Kerne anbieten, bis zu 1,7 -fach die Leistung und 1,6 EL Speicherbandbreite.

- AMD Pensando „Vulcano“ AI NICS, das UEC (Extremely -Ethernet -Konsortium) 1.0 -konform ist und sowohl PCIe- als auch Ualink -Schnittstellen für die Konnektivität zu CPUs und GPUs unterstützt. Es wird auch den 800G-Netzwerkdurchsatz und einen erwarteten 8-fachen der Skala-Out-Bandbreite professional GPU3 im Vergleich zur vorherigen Technology unterstützen.

ROCM 7 und Entwicklerwolke

Ein großer Vorteil für NVIDIA ist die Dominanz der Softwareentwicklungs -Enviornment – die überwiegende Mehrheit der AI -Anwendungsentwickler nutzt die CUDA -Programmierplattform von NVIDIA. Entwickler, die CUDA in der Lage sind, neigen dazu, weiterhin… CUDA zu verwenden. Benutzer von Anwendungen, die auf CUDA basieren, neigen dazu, NVIDIA GPUs zu dienen. Zusammen mit der GPU -Leistung ist der Wettbewerb mit NVIDIA an der AI -Software program -Entrance eine große Herausforderung für alle, die versuchen, einen erheblichen Anteil am KI -Markt zu erzielen.

Diese Woche führte AMD AMD ROCM 7 und die AMD Developer Cloud unter dem ein, was das Unternehmen als „Entwickler First“ Mantra bezeichnete.

„Im vergangenen Jahr haben wir unseren Fokus auf die Verbesserung unserer Inferenz- und Schulungsfunktionen in den wichtigsten Modellen und Rahmenbedingungen und die Erweiterung unserer Kundenstamme verlagert“, sagte Anush Elangovan, VP von AI Software program, AMD, in einem Ankündigungsblog. „Führende Modelle wie Lama 4, Gemma 3 und Deepseek werden jetzt vom ersten Tag an unterstützt, und unsere Zusammenarbeit mit der Open-Supply-Group struggle noch nie stärker und unterstreicht unser Engagement für die Förderung eines zugänglichen und innovativen KI-Ökosystems.“

Elangovan betonte die Zugänglichkeit und Skalierbarkeit von ROCM 7, einschließlich „GPUs von Mi300x-Klasse in die Hände von Personen mit einer Github-ID… und die Set up von ROCM mit einer einfachen PIP-Set up… von Null zum Triton-Kernel-Pocket book in wenigen Minuten.“

Im Allgemeinen im zweiten Quartal 2025 liefert ROCM 7 mehr als 3,5x die Inferenzfähigkeit und 3x die Trainingsleistung im Vergleich zu ROCM 6. Dies beruht auf Fortschritten in der Benutzerfreundlichkeit, der Leistung und der Unterstützung von Datentypen mit niedrigerer Präzision wie FP4 und FP6, so Elangovan. ROCM 7 bietet auch einen „robusten Ansatz“ für verteilte Inferenz, das Ergebnis der Zusammenarbeit mit dem Open-Supply-Ökosystem, einschließlich Frameworks wie Sglang, Vllm und LLM-D.

AMDs ROCM Enterprise KI debütiert als MLOPS-Plattform für KI-Vorgänge in Unternehmenseinstellungen und umfasst Instruments für die Modellabstimmung mit branchenspezifischen Daten und die Integration mit strukturierten und unstrukturierten Workflows. AMD sagte, dies sei durch Partnerschaften „in unserem Ökosystem für die Entwicklung von Referenzanwendungen wie Chatbots und Dokumentenfassungen“ erleichtert.

Energieeffizienz im Rackmaßstab

Für das dringende Downside des Energiebedarfs, der die Energieversorgung übertrifft, überstieg AMD sein „30 × 25“ -Effizienzziel und erzielte einen Anstieg der Energieeffizienz auf Knotenebene für AI-Coaching und HPC um 38-fach.

Das Unternehmen legte außerdem ein Ziel von 2030 fest, um eine Energieeffizienz des Racks-Maßstabs aus einem Basisjahr von 2024 um 20-fachen zu erzielen, sodass ein typisches KI-Modell ermöglicht wird, das heute bis 2030 mehr als 275 Racks in weniger als einem Rack mit 95 Prozent weniger Strom ausgebildet werden muss.

Das Unternehmen legte außerdem ein Ziel von 2030 fest, um eine Energieeffizienz des Racks-Maßstabs aus einem Basisjahr von 2024 um 20-fachen zu erzielen, sodass ein typisches KI-Modell ermöglicht wird, das heute bis 2030 mehr als 275 Racks in weniger als einem Rack mit 95 Prozent weniger Strom ausgebildet werden muss.

In Kombination mit erwarteten Software program- und algorithmischen Fortschritten könnte AMD laut AMD eine Verbesserung der Gesamtenergieeffizienz von bis zu 100 -fachen ermöglichen.

AI -Infrastruktur der offenen Rack -Skala

AMD kündigte seine Rack-Architektur für KI an, die seine GPUs der 5. Gen-EPYC-CPUs, den Instinkt MI350-Serien und die Skala-Out-Networking-Lösungen wie AMD Pensando Pollara AI NIC, integriert, in ein Branchen-Open-Compute-Projekt- und Extremely-Ethernet-Konsortium-konforme Design integriert.

„Durch die Kombination aller unserer Hardwarekomponenten zu einer einzelnen Rack-Lösung ermöglichen wir eine neue Klasse differenzierter Hochleistungs-KI-Infrastruktur sowohl in flüssigen als auch in luftgekühlten Konfigurationen“, sagte AMD.