Angenommen, jemand nimmt seine französische Bulldogge Bowser mit in den Hundepark. Bowser zu identifizieren, während er mit den anderen Hunden spielt, ist für den Hundebesitzer vor Ort leicht zu erkennen.

Wenn jemand jedoch ein generatives KI-Modell wie GPT-5 verwenden möchte, um sein Haustier während der Arbeit zu überwachen, könnte das Modell bei dieser grundlegenden Aufgabe scheitern. Imaginative and prescient-Language-Modelle wie GPT-5 sind oft hervorragend darin, allgemeine Objekte wie einen Hund zu erkennen, aber sie sind schlecht darin, personalisierte Objekte wie Bowser, die Französische Bulldogge, zu lokalisieren.

Um dieses Manko zu beheben, haben Forscher des MIT und des MIT-IBM Watson AI Lab eine neue Trainingsmethode eingeführt, die visuellen Sprachmodellen beibringt, personalisierte Objekte in einer Szene zu lokalisieren.

Ihre Methode nutzt sorgfältig aufbereitete Video-Monitoring-Daten, bei denen dasselbe Objekt über mehrere Bilder hinweg verfolgt wird. Sie haben den Datensatz so entworfen, dass sich das Modell auf kontextbezogene Hinweise konzentrieren muss, um das personalisierte Objekt zu identifizieren, anstatt sich auf zuvor gespeichertes Wissen zu verlassen.

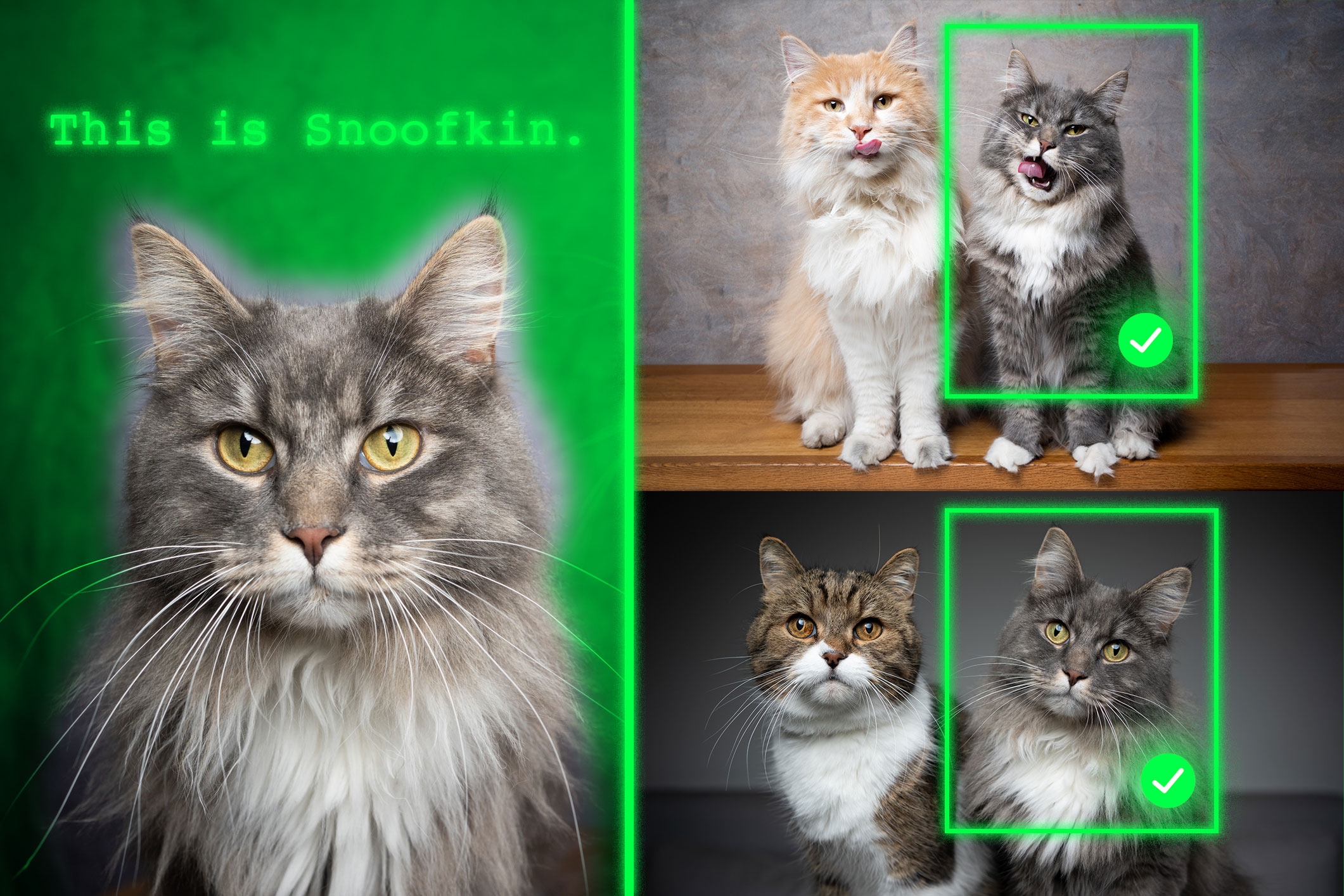

Anhand einiger Beispielbilder, die ein personalisiertes Objekt, beispielsweise das Haustier einer anderen Individual, zeigen, kann das neu trainierte Modell den Standort dieses Haustiers in einem neuen Bild besser identifizieren.

Modelle, die mit ihrer Methode neu trainiert wurden, übertrafen bei dieser Aufgabe modernste Systeme. Wichtig ist, dass ihre Technik die restlichen allgemeinen Fähigkeiten des Modells intakt lässt.

Dieser neue Ansatz könnte künftigen KI-Systemen dabei helfen, bestimmte Objekte im Laufe der Zeit zu verfolgen, beispielsweise den Rucksack eines Kindes, oder interessante Objekte, beispielsweise eine Tierart, im Rahmen der ökologischen Überwachung zu lokalisieren. Es könnte auch bei der Entwicklung KI-gesteuerter Hilfstechnologien helfen, die sehbehinderten Benutzern dabei helfen, bestimmte Gegenstände in einem Raum zu finden.

„Letztendlich möchten wir, dass diese Modelle in der Lage sind, aus dem Kontext zu lernen, genau wie Menschen. Wenn ein Modell dies intestine kann, anstatt es für jede neue Aufgabe neu zu trainieren, könnten wir einfach ein paar Beispiele liefern und es würde aus diesem Kontext ableiten, wie die Aufgabe ausgeführt werden soll. Das ist eine sehr mächtige Fähigkeit“, sagt Jehanzeb Mirza, Postdoktorand am MIT und leitender Autor eines Buches Papier über diese Technik.

Mirza wird bei dem Artikel von den Co-Hauptautoren Sivan Doveh, einem Doktoranden am Weizmann Institute of Science, unterstützt; und Nimrod Shabtay, ein Forscher bei IBM Analysis; James Glass, leitender Forschungswissenschaftler und Leiter der Spoken Language Methods Group am MIT Pc Science and Synthetic Intelligence Laboratory (CSAIL); und andere. Die Arbeit wird auf der Worldwide Convention on Pc Imaginative and prescient vorgestellt.

Ein unerwartetes Manko

Forscher haben herausgefunden, dass große Sprachmodelle (LLMs) hervorragend aus dem Kontext lernen können. Wenn sie ein LLM mit einigen Beispielen einer Aufgabe versorgen, beispielsweise mit Additionsproblemen, kann es lernen, neue Additionsprobleme auf der Grundlage des bereitgestellten Kontexts zu beantworten.

Ein Imaginative and prescient-Language-Modell (VLM) ist im Wesentlichen ein LLM mit einer damit verbundenen visuellen Komponente. Daher gingen die MIT-Forscher davon aus, dass es die kontextbezogenen Lernfähigkeiten des LLM erben würde. Dies ist jedoch nicht der Fall.

„Für dieses spezielle Downside konnte die Forschungsgemeinschaft bisher keine einheitliche Antwort finden. Der Engpass könnte darin liegen, dass beim Zusammenführen der beiden Komponenten einige visuelle Informationen verloren gehen, aber wir wissen es einfach nicht“, sagt Mirza.

Ziel der Forscher struggle es, die Fähigkeiten von VLM zur kontextbezogenen Lokalisierung zu verbessern, bei der es darum geht, ein bestimmtes Objekt in einem neuen Bild zu finden. Sie konzentrierten sich auf die Daten, die verwendet wurden, um bestehende VLMs für eine neue Aufgabe neu zu trainieren, ein Prozess namens Feinabstimmung.

Typische Feinabstimmungsdaten werden aus zufälligen Quellen gesammelt und stellen Sammlungen von Alltagsgegenständen dar. Ein Bild könnte auf einer Straße geparkte Autos zeigen, während ein anderes einen Blumenstrauß zeigt.

„Es gibt keine wirkliche Kohärenz in diesen Daten, daher lernt das Modell nie, dasselbe Objekt in mehreren Bildern zu erkennen“, sagt er.

Um dieses Downside zu beheben, entwickelten die Forscher einen neuen Datensatz, indem sie Proben aus vorhandenen Video-Monitoring-Daten kuratierten. Bei diesen Daten handelt es sich um Videoclips, die dasselbe Objekt zeigen, wie es sich durch eine Szene bewegt, etwa einen Tiger, der über eine Wiese läuft.

Sie schnitten Einzelbilder aus diesen Movies aus und strukturierten den Datensatz so, dass jede Eingabe aus mehreren Bildern bestand, die dasselbe Objekt in unterschiedlichen Kontexten zeigten, mit Beispielfragen und Antworten zu seinem Standort.

„Durch die Verwendung mehrerer Bilder desselben Objekts in unterschiedlichen Kontexten ermutigen wir das Modell, das interessierende Objekt konsequent zu lokalisieren, indem wir uns auf den Kontext konzentrieren“, erklärt Mirza.

Den Fokus erzwingen

Doch die Forscher fanden heraus, dass VLMs zum Schummeln neigen. Anstatt auf der Grundlage von Kontexthinweisen zu antworten, identifizieren sie das Objekt anhand der im Vortraining gewonnenen Erkenntnisse.

Da das Modell beispielsweise bereits gelernt hat, dass ein Bild eines Tigers und die Bezeichnung „Tiger“ korrelieren, könnte es den Tiger, der das Grasland überquert, anhand dieses vorab trainierten Wissens identifizieren, anstatt Rückschlüsse aus dem Kontext zu ziehen.

Um dieses Downside zu lösen, verwendeten die Forscher Pseudonamen anstelle tatsächlicher Objektkategorienamen im Datensatz. In diesem Fall änderten sie den Namen des Tigers in „Charlie“.

„Es hat eine Weile gedauert, bis wir herausgefunden haben, wie wir verhindern können, dass das Modell betrügt. Aber wir haben die Spielregeln für das Modell geändert. Das Modell weiß nicht, dass ‚Charlie‘ ein Tiger sein kann, additionally ist es gezwungen, den Kontext zu betrachten“, sagt er.

Die Forscher standen auch vor der Herausforderung, den besten Weg zur Aufbereitung der Daten zu finden. Wenn die Frames zu nah beieinander liegen, würde sich der Hintergrund nicht ausreichend verändern, um für Datenvielfalt zu sorgen.

Letztendlich verbesserte die Feinabstimmung von VLMs mit diesem neuen Datensatz die Genauigkeit der personalisierten Lokalisierung um durchschnittlich etwa 12 Prozent. Als sie den Datensatz mit Pseudonamen einschlossen, erreichten die Leistungssteigerungen 21 Prozent.

Mit zunehmender Modellgröße führt ihre Technik zu größeren Leistungssteigerungen.

In Zukunft wollen die Forscher mögliche Gründe untersuchen, warum VLMs nicht die kontextbezogenen Lernfähigkeiten von ihren Foundation-LLMs erben. Darüber hinaus planen sie die Erforschung zusätzlicher Mechanismen, um die Leistung eines VLM zu verbessern, ohne es mit neuen Daten neu trainieren zu müssen.

„Diese Arbeit definiert die personalisierte Objektlokalisierung mit wenigen Aufnahmen – die sich im laufenden Betrieb an das gleiche Objekt in neuen Szenen anpasst – als ein Downside der Befehlsabstimmung und verwendet Videoverfolgungssequenzen, um VLMs beizubringen, die Lokalisierung auf der Grundlage des visuellen Kontexts und nicht anhand von Klassenprioritäten zu lokalisieren. Außerdem wird der erste Benchmark für diese Einstellung mit soliden Vorteilen gegenüber offenen und proprietären VLMs eingeführt. Angesichts der immensen Bedeutung einer schnellen, instanzspezifischen Erdung – oft ohne Feinabstimmung – für Benutzer.“ „In Bezug auf reale Arbeitsabläufe (z. B. Robotik, Augmented-Actuality-Assistenten, kreative Instruments usw.) kann das praktische, datenzentrierte Rezept, das diese Arbeit bietet, dazu beitragen, die weit verbreitete Einführung von Imaginative and prescient-Language-Grundmodellen zu fördern“, sagt Saurav Jha, Postdoktorand am Mila-Quebec Synthetic Intelligence Institute, der nicht an dieser Arbeit beteiligt struggle.

Weitere Co-Autoren sind Wei Lin, wissenschaftlicher Mitarbeiter an der Johannes Kepler Universität; Eli Schwartz, Forschungswissenschaftler bei IBM Analysis; Hilde Kühne, Professorin für Informatik am Tuebingen AI Heart und außerordentliche Professorin am MIT-IBM Watson AI Lab; Raja Giryes, außerordentlicher Professor an der Universität Tel Aviv; Rogerio Feris, leitender Wissenschaftler und Supervisor am MIT-IBM Watson AI Lab; Leonid Karlinsky, leitender Forschungswissenschaftler bei IBM Analysis; Assaf Arbelle, leitender Forschungswissenschaftler bei IBM Analysis; und Shimon Ullman, Samy und Ruth Cohn Professor für Informatik am Weizmann Institute of Science.

Diese Forschung wurde teilweise vom MIT-IBM Watson AI Lab finanziert.