Wenn Sie jemals einen Urlaub anhand von Fotos, einer Sprachnotiz und einer kurzen Skizze erklärt haben, haben Sie es bereits verstanden multimodale KI: Systeme, die aus Textual content, Bildern, Audio – sogar Video – lernen und daraus Schlüsse ziehen, um Antworten mit mehr Kontext zu liefern. Führende Analysten beschreiben es als KI, die „verschiedene Arten von Informationen gleichzeitig versteht und verarbeitet“ und damit umfassendere Ergebnisse ermöglicht als Systeme mit nur einer Modalität. McKinsey & Firm

Kurze Analogie: Stellen Sie sich unimodale KI wie einen großartigen Pianisten vor; multimodale KI ist die volle Bandbreite. Jedes Instrument ist wichtig – aber es ist die Fusion, die die Musik ausmacht.

Was ist multimodale KI?

Im Kern bringt multimodale KI mehrere „Sinne“ zusammen. Ein Mannequin könnte ein Produktfoto (Imaginative and prescient), eine Kundenrezension (Textual content) und einen Unboxing-Clip (Audio) analysieren, um auf Qualitätsprobleme zu schließen. Definitionen aus Unternehmensleitfäden stimmen mit der Idee überein Modalitätsübergreifende Integration– nicht nur die Aufnahme vieler Eingaben, sondern auch das Erlernen der Beziehungen zwischen ihnen.

Multimodale vs. unimodale KI – was ist der Unterschied?

Führungskräfte kümmern sich darum, weil Kontext = Leistung: Das Verschmelzen von Signalen verbessert tendenziell die Relevanz und reduziert Halluzinationen bei vielen Aufgaben (wenn auch nicht überall). Neuere Erklärer bemerken diesen Wandel von „intelligenter Software program“ zu „fachkundigem Helfer“, wenn Modelle Modalitäten vereinheitlichen.

Multimodale KI-Anwendungsfälle, die Sie dieses Jahr versenden können

- Dokumentieren Sie KI mit Bildern und Textual content

Automatisieren Sie Versicherungsansprüche, indem Sie gescannte PDFs, Fotos und handschriftliche Notizen gemeinsam lesen. Ein Schadensbot, der die Delle sieht, die Schadensregulierernotiz liest und die Fahrgestellnummer überprüft, reduziert die manuelle Überprüfung. - Copiloten für den Kundensupport

Lassen Sie Agenten einen Screenshot, ein Fehlerprotokoll und eine Benutzer-Voicemail hochladen. Der Copilot richtet Signale aus, um Korrekturen vorzuschlagen und Antworten zu entwerfen. - Triage im Gesundheitswesen (mit Leitplanken)

Kombinieren Sie radiologische Bilder mit klinischen Notizen für erste Triage-Vorschläge (keine Diagnose). In Führungsbeiträgen wird das Gesundheitswesen angesichts des Datenreichtums und der Risiken als wichtigster Early Adopter hervorgehoben. - Visuelle Suche und Entdeckung im Einzelhandel

Benutzer machen ein Foto und beschreiben: „Wie diese Jacke, aber wasserdicht.“ Das System kombiniert Visionen mit Textpräferenzen, um Produkte zu bewerten. - Industrielle Qualitätssicherung

Kameras und akustische Sensoren kennzeichnen Anomalien in einer Produktionslinie und bringen ungewöhnliche Geräusche mit Mikrofehlern in Bildern in Zusammenhang.

Kurzgeschichte: Das Aufnahmeteam eines regionalen Krankenhauses nutzte eine Pilot-App, die ein Foto einer verschreibungspflichtigen Flasche, eine kurze Sprachnotiz und ein getipptes Symptom akzeptiert. Anstelle dreier separater Systeme vergleicht ein multimodales Modell die Dosierung, identifiziert wahrscheinliche Wechselwirkungen und markiert dringende Fälle für eine menschliche Überprüfung. Das Ergebnis warfare keine Zauberei – es reduzierte lediglich die Anzahl der Übergaben mit „verlorenem Kontext“.

Was hat sich in letzter Zeit geändert? Native multimodale Modelle

Ein sichtbarer Meilenstein warfare GPT-4o (Mai 2024)– ein nativ multimodales Modell, das Audio, Bild und Textual content in Echtzeit mit menschenähnlicher Latenz verarbeiten kann. Dieser „native“ Punkt ist wichtig: Weniger Klebeschichten zwischen den Modalitäten bedeuten im Allgemeinen eine geringere Latenz und eine bessere Ausrichtung.

Unternehmenserklärer aus dem Jahr 2025 untermauern dies Multimodal ist mittlerweile Mainstream in Produkt-Roadmaps, nicht nur in Forschungsdemos, und wecken die Erwartungen an die Argumentation über Formate hinweg.

Die unscheinbare Wahrheit: Daten sind der Burggraben

Multimodale Systeme brauchen gepaarte und hochvariable Daten: Bildunterschrift, Audiotranskript, Video-Aktionsetikett. Das Sammeln und Kommentieren im großen Maßstab ist schwierig – und genau hier scheitern viele Piloten.

Einschränkungen und Risiken: Was Führungskräfte wissen sollten

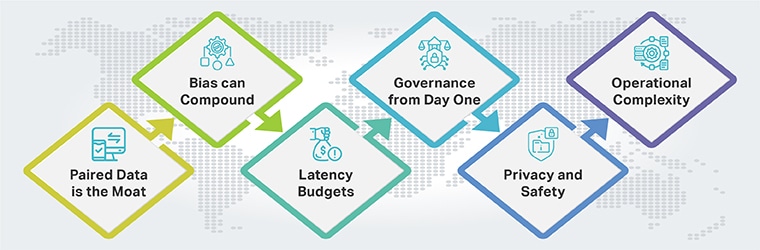

- Gepaarte Daten sind der Burggraben: Multimodale Systeme brauchen gepaarte Daten mit hoher Vielfalt (Bildunterschrift, Audiotranskript, Video-Aktionsetikett). Dies zu sammeln und zu kuratieren – ethisch und maßstabsgetreu – ist schwierig, weshalb viele Pilotprojekte zögern.

- Voreingenommenheit kann Folgendes verstärken: Zwei unvollständige Streams (Bild + Textual content) ergeben im Durchschnitt keinen neutralen Wert. Designbewertungen für jede Modalität und den Fusionsschritt.

- Latenzbudgets: Sobald Sie Bild/Audio hinzufügen, ändern sich Ihre Latenz- und Kostenprofile. Plan für Human-in-the-Loop und Caching in frühen Versionen.

- Governance vom ersten Tag an: Sogar ein kleiner Pilot profitiert von der Zuordnung von Risiken zu anerkannten Frameworks.

- Datenschutz und Sicherheit: Bilder/Audio können personenbezogene Daten preisgeben; Protokolle können vertraulich sein.

- Operative Komplexität: Die Instruments für die Aufnahme, Kennzeichnung und Qualitätssicherung mehrerer Formate sind noch ausgereift.

Wo Shaip in Ihre multimodale Roadmap passt

Erfolgreiche multimodale KI ist ein Datenproblem Erste. Shaip stellt die Trainingsdatendienste und Arbeitsabläufe bereit, um es Wirklichkeit werden zu lassen:

- Sammeln: Maßgeschneidert Sprach-/Audiodatensätze über Sprachen und Umgebungen hinweg.

- Etikett: Cross-modale Annotation für Bilder, Movies und Textual content mit strenger Qualitätssicherung. Sehen Sie sich unsere an Leitfaden zur multimodalen Etikettierung.

- Lernen: Praktische Perspektiven aus unserem Leitfaden für multimodale KI-Trainingsdaten– von Paarungsstrategien bis hin zu Qualitätsmetriken.