Das OpenAI-Crew hat seine veröffentlicht openai/circuit-sparsity Modell auf Hugging Face und dem openai/circuit_sparsity Toolkit auf GitHub. Die Veröffentlichung bündelt die Modelle und Schaltungen aus dem Papier ‚Transformatoren mit geringem Gewicht verfügen über interpretierbare Schaltkreise‚.

Was ist ein gewichtssparsamer Transformator??

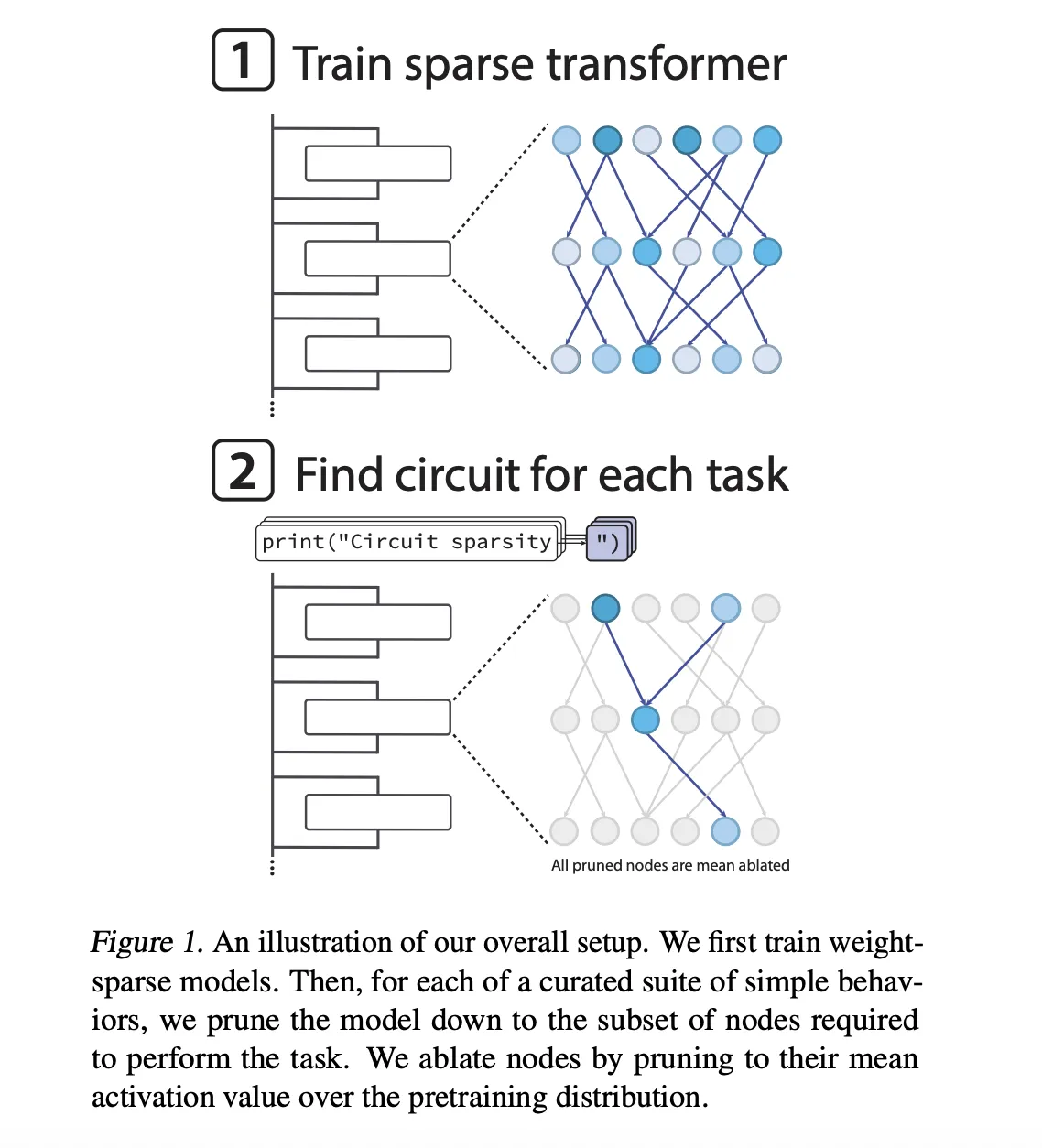

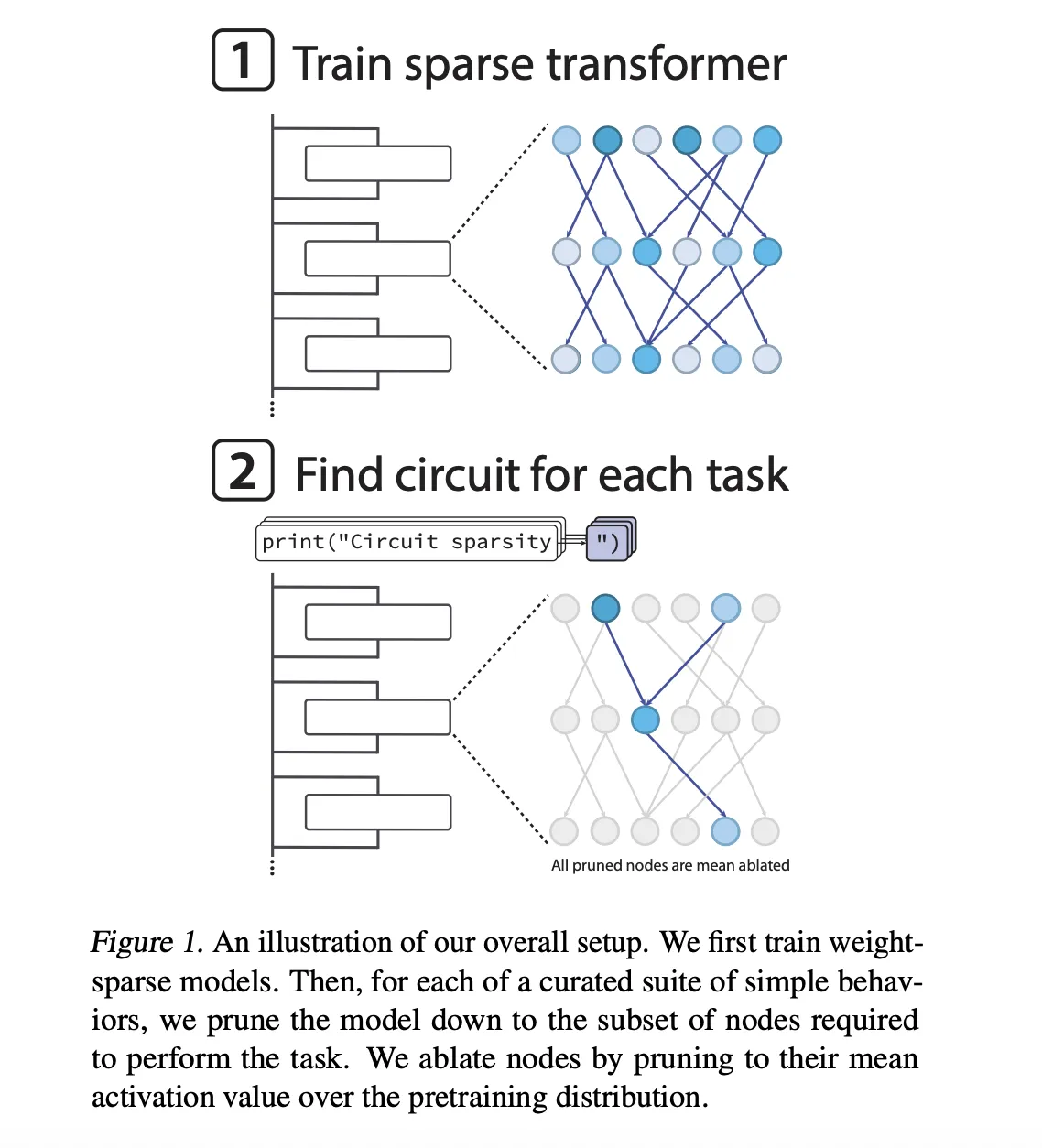

Bei den Modellen handelt es sich ausschließlich um GPT-2-Decoder-Transformatoren, die mit Python-Code trainiert wurden. Sparsity wird nicht nach dem Coaching hinzugefügt, sondern während der Optimierung erzwungen. Nach jedem AdamW-Schritt behält die Trainingsschleife nur die größten Größeneinträge in jeder Gewichtsmatrix und Bias, einschließlich Token-Einbettungen, und setzt den Relaxation auf Null. Alle Matrizen behalten den gleichen Anteil an Elementen ungleich Null bei.

Die spärlichsten Modelle haben ungefähr 1 von 1000 Gewichte ungleich Null. Darüber hinaus hat das OpenAI-Crew eine milde Aktivierungsparsity erzwungen, sodass etwa 1 von 4 Knotenaktivierungen sind ungleich Null und decken Restlesevorgänge, Restschreibvorgänge, Aufmerksamkeitskanäle und MLP-Neuronen ab.

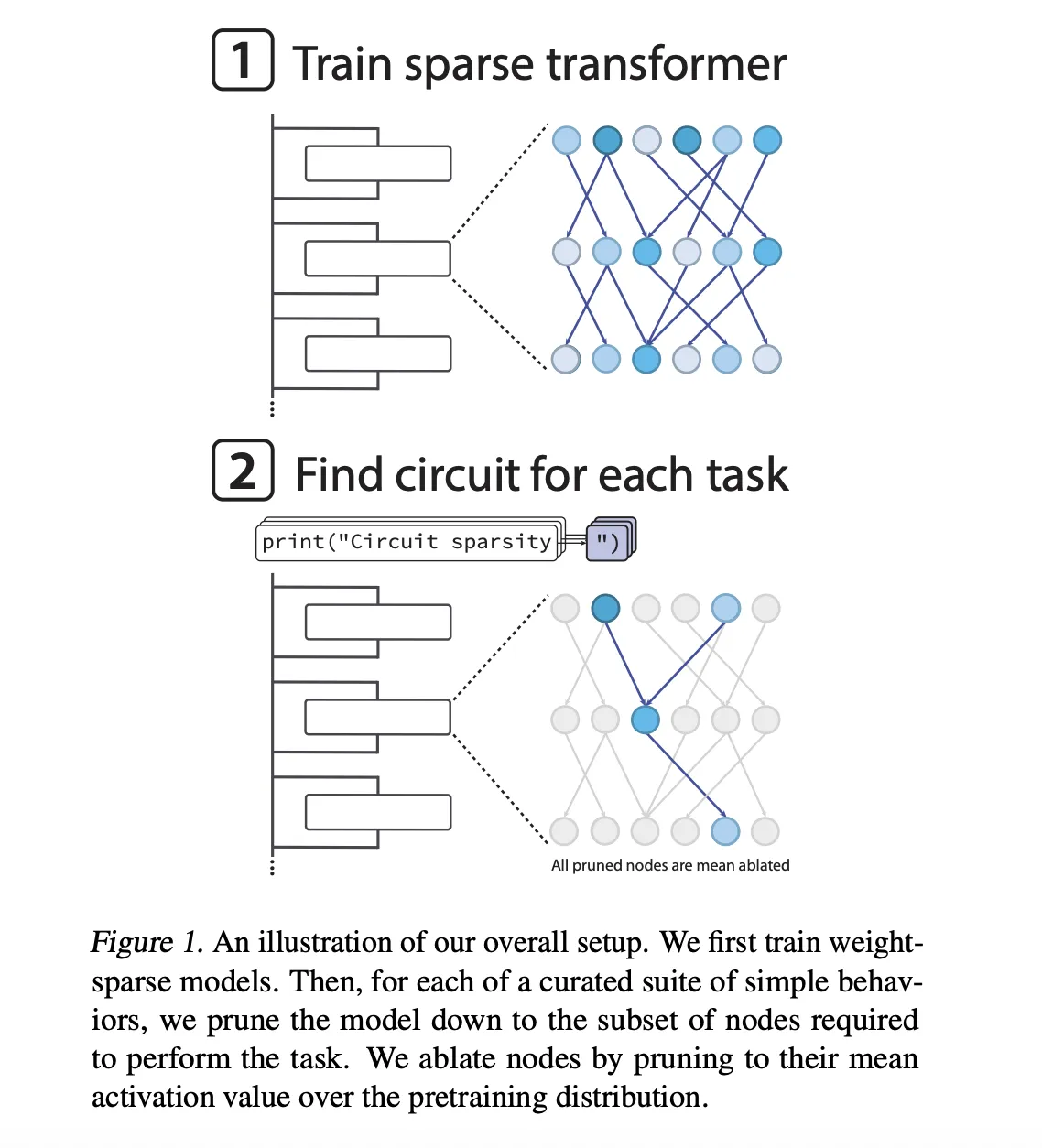

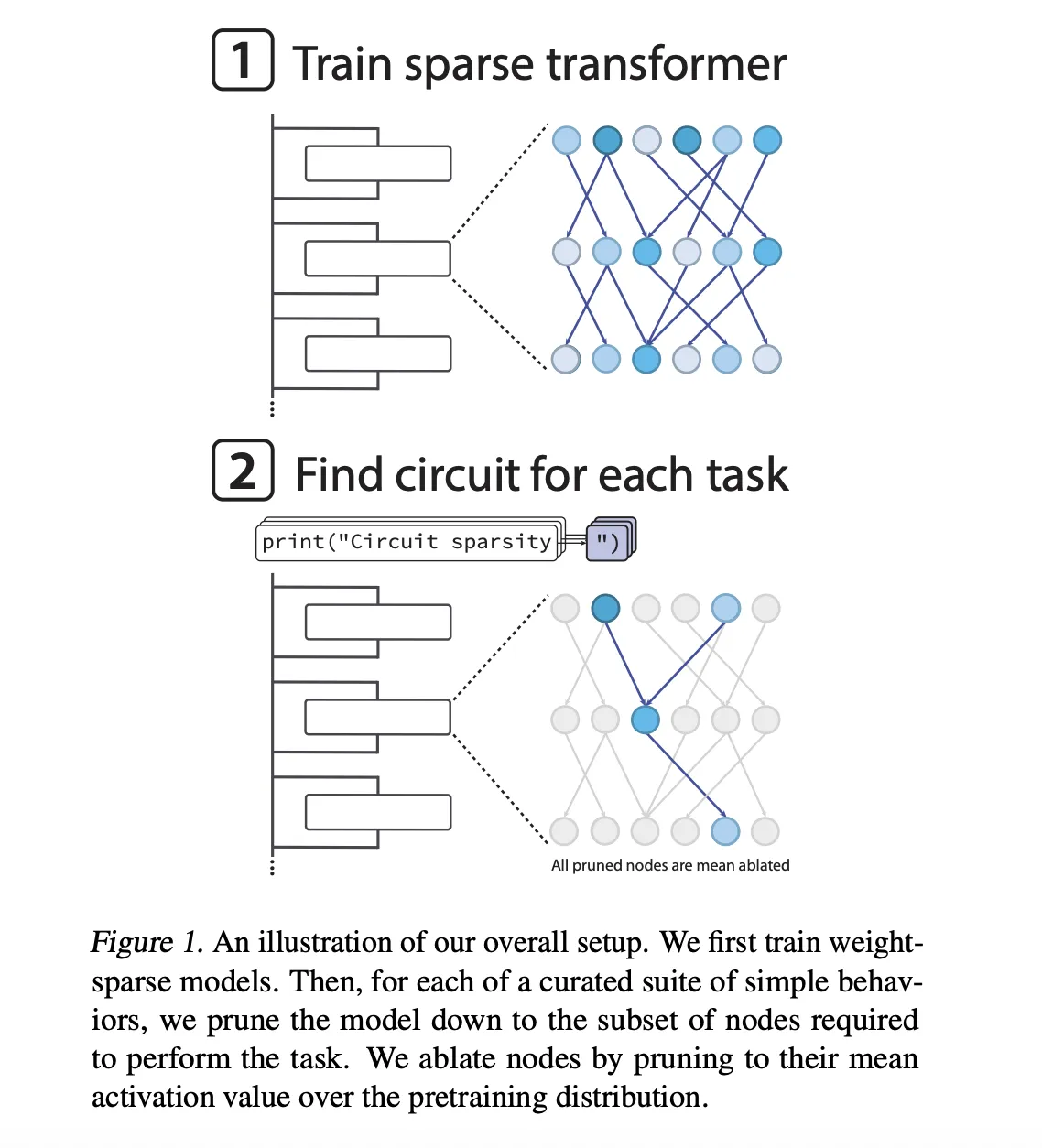

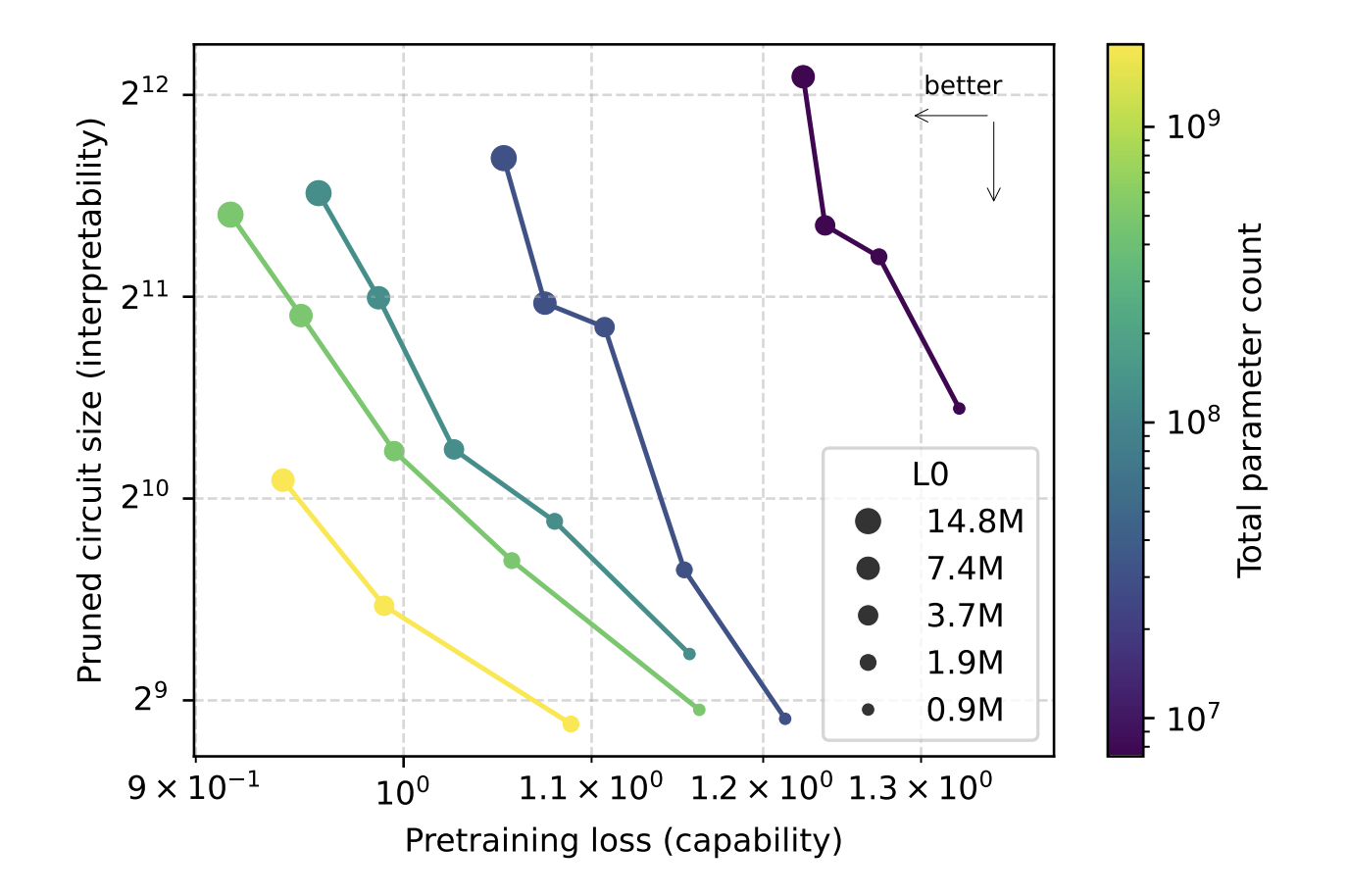

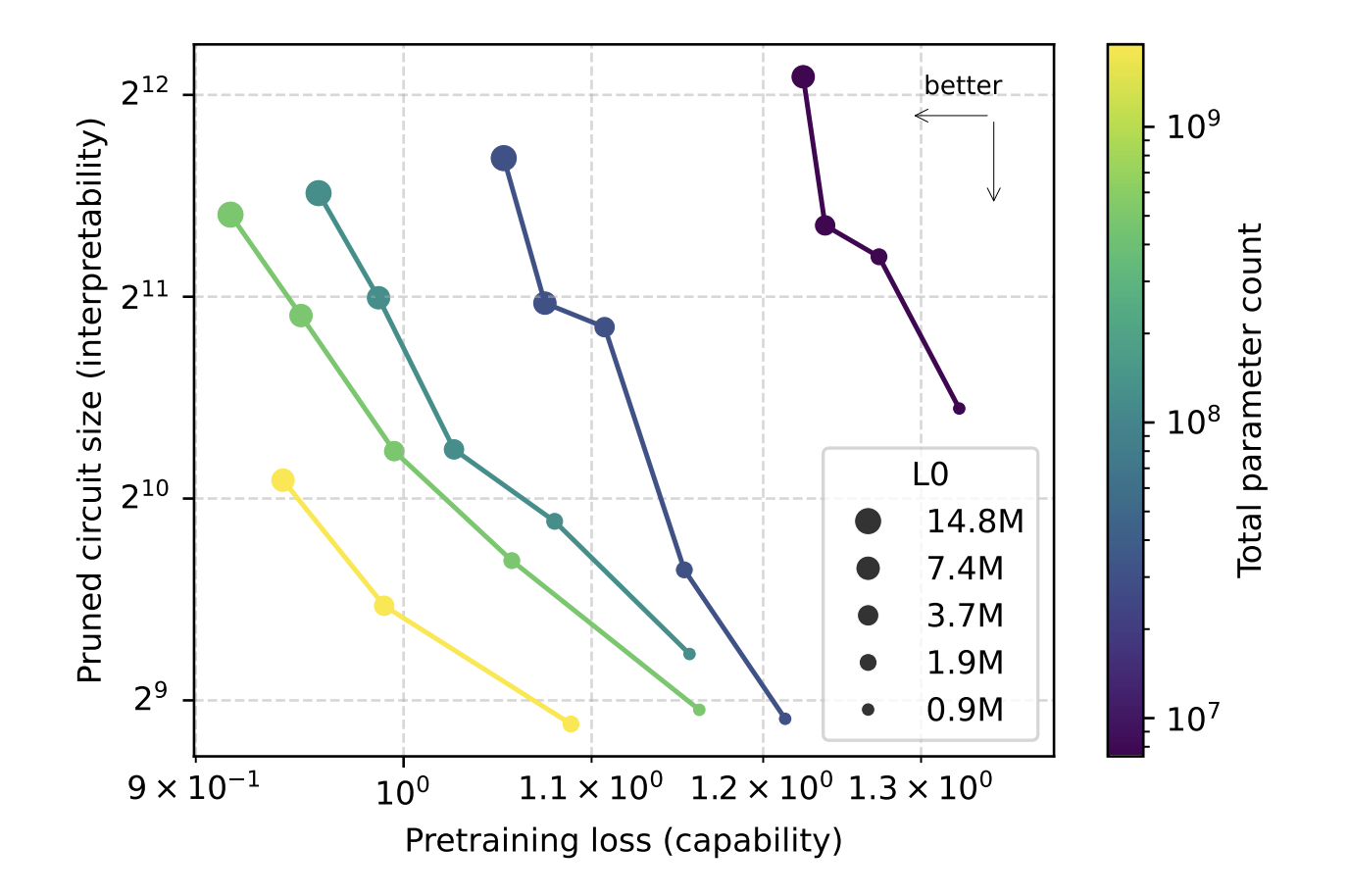

Sparsity wird während des Trainings geglüht. Modelle beginnen dicht, dann bewegt sich das zulässige Finances ungleich Null allmählich in Richtung des Zielwerts. Dieses Design ermöglicht es dem Forschungsteam, die Breite zu skalieren, während die Anzahl der Nicht-Null-Parameter unverändert bleibt, und dann den Kompromiss hinsichtlich der Interpretierbarkeit der Fähigkeit zu untersuchen, wenn Sparsity und Modellgröße variieren. Das Forschungsteam zeigte, dass bei einem gegebenen Verlust vor dem Coaching die wiederhergestellten Schaltkreise aus spärlichen Modellen ungefähr gleich sind 16 Mal kleiner als die von dichten Modellen.

Was ist additionally ein Sparse-Circuit?

Der zentrale Gegenstand dieser Forschungsarbeit ist a spärliche Schaltung. Das Forschungsteam definiert Knoten mit einer sehr feinen Granularität. Jeder Knoten ist ein einzelnes Neuron, ein Aufmerksamkeitskanal, ein verbleibender Lesekanal oder ein verbleibender Schreibkanal. Eine Kante ist ein einzelner Eintrag ungleich Null in einer Gewichtsmatrix, der zwei Knoten verbindet. Die Schaltkreisgröße wird anhand der geometrischen Mittelanzahl der Kanten über Aufgaben hinweg gemessen.

Um die Modelle zu untersuchen, baute das Forschungsteam 20 einfache Python-Subsequent-Token-Binäraufgaben. Jede Aufgabe zwingt das Modell, zwischen zwei Abschlüssen zu wählen, die sich in einem Token unterscheiden. Beispiele hierfür sind:

single_double_quotesagen Sie voraus, ob eine Zeichenfolge mit einem einfachen oder einem doppelten Anführungszeichen geschlossen werden sollbracket_countingentscheiden Sie sich zwischen)Und))basierend auf der Verschachtelungstiefe der Listeset_or_stringVerfolgen Sie, ob eine Variable als Menge oder Zeichenfolge initialisiert wurde

Für jede Aufgabe bereinigen sie das Modell, um die kleinste Schaltung zu finden, die noch einen Zielverlust von erreicht 0,15 zu dieser Aufgabenverteilung. Das Beschneiden erfolgt auf Knotenebene. Gelöschte Knoten sind bedeuten ablatiertwerden ihre Aktivierungen auf den Mittelwert der Vortrainingsverteilung eingefroren. Eine erlernte Binärmaske professional Knoten wird mit einem Straight-Via-Surrogat optimiert, sodass das Ziel einen Kompromiss zwischen Aufgabenverlust und Schaltungsgröße darstellt.

Beispielschaltkreise, Zitat schließen und Klammern zählen

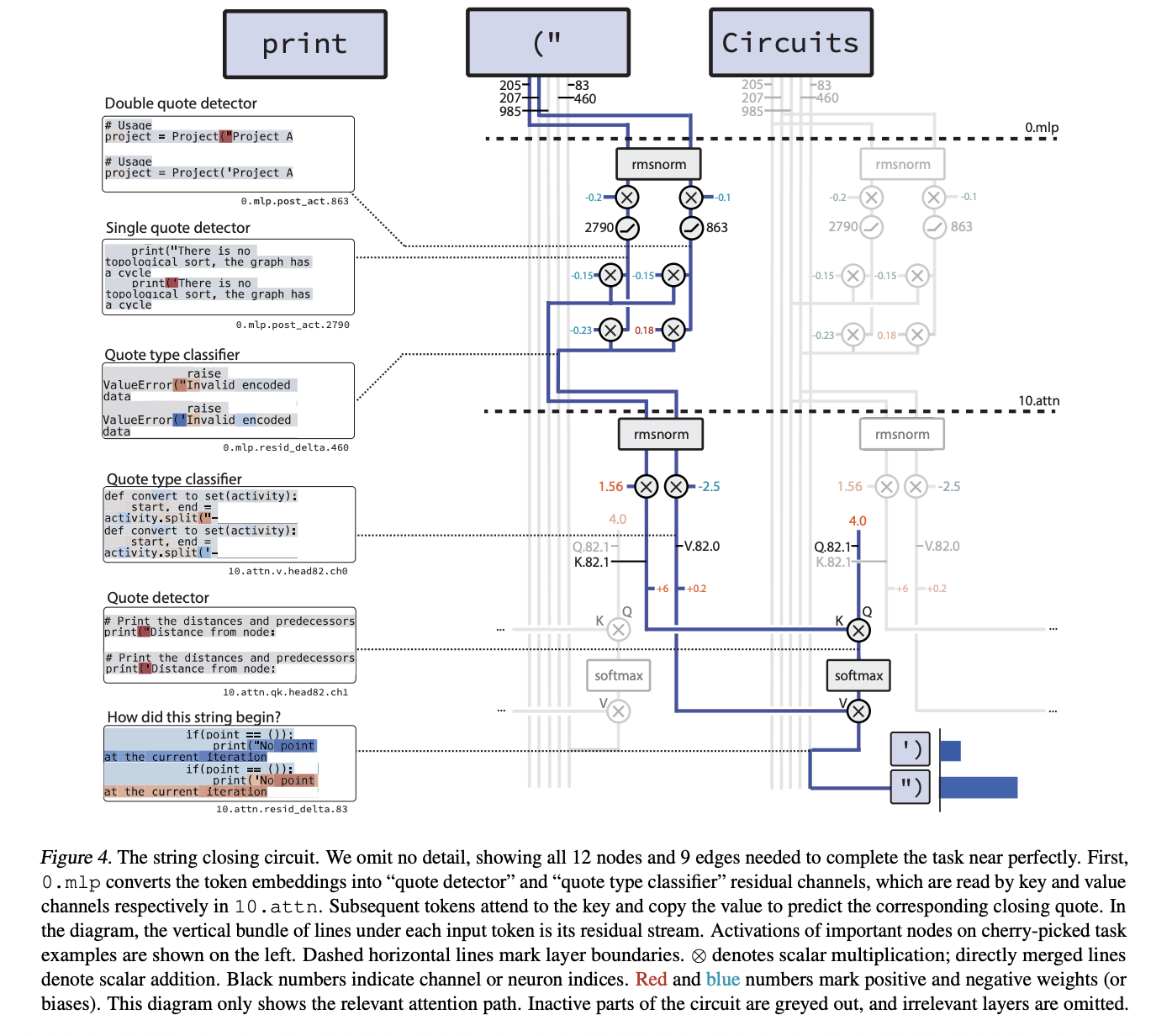

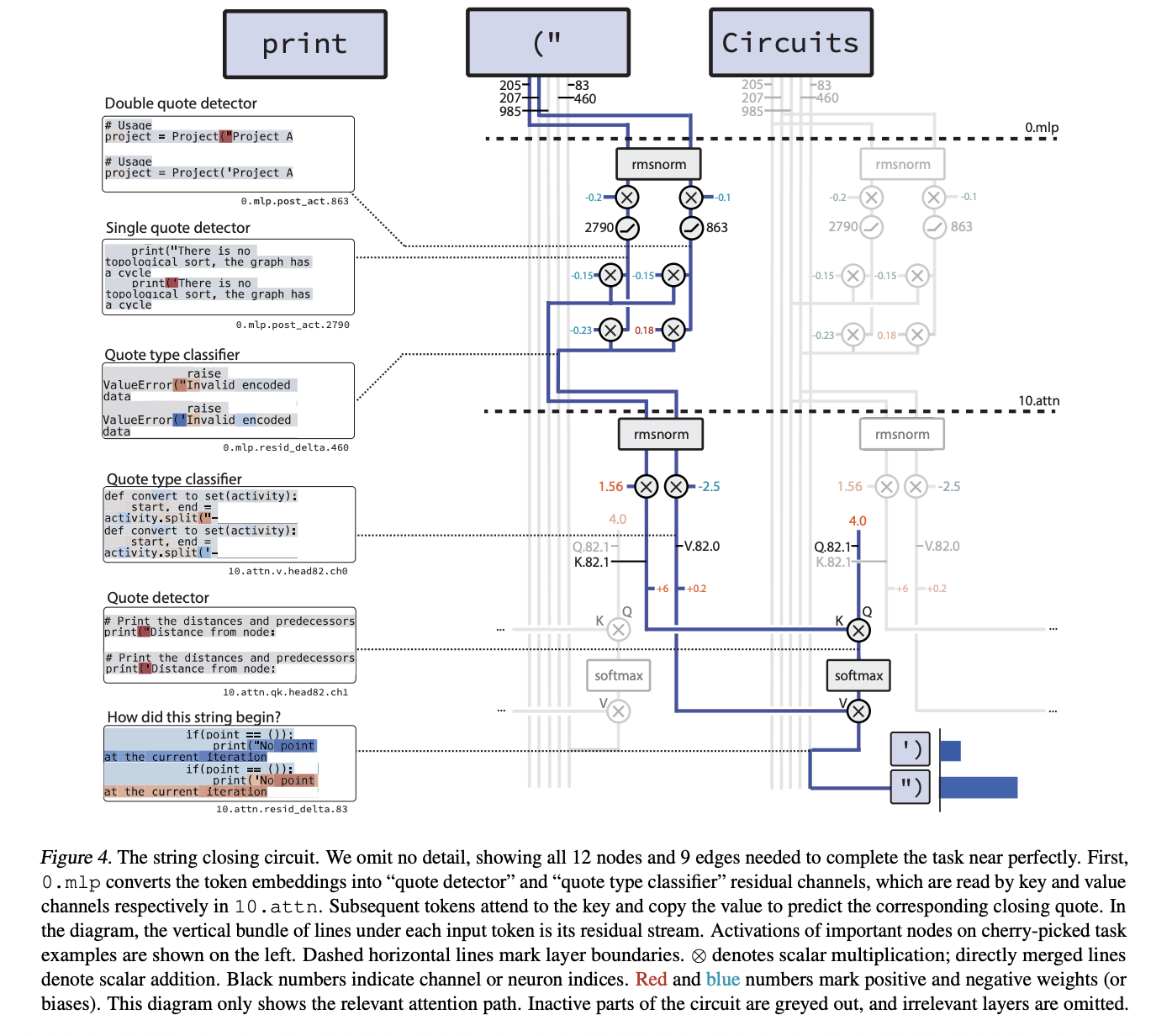

Das kompakteste Beispiel ist die Schaltung für single_double_quote. Hier muss das Modell bei einem Eröffnungszitat den richtigen Schlusszitattyp ausgeben. Der beschnittene Stromkreis hat 12 Knoten und 9 Kanten.

Der Mechanismus ist zweistufig. In Schicht 0.mlp2 Neuronen sind spezialisiert:

- A Zitatdetektor Neuron, das beide aktiviert

"Und' - A Zitattyp-Klassifikator Neuron, das positiv ist

"und negativ auf'

Ein späterer Aufmerksamkeitskopf in Schicht 10.attn verwendet den Kursdetektorkanal als Schlüssel und den Kurstypklassifizierungskanal als Wert. Das letzte Token hat eine konstant constructive Abfrage, sodass die Aufmerksamkeitsausgabe den richtigen Anführungszeichentyp an die letzte Place kopiert und das Modell die Zeichenfolge korrekt schließt.

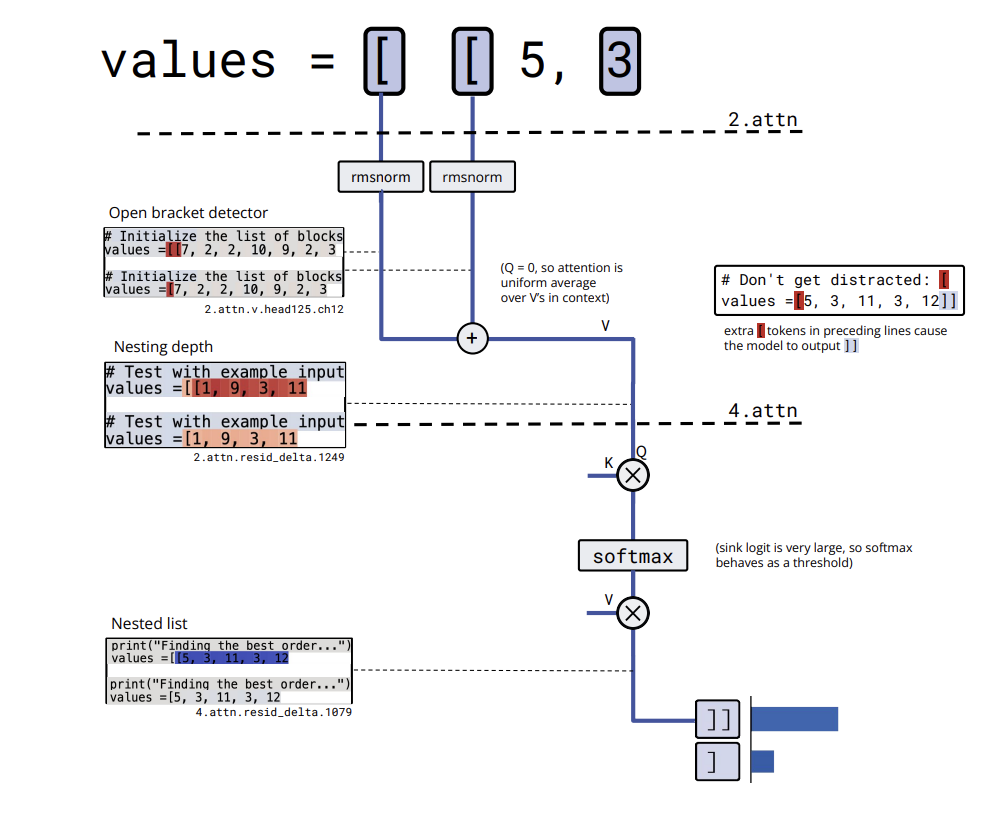

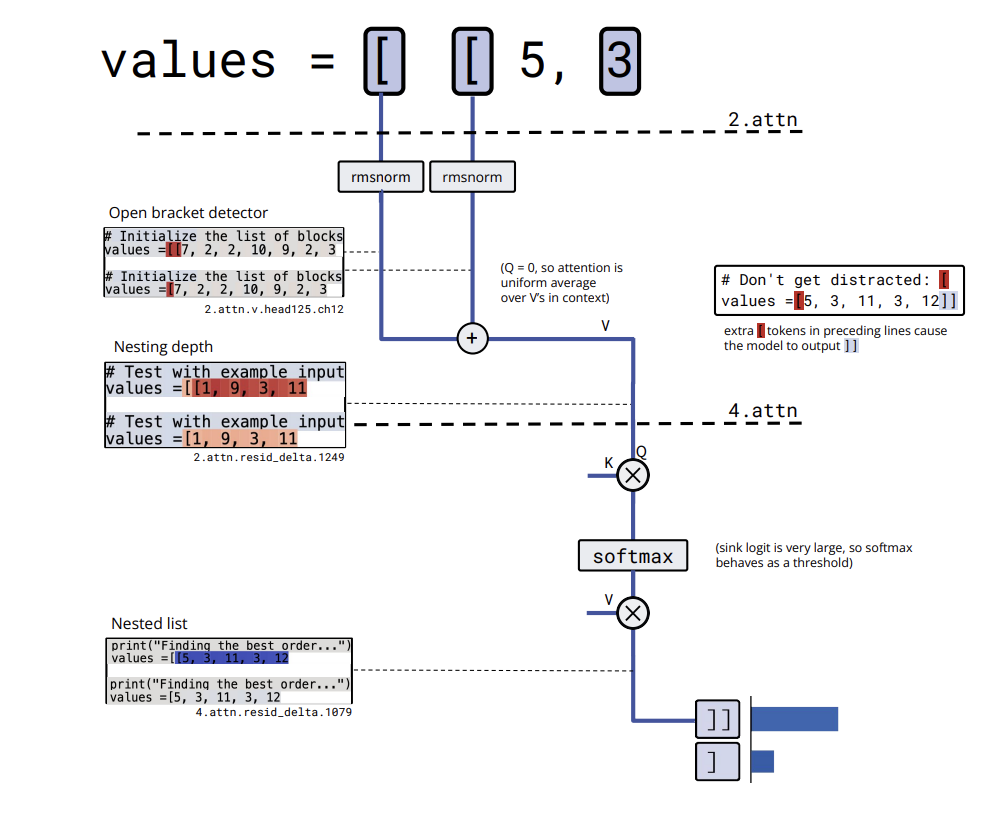

bracket_counting ergibt eine etwas größere Schaltung, aber mit einem klaren Algorithmus. Die Einbettung von ( schreibt in mehrere Restkanäle, die als fungieren Halterungsdetektoren. Ein Wertekanal in einem Schicht-2-Aufmerksamkeitskopf mittelt diese Detektoraktivierung über den Kontext, berechnet effektiv die Verschachtelungstiefe und speichert sie in einem Restkanal. Ein späterer Aufmerksamkeitskopf überschreitet diese Tiefe und aktiviert a verschachtelte Liste schließen Kanal nur, wenn die Liste verschachtelt ist, was zur Ausgabe des Modells führt )).

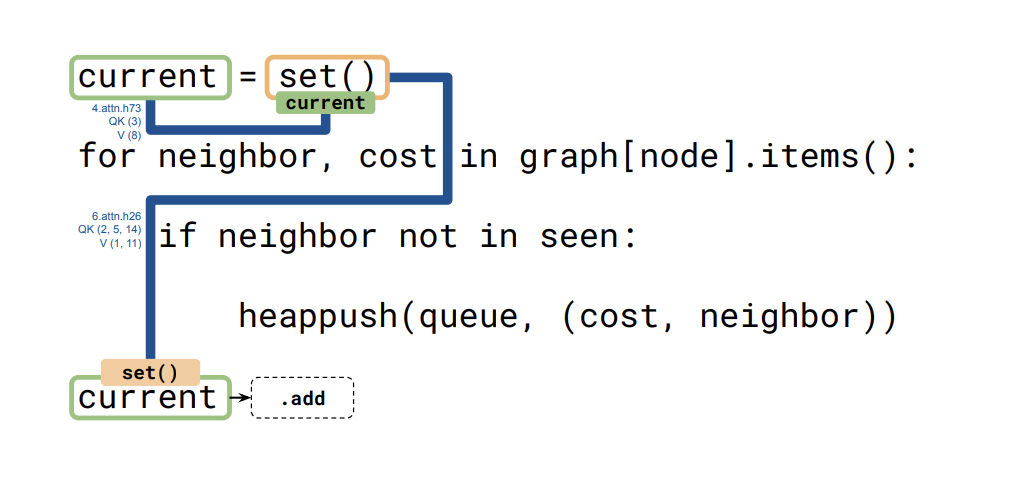

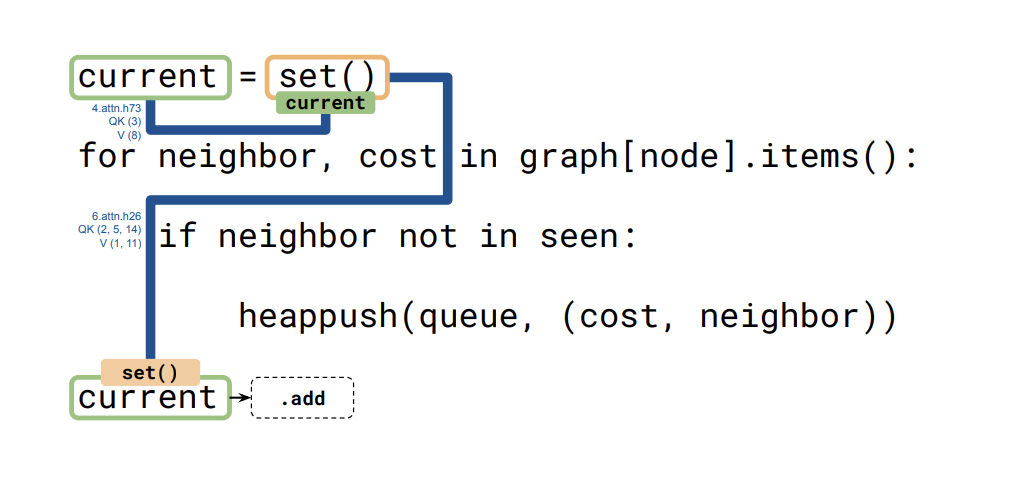

Ein dritter Stromkreis, z set_or_string_fixedvarnamezeigt, wie das Modell den Typ einer aufgerufenen Variablen verfolgt present. Ein Kopf kopiert die Einbettung von present in die set() oder "" Token. Ein späterer Kopf verwendet diese Einbettung als Abfrage und Schlüssel, um die relevanten Informationen zurückzukopieren, wenn das Modell zwischen diesen wählen muss .add Und +=.

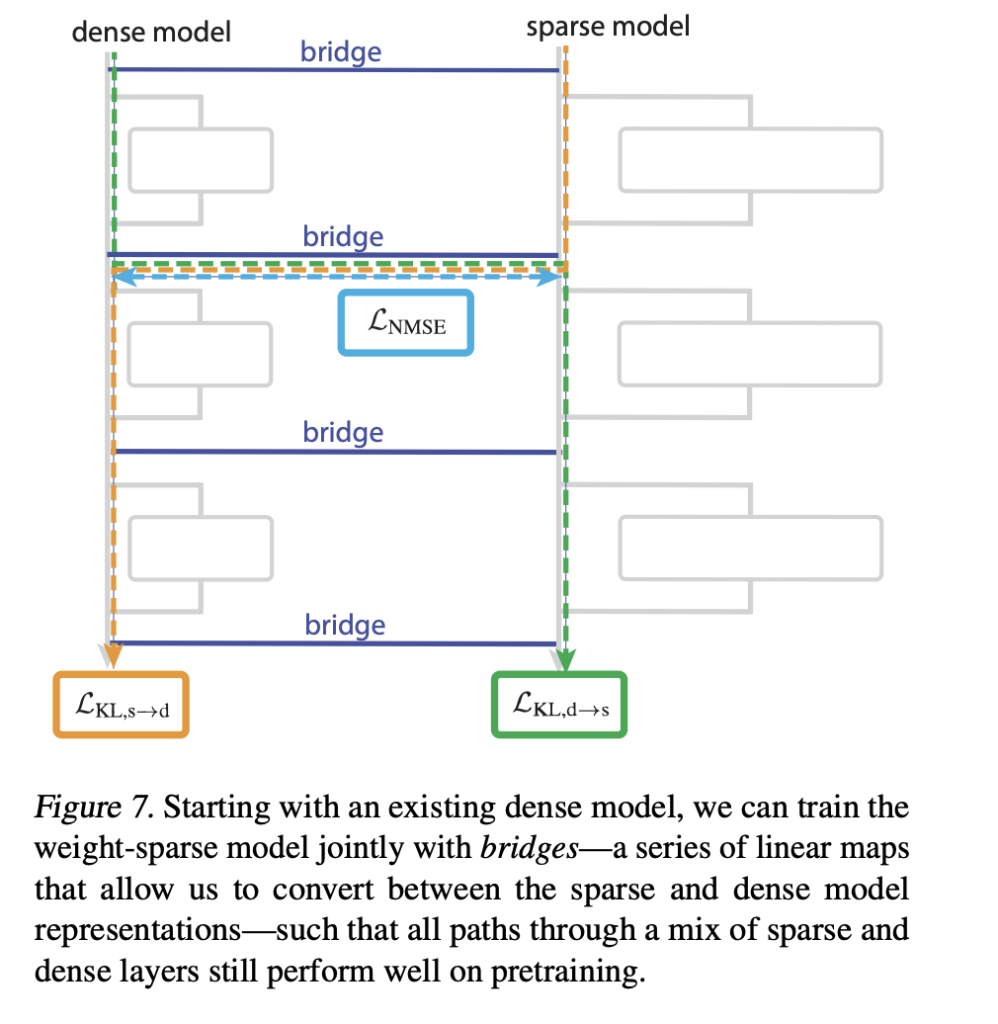

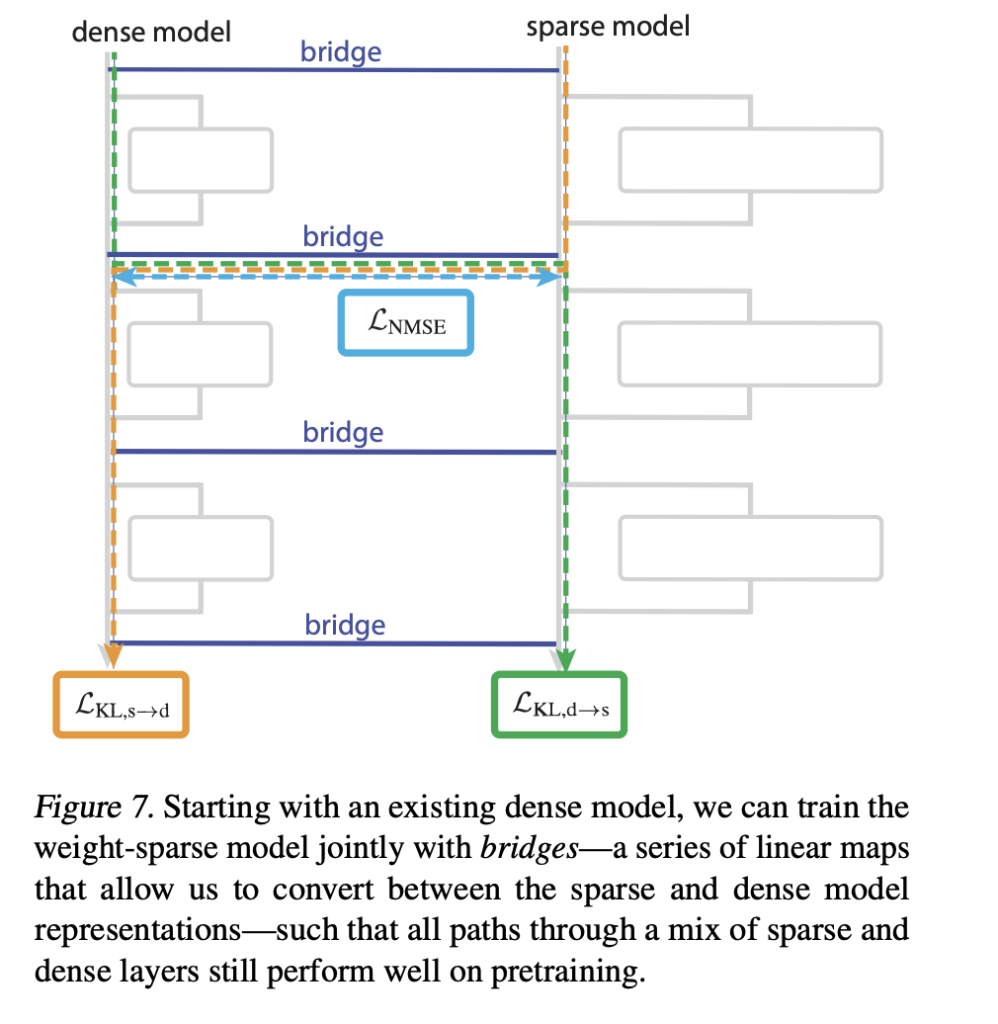

Brücken, die spärliche Modelle mit dichten Modellen verbinden

Das Forschungsteam stellt außerdem vor Brücken die ein spärliches Modell mit einem bereits trainierten dichten Modell verbinden. Jede Brücke ist ein Encoder-Decoder-Paar, das dichte Aktivierungen einmal professional Unterschicht in spärliche Aktivierungen und zurück abbildet. Der Encoder verwendet eine lineare Karte mit einer AbsTopK-Aktivierung, der Decoder ist linear.

Durch das Coaching werden Verluste hinzugefügt, die hybride, spärliche, dichte Vorwärtspässe fördern, die dem ursprünglichen dichten Modell entsprechen. Dadurch kann das Forschungsteam interpretierbare spärliche Merkmale wie den Klassifikatorkanal des Kurstyps stören und diese Störung dann im dichten Modell abbilden und so dessen Verhalten auf kontrollierte Weise ändern.

Was genau hat das OpenAI-Crew veröffentlicht?

Das OpenAI-Crew wie veröffentlicht openai/circuit-sparsity Modell auf Umarmendes Gesicht. Das ist ein 0,4B-Parameter Modell markiert mit custom_codeentsprechend csp_yolo2 im Forschungsarbeit. Das Modell wird für die qualitativen Ergebnisse zur Klammerzählung und Variablenbindung verwendet. Es ist unter Apache 2.0 lizenziert.

import torch

from transformers import AutoModelForCausalLM, AutoTokenizer

if __name__ == "__main__":

PROMPT = "def square_sum(xs):n return sum(x * x for x in xs)nnsquare_sum((1, 2, 3))n"

tok = AutoTokenizer.from_pretrained("openai/circuit-sparsity", trust_remote_code=True)

mannequin = AutoModelForCausalLM.from_pretrained(

"openai/circuit-sparsity",

trust_remote_code=True,

torch_dtype="auto",

)

mannequin.to("cuda" if torch.cuda.is_available() else "cpu")

inputs = tok(PROMPT, return_tensors="pt", add_special_tokens=False)("input_ids").to(

mannequin.system

)

with torch.no_grad():

out = mannequin.generate(

inputs,

max_new_tokens=64,

do_sample=True,

temperature=0.8,

top_p=0.95,

return_dict_in_generate=False,

)

print(tok.decode(out(0), skip_special_tokens=True))

``` :contentReference(oaicite:14){index=14}

Wichtige Erkenntnisse

- Gewichtarmes Coaching, kein nachträgliches Beschneiden: Circuit Sparsity trainiert Decodermodelle im GPT-2-Stil mit extremer Gewichtssparsität, die während der Optimierung erzwungen wird. Die meisten Gewichte sind Null, sodass jedes Neuron nur wenige Verbindungen hat.

- Kleine, aufgabenspezifische Schaltkreise mit expliziten Knoten und Kanten: Das Forschungsteam definiert Schaltkreise auf der Ebene einzelner Neuronen, Aufmerksamkeitskanäle und Restkanäle und stellt Schaltkreise wieder her, die oft Dutzende von Knoten und wenige Kanten für 20 binäre Python-Subsequent-Token-Aufgaben haben.

- Angebotsabschluss und Typverfolgung sind vollständig instanziierte Schaltkreise: Für Aufgaben wie

single_double_quote,bracket_countingUndset_or_string_fixedvarnameisolierte das Forschungsteam Schaltkreise, die konkrete Algorithmen für die Anführungszeichenerkennung, die Klammertiefe und die Verfolgung variabler Typen implementieren, wobei der String-Schließkreis 12 Knoten und 9 Kanten verwendet. - Modelle und Instruments auf Hugging Face und GitHub: OpenAI hat den 0,4B-Parameter veröffentlicht

openai/circuit-sparsityModell auf Hugging Face und das volleopenai/circuit_sparsityCodebasis auf GitHub unter Apache 2.0, einschließlich Modellprüfpunkten, Aufgabendefinitionen und einer Benutzeroberfläche zur Schaltungsvisualisierung. - Brückenmechanismus zur Verknüpfung dünner und dichter Modelle: Die Arbeit stellt Encoder-Decoder-Brücken vor, die zwischen spärlichen und dichten Aktivierungen abbilden, was es Forschern ermöglicht, spärliche Function-Eingriffe in standardmäßige dichte Transformatoren zu übertragen und zu untersuchen, wie interpretierbare Schaltkreise mit realen Modellen im Produktionsmaßstab zusammenhängen.

Schauen Sie sich das an Papier Und Modellgewichte. Schauen Sie sich gerne bei uns um GitHub-Seite für Tutorials, Codes und Notebooks. Sie können uns auch gerne weiter folgen Twitter und vergessen Sie nicht, bei uns mitzumachen 100.000+ ML SubReddit und Abonnieren Unser E-newsletter. Warten! Bist du im Telegram? Jetzt können Sie uns auch per Telegram kontaktieren.

Asif Razzaq ist CEO von Marktechpost Media Inc.. Als visionärer Unternehmer und Ingenieur setzt sich Asif dafür ein, das Potenzial der künstlichen Intelligenz für das soziale Wohl zu nutzen. Sein jüngstes Unterfangen ist die Einführung einer Medienplattform für künstliche Intelligenz, Marktechpost, die sich durch eine ausführliche Berichterstattung über maschinelles Lernen und Deep-Studying-Nachrichten auszeichnet, die sowohl technisch fundiert als auch für ein breites Publikum leicht verständlich ist. Die Plattform verfügt über mehr als 2 Millionen monatliche Aufrufe, was ihre Beliebtheit beim Publikum verdeutlicht.