Agenten -KI -Systeme fungieren als autonome digitale Mitarbeiter für die Ausführung komplexer Aufgaben mit minimaler Überwachung. Sie wachsen derzeit mit einer schnellen Anziehungskraft, bis zu dem Punkt, an dem eine schätzen Überzeugt, dass 35% der Unternehmen bis 2025 KI -Agenten umsetzen werden. Autonomie wirft jedoch Bedenken auf hohe Einsätze, selbst subtile Fehler in diesen Bereichen können schwerwiegende Konsequenzen haben. Daher glaubt die Menschen, dass menschliches Suggestions in der Agenten KI Sicherheit, Rechenschaftspflicht und Vertrauen gewährleistet.

Der Ansatz des Menschen in der Loop-Validation (HITL) ist ein kollaboratives Design, bei dem Menschen die Ausgaben einer KI bestätigen oder beeinflussen. Menschliche Kontrollpunkte erfassen frühere Fehler und halten das System auf menschliche Werte orientiert, was wiederum eine bessere Einhaltung und Vertrauen gegenüber der Agenten -KI hilft. Es fungiert als Sicherheitsnetz für komplexe Aufgaben. In diesem Artikel werden wir Workflows mit und ohne HITL vergleichen, um diese Kompromisse zu veranschaulichen.

Mensch in der Schleife: Konzept und Vorteile

Human-in-the-Loop (HITL) ist ein Designmuster, in dem ein KI-Workflow an wichtigen Stellen ausdrücklich das menschliche Urteilsvermögen enthält. Die KI kann eine vorläufige Ausgabe erzeugen und eine Pause einlegen, um die menschliche Überprüfung, Genehmigung oder Bearbeitung dieser Ausgabe zu lassen. In einem solchen Workflow wird der menschliche Überprüfungsschritt zwischen der KI -Komponente und der endgültigen Ausgabe eingegrenzt.

Vorteile der menschlichen Validierung

- Fehlerreduzierung und Genauigkeit: Mensch-in-the-Loop überprüft die potenziellen Fehler in den von der KI bereitgestellten Ausgängen und wird die Ausgabe fein stimmen.

- Vertrauen und Rechenschaftspflicht: Die menschliche Validierung macht ein System in seinen Entscheidungen verständlich und verantwortlich.

- Einhaltung und Sicherheit: Die menschliche Interpretation von Gesetzen und Ethik stellt sicher, dass KI -Handlungen den Vorschriften und Sicherheitsfragen entsprechen.

Wenn Sie keinen Menschen in der Schleife verwenden,

- Routine- oder Hochvolumenaufgaben: Menschen sind ein Engpass, wenn Geschwindigkeit wichtig ist. In solchen Bedingungen könnte die vollständige Automatisierungserzeugung extern effektiver sein.

- Zeitkritische Systeme: Echtzeit-Reaktion kann es kaum erwarten, auf den menschlichen Enter zu kommen. Zum Beispiel schnelle Inhaltsfilterung oder Stay -Warnungen; HITL könnte das System zurückhalten.

Was macht den Unterschied aus: Vergleich von zwei Szenarien

Ohne Menschen in der Schleife

Im vollautomatischen Szenario fährt der Agenten -Workflow autonom fort. Sobald die Eingabe bereitgestellt wird, generiert der Agent Inhalte und ergriffen die Aktion. Beispielsweise könnte ein AI-Assistent in einigen Fällen die Zeitabnahmeanfrage eines Benutzers ohne Bestätigung einreichen. Dies profitiert von der größten Geschwindigkeit und potenziellen Skalierbarkeit. Natürlich ist der Nachteil, dass nichts von einem Menschen überprüft wird. Es gibt einen konzeptionellen Unterschied zwischen einem Fehler eines Menschen und einem Fehler von einem AI -Agent. Ein Agent kann Anweisungen falsch interpretieren oder eine unerwünschte Handlung ausführen, die zu schädlichen Ergebnissen führen könnte.

Mit Menschen in der Schleife

Im Szenario von HITL (menschlich in der Schleife) setzen wir einen menschlichen Schritt ein. Nachdem der Agent einen groben Entwurf erstellt hat, stoppt er und bittet eine Individual, den Entwurf zu genehmigen oder Änderungen vorzunehmen. Wenn der Entwurf der Genehmigung erfüllt, veröffentlicht der Agent den Inhalt. Wenn der Entwurf nicht genehmigt wird, überarbeitet der Agent den Entwurf basierend auf Suggestions und Kreisen zurück. Dieses Szenario bietet ein größeres Maß an Genauigkeit und Vertrauen, da Menschen vor der Fertigstellung Fehler aufnehmen können. Das Hinzufügen eines Bestätigungsschritts verschiebt beispielsweise Aktionen, um „zufällige“ Maßnahmen zu reduzieren, und bestätigt, dass der Agent die Eingaben nicht missverstanden hat. Der Nachteil dazu ist natürlich, dass es mehr Zeit und menschliche Anstrengungen erfordert.

Beispielimplementierung in Langgraph

Unten ist ein Beispiel mit Verwendung Langgraph Und GPT-4O-Mini. Wir definieren zwei Workflows: eine vollständig automatisiert und eine mit einem menschlichen Zustimmungsschritt.

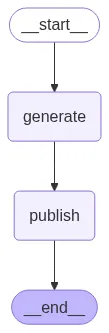

Szenario 1: Ohne Menschen in der Schleife

Im ersten Szenario erstellen wir additionally einen Agenten mit einem einfachen Workflow. Es wird die Eingabe des Benutzers erfordern, z. B. für welches Thema wir den Inhalt erstellen möchten, für welches Thema wir einen Artikel schreiben möchten. Nach dem Erhalt der Eingabe des Benutzers wird der Agent verwendet GPT-4O-Mini Um die Antwort zu erzeugen.

from langgraph.graph import StateGraph, END

from typing import TypedDict

from openai import OpenAI

from dotenv import load_dotenv

import os

load_dotenv()

OPENAI_API_KEY = os.getenv("OPENAI_API_KEY")

# --- OpenAI consumer ---

consumer = OpenAI(api_key=OPENAI_API_KEY) # Change together with your key

# --- State Definition ---

class ArticleState(TypedDict):

draft: str

# --- Nodes ---

def generate_article(state: ArticleState):

immediate = "Write an expert but partaking 150-word article about Agentic AI."

response = consumer.chat.completions.create(

mannequin="gpt-4o-mini",

messages=({"function": "consumer", "content material": immediate})

)

state("draft") = response.decisions(0).message.content material

print(f"n(Agent) Generated Article:n{state('draft')}n")

return state

def publish_article(state: ArticleState):

print(f"(System) Publishing Article:n{state('draft')}n")

return state

# --- Autonomous Workflow ---

def autonomous_workflow():

print("n=== Autonomous Publishing ===")

builder = StateGraph(ArticleState)

builder.add_node("generate", generate_article)

builder.add_node("publish", publish_article)

builder.set_entry_point("generate")

builder.add_edge("generate", "publish")

builder.add_edge("publish", END)

graph = builder.compile()

# Save diagram

with open("autonomous_workflow.png", "wb") as f:

f.write(graph.get_graph().draw_mermaid_png())

graph.invoke({"draft": ""})

if __name__ == "__main__":

autonomous_workflow()Code -Implementierung: Dieser Code richtet einen Workflow mit zwei Knoten ein: generate_article Und publish_articlenacheinander verknüpft. Beim Ausführen wird der Agent seinen Entwurf gedruckt und dann sofort veröffentlichen.

Agent Workflow Diagramm

Agentenantwort

“””Agentic AI refers to superior synthetic intelligence methods that possess the power to make autonomous selections primarily based on their setting and aims. In contrast to conventional AI, which depends closely on predefined algorithms and human enter, agentic AI can analyze complicated information, study from experiences, and adapt its conduct accordingly. This know-how harnesses machine studying, pure language processing, and cognitive computing to carry out duties starting from managing provide chains to personalizing consumer experiences.

The potential purposes of agentic AI are huge, remodeling industries akin to healthcare, finance, and customer support. As an example, in healthcare, agentic AI can analyze affected person information to offer tailor-made remedy suggestions, resulting in improved outcomes. As companies more and more undertake these autonomous methods, moral concerns surrounding transparency, accountability, and job displacement turn into paramount. Embracing agentic AI provides alternatives to boost effectivity and innovation, but it surely additionally requires cautious contemplation of its societal impression. The way forward for AI isn't just about automation; it is about clever collaboration.

”””

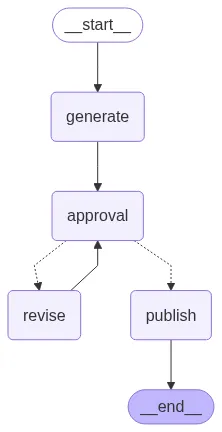

Szenario 2: Mit Menschen in der Schleife

In diesem Szenario werden wir zunächst 2 Instruments erstellen, revise_article_tool Und publish_article_tool. Der revise_article_tool wird den Inhalt des Artikels gemäß dem Suggestions des Benutzers überarbeiten/ändern. Sobald der Benutzer mit dem Suggestions fertig ist und mit der Agentenantwort zufrieden ist, veröffentlichen Sie das zweite Software, indem Sie das zweite Software veröffentlichen publish_article_toolEs wird ausgeführt und es wird den endgültigen Artikelinhalt bereitgestellt.

from langgraph.graph import StateGraph, END

from typing import TypedDict, Literal

from openai import OpenAI

from dotenv import load_dotenv

import os

load_dotenv()

# --- OpenAI consumer ---

OPENAI_API_KEY = os.getenv("OPENAI_API_KEY")

consumer = OpenAI(api_key=OPENAI_API_KEY)

# --- State Definition ---

class ArticleState(TypedDict):

draft: str

authorized: bool

suggestions: str

selected_tool: str

# --- Instruments ---

def revise_article_tool(state: ArticleState):

"""Software to revise article primarily based on suggestions"""

immediate = f"Revise the next article primarily based on this suggestions: '{state('suggestions')}'nnArticle:n{state('draft')}"

response = consumer.chat.completions.create(

mannequin="gpt-4o-mini",

messages=({"function": "consumer", "content material": immediate})

)

revised_content = response.decisions(0).message.content material

print(f"n(Software: Revise) Revised Article:n{revised_content}n")

return revised_content

def publish_article_tool(state: ArticleState):

"""Software to publish the article"""

print(f"(Software: Publish) Publishing Article:n{state('draft')}n")

print("Article efficiently printed!")

return state('draft')

# --- Out there Instruments Registry ---

AVAILABLE_TOOLS = {

"revise": revise_article_tool,

"publish": publish_article_tool

}

# --- Nodes ---

def generate_article(state: ArticleState):

immediate = "Write an expert but partaking 150-word article about Agentic AI."

response = consumer.chat.completions.create(

mannequin="gpt-4o-mini",

messages=({"function": "consumer", "content material": immediate})

)

state("draft") = response.decisions(0).message.content material

print(f"n(Agent) Generated Article:n{state('draft')}n")

return state

def human_approval_and_tool_selection(state: ArticleState):

"""Human validates and selects which instrument to make use of"""

print("Out there actions:")

print("1. Publish the article (kind 'publish')")

print("2. Revise the article (kind 'revise')")

print("3. Reject and supply suggestions (kind 'suggestions')")

determination = enter("nWhat would you love to do? ").strip().decrease()

if determination == "publish":

state("authorized") = True

state("selected_tool") = "publish"

print("Human validated: PUBLISH instrument chosen")

elif determination == "revise":

state("authorized") = False

state("selected_tool") = "revise"

state("suggestions") = enter("Please present suggestions for revision: ").strip()

print(f"Human validated: REVISE instrument chosen with suggestions")

elif determination == "suggestions":

state("authorized") = False

state("selected_tool") = "revise"

state("suggestions") = enter("Please present suggestions for revision: ").strip()

print(f"Human validated: REVISE instrument chosen with suggestions")

else:

print("Invalid enter. Defaulting to revision...")

state("authorized") = False

state("selected_tool") = "revise"

state("suggestions") = enter("Please present suggestions for revision: ").strip()

return state

def execute_validated_tool(state: ArticleState):

"""Execute the human-validated instrument"""

tool_name = state("selected_tool")

if tool_name in AVAILABLE_TOOLS:

print(f"n Executing validated instrument: {tool_name.higher()}")

tool_function = AVAILABLE_TOOLS(tool_name)

if tool_name == "revise":

# Replace the draft with revised content material

state("draft") = tool_function(state)

# Reset approval standing for subsequent iteration

state("authorized") = False

state("selected_tool") = ""

elif tool_name == "publish":

# Execute publish instrument

tool_function(state)

state("authorized") = True

else:

print(f"Error: Software '{tool_name}' not present in accessible instruments")

return state

# --- Workflow Routing Logic ---

def route_after_tool_execution(state: ArticleState) -> Literal("approval", "finish"):

"""Route primarily based on whether or not the article was printed or wants extra approval"""

if state("selected_tool") == "publish":

return "finish"

else:

return "approval"

# --- HITL Workflow ---

def hitl_workflow():

print("n=== Human-in-the-Loop Publishing with Software Validation ===")

builder = StateGraph(ArticleState)

# Add nodes

builder.add_node("generate", generate_article)

builder.add_node("approval", human_approval_and_tool_selection)

builder.add_node("execute_tool", execute_validated_tool)

# Set entry level

builder.set_entry_point("generate")

# Add edges

builder.add_edge("generate", "approval")

builder.add_edge("approval", "execute_tool")

# Add conditional edges after instrument execution

builder.add_conditional_edges(

"execute_tool",

route_after_tool_execution,

{"approval": "approval", "finish": END}

)

# Compile graph

graph = builder.compile()

# Save diagram

strive:

with open("hitl_workflow_with_tools.png", "wb") as f:

f.write(graph.get_graph().draw_mermaid_png())

print("Workflow diagram saved as 'hitl_workflow_with_tools.png'")

besides Exception as e:

print(f"Couldn't save diagram: {e}")

# Execute workflow

initial_state = {

"draft": "",

"authorized": False,

"suggestions": "",

"selected_tool": ""

}

graph.invoke(initial_state)

if __name__ == "__main__":

hitl_workflow()

"""Human Suggestions:

Maintain the dialogue massive and easy in order that each tech and non-tech individuals can perceive

"""Agent Workflow Diagramm

Agentenantwort

“””Understanding Agentic AI: The Way forward for Clever Help Agentic AI represents a groundbreaking development within the discipline of synthetic intelligence, characterised by its means to function independently whereas exhibiting goal-directed conduct. In contrast to conventional AI methods that require fixed human intervention, Agentic AI can analyze information, make selections, and execute duties autonomously. This revolutionary know-how has the potential to rework varied sectors, together with healthcare, finance, and customer support, by streamlining processes and enhancing effectivity. One of the notable options of Agentic AI is its adaptability; it learns from interactions and outcomes, repeatedly enhancing its efficiency. As extra companies undertake this know-how, the alternatives for customized consumer experiences and superior predictive analytics broaden considerably. Nonetheless, the rise of Agentic AI additionally raises vital discussions about ethics, accountability, and safety. Placing the proper stability between leveraging its capabilities and making certain accountable utilization shall be essential as we navigate this new period of clever automation. Embracing Agentic AI might essentially change our interactions with know-how, finally enriching our day by day lives and reshaping industries. Article efficiently printed!

”””

Beobachtungen

Diese Demonstration spiegelte die gemeinsamen HITL -Ergebnisse wider. Mit der menschlichen Überprüfung warfare der letzte Artikel klarer und genauer, was mit den Ergebnissen übereinstimmte, die sich Hitl verbessert Ai Ausgangsqualität. Das menschliche Suggestions entfernte Fehler und raffinierte Phrasierung, was diese Vorteile bestätigte. In der Zwischenzeit wurde Latenz und Arbeitsbelastung hinzugefügt. Der automatisierte Lauf endete quick sofort, während der Hitl -Workflow zweimal für Suggestions hielt. In der Praxis wird dieser Kompromiss erwartet: Maschinen bieten Geschwindigkeit, aber Menschen bieten Präzision.

Abschluss

Zusammenfassend könnte das menschliche Suggestions die Ausgabe der Agenten -KI erheblich verbessern. Es fungiert als Sicherheitsnetz für Fehler und kann die Ausgaben mit menschlicher Absicht in Einklang bringen. In diesem Artikel haben wir hervorgehoben, dass selbst ein einfacher Überprüfungsschritt die Textzuverlässigkeit verbesserte. Die Entscheidung, HITL zu verwenden, sollte letztendlich auf dem Kontext basieren: Sie sollten in wichtigen Fällen die menschliche Überprüfung verwenden und in routinemäßigen Situationen loslassen.

Mit zunehmender Verwendung von Agenten -KI wird die Herausforderung, automatisierte Prozesse zu verwenden, im Vergleich zur Verwendung dieser Prozesse. Vorschriften und Finest Practices erfordern zunehmend ein gewisses Maß an menschlicher Überprüfung in KI-Implementierungen mit hohem Risiko. Die Gesamtidee besteht darin, die Automatisierung für ihre Effizienz zu nutzen, aber immer noch die Menschen über die Besitzung wichtiger Entscheidungen, die einmal am Tag getroffen wurden! Versatile menschliche Kontrollpunkte helfen uns bei der Verwendung Agenten AI Wir können sicher und verantwortungsbewusst.

Mehr lesen: Wie komme ich im Jahr 2025 in die Agent -KI?

Häufig gestellte Fragen

A. HITL ist ein Design, bei dem Menschen an wichtigen Punkten KI -Ausgänge validieren. Es gewährleistet Genauigkeit, Sicherheit und Ausrichtung auf menschliche Werte, indem Überprüfungsschritte vor den endgültigen Maßnahmen hinzugefügt werden.

A. HITL ist für routinemäßige, hochvolumige oder zeitkritische Aufgaben nicht geeignet, bei denen menschliche Intervention die Leistung verlangsamt, wie z. B. Stay-Warnungen oder Echtzeit-Inhaltsfilterung.

A. Humanes Suggestions reduziert die Fehler, sorgt für die Einhaltung von Gesetzen und Ethik und baut Vertrauen und Rechenschaftspflicht bei der Entscheidungsfindung von KI auf.

A. Ohne HITL wirkt AI autonom mit Geschwindigkeit, riskiert jedoch ungeprüfte Fehler. Mit HITL überprüfen Menschen Entwürfe und verbessert die Zuverlässigkeit, fügt jedoch Zeit und Mühe hinzu.

A. Die Aufsicht stellt sicher, dass KI-Handlungen sicher, ethisch bleiben und mit menschlicher Absicht ausgerichtet sind, insbesondere in Anwendungen mit hohen Einsätzen, bei denen Fehler schwerwiegende Konsequenzen haben.

Melden Sie sich an, um weiter zu lesen und Experten-Kuratinhalte zu genießen.