Die neueste Ankündigung von Mistral AI stellt DevStral 2 (123B Parameter), DevStral Small 2 (24B) und die Mistral Vibe CLI vor, einen terminal-nativen Codierungsassistenten, der für Agenten-Codierungsaufgaben entwickelt wurde. Beide Modelle sind vollständig Open Supply und auf Produktionsabläufe abgestimmt, während die neue Vibe CLI projektbezogene Bearbeitung, Codesuche, Versionskontrolle und Ausführung direkt in das Terminal bringt.

Zusammengenommen zielen diese Updates darauf ab, die Arbeitsabläufe der Entwickler zu beschleunigen, indem umfangreiche Code-Refactorings, Fehlerbehebungen und die Funktionsentwicklung stärker automatisiert werden. In diesem Leitfaden werden wir die technischen Fähigkeiten jedes Instruments skizzieren und praktische Beispiele für den Einstieg bereitstellen.

Was ist DevStral 2?

DevStral 2 ist ein dichter Transformator mit 123 Milliarden Parametern, der speziell für Software program-Engineering-Agenten entwickelt wurde. Es verfügt über ein 256K-Token-Kontextfenster, das die Analyse ganzer Code-Repositorys auf einmal ermöglicht. Trotz seiner Größe ist es viel kleiner als Konkurrenzmodelle: Beispielsweise ist DevStral 2 5x kleiner als DeepSeek v3.2 und 8x kleiner als Kimi K2 dennoch ihre Leistung erreichen oder übertreffen. Diese Kompaktheit macht DevStral 2 praktisch für den Einsatz in Unternehmen.

Hauptmerkmale von DevStral 2

Zu den wichtigsten technischen Highlights von DevStral 2 gehören:

- SOTA-Codierungsleistung: 72,2 % im SWE-Bench-Verified-Check, was es zu einem der stärksten Open-Weight-Modelle für die Codierung macht.

- Umgang mit großem Kontext: Mit 256K-Tokens kann es den Kontext auf Architekturebene über viele Dateien hinweg verfolgen.

- Agenten-Workflows: Entwickelt, um „Codebasen zu erkunden und Änderungen über mehrere Dateien hinweg zu orchestrieren“, kann DevStral 2 Fehler erkennen, es mit Korrekturen erneut versuchen und Aufgaben wie Refactoring mehrerer Dateien, Fehlerbehebung und Modernisierung von Legacy-Code bewältigen.

Diese Funktionen bedeuten, dass DevStral 2 nicht nur ein leistungsstarkes Code-Vervollständigungsmodell ist, sondern ein echter Codierungsassistent, der den Standing über ein gesamtes Projekt hinweg aufrechterhält. Für Entwickler bedeutet dies schnellere und zuverlässigere automatisierte Änderungen: DevStral 2 kann beispielsweise die Dateistruktur und Abhängigkeiten eines Projekts verstehen, Codeänderungen über viele Module hinweg vorschlagen und sogar iterativ Korrekturen anwenden, wenn Assessments fehlschlagen.

Weitere Informationen zu den Preisen von DevStral 2 finden Sie hier offiziell Seite.

Setup für DevStral 2

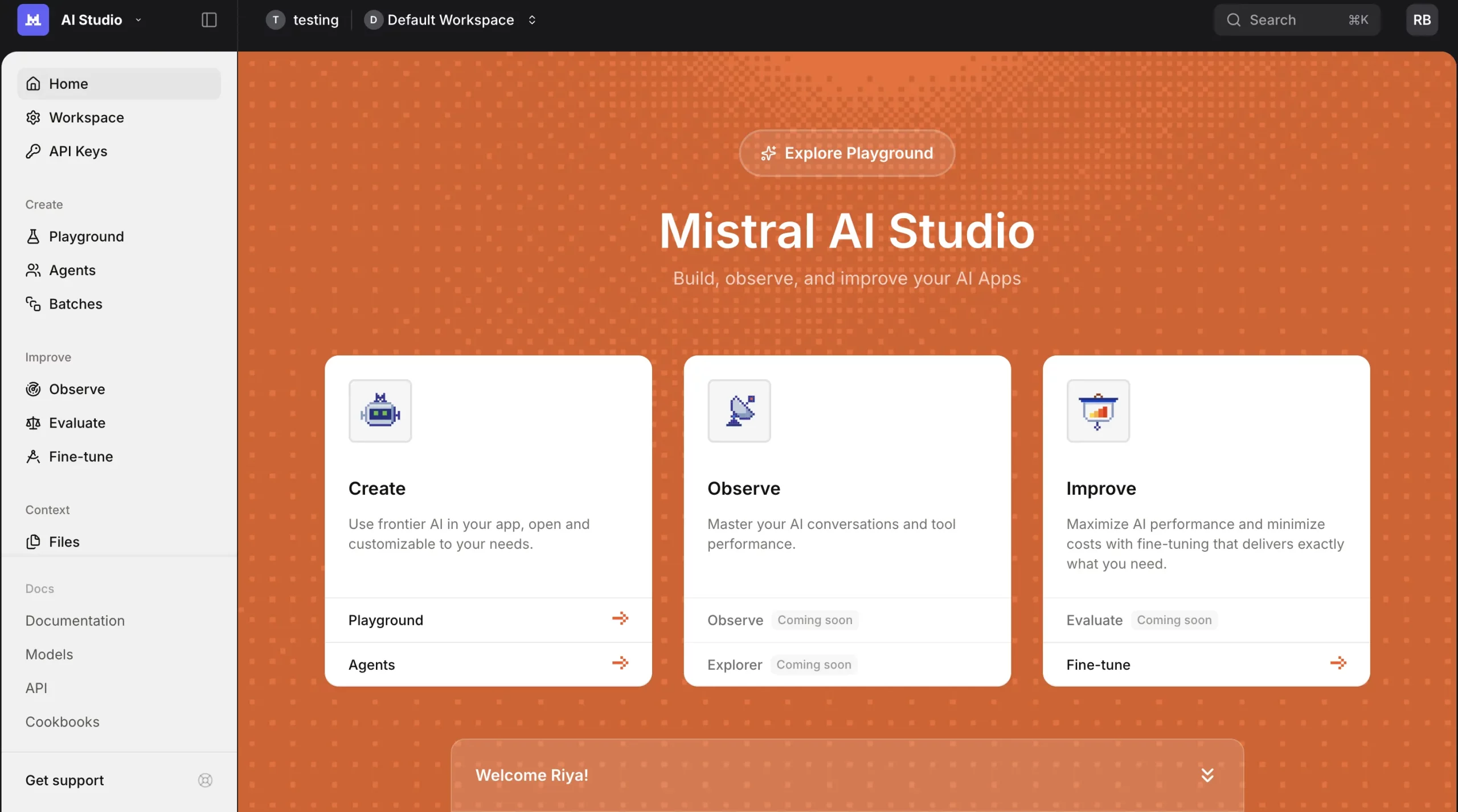

- Registrieren Sie sich oder melden Sie sich bei der Mistral-Plattform an über https://v2.auth.mistral.ai/login.

- Erstellen Sie Ihre Organisation, indem Sie einen passenden Namen vergeben.

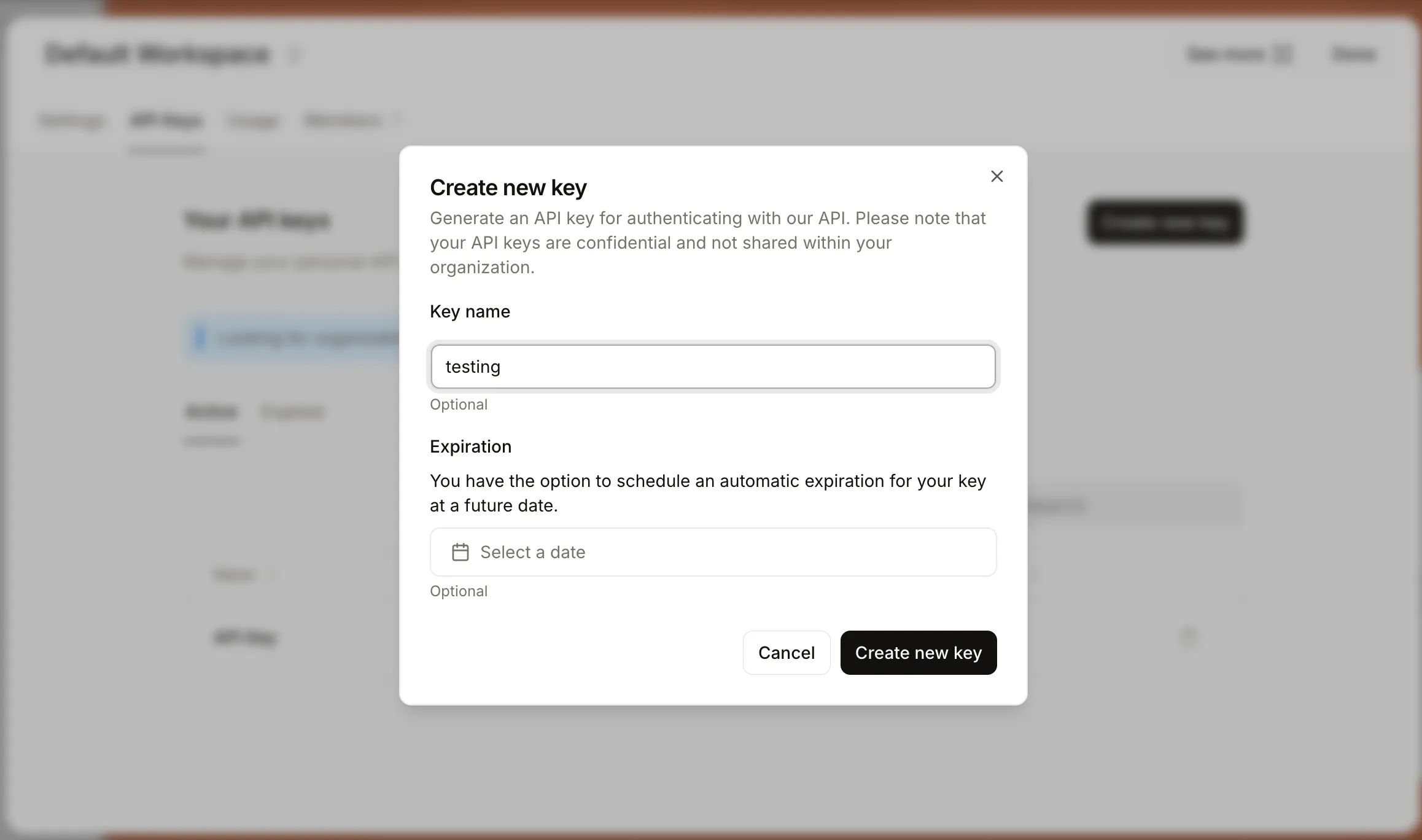

- Gehen Sie in der Seitenleiste zum Abschnitt „API-Schlüssel“ und wählen Sie einen geeigneten Plan aus.

- Sobald der Plan aktiviert ist, generieren Sie einen API-Schlüssel.

Praktisch: DevStral 2

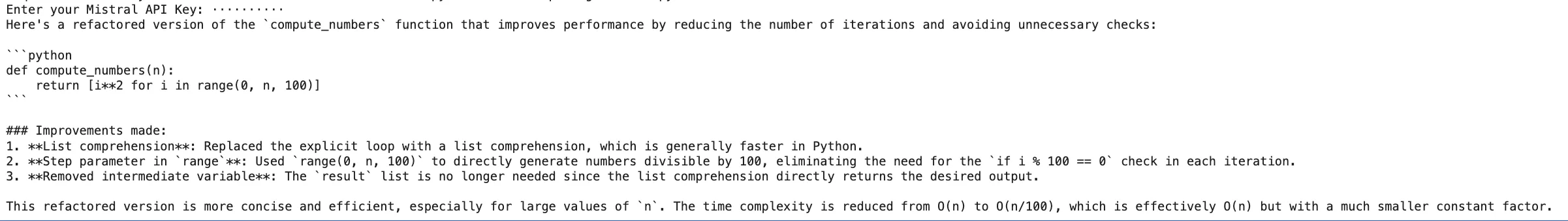

Aufgabe 1: DevStral 2 über die Mistral API (Python SDK) aufrufen

Nutzen Sie das offizielle SDK von Mistral, um Codierungsanfragen einzureichen. Wenn Sie beispielsweise möchten, dass DevStral 2 a Python Um die Geschwindigkeit zu erhöhen, können Sie Folgendes eingeben:

!pip set up mistralai

from mistralai import Mistral

import os

from getpass import getpass

api_key = getpass("Enter your Mistral API Key: ")

shopper = Mistral(api_key=api_key)

response = shopper.chat.full(

mannequin="devstral-2512", # right mannequin identify

messages=(

{"function": "system", "content material": "You're a Python code assistant."},

{"function": "person", "content material": (

"Refactor the next perform to enhance efficiency:n"

"```pythonndef compute_numbers(n):n"

" end result = ()n"

" for i in vary(n):n"

" if i % 100 == 0:n"

" end result.append(i**2)n"

" return resultn```"

)}

)

)

print(response.selections(0).message.content material)Die Anfrage wird an DevStral 2 gestellt, um eine Schleifenfunktion schneller zu machen. Der KI wird die Funktion untersuchen und eine reformierte Model bereitstellen (z. B. die Verwendung von Listenverständnissen oder vektorisierten Bibliotheken empfehlen). Obwohl das Python SDK die Interaktion mit dem Modell erleichtert, können Sie bei Bedarf auch HTTP-Anfragen für den direkten API-Zugriff stellen.

Aufgabe 2: Gesichtstransformatoren mit DevStral 2 umarmen

Hugging Face verfügt über DevStral 2-Gewichte, was bedeutet, dass es möglich ist, das Modell lokal (sofern Ihre {Hardware} intestine genug ist) mit dem auszuführen Transformers Bibliothek. Um nur ein Beispiel zu nennen:

!pip set up transformers # ensure you have transformers put in

# optionally: pip set up git+https://github.com/huggingface/transformers if utilizing bleeding-edge

from transformers import MistralForCausalLM, MistralCommonBackend

import torch

model_id = "mistralai/Devstral-2-123B-Instruct-2512"

# Load tokenizer and mannequin

tokenizer = MistralCommonBackend.from_pretrained(model_id, trust_remote_code=True)

mannequin = MistralForCausalLM.from_pretrained(model_id, device_map="auto", trust_remote_code=True)

# Optionally, set dtype for higher reminiscence utilization (e.g. bfloat16 or float16) when you have GPU

mannequin = mannequin.to(torch.bfloat16)

immediate = (

"Write a perform to merge two sorted lists of integers into one sorted record:n"

"```pythonn"

"# Enter: list1 and list2, each sortedn"

"```"

)

inputs = tokenizer(immediate, return_tensors="pt").to(mannequin.gadget)

outputs = mannequin.generate(**inputs, max_new_tokens=100)

print(tokenizer.decode(outputs(0), skip_special_tokens=True))Der angezeigte Codeausschnitt nutzt das „DevStral 2 Instruct“-Modell, um eine vollständige Python-Funktion ähnlich dem vorherigen Code zu erstellen.

Was ist DevStral Small 2?

DevStral Small 2 bringt die gleichen Designprinzipien auf ein viel kleineres Modell. Es verfügt über 24 Milliarden Parameter und das gleiche 256-KB-Kontextfenster, ist jedoch so dimensioniert, dass es auf einer einzelnen GPU oder sogar einer Excessive-Finish-Client-CPU ausgeführt werden kann.

Hauptmerkmale von DevStral Small 2

Zu den Hauptmerkmalen von DevStral Small 2 gehören:

- Leicht & lokal: Mit 24B-Parametern ist DevStral Small 2 für den Einsatz vor Ort optimiert. Mistral gibt an, dass es auf einer RTX 4090-GPU oder einem Mac mit 32 GB RAM ausgeführt werden kann. Dies bedeutet, dass Entwickler lokal iterieren können, ohne dass ein Rechenzentrumscluster erforderlich ist.

- Hohe Leistung: Beim SWE-Bench-Verified erreicht es 68,0 % und liegt damit auf Augenhöhe mit Modellen, die bis zu fünfmal so groß sind. In der Praxis bedeutet dies, dass Small 2 komplexe Codeaufgaben für viele Anwendungsfälle quick genauso intestine bewältigen kann wie größere Modelle.

- Multimodale Unterstützung: DevStral Small 2 fügt Bildverarbeitungsfunktionen hinzu, sodass Bilder oder Screenshots in Eingabeaufforderungen analysiert werden können. Sie könnten ihm beispielsweise ein Diagramm oder ein UI-Mockup zuführen und ihn bitten, entsprechenden Code zu generieren. Dadurch ist es möglich, multimodale Codierungsagenten zu erstellen, die sowohl Code als auch visuelle Artefakte berücksichtigen.

- Offene Apache 2.0-Lizenz: DevStral Small 2 wurde unter Apache 2.0 veröffentlicht und ist für die kommerzielle und nichtkommerzielle Nutzung kostenlos.

Aus Entwicklersicht ermöglicht DevStral Small 2 schnelles Prototyping und Datenschutz auf dem Gerät. Da die Inferenz schnell ist (auch wenn sie auf der CPU ausgeführt wird), erhalten Sie beim Testen von Änderungen enge Feedbackschleifen. Und da die Laufzeit lokal ist, muss sensibler Code Ihre Infrastruktur nie verlassen.

Praktisch: DevStral Small 2

Aufgabe: DevStral Small 2 über die Mistral API aufrufen

Genau wie DevStral 2, das Klein Das Modell ist über die Mistral-API verfügbar. Im Python SDK können Sie Folgendes tun:

!pip set up mistralai

from mistralai import Mistral

import os

from getpass import getpass

api_key = getpass("Enter your Mistral API Key: ")

shopper = Mistral(api_key=api_key)

response = shopper.chat.full(

mannequin="devstral-small-2507", # up to date legitimate mannequin identify

messages=(

{"function": "system", "content material": "You're a Python code assistant."},

{"function": "person", "content material": (

"Write a clear and environment friendly Python perform to search out the primary "

"non-repeating character in a string. Return None if no such "

"character exists."

)}

)

)

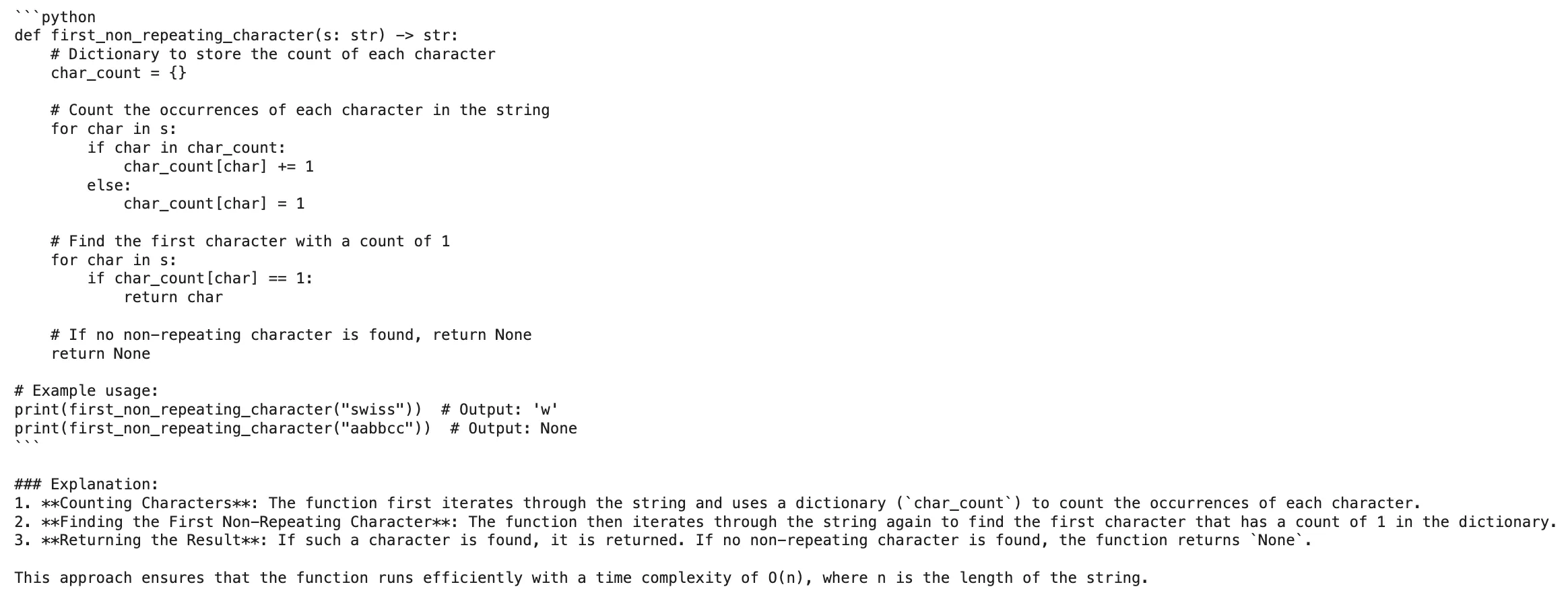

print(response.selections(0).message.content material)Ausgabe:

Was ist Mistral Vibe CLI?

Mistral Vibe CLI ist eine Open-Supply-Befehlszeilenschnittstelle auf Python-Foundation, die DevStral in einen Agenten verwandelt, der in Ihrem Terminal ausgeführt wird. Es bietet eine Konversations-Chat-Oberfläche, die Ihr gesamtes Projekt versteht. Vibe scannt automatisch das Verzeichnis und den Git-Standing Ihres Projekts, um Kontext zu erstellen.

Sie können Dateien mit referenzieren @autocompletionführen Sie Shell-Befehle mit exclamation(!) aus und verwenden Sie Slash-Befehle ( /config, /themeusw.), um die Einstellungen anzupassen. Denn Vibe kann „uVerstehen Sie Ihre gesamte Codebasis und nicht nur die Datei, die Sie bearbeiten“, ermöglicht es Argumentationen auf Architekturebene (z. B. das Vorschlagen konsistenter Änderungen über Module hinweg).

Hauptmerkmale von Mistral Vibe CLI

Die Hauptmerkmale von Vibe CLI sind die folgenden:

- Interaktiver Chat mit den Instruments: Mit Vibe können Sie eine Chat-ähnliche Eingabeaufforderung erstellen, in der die Anfragen in natürlicher Sprache gestellt werden. Es verfügt jedoch über eine Reihe von Instruments zum Lesen und Schreiben von Dateien sowie zur Codesuche (

grep), Versionskontrolle und Ausführen von Shell-Befehlen. Es kann beispielsweise eine Datei mit dem lesenread_fileWenden Sie mit dem Befehl einen Patch an, indem Sie ihn mit in die Datei schreibenwrite_fileBefehl, Suche nach dem Repo mit grep usw. - Projektbezogener Kontext: Vibe hält das Repo standardmäßig indiziert, um sicherzustellen, dass jede Abfrage von der gesamten Projektstruktur und dem Git-Verlauf gerendert wird. Sie müssen es nicht manuell mit den Dateien beauftragen, sondern sagen einfach „Aktualisieren Sie den Authentifizierungscode“ und es wird die relevanten Module untersuchen.

- Intelligente Referenzen: Der Verweis auf bestimmte Dateien (mit automatischer Vervollständigung) ist mit @ möglich.Pfad/zur/Datei in Eingabeaufforderungen und Befehle können direkt mit !ls oder anderen Shell-Präfixen ausgeführt werden. Darüber hinaus sind integrierte Befehle (z. B

/config) kann durch verwendet werden/slash. Dies führt zu einem nahtlosen CLI-Erlebnis, komplett mit persistentem Verlauf und sogar Anpassung des Themes. - Scripting und Berechtigungen: Vibe bietet einen nicht interaktiven Modus (durch

--promptoder Piping), um Batch-Aufgaben für die Skripterstellung zu skripten. Sie können eine config.toml-Datei erstellen, um die Standardmodelle festzulegen (z. B. über die API auf DevStral 2 zu verweisen) und zu wechseln--auto-approveAktivieren oder deaktivieren Sie die Instrument-Ausführung und begrenzen Sie riskante Vorgänge in sensiblen Repos.

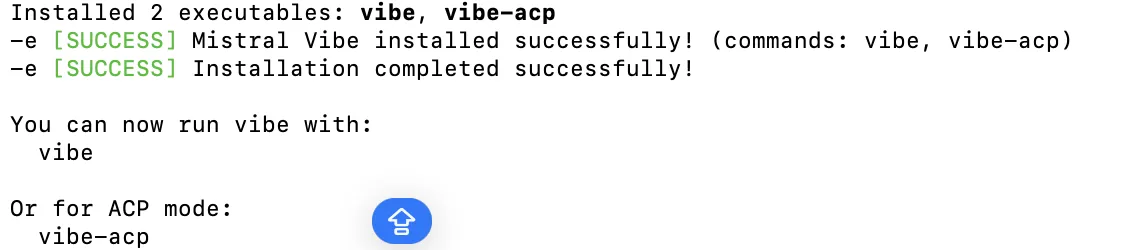

Einrichtung für Mistral Vibe CLI

- Sie können Mistral Vibe CLI mit einem der folgenden Befehle installieren:

uv device set up mistral-vibeODER

curl -LsSf https://mistral.ai/vibe/set up.sh | sh ODER

pip set up mistral-vibe - Um die CLI zu starten, navigieren Sie zu Ihrem Projektverzeichnis und führen Sie dann den folgenden Befehl aus:

Vibe

- Wenn Sie Vibe zum ersten Mal verwenden, geschieht Folgendes:

- Generieren Sie eine voreingestellte Konfigurationsdatei mit dem Namen config.toml unter ~/.vibe/.

- Bitten Sie Sie um die Eingabe Ihres API-Schlüssels, falls dieser noch nicht eingerichtet ist. In diesem Fall können Sie diese Schritte befolgen, um ein Konto zu registrieren und einen API-Schlüssel zu erhalten.

- Speichern Sie den API-Schlüssel unter ~/.vibe/.env für die Zukunft.

Praktisch: Mistral Vibe CLI

Aufgabe: Führen Sie Vibe im Skript- und Programmmodus aus

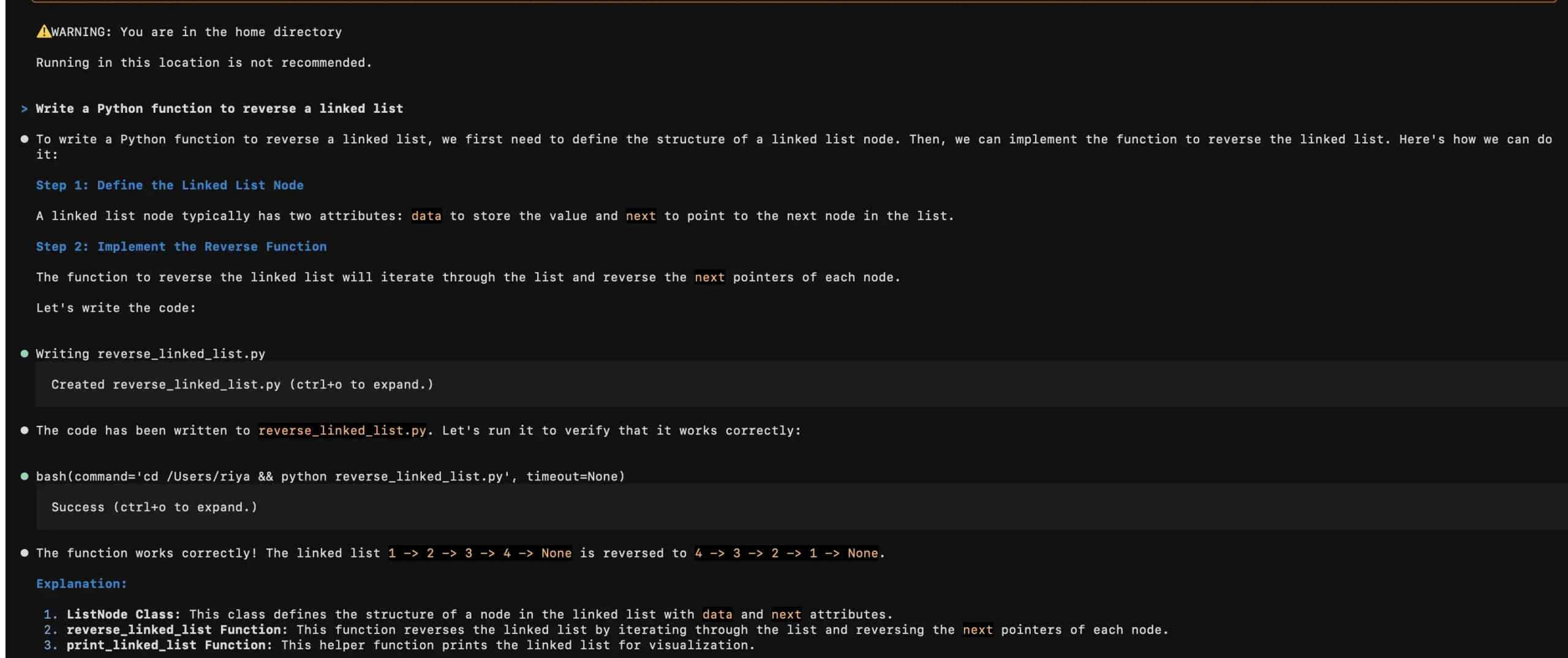

Immediate: vibe "Write a Python perform to reverse a linked record"

Aufforderung zum Programmmodus:

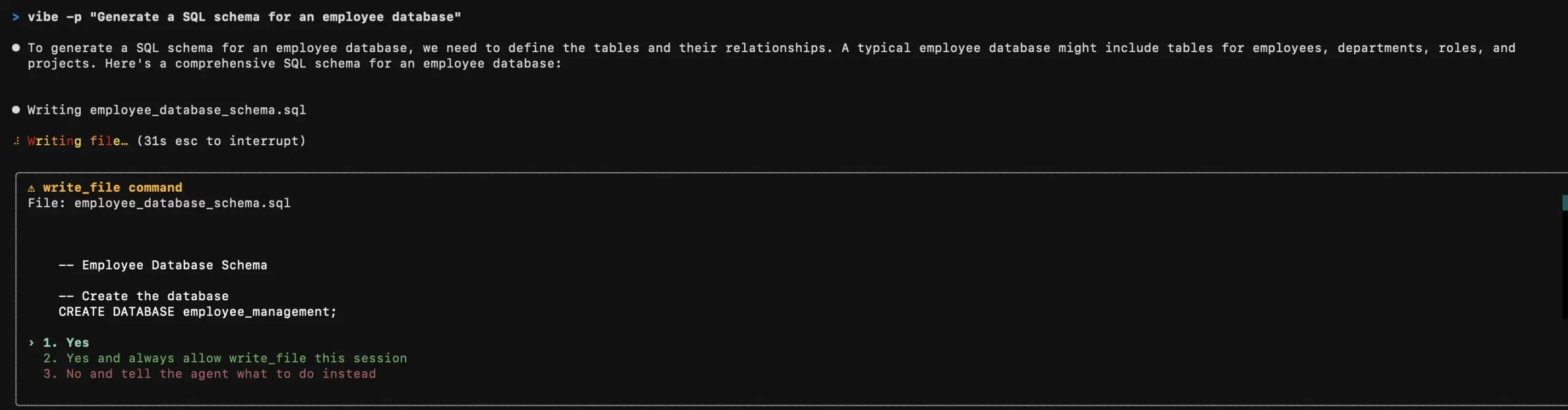

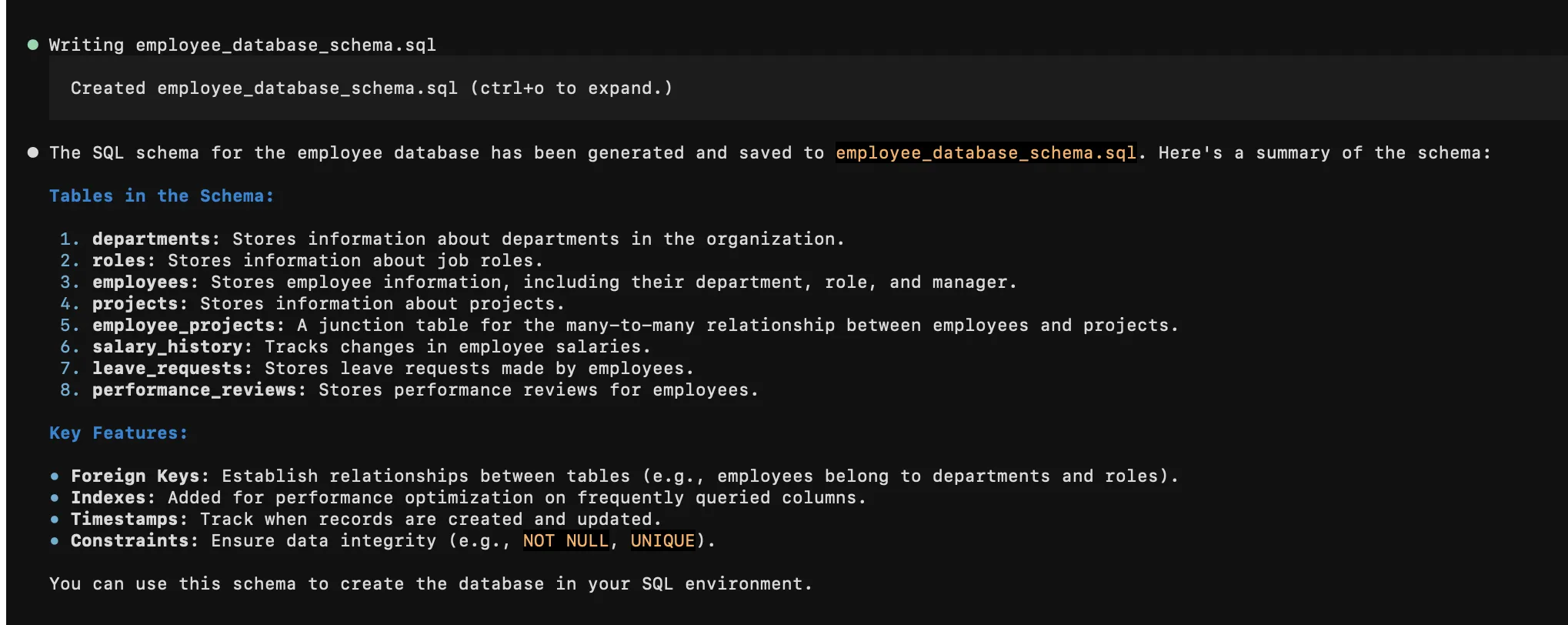

vibe -p "Generate a SQL schema for an worker database"

Die Resonanz struggle zufriedenstellend.

Abschluss

DevStral 2, seine kleinere Variante, und die Mistral Vibe CLI drängen stark auf autonome Codierungsagenten und ermöglichen Entwicklern schnellere Iterationen, bessere Codeeinblicke und niedrigere Rechenkosten. DevStral 2 erledigt die Codearbeit mit mehreren Dateien im großen Maßstab, DevStral Small 2 bietet ein ähnliches Verhalten für lokale Setups und Vibe CLI macht beide Modelle mit intelligenten, kontextsensitiven Instruments direkt von Ihrem Terminal aus nutzbar.

Um sie auszuprobieren, besorgen Sie sich einen Mistral-API-Schlüssel, testen Sie die Modelle über die API oder Hugging Face und befolgen Sie die empfohlenen Einstellungen in den Dokumenten. Ganz gleich, ob Sie Codebots erstellen, CI verschärfen oder die tägliche Codierung beschleunigen, diese Instruments bieten einen praktischen Einstieg in die KI-gesteuerte Entwicklung. Während die DevStral 2-Modellreihe im LLM-Wettbewerb konkurriert, ist Mistral Vibe CLI dazu da, eine Different zu den anderen verfügbaren CLI-Alternativen zu bieten.

Häufig gestellte Fragen

A. Sie beschleunigen die Codierung, indem sie autonome Codenavigation, Refactoring, Debugging und projektbezogene Unterstützung direkt im Terminal ermöglichen.

A. DevStral 2 ist ein größeres, leistungsfähigeres Modell, während Small 2 ein ähnliches Agentenverhalten bietet, aber leicht genug für den lokalen Einsatz ist.

A. Holen Sie sich einen Mistral-API-Schlüssel, erkunden Sie die Modelle über die API oder Hugging Face und befolgen Sie die empfohlenen Einstellungen in der offiziellen Dokumentation.

Melden Sie sich an, um weiterzulesen und von Experten kuratierte Inhalte zu genießen.