OpenAI-Modelle haben sich in den letzten Jahren drastisch weiterentwickelt. Die Reise begann mit GPT-3.5 und hat nun GPT-5.1 und die neueren Argumentationsmodelle der O-Serie erreicht. Während ChatGPT GPT-5.1 als primäres Modell verwendet, bietet Ihnen die API Zugriff auf viele weitere Optionen, die für verschiedene Arten von Aufgaben konzipiert sind. Einige Modelle sind auf Geschwindigkeit und Kosten optimiert, andere sind auf fundierte Überlegungen ausgelegt und wieder andere sind auf Bilder oder Audio spezialisiert.

In diesem Artikel werde ich Sie durch alle wichtigen Modelle führen, die über die API verfügbar sind. Anhand einfacher Codebeispiele erfahren Sie, wofür sich jedes Modell am besten eignet, für welche Artwork von Projekt es geeignet ist und wie man damit arbeitet. Ziel ist es, Ihnen ein klares Verständnis dafür zu vermitteln, wann Sie ein bestimmtes Modell auswählen und wie Sie es in einer realen Anwendung effektiv einsetzen können.

GPT-3.5 Turbo: Die Grundlagen moderner KI

Der GPT-3.5 Turbo leitete die Revolution der generativen KI ein. Der ChatGPT kann auch das Unique mit Strom versorgen und ist zudem eine stabile und kostengünstige Lösung für einfache Aufgaben. Das Modell beschränkt sich auf das Befolgen von Anweisungen und das Führen eines Gesprächs. Es hat die Fähigkeit, auf Fragen zu antworten, Texte zusammenzufassen und einfachen Code zu schreiben. Neuere Modelle sind intelligenter, aber GPT-3.5 Turbo kann immer noch für Aufgaben mit hohem Volumen eingesetzt werden, bei denen die Kosten im Vordergrund stehen.

Hauptmerkmale:

- Geschwindigkeit und Kosten: Es ist sehr schnell und sehr günstig.

- Aktion nach Anweisung: Es ist auch ein zuverlässiger Nachfolger einfacher Eingabeaufforderungen.

- Kontext: Es rechtfertigt das 4K-Token-Fenster (ca. 3.000 Wörter).

Praxisbeispiel:

Das Folgende ist eine kurze Zusammenfassung Python Skript zur Verwendung von GPT-3.5 Turbo für die Textzusammenfassung.

import openai

from google.colab import userdata

# Set your API key

consumer = openai.OpenAI(api_key=userdata.get('OPENAI_KEY'))

messages = (

{"position": "system", "content material": "You're a useful summarization assistant."},

{"position": "person", "content material": "Summarize this: OpenAI modified the tech world with GPT-3.5 in 2022."}

)

response = consumer.chat.completions.create(

mannequin="gpt-3.5-turbo",

messages=messages

)

print(response.selections(0).message.content material)Ausgabe:

GPT-4-Familie: Multimodale Kraftpakete

Der GPT-4 Familie warfare ein enormer Durchbruch. Solche Serien sind GPT-4, GPT-4 Turbo und der sehr effiziente GPT-4o. Diese Modelle sind multimodal, das heißt, sie können sowohl Textual content als auch Bilder verstehen. Ihre größte Stärke liegt in kompliziertem Denken, juristischer Recherche und kreativem, subtilem Schreiben.

GPT-4o-Funktionen:

- Multimodaler Enter: Es verarbeitet Texte und Bilder gleichzeitig.

- Geschwindigkeit: GPT-4o (o ist Omni) ist doppelt so schnell wie GPT-4.

- Preis: Es ist viel günstiger als das herkömmliche GPT-4-Modell.

Eine openAI-Studie ergab, dass GPT-4 bei den besten 10 Prozent der Personen, die den Take a look at absolvierten, einen simulierten Balkentest durchführte. Dies ist ein Hinweis auf seine Fähigkeit, mit anspruchsvoller Logik umzugehen.

Praktisches Beispiel (komplexe Logik):

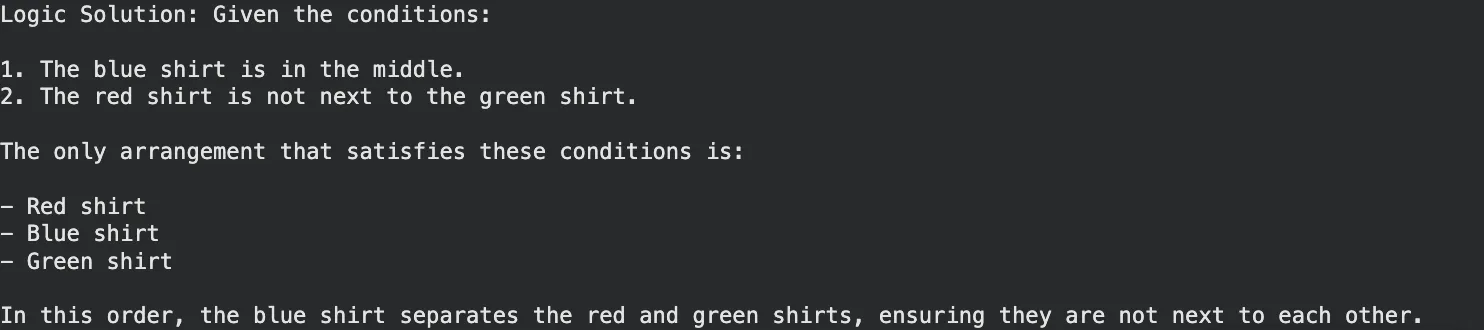

GPT-4o ist in der Lage, ein logisches Rätsel zu lösen, das logisches Denken beinhaltet.

messages = (

{"position": "person", "content material": "I've 3 shirts. One is crimson, one blue, one inexperienced. "

"The crimson is just not subsequent to the inexperienced. The blue is within the center. "

"What's the order?"}

)

response = consumer.chat.completions.create(

mannequin="gpt-4o",

messages=messages

)

print("Logic Answer:", response.selections(0).message.content material)Ausgabe:

Die o-Serie: Modelle, die denken, bevor sie sprechen

Ende 2024 und Anfang 2025 kündigte OpenAI die o-Serie (o1, o1-mini und o3-mini) an. Dies sind „Argumentationsmodelle“. Sie antworten nicht sofort, sondern nehmen sich im Gegensatz zu den normalen GPT-Modellen Zeit zum Nachdenken und Entwickeln einer Strategie. Dadurch sind sie in Mathematik, Naturwissenschaften und schwierigem Programmieren überlegen.

o1- und o3-mini-Highlights:

- Gedankenkette: Dieses Modell überprüft seine Schritte intern selbst und minimiert so Fehler.

- Programmierkenntnisse: o3-mini ist darauf ausgelegt, Codes schnell und genau zu verarbeiten.

- Effizienz: o3-mini ist ein hochintelligentes Modell zu einem günstigeren Preis im Vergleich zum kompletten o1-Modell.

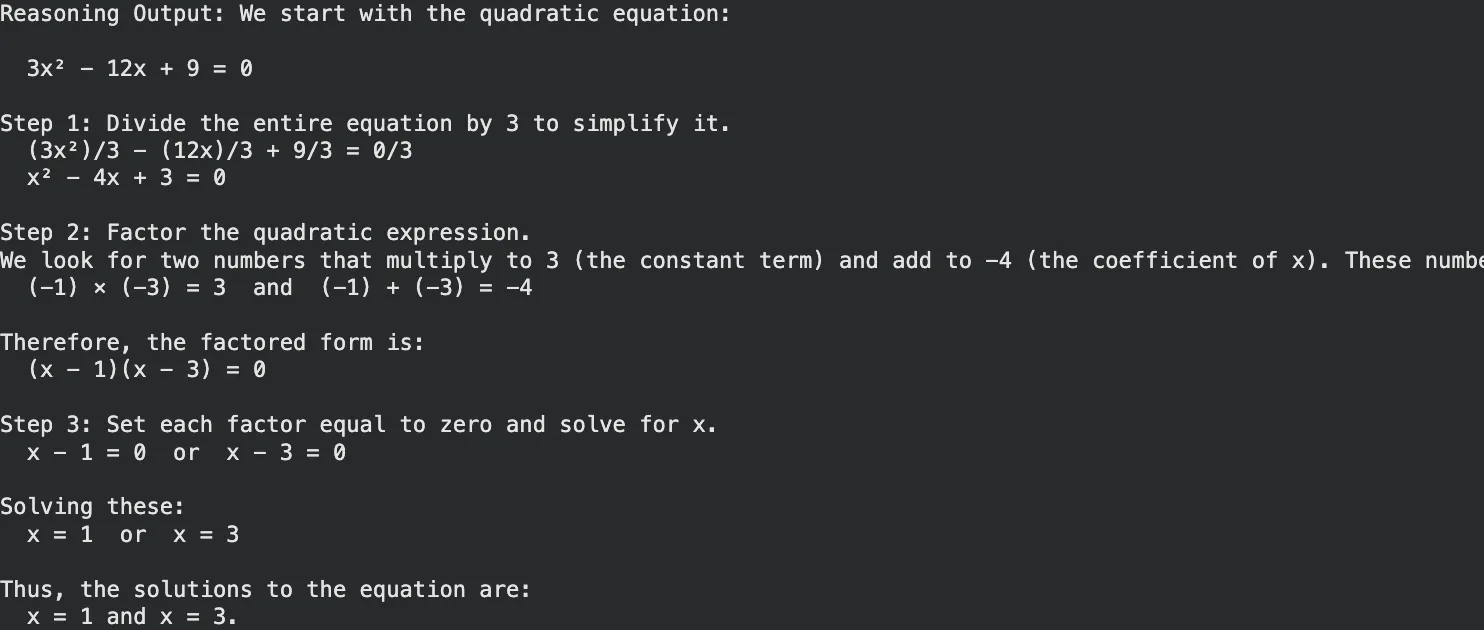

Praktisches Beispiel (Math Reasoning):

Verwenden Sie o3-mini für ein mathematisches Drawback, bei dem eine schrittweise Überprüfung entscheidend ist.

# Utilizing the o3-mini reasoning mannequin

response = consumer.chat.completions.create(

mannequin="o3-mini",

messages=({"position": "person", "content material": "Remedy for x: 3x^2 - 12x + 9 = 0. Clarify steps."})

)

print("Reasoning Output:", response.selections(0).message.content material)Ausgabe:

GPT-5 und GPT-5.1: Die nächste Technology

Beide GPT-5 und seine optimierte Model GPT-5.1das Mitte 2025 veröffentlicht wurde, vereinte Tempo und Logik. GPT-5 bietet integriertes Denken, bei dem das Modell selbst in kurzer Zeit bestimmt, wann es denken und wann es reagieren muss. Die Model, GPT-5.1, wurde verfeinert, um bessere Unternehmenskontrollen und weniger Halluzinationen zu bieten.

Was sie auszeichnet:

- Adaptives Denken: Es reicht von einfachen Abfragen bis zu einfachen Routen und von einfacher Argumentation bis hin zu harten Argumentationsrouten.

- Unternehmensklasse: GPT-5.1 bietet die Möglichkeit einer umfassenden Recherche mit Professional-Funktionen.

- Das GPT-Bild 1: Dies ist ein integriertes Menü, das ersetzt DALL-E 3 um eine reibungslose Bilderstellung im Chat zu gewährleisten.

Praxisbeispiel (Geschäftsstrategie):

GPT-5.1 eignet sich sehr intestine für die Prime-Degree-Strategie, die Allgemeinwissen und strukturiertes Denken erfordert.

# Instance utilizing GPT-5.1 for strategic planning

response = consumer.chat.completions.create(

mannequin="gpt-5.1",

messages=({"position": "person", "content material": "Draft a go-to-market technique for a brand new AI espresso machine."})

)

print("Technique Draft:", response.selections(0).message.content material)Ausgabe:

DALL-E 3 und GPT-Bild: Visuelle Kreativität

Für visuelle Daten stellt OpenAI DALL-E 3 und die neueren GPT-Picture-Modelle bereit. Diese Anwendungen verwandeln Textaufforderungen in wunderschöne, detaillierte Bilder. Wenn Sie mit DALL-E 3 arbeiten, können Sie Bilder, Logos und Schemata zeichnen, indem Sie sie einfach beschreiben.

Mehr lesen: Bildgenerierung mithilfe der GPT-Bild-API

Hauptfunktionen:

- Sofortmaßnahme: Ausführliche Anweisungen werden strikt befolgt.

- Integration: Es ist in ChatGPT und die API integriert.

Praxisbeispiel (Bildgenerierung):

Dieses Skript generiert eine Bild-URL basierend auf Ihrer Textaufforderung.

image_response = consumer.photos.generate(

mannequin="dall-e-3",

immediate="A futuristic metropolis with flying vehicles in a cyberpunk type",

n=1,

dimension="1024x1024"

)

print("Picture URL:", image_response.information(0).url)Ausgabe:

Whisper: Speech-to-Textual content-Beherrschung

Whisper Das Spracherkennungssystem entspricht dem neuesten Stand der Technik und wird von OpenAI bereitgestellt. Es ist in der Lage, Audioinhalte aus Dutzenden von ihnen bekannten Sprachen ins Englische zu transkribieren. Es ist resistent gegen Hintergrundgeräusche und Akzente. Der folgende Ausschnitt des Whisper API-Tutorials zeigt, wie einfach die Verwendung ist.

Praxisbeispiel (Transkription):

Stellen Sie sicher, dass Sie sich in einem Verzeichnis mit einer Audiodatei befinden (mit dem Namen „speech.mp3“).

audio_file = open("speech.mp3", "rb")

transcript = consumer.audio.transcriptions.create(

mannequin="whisper-1",

file=audio_file

)

print("Transcription:", transcript.textual content)Ausgabe:

Einbettungen und Moderation: Die Utility-Instruments

OpenAI verfügt über Gebrauchsmuster, die für die Entwickler von entscheidender Bedeutung sind.

- Einbettungen (text-embedding-3-small/massive): Diese werden verwendet, um Textual content als Zahlen (Vektoren) zu kodieren. Auf diese Weise können Sie Suchmaschinen erstellen, die die Bedeutung anstelle von Schlüsselwörtern entschlüsseln können.

- Mäßigung: Dies ist eine kostenlose API, die Textinhalte auf Hassrede, Gewalt oder Selbstverletzung überprüft, um sicherzustellen, dass Apps sicher sind.

Praxisbeispiel (Semantische Suche):

Dadurch wird die Tatsache entdeckt, dass eine Ähnlichkeit zwischen einer Anfrage und einem Produkt besteht.

# Get embeddings

resp = consumer.embeddings.create(

enter=("smartphone", "banana"),

mannequin="text-embedding-3-small"

)

# In an actual app, you examine these vectors to search out the very best match

print("Vector created with dimension:", len(resp.information(0).embedding))Ausgabe:

Feinabstimmung: Anpassen Ihrer KI

Die Feinabstimmung ermöglicht das Coaching eines Modells anhand seiner eigenen Daten. GPT-4o-mini oder GPT-3.5 können verfeinert werden, um einen bestimmten Ton, ein bestimmtes Format oder einen bestimmten Branchenjargon aufzunehmen. Dies ist im Fall von Unternehmensanwendungen, die lediglich eine allgemeine Reaktion erfordern, von großer Bedeutung.

So funktioniert es:

- Bereiten Sie eine JSON-Datei mit Trainingsbeispielen vor.

- Laden Sie die Datei auf OpenAI hoch.

- Beginnen Sie mit der Feinabstimmung.

- Verwenden Sie Ihre neue benutzerdefinierte Modell-ID in der API.

Abschluss

Die OpenAI-Modelllandschaft bietet für nahezu jede digitale Aufgabe ein Werkzeug. Von der Geschwindigkeit von GPT-3.5 Turbo bis zur Argumentationsleistung von o3-mini und GPT-5.1 haben Entwickler zahlreiche Möglichkeiten. Sie können mit Whisper Sprachanwendungen erstellen, mit DALL-E 3 visuelle Belongings erstellen oder Daten mit den neuesten Reasoning-Modellen analysieren.

Die Eintrittsbarrieren bleiben niedrig. Sie benötigen lediglich einen API-Schlüssel und ein Konzept. Wir empfehlen Ihnen, die in diesem Handbuch bereitgestellten Skripte zu testen. Experimentieren Sie mit den verschiedenen Modellen, um ihre Stärken zu verstehen. Finden Sie das richtige Gleichgewicht zwischen Kosten, Geschwindigkeit und Intelligenz für Ihre spezifischen Anforderungen. Die Technologie ist vorhanden, um Ihre nächste Anwendung voranzutreiben. Es liegt nun an Ihnen, es anzuwenden.

Häufig gestellte Fragen

A. GPT-4o ist ein universelles multimodales Modell, das sich für die meisten Aufgaben eignet. o3-mini ist ein Argumentationsmodell, das für komplexe mathematische, naturwissenschaftliche und Codierungsprobleme optimiert ist.

A. Nein, DALL-E 3 ist ein kostenpflichtiges Modell, dessen Preis professional generiertem Bild berechnet wird. Die Kosten variieren je nach Auflösung und Qualitätseinstellungen.

A. Ja, das Whisper-Modell ist Open Supply. Sie können es auf Ihrer eigenen {Hardware} ausführen, ohne API-Gebühren zu zahlen, vorausgesetzt, Sie verfügen über eine GPU.

A. GPT-5.1 unterstützt ein riesiges Kontextfenster (häufig 128.000 Token oder mehr), sodass ganze Bücher oder lange Codebasen auf einmal verarbeitet werden können.

A. Diese Modelle stehen Entwicklern über die OpenAI-API und Benutzern über ChatGPT Plus-, Staff- oder Enterprise-Abonnements zur Verfügung.

Melden Sie sich an, um weiterzulesen und von Experten kuratierte Inhalte zu genießen.