Wenn es um ein Trainingsmodell geht, setzen Unternehmen in der Regel darauf, ihm immer mehr Daten für das Coaching zuzuführen.

Größere Datensätze = intelligentere Modelle

Als DeepSeek erstmals veröffentlicht wurde, stellte es diesen Ansatz in Frage und legte neue Definitionen fest Modelltraining. Und danach kam eine neue Welle des Modelltrainings mit weniger Daten und optimiertem Ansatz. Ich bin auf eine solche Forschungsarbeit gestoßen: LIMI: Weniger ist mehr für intelligente Agenturen und es hat mich wirklich süchtig gemacht. Es wird erläutert, wie Sie nicht Tausende von Beispielen benötigen, um eine leistungsstarke KI aufzubauen. Tatsächlich reichen nur 78 sorgfältig ausgewählte Trainingsbeispiele aus, um die auf 10.000 trainierten Modelle zu übertreffen.

Wie? Indem wir uns auf Qualität statt Quantität konzentrieren. Anstatt das Modell mit sich wiederholenden oder oberflächlichen Beispielen zu überfluten, nutzt LIMI reichhaltige, reale Szenarien aus der Softwareentwicklung und wissenschaftlichen Forschung. Jedes Beispiel erfasst den gesamten Bogen der Problemlösung: Planung, Werkzeugnutzung, Debugging und Zusammenarbeit.

Das Ergebnis? Ein Modell, das nicht nur Dinge „weiß“, sondern auch Dinge tut. Und das geht besser, schneller und mit weit weniger Daten.

Dieser Artikel erklärt, wie LIMI funktioniert!

Wichtige Erkenntnisse

- Handlungsfähigkeit ist definiert als die Fähigkeit von KI-Systemen, autonom zu handeln und Probleme durch selbstgesteuerte Interaktion mit Werkzeugen und Umgebungen zu lösen.

- Der LIMI-Ansatz verwendet nur 78 hochwertige, strategisch gestaltete Trainingsbeispiele mit Schwerpunkt auf kollaborativer Softwareentwicklung und wissenschaftlicher Forschung.

- In der Evaluierungssuite AgencyBench erreicht LIMI eine Leistung von 73,5 % und übertrifft damit führende Modelle wie GLM-4.5 (45,1 %), Kimi-K2 (24,1 %) und DeepSeek-V3.1 (11,9 %) bei weitem.

- LIMI zeigt eine Verbesserung von 53,7 % gegenüber Modellen, die auf 10.000 Proben trainiert wurden, wobei 128-mal weniger Daten verwendet werden.

- Die Studie führt das Prinzip der Agentureffizienz ein: Maschinenautonomie ergibt sich nicht aus der Datenmenge, sondern aus der strategischen Kuratierung qualitativ hochwertiger Agentendemonstrationen.

- Die Ergebnisse lassen sich auf Codierung, Device-Nutzung und wissenschaftliche Argumentations-Benchmarks verallgemeinern und bestätigen, dass das „Weniger ist mehr“-Paradigma weitgehend auf die Agenten-KI anwendbar ist.

Was ist Agentur?

Das Papier definiert Agentur als eine aufstrebende Fähigkeit, bei der KI-Systeme autonom funktionieren Agenten. Diese Agenten warten nicht auf Schritt-für-Schritt-Anleitungen. Stattdessen:

- Entdecken Sie aktiv Probleme

- Formulieren Sie Hypothesen

- Führen Sie mehrstufige Lösungen aus

- Interagieren Sie mit Umgebungen und Instruments

Dies steht in krassem Gegensatz zu traditionellen Sprachmodellen, die zwar Antworten generieren, aber nicht handeln können. Reale Anwendungen wie das Debuggen von Code, die Verwaltung von Forschungsworkflows oder der Betrieb von Microservices erfordern diese Artwork von proaktiver Intelligenz.

Der Wandel von der „denkenden KI“ zur „arbeitenden KI“ wird durch die Bedürfnisse der Branche vorangetrieben. Unternehmen suchen heute nach Systemen, die Aufgaben durchgängig erledigen und nicht nur Fragen beantworten können.

Warum können weniger Daten effektiver sein?

Seit über einem Jahrzehnt folgt der KI-Fortschritt einer Regel: Skalierung. Größere Modelle. Mehr Token. Größere Datensätze. Und es hat funktioniert: für das Sprachverständnis. Neuere Arbeiten in anderen Bereichen legen jedoch etwas anderes nahe:

- LIMO (2025) zeigte, dass sich komplexes mathematisches Denken mit nur 817 kuratierten Beispielen um 45,8 % verbessert.

- LIMA (2023) zeigte, dass eine Modellausrichtung mit nur 1.000 hochwertigen Beispielen erreicht werden kann.

Aber Agentur ist anders. Sie können das Erstellen nicht lernen, indem Sie Millionen von Codefragmenten lesen. Sie lernen, indem Sie es tun. Und um gute Ergebnisse zu erzielen, sind dichte, originalgetreue Beispiele erforderlich: nicht nur Volumen.

Stellen Sie sich das so vor, als würden Sie kochen lernen. Wenn Sie sich 10.000 Kochvideos ansehen, lernen Sie möglicherweise Vokabeln. Aber in einer praktischen Sitzung mit einem Koch, bei der Sie hacken, würzen, abschmecken und anpassen, lernen Sie, wie man kocht.

LIMI wendet diese Idee auf das KI-Coaching an. Anstatt endlose Protokolle von Device-Aufrufen zu sammeln, werden 78 vollständige „Kochsitzungen“ kuratiert, von denen jede eine vollständige, erfolgreiche Zusammenarbeit zwischen Mensch und KI bei einer komplexen Aufgabe darstellt.

Das Ergebnis? Das Modell lernt das Wesen der Agentur: wie man plant, sich anpasst und liefert.

Der LIMI-Ansatz: Drei Kerninnovationen

Der Erfolg von LIMI basiert auf drei methodischen Säulen:

Agentische Abfragesynthese

Abfragen sind keine generischen Eingabeaufforderungen. Sie simulieren reale kollaborative Aufgaben in der Softwareentwicklung („Vibe Coding“) und der wissenschaftlichen Forschung. Das Staff sammelte:

- 60 reale Anfragen von professionellen Entwicklern und Forschern.

- 18 synthetische Abfragen, die aus GitHub Pull Requests mit GPT-5 generiert wurden, um Authentizität und technische Tiefe zu gewährleisten.

Protokoll zur Flugbahnerfassung

Für jede Abfrage zeichnete das Staff vollständige Interaktionsverläufe und Multi-Flip-Sequenzen auf, die Folgendes umfassen:

- Schritte zur Modellbegründung

- Device-Aufrufe (z. B. Dateibearbeitungen, API-Anfragen)

- Umgebungsfeedback (z. B. Fehlermeldungen, Benutzererklärungen)

Diese Trajektorien umfassen durchschnittlich 42.400 Token, wobei einige über 150.000 Token liegen, und erfassen so die gesamte Komplexität der kollaborativen Problemlösung.

Konzentrieren Sie sich auf Domänen mit hoher Auswirkung

Alle 78 Trainingsbeispiele stammen aus zwei Bereichen, die den Großteil der Wissensarbeit ausmachen:

- Vibe-Codierung: Kollaborative Softwareentwicklung mit iterativem Debuggen, Testen und Device-Nutzung.

- Forschungsworkflows: Literatursuche, Datenanalyse, Versuchsplanung und Berichterstellung.

Dieser Fokus stellt sicher, dass jedes Trainingsbeispiel reich an Agentensignalen ist.

Datensatzkonstruktion: Von GitHub zur Mensch-KI-Zusammenarbeit

Der LIMI-Datensatz wurde durch eine sorgfältige Pipeline erstellt:

Schritt 1: Erstellung eines Abfragepools

Echte Anfragen kamen aus tatsächlichen Entwickler- und Forscher-Workflows. Synthetische Abfragen wurden aus 100 hochrangigen GitHub-Repositories abgeleitet und nach sinnvollen Codeänderungen gefiltert (mit Ausnahme von reinen Dokumentations-PRs).

Schritt 2: Qualitätskontrolle

Vier Annotatoren auf Doktoratsebene überprüften alle Abfragen auf semantische Übereinstimmung mit realen Aufgaben. Nur die besten 78 wurden ausgewählt.

Schritt 3: Trajektoriengenerierung

Mithilfe der SII-CLI-Umgebung, einer Schnittstelle mit vielen Instruments, die Codeausführung, Dateisystemzugriff und Websuche unterstützt, arbeiteten menschliche Annotatoren mit GPT-5 zusammen, um jede Aufgabe zu erledigen. Jede erfolgreiche Flugbahn wurde vollständig protokolliert.

Das Ergebnis ist ein kompakter, aber äußerst umfangreicher Datensatz, in dem jede Stichprobe Stunden realistischer Problemlösung enthält.

Bewertung: AgencyBench und mehr

Um die Fähigkeiten von LIMI zu testen, nutzte das Staff AgencyBench, einen neuen Benchmark mit 10 komplexen, realen Aufgaben:

- Vibe-Codierungsaufgaben (4):

- C++-Chat-System mit Login, Freunden, Parallelität

- Java-To-Do-App mit Suche und Mehrbenutzersynchronisierung

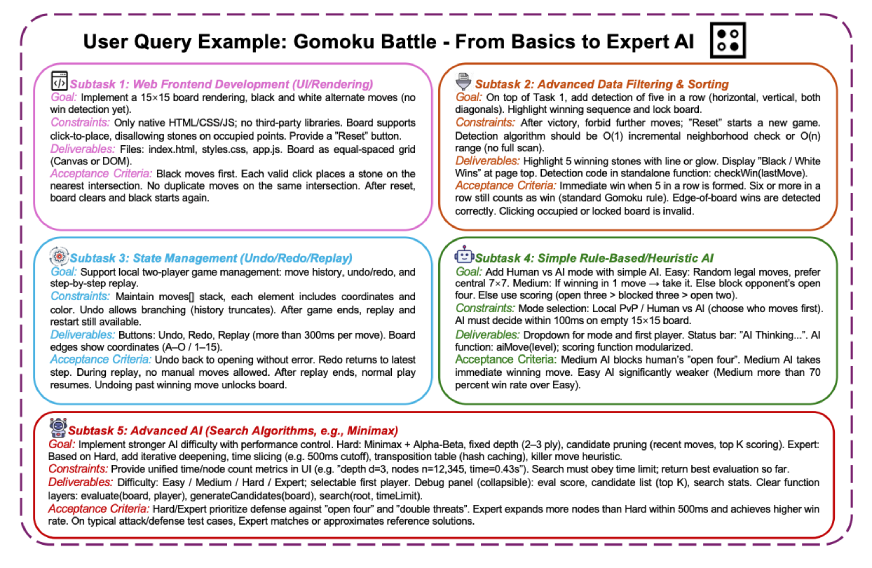

- Webbasiertes Gomoku-Spiel mit KI-Gegnern

- Selbstreparierende Microservice-Pipeline

- Forschungsworkflow-Aufgaben (6):

- Vergleich der LLM-Leistung im DynToM-Datensatz

- Statistische Analyse von Argumentation im Vergleich zu direkten Modellen

- Datensatzerkennung auf Hugging Face

- Wissenschaftliche Funktionsanpassung mit hoher Präzision

- Komplexe Argumentation zum Handel mit NBA-Spielern

- S&P 500-Unternehmensanalyse anhand von Finanzdaten

Jede Aufgabe hat mehrere Unteraufgaben, die Planung, Werkzeugnutzung und iterative Verfeinerung erfordern.

Zusätzlich zu AgencyBench wurde LIMI anhand von Generalisierungsbenchmarks getestet:

- SciCode (Wissenschaftliches Rechnen)

- TAU2-Financial institution (Werkzeuggebrauch)

- EvalPlus-HumanEval/MBPP (Codegenerierung)

- DS-1000 (Datenwissenschaft)

Experimentelle Ergebnisse

LIMI wurde durch Feinabstimmung von GLM-4.5 (355B-Parameter) am 78-Proben-Datensatz implementiert. Es wurde verglichen mit:

- Basismodelle: GLM-4.5, Kimi-K2, DeepSeek-V3.1, Qwen3

- Datenreiche Varianten: Auf CC-Bench (260 Proben), AFM-WebAgent (7.610) und AFM-CodeAgent (10.000) trainierte Modelle

Auf AgencyBench erreichte LIMI 73,5 % und lag damit weit vor allen Mitbewerbern:

- Funktionale Vollständigkeit in der ersten Runde: 71,7 % vs. 37,8 % (GLM-4,5)

- Erfolgsquote (innerhalb von 3 Runden): 74,6 % vs. 47,4 %

- Effizienz (ungenutzte Runden): 74,2 % vs. 50,0 %

Noch auffälliger: LIMI übertraf das 10.000-Samples-Modell um 53,7 % absolute Punkte und verwendete dabei 128-mal weniger Samples.

Bei Generalisierungs-Benchmarks lag der LIMI im Durchschnitt bei 57,2 % und übertraf damit alle Baselines und datenreichen Varianten. Es erzielte Spitzenwerte bei der Codierung (92,1 % bei HumanEval) und Wettbewerbsergebnisse bei der Werkzeugnutzung (45,6 % bei TAU2-retail).

Die Rolle der SII-CLI-Umgebung

Die SII-CLI ist eine benutzerdefinierte Befehlszeilenschnittstelle, die Folgendes unterstützt:

- Dateisystemnavigation

- Codeausführung

- Websuche

- API-Aufrufe

- Multi-Device-Orchestrierung

In Experimenten wurde LIMI mit und ohne CLI-Zugriff verglichen. Auch ohne Instruments erreichte LIMI bei Generalisierungs-Benchmarks 50,0 % und lag damit immer noch vor GLM-4.5 (48,7 %). Dies beweist, dass Verbesserungen dem Modell innewohnen und nicht nur eine bessere Werkzeugnutzung.

Mit dem CLI-Zugriff stieg die Leistung jedoch auf 57,2 %, was zeigt, dass LIMI auch lernt, Instruments effektiv zu orchestrieren: eine wichtige Agentenfähigkeit.

Fallstudien: Leistung in der Praxis

Das Papier enthält detaillierte Fallvergleiche:

- Gomoku-Spiel (Aufgabe 3):

GLM-4.5 schlug beim Board-Rendering, der Win-Erkennung und der KI-Logik fehl. LIMI erledigte alle Teilaufgaben mit minimalem Eingriff.

- Datensatzerkennung (Aufgabe 7):

GLM-4.5 hat weniger relevante Datensätze abgerufen. Die Entscheidungen von LIMI entsprachen besser den Anforderungen der Abfrage (z. B. Philosophie des KI-Bewusstseins, dänische Klassifizierung von Hassreden). - Wissenschaftliche Funktionsanpassung (Aufgabe 8):

GLM-4.5 erreichte nach mehreren Eingabeaufforderungen einen Verlust von 1,14e-6. LIMI erreicht 5,95e-7 beim ersten Versuch. - NBA-Argumentation (Aufgabe 9):

GLM-4.5 schlug häufig fehl oder erforderte maximale Eingabeaufforderungen. LIMI löste die meisten Unteraufgaben mit null oder einem Hinweis und verbrauchte dabei weniger Token und weniger Zeit.

Diese Beispiele veranschaulichen die überlegene Argumentation, Werkzeugnutzung und Anpassungsfähigkeit von LIMI.

Lesen Sie auch: Vereinfachen Sie Modelltraining und -tests mit MultiTrain

Endgültiges Urteil

LIMI legt das Agentureffizienzprinzip fest:

Maschinenautonomie entsteht nicht aus der Datenfülle, sondern aus der strategischen Kuratierung hochwertiger Agentendemonstrationen.

Dies stellt die Abhängigkeit der Branche von riesigen Datenpipelines in Frage. Stattdessen wird Folgendes vorgeschlagen:

- Das Wesen der Entscheidungsfreiheit verstehen ist wichtiger als die Skalierung von Daten

- Kleine, von Experten entworfene Datensätze kann Leistung auf dem neuesten Stand der Technik liefern

- Nachhaltige KI-Entwicklung ist ohne enorme Rechen- oder Datenkosten möglich

Für Praktiker bedeutet dies, in die Aufgabengestaltung, Protokolle für die Zusammenarbeit zwischen Mensch und KI und die Qualität der Flugbahn zu investieren: nicht nur in das Datenvolumen.

Lesen Sie auch: Den Archite verstehenCture von Qwen3-Subsequent-80B-A3B

Abschluss

Das LIMI-Papier vermittelt eine mutige Botschaft: Man braucht keine 10.000 Beispiele, um einer KI beizubringen, wie sie funktioniert. Du brauchst 78 wirklich gute. Durch die Konzentration auf qualitativ hochwertige, praxisnahe Zusammenarbeit erreicht LIMI mit einem Bruchteil der Daten modernste Agentenleistung. Es beweist, dass es bei der Agentur nicht um Größe geht. Es geht um Sign.

Da sich die KI von Chatbots auf Kollegen verlagert, wird diese Erkenntnis von entscheidender Bedeutung sein. Die Zukunft gehört nicht denen, die die meisten Daten sammeln, sondern denen, die die sinnvollsten Lernerfahrungen gestalten.

Im Zeitalter von Agentische KIweniger ist nicht einfach mehr. Es ist besser!

Melden Sie sich an, um weiterzulesen und von Experten kuratierte Inhalte zu genießen.