Bild vom Autor

# Das Setup

Sie sind gerade dabei, ein Modell zu trainieren, als Sie feststellen, dass 20 % Ihrer Werte fehlen. Lassen Sie diese Zeilen fallen? Füllen Sie sie mit Durchschnittswerten aus? Etwas Ausgefalleneres verwenden? Die Antwort ist wichtiger als Sie denken.

Wenn Sie googeln, finden Sie Dutzende Imputationsmethoden, von ganz einfach (verwenden Sie einfach den Mittelwert) bis hin zu ausgefeilten (iterative Modelle für maschinelles Lernen). Man könnte meinen, dass ausgefallene Methoden besser sind. KNN berücksichtigt ähnliche Zeilen. MÄUSE erstellt Vorhersagemodelle. Sie müssen einfach nur den Durchschnitt übertreffen, oder?

Das dachten wir auch. Wir haben uns geirrt.

# Das Experiment

Wir haben uns das geschnappt Datensatz mit Ernteempfehlungen aus StrataScratch-Projekten – 2.200 Bodenproben aus 22 Pflanzenarten mit Merkmalen wie Stickstoffgehalt, Temperatur, Luftfeuchtigkeit und Niederschlag. Ein Random Forest erreicht bei diesem Ding eine Genauigkeit von 99,6 %. Es ist quick verdächtig sauber.

Diese Analyse erweitert unsere Agrardatenanalyse Projekt, das denselben Datensatz durch EDA und statistische Exams untersucht. Hier fragen wir: Was passiert, wenn saubere Daten auf ein reales Downside treffen – fehlende Werte?

Perfekt für unser Experiment.

Wir haben 20 % fehlende Werte eingeführt (völlig zufällig, um Sensorausfälle zu simulieren) und dann fünf Imputationsmethoden getestet:

Unsere Exams waren gründlich; Wir verwendeten eine 10-fache Kreuzvalidierung über fünf zufällige Startwerte (insgesamt 50 Durchläufe professional Methode). Um sicherzustellen, dass keine Informationen aus dem Testsatz in den Trainingssatz gelangen, wurden unsere Imputationsmodelle nur auf den Trainingssätzen trainiert. Für unsere statistischen Exams haben wir die Bonferroni-Korrektur angewendet. Wir haben auch die Eingabemerkmale sowohl für KNN als auch für MICE normalisiert. Wenn wir sie nicht normalisiert hätten, hätte eine Eingabe mit Werten zwischen 0 und 300 (Niederschlag) eine viel größere Auswirkung als eine Eingabe mit einem Bereich von 3 bis 10 (pH), wenn wir die Entfernungsberechnung für diese Methoden durchführen. Vollständiger Code und reproduzierbare Ergebnisse sind in unserem verfügbar Notizbuch.

Dann ließen wir es laufen und starrten auf die Ergebnisse.

# Die Überraschung

Folgendes haben wir erwartet: KNN oder MICE würden gewinnen, weil sie schlauer sind. Sie berücksichtigen Beziehungen zwischen Options. Sie nutzen echtes maschinelles Lernen.

Das haben wir bekommen:

Der Median und der Mittelwert liegen gleichauf auf dem ersten Platz. Auf den Plätzen drei und vier landeten die anspruchsvollen Methoden.

Wir haben den statistischen Take a look at durchgeführt. Mittelwert vs. Median: p = 0,7. Nicht einmal annähernd bedeutsam. Sie sind praktisch identisch.

Aber hier ist der Clou: Beide übertrafen KNN und MICE deutlich (p < 0,001 nach Bonferroni-Korrektur). Die einfachen Methoden passten nicht nur zu den ausgefallenen. Sie haben sie geschlagen.

# Warte, was?

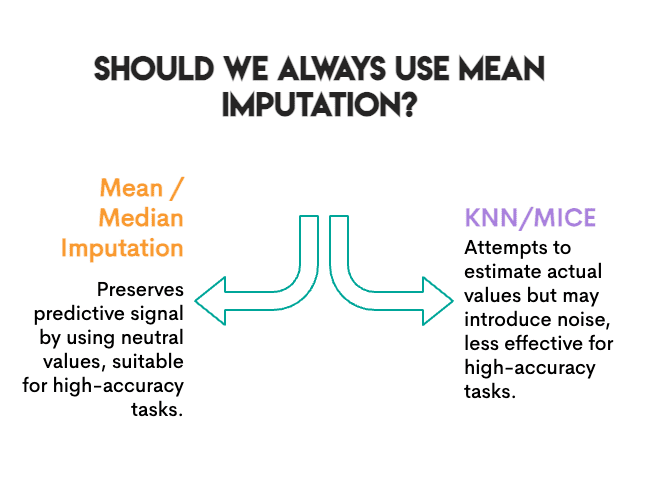

Bevor Sie Ihre MICE-Set up verwerfen, wollen wir uns mit der Ursache befassen.

Die Aufgabe battle die Vorhersage. Wir haben die Genauigkeit gemessen. Klassifiziert das Modell Nutzpflanzen nach der Imputation immer noch korrekt? Für dieses spezifische Ziel kommt es darauf an, das Vorhersagesignal beizubehalten, nicht unbedingt die genauen Werte.

Die mittlere Imputation bewirkt etwas Interessantes: Sie ersetzt fehlende Werte durch einen „neutralen“ Wert, der das Modell nicht in Richtung einer bestimmten Klasse drängt. Es ist langweilig, aber es ist sicher. Der Random Forest kann immer noch seine Entscheidungsgrenzen finden.

KNN und MICE geben sich mehr Mühe; Sie schätzen, wie hoch der tatsächliche Wert gewesen sein könnte. Dabei können sie jedoch Lärm verursachen. Wenn die nächsten Nachbarn nicht so ähnlich sind oder wenn die iterative Modellierung von MICE falsche Muster erkennt, fügen Sie möglicherweise Fehler hinzu, anstatt sie zu entfernen.

Die Grundlinie battle bereits hoch. Mit einer Genauigkeit von 99,6 % ist dies ein ziemlich einfaches Klassifizierungsproblem. Wenn das Sign stark ist, spielen Imputationsfehler weniger eine Rolle. Etwas Lärm kann sich das Modell leisten.

Zufälliger Wald ist sturdy. Baumbasierte Modelle verarbeiten unvollständige Daten intestine. Ein lineares Modell hatte mehr mit der Varianzverzerrung der Mittelwertimputation zu kämpfen.

Nicht so schnell.

# Der Plot Twist

Wir haben noch etwas anderes gemessen: die Korrelationserhaltung.

Das Besondere an echten Daten ist, dass Funktionen nicht isoliert existieren. Sie ziehen zusammen. Wenn der Boden in unserem Datensatz einen hohen Phosphorgehalt aufweist, weist er normalerweise auch einen hohen Kaliumgehalt auf (Korrelation von 0,74). Das ist kein Zufall; Landwirte fügen diese Nährstoffe normalerweise zusammen hinzu, und bestimmte Bodentypen behalten beide auf ähnliche Weise bei.

Wenn Sie fehlende Werte imputieren, können diese Beziehungen versehentlich unterbrochen werden. Die mittlere Imputation trägt „durchschnittliches Kalium“ ein, unabhängig davon, wie Phosphor in dieser Zeile aussieht. Wenn Sie das oft genug tun, beginnt die Verbindung zwischen P und Ok zu schwinden. Ihre unterstellten Daten mögen Spalte für Spalte intestine aussehen, aber die Beziehungen zwischen den Spalten lösen sich langsam auf.

Warum ist das wichtig? Wenn Ihr nächster Schritt ist Clusterbildung, PCAoder einer Analyse, bei der es um Function-Beziehungen geht, arbeiten Sie mit beschädigten Daten und wissen es nicht einmal.

Wir haben überprüft: Wie viel von dieser P↔Ok-Korrelation blieb nach der Imputation erhalten?

Bild vom Autor

Die Rangliste drehte sich völlig um.

KNN hat die Korrelation nahezu perfekt beibehalten. Imply und Median zerstörten etwa ein Viertel davon. Und die Zufallsstichprobe (bei der die Werte für jede Spalte unabhängig abgetastet werden) beseitigte die Beziehung.

Das macht Sinn. Bei der Mittelwertimputation werden fehlende Werte durch die gleiche Zahl ersetzt, unabhängig davon, wie die anderen Merkmale aussehen. Wenn eine Reihe einen hohen Stickstoffgehalt aufweist, ist es Imply egal; es unterstellt immer noch den durchschnittlichen Kaliumwert. KNN betrachtet ähnliche Zeilen. Wenn additionally Zeilen mit hohem N dazu neigen, einen hohen Ok-Wert zu haben, wird ein hoher Ok-Wert unterstellt.

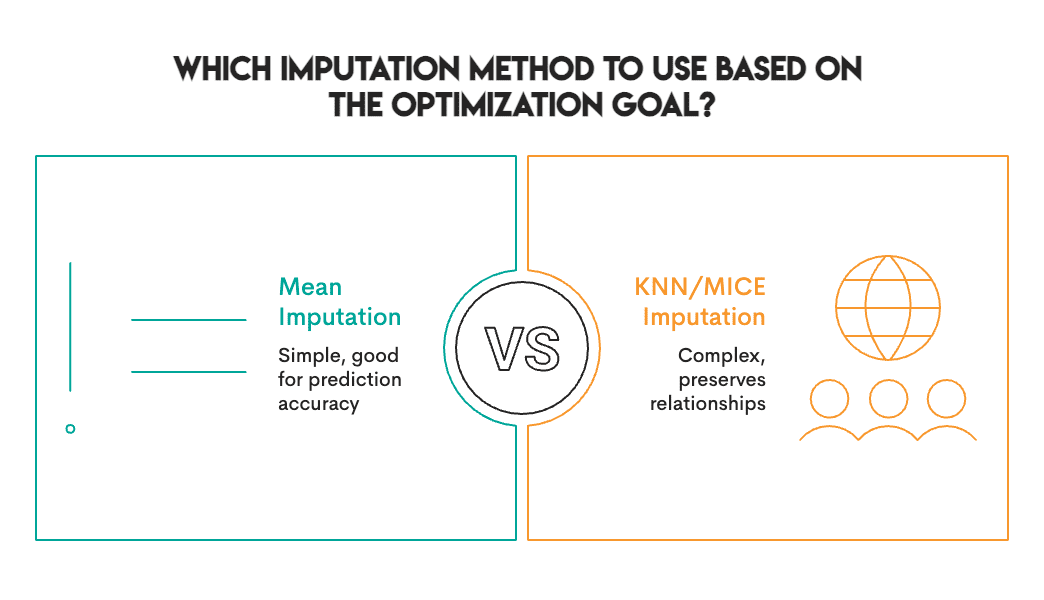

# Der Kompromiss

Hier ist die eigentliche Erkenntnis: Es gibt keine einzelne beste Imputationsmethode. Wählen Sie stattdessen die am besten geeignete Methode basierend auf Ihrem spezifischen Ziel und Kontext.

Die Genauigkeitsrankings und Korrelationsrankings sind nahezu gegensätzlich:

Bild vom Autor

(Zumindest ist die Zufallsstichprobe konsistent – sie ist in allem schlecht.)

Dieser Kompromiss gilt nicht nur für unseren Datensatz. Es hängt davon ab, wie diese Methoden funktionieren. Mittelwert/Median sind univariat und betrachten jeweils eine Spalte. KNN/MICE sind multivariat und berücksichtigen Beziehungen. Univariate Methoden bewahren Randverteilungen, zerstören jedoch die Korrelation. Multivariate Methoden bewahren die Struktur und können eine Kind von Vorhersagefehlern/-rauschen erzeugen.

# Was sollten Sie additionally eigentlich tun?

Nachdem Sie dieses Experiment durchgeführt und die Literatur durchgesehen haben, finden Sie hier unseren praktischen Leitfaden:

Verwenden Sie Mittelwert oder Median, wenn:

- Ihr Ziel ist die Vorhersage (Klassifizierung, Regression)

- Sie verwenden ein robustes Modell (Random Forest, XGBoost, neuronale Netze).

- Die Fehlquote liegt unter 30 %.

- Sie brauchen schnell etwas

Verwenden Sie KNN, wenn:

- Sie müssen Function-Beziehungen beibehalten

- Nachgelagerte Aufgaben sind Clustering, PCA oder Visualisierung

- Sie möchten, dass Korrelationen für die explorative Analyse bestehen bleiben

Verwenden Sie MICE, wenn:

- Sie benötigen gültige Standardfehler (für statistische Schlussfolgerungen)

- Sie geben Konfidenzintervalle oder p-Werte an

- Der Mechanismus für fehlende Daten könnte MAR (Lacking at Random) sein.

Vermeiden Sie Zufallsstichproben:

- Es ist verlockend, weil es „die Verteilung bewahrt“

- Aber es zerstört alle multivariaten Strukturen

- Wir konnten keinen guten Anwendungsfall finden

# Die ehrlichen Vorbehalte

Wir haben einen Datensatz, eine fehlende Fee (20 %), einen Mechanismus (MCAR) und ein Downstream-Modell (Random Forest). Ihr Setup kann variieren. Die Literatur zeigt, dass bei anderen Datensätzen MissForest und MICE schneiden oft besser ab. Unsere Feststellung, dass einfache Methoden konkurrieren, ist actual, aber nicht universell.

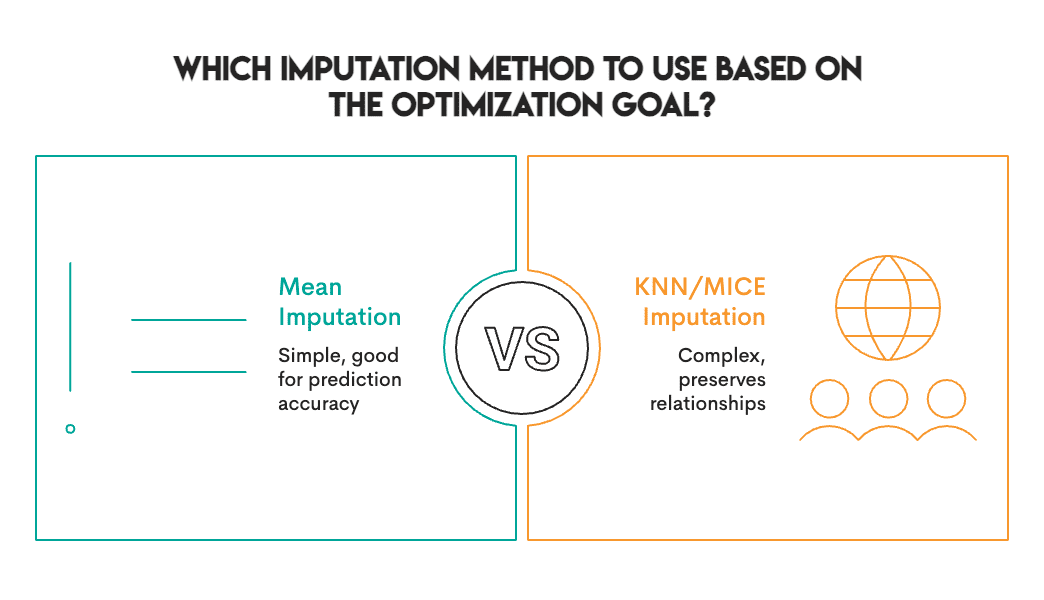

# Das Fazit

Wir gingen in dieses Experiment, um zu bestätigen, dass ausgefeilte Imputationsmethoden die Komplexität wert sind. Stattdessen stellten wir fest, dass sich der bescheidene Mittelwert hinsichtlich der Vorhersagegenauigkeit behaupten konnte, während er die Beziehungen zwischen den Merkmalen überhaupt nicht aufrechterhielt.

Die Lektion lautet nicht: „Verwenden Sie immer die mittlere Imputation.“ Es geht darum: „Wissen Sie, wofür Sie optimieren.“

Bild vom Autor

Wenn Sie nur Vorhersagen benötigen, fangen Sie einfach an. Testen Sie, ob KNN oder MICE bei Ihren Daten tatsächlich weiterhilft. Gehen Sie nicht davon aus, dass sie es tun werden.

Wenn Sie die Korrelationsstruktur für eine nachgelagerte Analyse benötigen, wird Imply sie stillschweigend zerstören und Ihnen gleichzeitig vollkommen vernünftige Genauigkeitszahlen liefern. Das ist eine Falle.

Und was auch immer Sie tun: Skalieren Sie Ihre Funktionen, bevor Sie KNN verwenden. Vertrauen Sie uns in dieser Sache.

Nate Rosidi ist Datenwissenschaftler und in der Produktstrategie tätig. Er ist außerdem außerordentlicher Professor für Analytik und Gründer von StrataScratch, einer Plattform, die Datenwissenschaftlern hilft, sich mit echten Interviewfragen von Prime-Unternehmen auf ihre Interviews vorzubereiten. Nate schreibt über die neuesten Developments auf dem Karrieremarkt, gibt Ratschläge zu Vorstellungsgesprächen, stellt Knowledge-Science-Projekte vor und behandelt alles rund um SQL.