Gesponserte Inhalte

Wie viel Zeit verbringen Sie damit, Ihre Werkzeuge zu bekämpfen, anstatt Probleme zu lösen? Jeder Datenwissenschaftler struggle dort: Downsampling eines Datensatzes, da er nicht in den Speicher passt oder eine Möglichkeit hackt, einen Unternehmensbenutzer mit einem maschinellen Lernmodell interagieren zu lassen.

Die ideale Umgebung gerät aus dem Weg, damit Sie sich auf die Analyse konzentrieren können. Dieser Artikel umfasst acht praktische Methoden in BigQuery, die genau das tun, von der Verwendung von AI-betriebenen Agenten bis hin zum Servieren von ML-Modellen direkt aus einer Tabelle.

1. maschinelles Lernen in Ihren Tabellenkalkulationen

BQML -Schulung und Vorhersage aus einem Google -Blatt

Viele Datengespräche beginnen und enden in einer Tabelle. Sie sind vertraut, einfach zu bedienen und großartig für die Zusammenarbeit. Aber was passiert, wenn Ihre Daten zu groß für eine Tabelle sind oder wenn Sie eine Vorhersage ausführen möchten, ohne eine Reihe von Code zu schreiben? Verbundene Blätter Hilft, indem Sie Milliarden von Zeilen von BigQuery -Daten von der Google Sheets -Schnittstelle analysieren. Alle Berechnungen, Diagramme und Pivot -Tabellen werden von BigQuery hinter den Kulissen angetrieben.

Wenn Sie noch einen Schritt weiter gehen, können Sie auch auf Modelle zugreifen, mit denen Sie aufgebaut sind BigQuery Machine Studying (BQML). Stellen Sie sich vor, Sie haben ein BQML -Modell, das die Immobilienpreise vorhersagt. Mit verbundenen Blättern kann ein Geschäftskräfte ein Blatt öffnen, Daten für eine neue Eigenschaft (Quadratmeterzahl, Anzahl der Schlafzimmer, Ort) eingeben, und eine Formel kann ein BQML -Modell aufrufen, um eine Preisschätzung zurückzugeben. Keine Python oder API -Wrangling benötigt – nur eine Blattformel, die ein Modell aufruft. Es ist eine leistungsstarke Möglichkeit, maschinelles Lernen nicht-technischen Groups auszusetzen.

2. Keine Kosten BigQuery Sandbox und Colab Notebooks

Der Einstieg mit Unternehmensdatenlagern beinhaltet häufig die Reibung, z. B. die Einrichtung eines Abrechnungskontos. Der BigQuery Sandbox Entfernt diese Barriere und lassen Sie Sie bis zu 1 Terabyte Daten professional Monat abfragen. Keine Kreditkarte erforderlich. Es ist ein großartiger, günstiger Weg, mit dem Lernen und Experimentieren mit großem Maßstab zu beginnen.

Als Datenwissenschaftler können Sie von einem auf Ihre BigQuery Sandbox zugreifen Colab Pocket book. Mit nur wenigen Zeilen Authentifizierungscode können Sie SQL -Abfragen direkt aus einem Pocket book ausführen und die Ergebnisse zur Analyse in einen Python -Datenframe ziehen. Dieselbe Pocket book -Umgebung kann sogar als KI -Associate fungieren, um Ihre Analyse zu planen und Code zu schreiben.

3.. Ihr KI-betriebener Associate in Colab Notebooks

Knowledge Science Agent in einem Colab -Notizbuch (Sequenzen verkürzt, Ergebnisse für veranschaulichende Zwecke)

Colab -Notizbücher sind jetzt Eine AI-erste Erfahrung Entwickelt, um Ihren Workflow zu beschleunigen. Sie können Code aus natürlicher Sprache generieren, automatische Fehlererklärungen abrufen und mit einem Assistenten neben Ihrem Code chatten.

Colab Notebooks haben auch einen integrierten Knowledge Science Agent. Betrachten Sie es als einen ML -Experten, mit dem Sie zusammenarbeiten können. Beginnen Sie mit einem Datensatz – wie einem lokalen CSV oder einer BigQuery -Tabelle – und einem hochrangigen Ziel, wie „Erstellen Sie ein Modell, um die Kundendehnung vorherzusagen“. Der Agent erstellt einen Plan mit vorgeschlagenen Schritten (z. B. Datenreinigung, Function Engineering, Modelltraining) und schreibt den Code.

Und Sie haben immer die Kontrolle. Der Agent generiert Code direkt in Pocket book -Zellen, führt aber nichts von selbst aus. Sie können jede Zelle überprüfen und bearbeiten, bevor Sie entscheiden, was auszuführen ist, oder den Agenten sogar bitten, seinen Ansatz zu überdenken und verschiedene Techniken auszuprobieren.

4. skalieren Sie Ihre Pandas -Workflows mit BigQuery -Datenframes

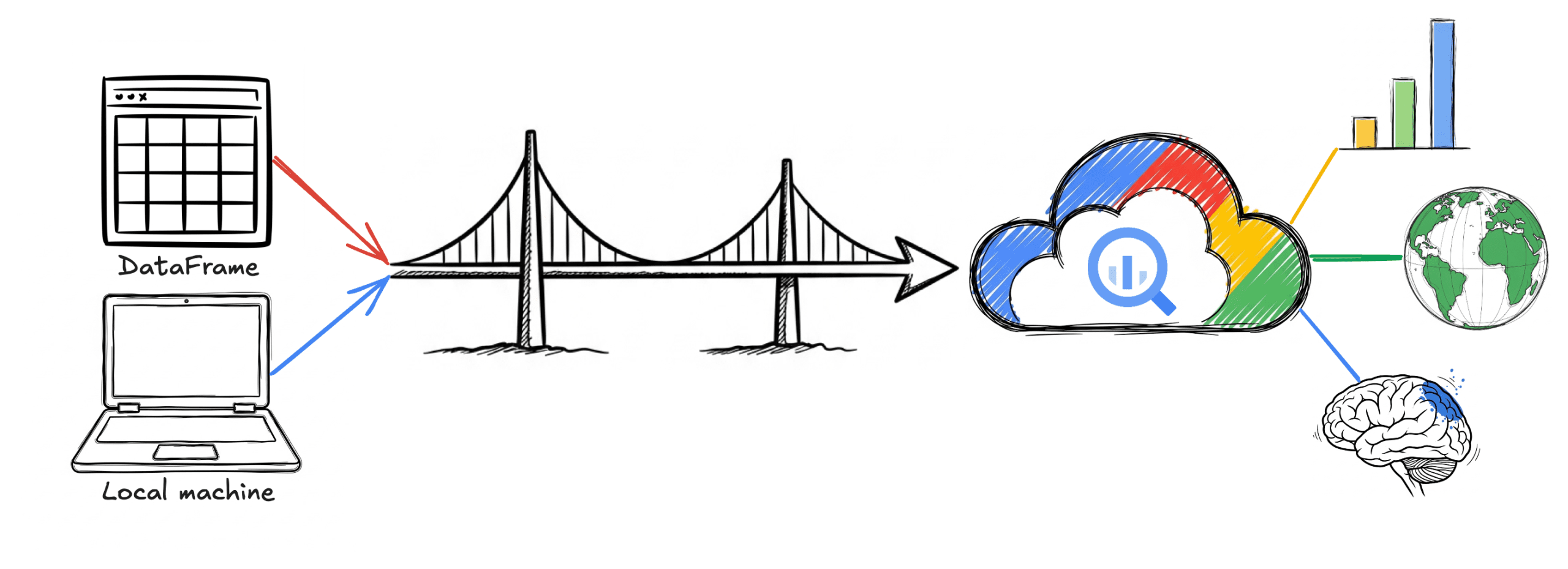

Viele Datenwissenschaftler leben in Notizbüchern und verwenden Pandas -Datenrahmen für die Datenmanipulation. Es gibt jedoch eine bekannte Grenze: Alle Daten, die Sie verarbeiten, müssen in den Speicher Ihrer Maschine passen. MemoryError Ausnahmen sind nur allzu häufig und zwingen Sie, Ihre Daten frühzeitig zu verkleinern.

Dies ist das genaue Drawback BigQuery DataFrames löst. Es bietet eine Python -API absichtlich ähnlich wie Pandas. Anstatt lokal auszuführen, übersetzt es Ihre Befehle in SQL und führt sie auf der BigQuery Engine aus. Dies bedeutet, dass Sie mit Datasets im Terabyte-Scale-Maßnahmen aus Ihrem Pocket book mit einer vertrauten API und ohne Sorgen um Speicherbeschränkungen arbeiten können. Das gleiche Konzept gilt für das Modelltraining mit einer scikit-larn-ähnlichen API, die das Modelltraining in BigQuery ML überschreitet.

5. Spark ML in BigQuery Studio Notebooks

Beispiel Spark ML Pocket book in BigQuery Studio

Apache Spark ist ein nützliches Device von Function Engineering bis zum Modellieren von Schulungen, aber die Verwaltung der Infrastruktur struggle schon immer eine Herausforderung. Serverlos für Apache Spark Sie können Spark -Code ausführen, einschließlich Jobs mit Bibliotheken wie Xgboost, Pytorch und Transformers, ohne einen Cluster bereitstellen zu müssen. Sie können sich entwickeln interaktiv Von einem Notizbuch direkt in BigQuery aus, sodass Sie sich auf die Modellentwicklung konzentrieren können, während BigQuery die Infrastruktur behandelt.

Sie können Serverless Spark verwenden, um in Ihrem BigQuery -Lagerhaus mit denselben Daten (und demselben Governance -Modell) zu arbeiten.

6. Fügen Sie den externen Kontext mit öffentlichen Datensätzen hinzu

High 5 Trendbedingungen in der Area Los Angeles Anfang Juli 2025

Ihre Erstanbieter-Daten sagen Ihnen, was passiert ist, kann aber nicht immer erklären, warum. Um diesen Kontext zu finden, können Sie Ihren Daten mit einer großen Sammlung öffentlicher Datensätze in BigQuery anschließen.

Stellen Sie sich vor, Sie sind Datenwissenschaftlerin für eine Einzelhandelsmarke. Sie sehen einen Umsatzspiegel für einen Regenmantel im pazifischen Nordwesten. Warfare es Ihre jüngste Marketingkampagne oder etwas anderes? Durch Beitritt zu Ihren Verkaufsdaten mit dem Google Traits Dataset In BigQuery können Sie schnell sehen, ob Suchanfragen nach „wasserdichte Jacke“ in derselben Area und in derselben Zeitspanne stiegen.

Oder sagen wir, Sie planen ein neues Geschäft. Sie können die verwenden Platziert Insights Dataset Um die Verkehrsmuster und die Geschäftsdichte in potenziellen Stadtteilen zu analysieren und diese über Ihre Kundeninformationen zu legen, um den besten Standort auszuwählen. Mit diesen öffentlichen Datensätzen können Sie umfangreichere Modelle erstellen, die reale Faktoren berücksichtigen.

7. Geospatial Analytics in Skala

BigQuery Geo Viz Karte eines Hurrikans mit Farbe, um Radius und Windgeschwindigkeit anzugeben

Gebäudlich-bewährte Funktionen für ein Modell können komplex sein, aber BigQuery vereinfacht dies durch Unterstützung von a GEOGRAPHY Datentyp und Customary GIS -Funktionen innerhalb von SQL. Auf diese Weise können Sie räumliche Funktionen direkt an der Quelle konstruieren. Wenn Sie beispielsweise ein Modell zur Vorhersage von Immobilienpreisen erstellen, können Sie eine Funktion wie ST_DWithin verwenden, um die Anzahl der öffentlichen Transitstopps innerhalb eines Kilometerradius für jede Eigenschaft zu berechnen. Sie können diesen Wert dann direkt als Eingabe für Ihr Modell verwenden.

Sie können dies weiter mitnehmen Google Earth Engine Integration, die Petabyte von Satellitenbildern und Umweltdaten in BigQuery bringt. Für dasselbe Immobilienmodell können Sie die Daten von Earth Engine abfragen, um Funktionen wie das historische Hochwasserrisiko oder sogar die Dichte der Baumabdeckung hinzuzufügen. Auf diese Weise können Sie viel reichhaltigere Modelle aufbauen, indem Sie Ihre Geschäftsdaten mit Umweltinformationen im Planetenmaßstab erhöhen.

8. Machen Sie einen Sinn für Protokolldaten

Die meisten Menschen denken an BigQuery für analytische Daten, aber es ist auch ein leistungsstarkes Ziel für Betriebsdaten. Sie können alle Ihre weiterleiten Cloud -Protokollierungsdaten für BigQueryUnstrukturierte Textprotokolle in abfragbare Ressourcen. Auf diese Weise können Sie SQL über Protokolle aus allen Ihren Diensten ausführen, um Probleme zu diagnostizieren, Leistung zu verfolgen oder Sicherheitsereignisse zu analysieren.

Für einen Datenwissenschaftler ist diese Cloud -Protokollierungsdaten eine umfangreiche Quelle, um Vorhersagen aus zu erstellen. Stellen Sie sich vor, Sie untersuchen einen Rückgang der Benutzeraktivität. Nachdem Sie eine Fehlermeldung in den Protokollen identifiziert haben, können Sie verwenden BigQuery Vectorsuche semantisch ähnliche Protokolle finden, auch wenn sie nicht genau denselben Textual content enthalten. Dies könnte dazu beitragen, verwandte Probleme wie „Person -Token Invalid“ und „Authentifizierung fehlgeschlagen“ zu enthüllen, die Teil derselben Grundursache sind. Sie können diese markierten Daten dann verwenden, um ein Anomalie -Erkennungsmodell zu trainieren, das Muster proaktiv kennzeichnet.

Abschluss

Hoffentlich lösten diese Beispiele einige neue Ideen für Ihr nächstes Projekt aus. Von Scaling Pandas DataFrames bis hin zu Engineering -Daten mit geografischen Daten ist das Ziel, Ihnen bei der Arbeit mit vertrauten Instruments zu helfen.

Bereit, einen Schuss zu machen? Sie können heute in der heute kostenlos erkunden BigQuery Sandbox!

Autor: Jeff Nelson, Entwicklerbeziehungsingenieur