NVIDIA Vera Rubin-Plattform

Diejenigen, die erwartet hatten, dass NVIDIA-CEO Jensen Huang die Bereitstellung eines Updates für seinen nächsten großen KI-Chip – den Vera-Rubin-Prozessor, der erstmals letzten März auf der GTC-Konferenz des Unternehmens in San Jose besprochen wurde – bis zur bevorstehenden GTC-Konferenz im März verzögern würden, waren gestern Abend überrascht, als Huang gestern Abend auf der CES in Las Vegas Particulars über den Chip veröffentlichte und sagte, der neue Chip sei in „voller Produktion“ und werde in der zweiten Hälfte dieses Jahres verfügbar sein.

Zu den Markenzeichen von NVIDIA, die sich vom Verhalten der Technologieunternehmen in der Vergangenheit unterscheiden, gehört es, neue Produkte pünktlich oder früher als geplant zu liefern und gleichzeitig eine Roadmap zu verfolgen, die frei von der Angst vor „Kannibalismus“ ist, additionally der Sorge, dass neue Produkte den potenziellen Umsatz bestehender, noch auf dem Markt befindlicher Produkte verschlingen. Auch wenn NVIDIA in der Tat nicht jeden Greenback aus den Vorgängern von Vera Rubin herausgequetscht hat, hat das Unternehmen mit seinem rasanten Produktrhythmus einen enormen Druck auf seine Konkurrenten ausgeübt und gleichzeitig riesige Mengen an Chips an einen Marktsektor geliefert, in dem eine ständige Nachfrage nach den neuesten und besten Chips besteht, unabhängig davon, wie schnell diese eingeführt werden: die Hyperscaler und KI-Cloud-Unternehmen.

Von Vera Rubin hat Huang ihn gestern Abend als überragenden Leistungsträger positioniert, der die fünffache KI-Rechenleistung des aktuellen Flaggschiff-Chips von Grace Blackwell liefert.

Laut NVIDIA nutzt die Rubin-Plattform ein extremes Codesign auf sechs Chips – der NVIDIA Vera-CPU, der NVIDIA Rubin-GPU, dem NVIDIA NVLink 6 Swap, dem NVIDIA ConnectX-9 SuperNIC, der NVIDIA BlueField-4 DPU und dem NVIDIA Spectrum-6 Ethernet Swap –, die zusammen die Trainingszeit und die Inferenz-Token-Kosten senken, so das Unternehmen.

„Rubin kommt genau zum richtigen Zeitpunkt, da die Nachfrage nach KI-Computing sowohl für Coaching als auch für Inferenz rasant steigt“, sagte Huang. „Mit unserer jährlichen Kadenz, eine neue Technology von KI-Supercomputern zu liefern – und extremem Codesign auf sechs neuen Chips – macht Rubin einen riesigen Sprung in Richtung der nächsten Grenze der KI.“

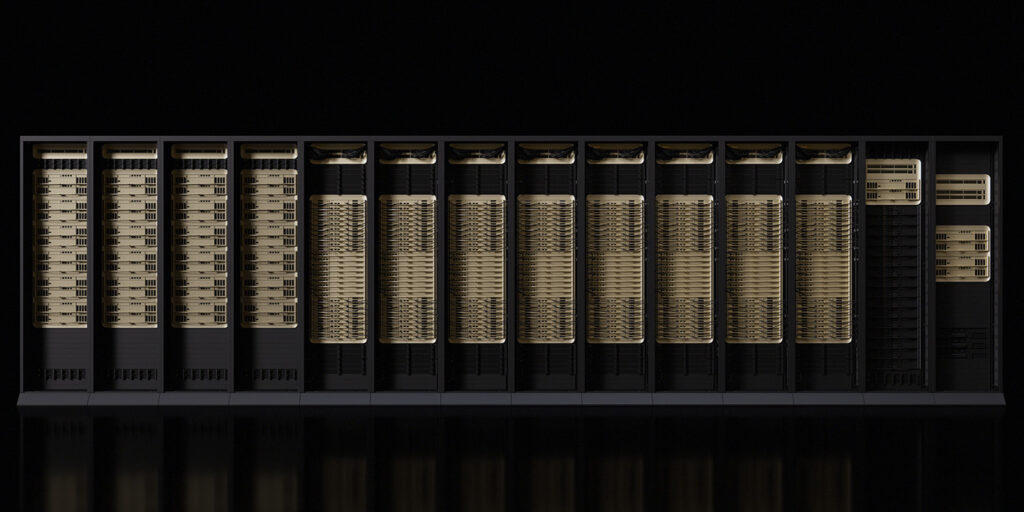

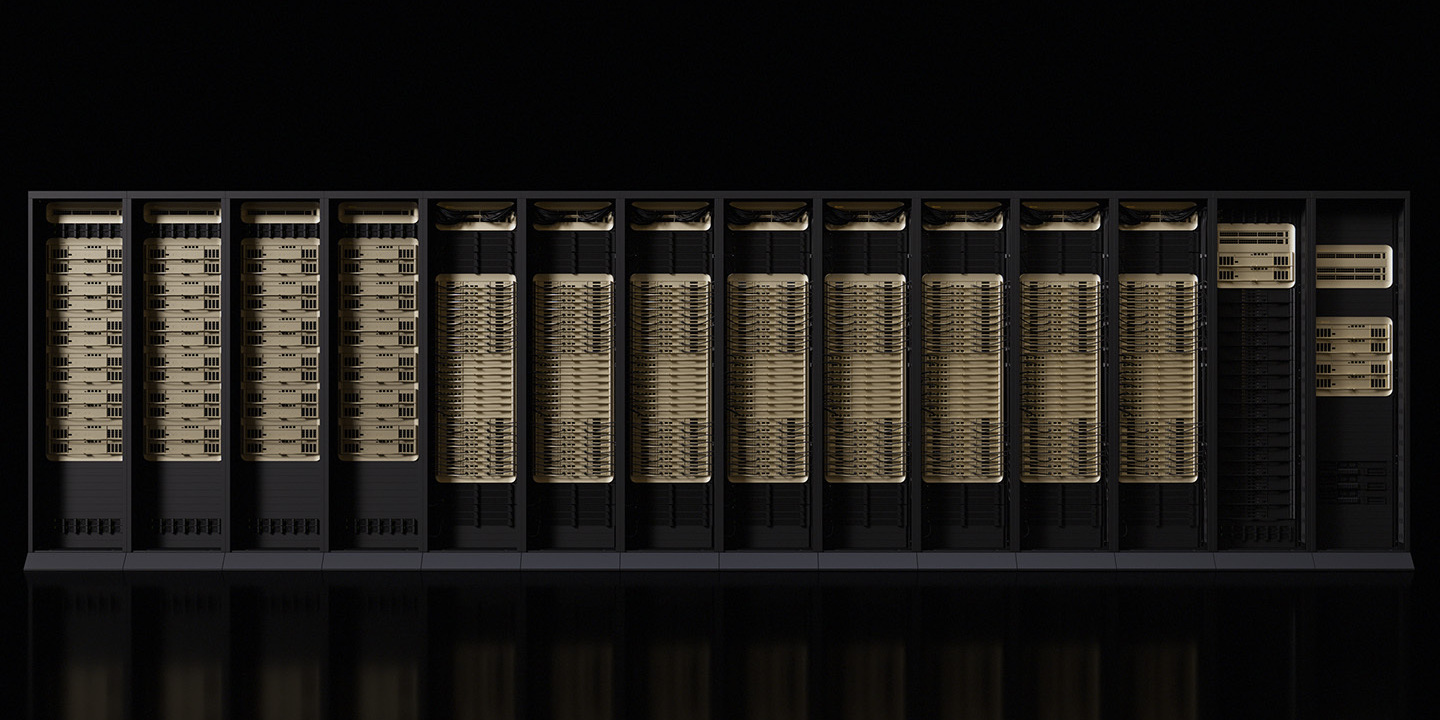

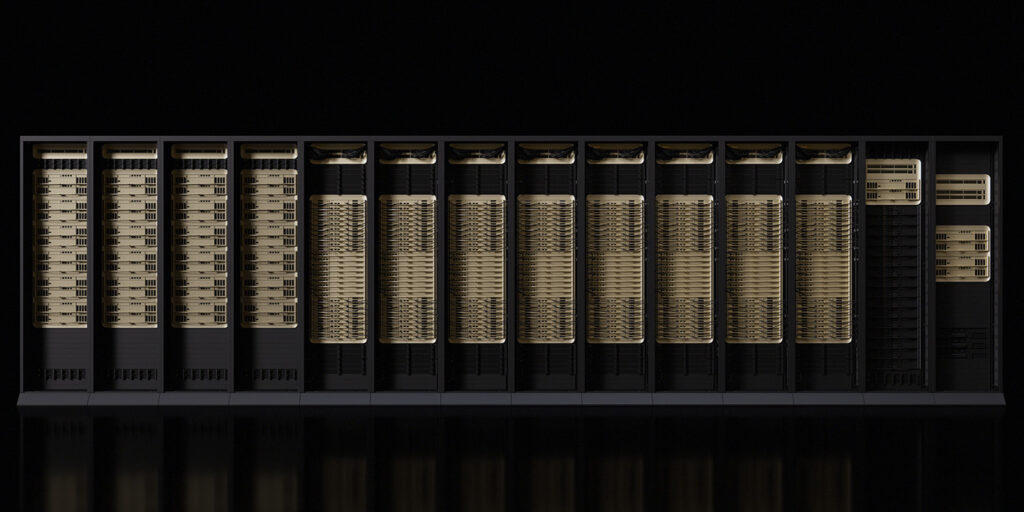

Die nach der Astronomin Vera Florence Cooper Rubin benannte Plattform umfasst die Rack-Scale-Lösung NVIDIA Vera Rubin NVL72 und das NVIDIA HGX Rubin NVL8-System.

Laut NVIDIA führt die Plattform fünf Innovationen ein, darunter die neuesten Generationen der NVIDIA NVLink-Verbindungstechnologie, Transformer Engine, Confidential Computing und RAS Engine sowie die NVIDIA Vera-CPU.

„Diese Durchbrüche werden die Agenten-KI, das fortschrittliche Denken und die Modellinferenz von Expertenmischungen (Combined-of-Specialists, MoE) in großem Maßstab zu bis zu zehnmal geringeren Kosten professional Token der NVIDIA Blackwell-Plattform beschleunigen“, sagte das Unternehmen in seiner Ankündigung. „Im Vergleich zum Vorgänger trainiert die NVIDIA Rubin-Plattform MoE-Modelle mit viermal weniger GPUs, um die KI-Einführung zu beschleunigen.“

Jensen Huang

Vera Rubin soll sich mit der zunehmenden Einführung von Agenten-KI und Argumentationsmodellen befassen, die die Grenzen der Berechnung verschieben. Die mehrstufige Problemlösung erfordert, dass Modelle lange Sequenzen von Token verarbeiten, begründen und agieren. Zu den fünf Technologien der Rubin-Plattform gehören:

- NVIDIA NVLink der sechsten Technology: Bietet GPU-zu-GPU-Kommunikation, die für MoE-Modelle erforderlich ist. Jede GPU bietet 3,6 TB/s Bandbreite, während das Vera Rubin NVL72-Rack 260 TB/s bietet – was laut NVIDIA mehr Bandbreite ist als das gesamte Web. Mit integrierter netzwerkinterner Rechenleistung für kollektive Vorgänge sowie neuen Funktionen für Wartungsfreundlichkeit und Ausfallsicherheit ist der NVLink 6-Swap für KI-Coaching und Inferenz im großen Maßstab konzipiert.

- Vera-CPU: Laut NVIDIA ist Vera die energieeffizienteste CPU für große KI-Fabriken und wurde für das Agentendenken entwickelt. Es ist mit 88 maßgeschneiderten NVIDIA-Olympus-Kernen, Armv9.2-Kompatibilität und ultraschneller NVLink-C2C-Konnektivität ausgestattet.

- Rubin-GPU: Ausgestattet mit einer Transformer Engine der dritten Technology mit hardwarebeschleunigter adaptiver Komprimierung liefert die Rubin-GPU 50 Petaflops NVFP4-Rechenleistung für KI-Inferenz.

- NVIDIA Confidential Computing der dritten Technology: Das Unternehmen gab an, dass Vera Rubin NVL72 die erste Rack-Plattform ist, die NVIDIA Confidential Computing bietet – das die Datensicherheit über CPU-, GPU- und NVLink-Domänen hinweg gewährleistet.

- RAS-Engine der zweiten Technology: Die Rubin-Plattform bietet Integritätsprüfungen, Fehlertoleranz und proaktive Wartung. Das modulare, kabellose Tray-Design des Racks ermöglicht eine bis zu 18-mal schnellere Montage und Wartung als Blackwell.

NVIDIA Rubin stellt die NVIDIA Inference Context Reminiscence Storage Platform vor, bei der es sich nach Angaben des Unternehmens um eine neue Klasse KI-nativer Speicherinfrastruktur handelt, die für die Skalierung von Inferenzkontexten im Gigamaßstab entwickelt wurde.

Die auf NVIDIA BlueField-4 basierende Plattform ermöglicht die gemeinsame Nutzung und Wiederverwendung von Schlüsselwert-Cache-Daten in der gesamten KI-Infrastruktur, um die Reaktionsfähigkeit und den Durchsatz zu verbessern.

Da KI-Fabriken zunehmend auf Naked-Steel- und Multi-Tenant-Bereitstellungsmodelle setzen, wird die Aufrechterhaltung einer starken Kontrolle und Isolierung der Infrastruktur immer wichtiger. BlueField-4 führt außerdem die Superior Safe Trusted Useful resource Structure (ASTRA) ein, eine Architektur auf Systemebene, die den Entwicklern von KI-Infrastrukturen einen einzigen Kontrollpunkt für die Bereitstellung, Isolierung und den Betrieb großer KI-Umgebungen ohne Leistungseinbußen bietet.

Da sich KI-Anwendungen in Richtung Multi-Flip Agentic Reasoning weiterentwickeln, verwalten und teilen KI-native Organisationen größere Mengen an Inferenzkontext über Benutzer, Sitzungen und Dienste hinweg. NVIDIA Vera Rubin NVL72 wurde entwickelt, um ein einheitliches System zu bieten, das 72 NVIDIA Rubin-GPUs, 36 NVIDIA Vera-CPUs, NVIDIA NVLink 6, NVIDIA ConnectX-9 SuperNICs und NVIDIA BlueField-4 DPUs kombiniert.

Da sich KI-Anwendungen in Richtung Multi-Flip Agentic Reasoning weiterentwickeln, verwalten und teilen KI-native Organisationen größere Mengen an Inferenzkontext über Benutzer, Sitzungen und Dienste hinweg. NVIDIA Vera Rubin NVL72 wurde entwickelt, um ein einheitliches System zu bieten, das 72 NVIDIA Rubin-GPUs, 36 NVIDIA Vera-CPUs, NVIDIA NVLink 6, NVIDIA ConnectX-9 SuperNICs und NVIDIA BlueField-4 DPUs kombiniert.

NVIDIA sagte, es werde auch die NVIDIA HGX Rubin NVL8-Plattform anbieten, ein Serverboard, das acht Rubin-GPUs über NVLink verbindet, um x86-basierte generative KI-Plattformen zu unterstützen. Die HGX Rubin NVL8-Plattform beschleunigt Coaching, Inferenz und wissenschaftliches Rechnen für KI- und Hochleistungsrechner-Workloads.

NVIDIA DGX SuperPOD dient als Referenz für die Bereitstellung von Rubin-basierten Systemen in großem Maßstab und integriert entweder NVIDIA DGX Vera Rubin NVL72- oder DGX Rubin NVL8-Systeme mit NVIDIA BlueField-4 DPUs, NVIDIA ConnectX-9 SuperNICs, NVIDIA InfiniBand-Netzwerken und NVIDIA Mission Management-Software program.

Da sich KI-Anwendungen in Richtung Multi-Flip Agentic Reasoning weiterentwickeln, verwalten und teilen KI-native Organisationen größere Mengen an Inferenzkontext über Benutzer, Sitzungen und Dienste hinweg. NVIDIA Vera Rubin NVL72 wurde entwickelt, um ein einheitliches System zu bieten, das 72 NVIDIA Rubin-GPUs, 36 NVIDIA Vera-CPUs, NVIDIA NVLink 6, NVIDIA ConnectX-9 SuperNICs und NVIDIA BlueField-4 DPUs kombiniert.

Da sich KI-Anwendungen in Richtung Multi-Flip Agentic Reasoning weiterentwickeln, verwalten und teilen KI-native Organisationen größere Mengen an Inferenzkontext über Benutzer, Sitzungen und Dienste hinweg. NVIDIA Vera Rubin NVL72 wurde entwickelt, um ein einheitliches System zu bieten, das 72 NVIDIA Rubin-GPUs, 36 NVIDIA Vera-CPUs, NVIDIA NVLink 6, NVIDIA ConnectX-9 SuperNICs und NVIDIA BlueField-4 DPUs kombiniert.