I. EINLEITUNG: Das zweischneidige Schwert von Genai

Durch die Entwicklung der Enterprise -Automatisierung durch Generative AI (Genai) können virtuelle Assistenten und Chatbots die Benutzerabsicht verstehen, damit sie geeignete Antworten und Vorhersageaktionen erstellen können. Die vielversprechenden Vorteile einer kontinuierlichen intelligenten Interaktion in der Skala erzeugen mehrere ethische Herausforderungen, die voreingenommene Outputs und Fehlinformationen sowie die regulatorische Nichteinhaltung und das Misstrauen des Benutzers umfassen. Der Einsatz von Genai ist nicht mehr eine Frage der Fähigkeit, sondern hat sich zu einer Frage der Verantwortung und der angemessenen Implementierungsmethoden entwickelt. Der McKinsey -Bericht zeigt, dass mehr als die Hälfte der Unternehmen mit Genai -Instruments begonnen hat, die sich hauptsächlich auf den Kundendienst und die betrieblichen Anwendungen konzentrieren. Das wachsende Ausmaß dieser Technologie erzeugt entsprechende Auswirkungen auf Equity -Requirements und Sicherheitsmaßnahmen und Compliance -Anforderungen. Genai Chatbots haben bereits damit begonnen, öffentliche und non-public Interaktionen durch ihre Umsetzung in virtuellen Vertretern und mehrsprachigen staatlichen Helplinen zu verändern.

Ii. Chatbots für Unternehmensgröße: eine neue Klasse der Verantwortung

Verbraucheranwendungen tolerieren normalerweise Chatbot -Fehler ohne Konsequenz. Die Risiken in Unternehmensumgebungen wie Finanzen, Gesundheitswesen und Regierung sind viel größer. Eine fehlerhafte Ausgabe kann zu Fehlinformationen, Verstößen gegen die Compliance oder sogar zu rechtlichen Konsequenzen führen. Ethisches Verhalten ist nicht nur eine soziale Verpflichtung. Es ist ein geschäftskritischer Imperativ. Unternehmen benötigen Frameworks, um sicherzustellen, dass KI -Systeme die Benutzerrechte respektieren, Vorschriften einhalten und das öffentliche Vertrauen aufrechterhalten.

III. Von der Eingabeaufforderung bis zur Ausgabe: wo die Ethik beginnt

Jedes Genai-System beginnt mit einem schnellen-was zwischen Eingabe und Ausgabe passiert, ist ein komplexes Netz von Trainingsdaten, Modellgewichten, Verstärkungslogik und Risikominderung. Die ethischen Bedenken können bei jedem Schritt auftreten:

- Mehrdeutige oder kulturell voreingenommene Aufforderungen

- Nicht transparente Entscheidungspfade

- Antworten basierend auf veralteten oder ungenauen Daten

Ohne robuste Filter- und Interpretierbarkeitsmechanismen können Unternehmen unabsichtlich Systeme einsetzen, die schädliche Verzerrungen verstärken oder Informationen erstellen.

Iv. Ethische Herausforderungen in genaiorientierten Chatbots

- Der Schulungsprozess unter Verwendung historischer Daten stärkt die bestehenden sozialen und kulturellen Vorurteile.

- Die LLMs erzeugen Antworten, die sowohl sachliche Ungenauigkeiten als auch fiktive Inhalte enthalten.

- Das unbeabsichtigte Verhalten von Modellen kann dazu führen, dass smart Unternehmens- oder Benutzerinformationen durchlaufen werden.

- Das Fehlen von mehrsprachigem und interkulturellem Verständnis in Genai-Systemen führt zu einer Entfremdung von Nutzern mit unterschiedlichem kulturellen Hintergrund.

- Genai-Systeme fehlen integrierte Moderationssysteme, mit denen sie unangemessene oder zwingende Nachrichten erstellen können.

- Der nicht überprüfte AI-generierte Inhalt verbreitet falsche oder irreführende Daten bei hoher Geschwindigkeit in den regulierten Sektoren.

- Die mangelnde Prüfbarkeit in diesen Modellen schafft Schwierigkeiten, wenn Sie versuchen, die Quelle einer bestimmten Ausgabe zu identifizieren, da sie als schwarze Kästchen fungieren.

Diese Herausforderungen treten mit unterschiedlichen Schweregraden auf und zeigen unterschiedliche Manifestationen auf der Grundlage der spezifischen Branche. Die Gesundheitsbranche ist einem kritischen Risiko ausgesetzt, da halluzierte Daten in Chatbots im Einzelhandel Kunden verwirren würden, aber zu fatalen Folgen führen könnten.

V. Designprinzipien für verantwortungsbewusste Chatbot -Entwicklung

Bei der Entwicklung ethischer Chatbots müssen Designer Werte direkt in ihren Entwurfsprozess einbeziehen, das über die grundlegende Fehlerbehebung hinausgeht.

- Das System umfasst Leitplanken und schnelle Moderationsmerkmale, die sowohl Themen als auch Reaktionston und Umfang einschränken.

- Mensch-in-the-Loop: Sensibilische Entscheidungen, die für die menschliche Überprüfung geleitet wurden

- Erklärungsmodule: Transparenz in die Erzeugung der Antworten ermöglichen

- Die Schulungsdaten müssen verschiedene und repräsentative Beispiele umfassen, um eindimensionales Lernen zu verhindern.

- Prüfungsprotokolle und Versionskontrolle: Gewährleistung der Rückverfolgbarkeit des Modellverhaltens

- Equity Frameworks: Instruments wie die KI -Equity 360 von IBM können dazu beitragen, unbeabsichtigte Verzerrungen bei NLP -Ausgängen zu testen

- Echtzeit-Moderation-APIs: Dienste wie das Inhaltsfilter von OpenAI oder die Content material Security API von Microsoft Azure helfen dabei, unsichere Antworten zu filtern, bevor sie von Benutzern gesehen werden

Vi. Governance und politische Integration

Alle Unternehmensbereitstellungen müssen sowohl interne Organisationsrichtlinien als auch externe regulatorische Anforderungen einhalten.

- GDPR/CCPA: Datenhandhabung und Einwilligung der Benutzer

- EU AI ACT & Algorithmic Accountability Act: Risikoklassifizierung, Folgenabschätzung

- Interne AI -Ethikkommissionen: regelmäßige Überprüfung der Bereitstellungen

- Unternehmen sollten Echtzeit-Protokollierung sowie Alarmierungs- und Auditing-Instruments für die kontinuierliche Compliance-Überwachung implementieren.

Organisationen sollten Genai -Systemen Risiken zuweisen, die auf Domäne, Publikum und Datentyp basieren, die niedrig, mittel- oder ein hohes Risiko sein können. AI -Audit -Checklisten und Compliance -Dashboards helfen dabei, Entscheidungsspuren zu dokumentieren und die Haftung zu verringern.

Vii. Eine Blaupausearchitektur für ethische Genai -Chatbots

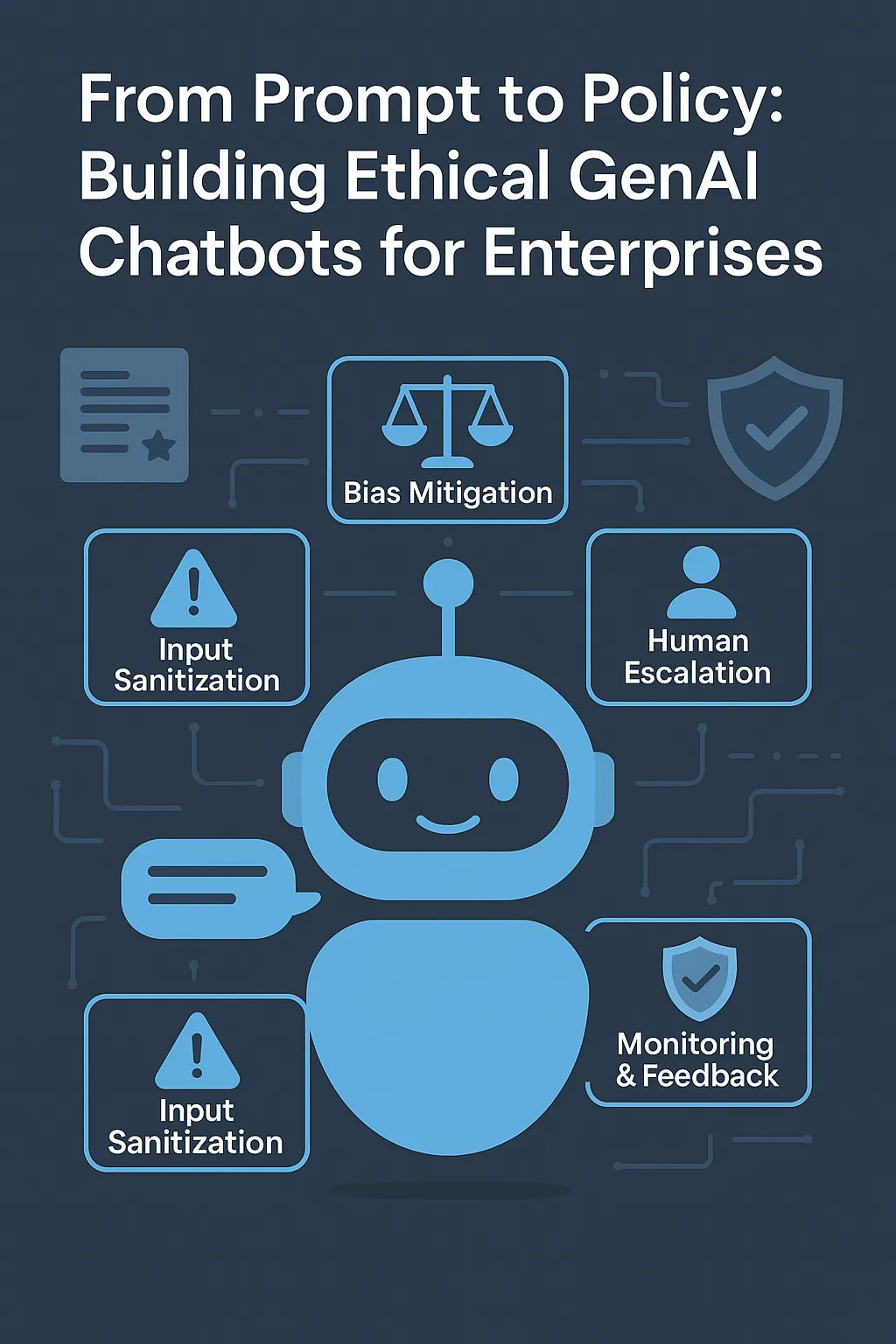

Ein ethisches Genai -Chatbot -System sollte enthalten:

- Die Eingabenteinigungsschicht identifiziert offensive oder manipulative oder mehrdeutige Eingabeaufforderungen im System.

- Die Einrichtungspunktmotor für die Ausrichtung der Umgabewiedergabe ist dafür verantwortlich, dass die Antworten mit dem Unternehmenston und den ethischen Requirements übereinstimmen.

- Die Schicht der Vorspannungsminderung führt in Echtzeitüberprüfungen über Geschlecht, Rassen- oder Kulturscheibe in Antworten durch.

- Menschliches Eskalationsmodul: Routes smart Gespräche zu menschlichen Wirkstoffen

- Das System umfasst eine Überwachungs- und Rückkopplungsschleife, die aus markierten Ausgängen lernt und das Modell regelmäßig umdehnt.

Abbildung 1: Architektur Blaupause für ethische Genai-Chatbots (AI-generiert für redaktionelle Klarheit)

Beispielfluss: Ein Benutzer gibt eine Grenze -medizinische Abfrage in einen Versicherungs -Chatbot ein. Die Sanitalisierungsschicht kennzeichnet die Unklarheit, die Alignment -Engine erzeugt eine sichere Reaktion mit einem Haftungsausschluss, und das Eskalationsmodul sendet ein Transkript an einen Dwell -Help -Agenten. Das Überwachungssystem protokolliert dieses Ereignis und führt zu Umschulungsdatensätzen.

Viii. Anwendungsfälle und Fehler in der Praxis

- Microsoft Tay: Ein Chatbot wurde innerhalb von 24 Stunden aufgrund unherliger Wechselwirkungen beschädigt

- METAs Blenderbot erhielt Kritik an der Bereitstellung von offensiven Inhalten und der Verbreitung falscher Informationen

- Einstein GPT von Salesforce implementierte menschliche Überprüfungs- und Compliance -Module, um die Einführung von Unternehmen zu unterstützen

Diese Beispiele zeigen, dass in realen operativen Umgebungen ethische Aufschlüsse vorhanden sind. Es geht nicht darum, wann Misserfolge auftreten, sondern wann sie eintreten werden und ob Organisationen die Antwortmechanismen festgelegt haben.

Ix. Metriken für ethische Leistung

Unternehmen müssen neue Messkriterien festlegen, die die Genauigkeitsstandards übertreffen.

- Vertrauensbewertungen: Basierend auf dem Suggestions und der Moderationsfrequenz von Benutzern

- Equity Metriken: Vertriebsleistung über demografische Merkmale

- Transparenzindex: Wie erklärbar die Ausgänge sind

- Sicherheitsverletzungen zählen: Fälle unangemessener oder eskalierter Ausgänge

- Die Bewertung der Benutzererfahrung gegen die ethische Durchsetzung erfordert die Bewertung der Aufbewahrung im Vergleich zum Kompromiss der Compliance.

Echtzeit Enterprise Dashboards zeigen diese Metriken an, um sofortige ethische Gesundheits-Schnappschüsse bereitzustellen und potenzielle Interventionspunkte zu erkennen. Organisationen integrieren nun ethische Metriken in ihre vierteljährlichen Leistungsüberprüfungen, die CSAT, NPS und die durchschnittliche Handhabungszeit umfassen, um Ethik als primärer KPI für die CX -Transformation zu etablieren.

X. zukünftige Developments: Aus der Einhaltung von Ethik zu Design

Die Genai Techniques of Tomorrow werden wertschreibend von Design angesetzt, anstatt nur konform zu sein. Die Industrie erwartet Fortschritte in:

- New -Age -APIs mit eingebetteter Ethik

- Hoch kontrollierte Umgebungen, die mit regulatorischen Sandboxen zum Testen von KI -Systemen ausgestattet sind

- Nachhaltigkeitsprüfungen für energieeffiziente KI-Bereitstellung

- Interkulturelle Simulationsmotoren für die globale Bereitschaft

Große Organisationen schaffen neue Rollen wie KI -Ethikbeauftragte und verantwortungsbewusste KI -Architekten, um unbeabsichtigte Konsequenzen zu überwachen und die Richtlinienausrichtung zu überwachen.

Xi. Schlussfolgerung: Erstellen von Chatbots -Nutzern können vertrauen

Die Zukunft von Genai als Kerntool für Unternehmen erfordert die Akzeptanz seiner Fähigkeiten und die Aufrechterhaltung ethischer Requirements. Jedes Designelement von Chatbots von Aufforderungen zu Richtlinien muss das Engagement für Equity -Transparenz und -verantwortung demonstrieren. Leistung erzeugt kein Vertrauen, da Vertrauen als das tatsächliche Ergebnis existiert. Die Gewinner dieser Zeit werden Unternehmen sein, die verantwortungsvolle Lösungen liefern, die die Dignität und Privatsphäre der Benutzer schützen und dauerhaftes Vertrauen aufbauen. Die Entwicklung ethischer Chatbots erfordert die Teamarbeit zwischen Ingenieuren und Ethikisten, Produktleitern und Rechtsberatern. Unsere Fähigkeit, KI -Systeme zu schaffen, die allen Menschen zugute kommen, hängt von der Zusammenarbeit ab.

Autor Bio:

Satya Karteek Gudipati ist ein in Dallas, TX, ansässiger Software program-Ingenieur, der sich auf Systeme für Unternehmensklassen, Cloud-nativen Architekturen und mehrsprachiges Chatbot-Design spezialisiert hat. Mit über 15 Jahren Erfahrung in Bezug auf skalierbare Plattformen für globale Kunden bringt er ein tiefes Fachwissen in der generativen KI -Integration, der Workflow -Automatisierung und der intelligenten Agentenorchestrierung ein. Seine Arbeiten wurden in IEEE, Springer und mehreren Handelspublikationen vorgestellt. Verbinden LinkedIn.

Referenzen

1. McKinsey & Firm. (2023). *Der Zustand der KI im Jahr 2023*. (Hyperlink)(https://www.mckkinsey.com/capabilities/quantumblack/our-insights/the-state-of-ai-in-2023 )

2. IBM AI Equity 360 Toolkit. (ND). (Hyperlink)(https://aif360.mybluemix.web/ )

3.. EU Synthetic Intelligence Act – Vorgeschlagene Gesetzgebung. (Hyperlink)(https://artificialintelligenceact.eu/ )

4. OpenAI Moderation API -Übersicht. (Hyperlink)(https://platform.openai.com/docs/guides/Moderation )

5. Microsoft Azure Content material Security. (Hyperlink)(https://be taught.microsoft.com/en-us/azure/ai-soervices/content-safety/overview )

Der Beitrag Von immediate zur Politik: Aufbau ethischer Genai -Chatbots für Unternehmen erschien zuerst auf DataFloq.