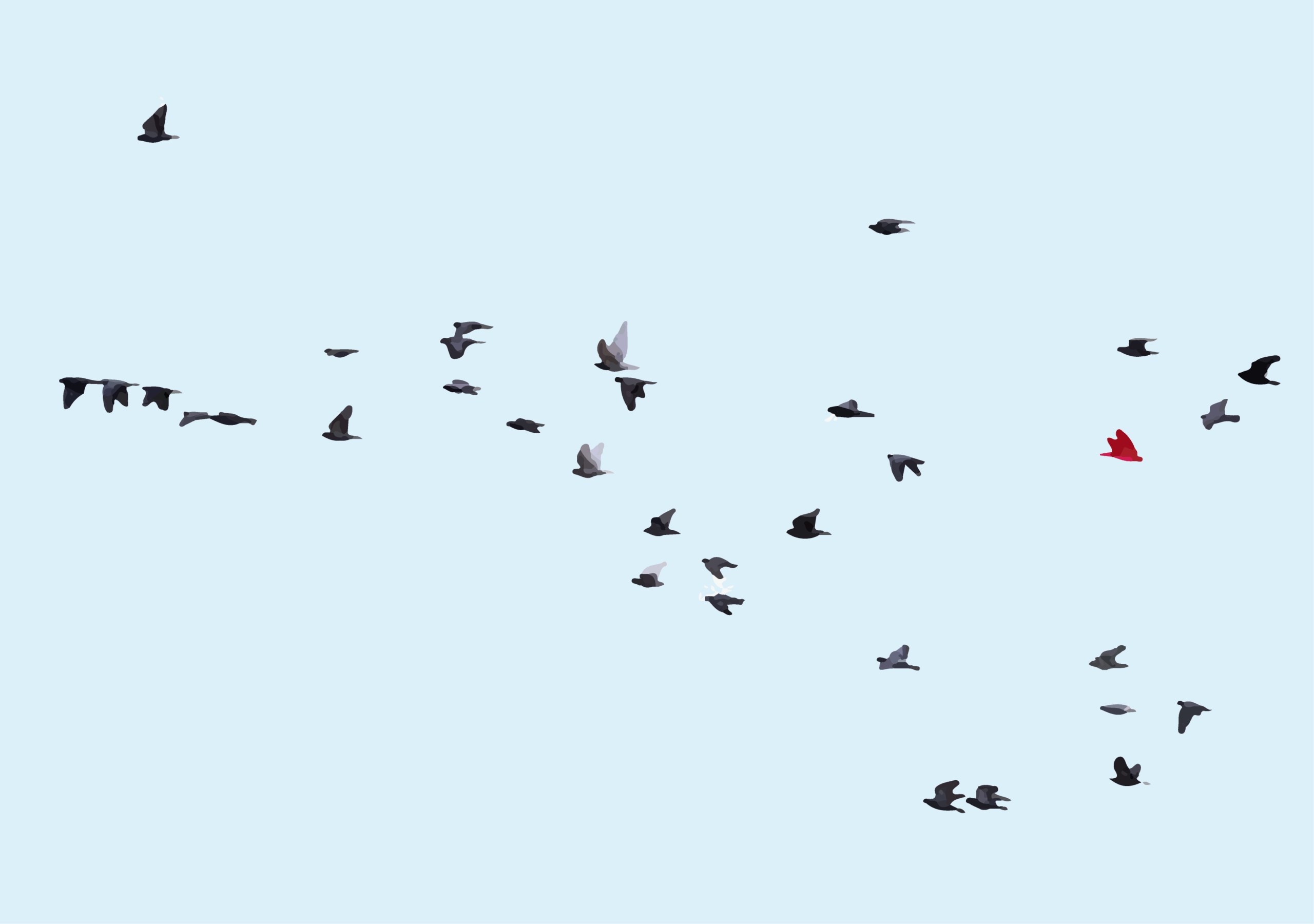

von Vögeln im Flug.

Es gibt keinen Anführer. Kein zentrales Kommando. Jeder Vogel richtet sich nach seinen Nachbarn aus – passt die Richtung an, passt die Geschwindigkeit an und erhält die Kohärenz durch rein lokale Koordination aufrecht. Das Ergebnis ist eine globale Ordnung, die aus lokaler Konsistenz entsteht.

Stellen Sie sich nun einen Vogel vor, der mit der gleichen Überzeugung fliegt wie die anderen. Seine Flügelschläge sind souverän. Seine Geschwindigkeit stimmt. Aber seine Richtung stimmt nicht mit der seiner Nachbarn überein. Es ist der rote Vogel.

Es ist nicht verloren. Es ist kein Zögern. Es gehört einfach nicht zur Herde.

Halluzinationen bei LLMs sind rote Vögel.

Das Drawback, das wir tatsächlich zu lösen versuchen

LLMs erzeugen flüssige, sichere Texte, die erfundene Informationen enthalten können. Sie erfinden Rechtsfälle, die es nicht gibt. Sie zitieren Arbeiten, die nie geschrieben wurden. Sie geben Tatsachen im gleichen Ton an, unabhängig davon, ob diese Tatsachen wahr oder vollständig erfunden sind.

Der Standardansatz, dies zu erkennen, besteht darin, ein anderes Sprachmodell zu bitten, die Ausgabe zu überprüfen. LLM-als-Richter. Man sieht das Drawback sofort: Wir verwenden ein System, das halluziniert, um Halluzinationen zu erkennen. Es ist, als würde man jemanden, der Farben nicht unterscheiden kann, bitten, Farbmuster zu sortieren. Sie werden Ihnen eine Antwort geben. Manchmal könnte es sogar richtig sein. Aber sie sehen nicht wirklich das, was Sie von ihnen erwarten.

Die Frage, die wir gestellt haben, battle anders: Können wir Halluzinationen anhand der geometrischen Struktur des Textes selbst erkennen, ohne die Meinung eines anderen Sprachmodells zu benötigen?

Was Einbettungen eigentlich bewirken

Bevor ich zur Erkennungsmethode komme, möchte ich einen Schritt zurücktreten und herausfinden, womit wir arbeiten.

Wenn Sie Textual content in einen Satzkodierer eingeben, erhalten Sie einen Vektor zurück – einen Punkt im hochdimensionalen Raum. Texte, die semantisch ähnlich sind, landen nahe beieinander. Texte, die nichts miteinander zu tun haben, liegen weit auseinander. Dafür optimiert kontrastives Coaching. Aber es gibt eine subtilere Struktur als nur „Ähnliche Dinge liegen nahe beieinander“.

Überlegen Sie, was passiert, wenn Sie eine Frage und die dazugehörige Antwort einbetten. Die Frage landet irgendwo in diesem Einbettungsraum. Die Antwort landet woanders. Der Vektor, der sie verbindet – was wir nennen Verschiebung– zeigt in eine bestimmte Richtung. Wir haben einen Vektor: einen Betrag und einen Winkel.

Das haben wir auch beobachtet Bei geerdeten Antworten innerhalb eines bestimmten Bereichs zeigen diese Verschiebungsvektoren in konsistente Richtungen. Wir haben eine Gemeinsamkeit gefunden: Winkel.

Wenn Sie fünf ähnliche Fragen stellen und fünf fundierte Antworten erhalten, sind die Verschiebungen von Frage zu Antwort ungefähr parallel. Nicht identisch – die Größen variieren, die genauen Winkel unterscheiden sich geringfügig –, aber die Gesamtrichtung ist konsistent.

Wenn ein Mannequin halluziniert, passiert etwas anderes. Die Antwort landet immer noch irgendwo im Einbettungsraum. Es ist immer noch fließend. Es klingt immer noch nach einer Antwort. Aber die Verschiebung folgt nicht dem lokalen Muster. Es weist auf etwas anderes hin. Ein Vektor mit einem völlig anderen Winkel.

Der rote Vogel fliegt selbstbewusst. Aber nicht mit der Herde. Fliegt in die entgegengesetzte Richtung mit einem völlig anderen Winkel als der Relaxation der Vögel.

Verschiebungskonsistenz (DC)

Wir formalisieren dies als Displacement Consistency (DC). Die Idee ist einfach:

- Erstellen Sie einen Referenzsatz fundierter Frage-Antwort-Paare aus Ihrer Area

- Suchen Sie für ein neues Frage-Antwort-Paar nach den benachbarten Fragen im Referenzsatz

- Berechnen Sie die mittlere Verschiebungsrichtung dieser Nachbarn

- Messen Sie, wie intestine die neue Verschiebung mit dieser mittleren Richtung übereinstimmt

Bodenständige Antworten passen intestine zusammen. Halluzinierte Reaktionen nicht. Das ist es. Eine Kosinusähnlichkeit. Zum Zeitpunkt der Inferenz sind keine Quelldokumente erforderlich. Keine mehreren Generationen. Keine Modellinterna.

Und es funktioniert bemerkenswert intestine. Über fünf architektonisch unterschiedliche Einbettungsmodelle und mehrere Halluzinations-Benchmarks, darunter HaluEval und TruthfulQA, erreicht DC eine nahezu perfekte Unterscheidung. Die Verteilungen überschneiden sich kaum.

Der Haken: Area-Lokalität

Wir haben DC anhand von fünf Einbettungsmodellen getestet, die ausgewählt wurden, um die Architekturvielfalt abzudecken: MPNet-basierte kontrastive Feinabstimmung (all-mpnet-base-v2), schwach überwachtes Vortraining (E5-large-v2), anweisungsgesteuertes Coaching mit harten Negativen (BGE-large-en-v1.5), Encoder-Decoder-Anpassung (GTR-T5-large) und effiziente Architekturen mit langem Kontext (nomic-embed-text-v1.5). Wenn DC nur mit einer Architektur arbeiten würde, könnte es sich um ein Artefakt dieses bestimmten Modells handeln. Konsistente Ergebnisse über architektonisch unterschiedliche Modelle hinweg lassen darauf schließen, dass die Struktur grundlegend ist.

Die Ergebnisse waren konsistent. DC erreichte in unserem synthetischen Benchmark bei allen fünf Modellen einen AUROC von 1,0. Aber synthetische Benchmarks können irreführend sein – möglicherweise sind nach Domänen gemischte Antworten einfach zu leicht zu erkennen.

Deshalb haben wir anhand etablierter Halluzinationsdatensätze validiert: HaluEval-QA, das LLM-generierte Halluzinationen enthält, die speziell darauf ausgelegt sind, subtil zu sein; HaluEval-Dialog, mit Antworten, die vom Gesprächskontext abweichen; und TruthfulQA, das häufige Missverständnisse testet, an die Menschen häufig glauben.

DC wahrte bei allen eine perfekte Unterscheidung. Keine Verschlechterung von synthetischen zu realistischen Benchmarks.

Zum Vergleich: Verhältnisbasierte Methoden, die messen, wo Antworten im Verhältnis zu Anfragen landen (und nicht die Richtung, in die sie sich bewegen), erreichten einen AUROC von etwa 0,70–0,81. Der Abstand – etwa 0,20 absolute AUROC – ist beträchtlich und bei allen getesteten Modellen gleichbleibend.

Die Punkteverteilungen erzählen die Geschichte visuell. Bei hohen DC-Werten (ca. 0,9) häufen sich geerdete Antworten stark. Halluzinierte Reaktionen breiten sich bei niedrigeren Werten (ca. 0,3) aus. Die Verteilungen überschneiden sich kaum.

DC erreicht eine perfekte Erkennung innerhalb eine enge Domäne. Wenn Sie jedoch versuchen, einen Referenzsatz aus einer Domäne zu verwenden, um Halluzinationen in einer anderen Domäne zu erkennen, sinkt die Leistung auf zufällig – AUROC etwa 0,50. Dies verrät uns etwas Grundlegendes darüber, wie Einbettungen die Erdung kodieren. Es ist gleichbedeutend damit, verschiedene Schwärme am Himmel zu sehen: Jeder Schwarm wird eine andere Richtung haben.

Bei LLMs lässt sich dies am einfachsten anhand der Vorstellung dessen verstehen, was in der Geometrie als „Faserbündel“ bezeichnet wird.

Die Fläche in Abbildung 1 ist die Basismannigfaltigkeit, die alle möglichen Fragen darstellt. An jedem Punkt dieser Oberfläche gibt es eine Faser: eine Linie, die in die Richtung zeigt, in die sich geerdete Reaktionen bewegen. Innerhalb eines lokalen Bereichs der Oberfläche (einer bestimmten Domäne) zeigen alle Fasern ungefähr in die gleiche Richtung. Deshalb funktioniert DC vor Ort so intestine.

Aber international gesehen, über verschiedene Regionen hinweg, weisen die Fasern in unterschiedliche Richtungen. Die „grundlegende Richtung“ für rechtliche Fragen unterscheidet sich von der „grundlegenden Richtung“ für medizinische Fragen. Es gibt kein einheitliches globales Muster. Nur lokale Kohärenz.

Schauen Sie sich nun das folgende Video an. Vogelflugrouten, die Europa und Afrika verbinden. Wir können die Faserbündel sehen. Verschiedene Vögel (mittelgroß/groß, klein, Insekten) haben unterschiedliche Richtungen.

In der Differentialgeometrie heißt diese Struktur lokale Trivialität ohne globale Trivialität. Jeder Patch des Verteilers sieht im Inneren einfach und konsistent aus. Die Patches können jedoch nicht in einem globalen Koordinatensystem zusammengefügt werden.

Dies hat eine bemerkenswerte Auswirkung:

Erdung ist keine universelle geometrische Eigenschaft

Es gibt keine einheitliche „Richtung der Wahrhaftigkeit“ beim Einbetten von Raum. Jede Domäne – jeder Aufgabentyp, jedes LLM – entwickelt während des Trainings sein eigenes Verschiebungsmuster. Die Muster sind actual und erkennbar, aber sie sind domänenspezifisch. Vögel wandern nicht in die gleiche Richtung.

Was das praktisch bedeutet

Für die Bereitstellung bedeutet die Domänenlokalitätsfindung, dass Sie einen kleinen Kalibrierungssatz (ca. 100 Beispiele) benötigen, der auf Ihren spezifischen Anwendungsfall abgestimmt ist. Ein juristisches Frage-und-Antwort-System braucht juristische Beispiele. Ein medizinischer Chatbot braucht medizinische Beispiele. Dabei handelt es sich um einmalige Vorabkosten – die Kalibrierung erfolgt offline –, die jedoch nicht übersprungen werden können.

Für das Verständnis von Einbettungen legen die Ergebnisse nahe, dass diese Modelle eine umfassendere Struktur kodieren, als wir normalerweise annehmen. Sie lernen nicht nur „Ähnlichkeit“. Sie lernen domänenspezifische Zuordnungen, deren Störung zuverlässig Halluzinationen signalisiert.

Der rote Vogel tut es nicht

Die halluzinierte Reaktion hat keinen Marker, der besagt: „Ich bin erfunden.“ Es ist fließend. Es ist zuversichtlich. Es sieht genau wie eine fundierte Antwort auf jede oberflächliche Metrik aus.

Aber es bewegt sich nicht mit der Herde. Und jetzt können wir das messen.

Die Geometrie battle schon immer da und spiegelt sich in der Artwork und Weise wider, wie kontrastierendes Coaching den eingebetteten Raum formt. Wir lernen gerade, es zu lesen.

Hinweise:

Das vollständige Papier finden Sie unter https://cert-framework.com/docs/analysis/dc-paper.

Wenn Sie Fragen zu den besprochenen Themen haben, können Sie mich gerne unter kontaktieren (e-mail protected)